Push-varsler er overalt-enten det er et nyhetsvarsel, en væroppdatering eller en “bestillingen din har sendt” -meldingen, driver de engasjement og leverer sanntidsverdi til brukerne. Men å designe et pushvarslingssystem som kan håndtere milliarder av meldinger på tvers av plattformer, mens de holder seg utøvende og pålitelig, er ingen tur i parken.

Moderne applikasjoner trenger ofte å skyve tidssensitiv informasjon til brukere på mobile enheter (iOS/Android), stasjonære maskiner (MacOS/Windows) og nettlesere (Chrome, Firefox, Safari). Hver av disse plattformene kommer med sin egen protokoll, leveringsbegrensninger og hastighetsgrenser. Nå lag i forretningsregler som brukerpreferanser, segmentering, gasspedling, forsøk på nytt og lokalisering-du stirrer plutselig på et ikke-trivielt distribuert system.

En grunnleggende implementering kan fungere i lav skala eller i et bevis-av-konsept. Men hva skjer når du har 50 millioner brukere, hver med flere enheter, og markedsføring ønsker å kjøre kampanjer til 10% av publikum med noen få minutter? Det er her ting begynner å falle fra hverandre hvis arkitekturen din ikke ble bygget for den fra grunnen av.

Denne guiden går gjennom den arkitektoniske blåkopien for å bygge et skalerbart, feiltolerant og utvidelig pushvarslingssystem. Det vil fokusere på levering av plattformer (APNS, FCM, WebPush), systemnivåproblemer som kø og forsøk på nytt, samt hvordan du kan stille inn for ytelse under høy belastning.

Målet er å utstyre deg med den mentale modellen og designmønstrene som trengs for å bygge et system som ikke spenner under press – og kan utvikle seg med produktbehovene dine.

Systemkrav

Funksjonelle krav

I kjernen må push-varslingssystemet levere meldinger til sluttbrukerenheter. Men “levering” er ikke nok. Her er hva systemet faktisk burde gjøre:

- Levering på flere plattformer: Støtt Apple Push Notification Service (APN), Firebase Cloud Messaging (FCM) og Web Push-protokoll (WPP).

- Enhetsregistrering og -administrasjon: Lagre enhetstokener tilordnet brukere, plattformer og applikasjoner.

- Målrettingsevner: Send meldinger til spesifikke brukere, enhetsgrupper, brukersegmenter eller alle brukere (kringkasting).

- Planlegging: La meldinger sendes umiddelbart eller på et fremtidig planlagt tidspunkt.

- Ratebegrensning: Gassmeldinger basert på plattformbegrensninger eller interne forretningsregler.

- Prøv logikken på nytt: Automatisk prøve på nytt mislykkede leveranser med eksponentiell backoff eller tilpasset policyer på nytt.

- Brukerpreferanser: Respekter opt-in/opt-out status, stille timer eller spesifikke kanaltyper (f.eks. Salgsfremmende vs. transaksjonell).

- Revisjon og analyse: Spor leveringssuksess/fiasko, åpnes (når det er mulig), og diagnostiske metadata for feilsøking.

Ikke-funksjonelle krav

Dette er ryggradens bekymring-MISS disse, og plattformen din vil kollapse under bruk av den virkelige verden.

- Skalerbarhet: Systemet må håndtere pigger med millioner av meldinger per minutt.

- Tilgjengelighet: Målretting av 99,99% oppetid, spesielt for kritiske veier som enhetsregistrering og leveringsrørledninger.

- Latens: Underbehandling under transaksjonell (f.eks. OTP, sikkerhetsvarsler); Tolerable Delay (5-15s) for markedsføring av batchmarkedsføring.

- Varighet: Meldinger må ikke gå tapt i tilfelle node eller tjenestesvikt.

- Sikkerhet: Ende-til-ende beskyttelse av brukerdata, autentisering til 3.-partitjenester, kryptering av nyttelast i transitt og i ro.

- Multi-leiekant: Evne til å støtte flere applikasjoner/kunder med isolerte data og leveringsrørledninger.

Begrensninger og forutsetninger

Å definere grenser er avgjørende for å redusere arkitektonisk tvetydighet.

- Anta at plattformpressleverandører (APN -er, FCM, Webpush) er eksterne og fungerer som svarte bokser med publiserte SLA -er.

- Meldingens nyttelast er små (2KB – 4KB), med mest logikk håndtert på klientsiden.

- Det er en eksisterende brukeridentitetsplattform som utsetter enhet-til-bruker-kartlegginger og brukerpreferanser.

- Systemet garanterer ikke levering – når det gir det til APNS/FCM, er ansvaret deres.

- Systemet kjøres i et sky-innfødt miljø (Kubernetes eller administrerte containere, autoscaling, etc.).

Kjernebrukssak og leveringslandskap

Før du dykker inn i arkitektur, er det viktig å avklare hva dette systemet løser for – fordi “pushvarsler” betyr forskjellige ting i forskjellige forretningssammenhenger. Denne delen utforsker det virkelige operasjonslandskapet, som bruker systemet, og hvordan skalaen påvirker designvalg.

Primær forretningsbrukssak

La oss definere en typisk sak med høy påvirkning: en storskala B2C-e-handelsplattform ønsker å sende pushvarsler i sanntid på tvers av mobil og nett for å drive brukerengasjement, varsle brukere av ordre-statusoppdateringer, eller utløse atferdsbaserte påminnelser (f.eks. Abandoned cart nudges). Det er også interne brukssaker – OPS -varsler, svindelsystemer og partnerintegrasjoner. Men kjernedriveren er høy gjennomstrømning, brukersentrisk meldinger med varierende kritikknivå.

Brukere og varslingskanaler

Sluttbrukere av systemet er ikke bare kunder som mottar push -meldingene. Det er flere skuespillere:

- Markedsførere: Kjør store kampanjer, plan- og segmentbrukerkohorter.

- Produktteam: Utløser kontekstuelle varsler fra appatferd (milepæler i appen, gamification-løkker).

- Backend Systems: Utløser automatisk transaksjonsmeldinger som OTPS, betalingsbekreftelser eller leveringsvarsler.

I den mottakende enden kan hver bruker ha flere enhetstyper:

- Mobilapper: iOS via APNS og Android via FCM.

- Nettlesere: Via Web Push Protocol (VAPID-basert), vanligvis for brukere av stasjonær/bærbar PC.

- Tredjeparts tjenester: I noen tilfeller er integrasjoner med tredjeparts leveringskanaler som WhatsApp eller-app-meldingsoverlegg involvert-men utenfor omfanget for dette systemet.

Volum og skala hensyn

Dette er hva systemet forventes å håndtere i den virkelige skalaen:

- 100m+ registrerte enheter på tvers av plattformer, med 5–10% aktiv på daglig basis.

- Transaksjonelle hendelser: 3–5m meldinger/dag, med SLA -er med hard latens (f.eks. OTP i løpet av 3 sekunder).

- Kampanjer: Burst sender til 10–20 millioner brukere på under 5 minutter, ofte utløst via dashbord eller backend -jobbkøer.

- Topp samtidighet: 200k+ meldinger/minutt under hendelser fra Black Friday-type eller under virale pigger.

Dette handler ikke om å sende en melding til en bruker – det handler om å sende millioner av skreddersydde meldinger over tusenvis av noder, med pålitelighet, forsøk på nytt og minimal forsinkelse. Designet må imøtekomme denne typen dynamiske arbeidsmengder, som betyr statsløse kjernetjenester, distribuerte køer og horisontal skalerbarhet på hvert nivå.

Systemarkitektur på høyt nivå

Arkitekturen for et skalerbart pushvarslingssystem dreier seg om tre prinsipper: avkobling, parallellisme, og plattformspesifikk levering. I skala faller monolitiske design fra hverandre-så denne arkitekturen omfavner en mikroservicebasert, hendelsesdrevet tilnærming som kan vifte ut, gass, prøve på nytt og revidere milliarder av meldinger med minimale flaskehalser.

La oss gå gjennom kjernedubsystemene, dataflyt og plattformspesifikke abstraksjoner som gjør at det hele fungerer.

Komponentoversikt

Arkitekturen er delt inn i følgende logiske komponenter:

- Svelging API: Mottar meldingsforespørsler – Batch eller Transactional – validerer inndata, Enqueues -meldinger i rørledningen.

- Rutingmotor: Slår opp enheter, deler meldinger per enhetsplattformpar, gir dem i respektive køer.

- Plattformleveringsarbeidere: Dedikerte mikroservices for APN -er, FCM og Webpush. Disse håndterer tilkoblingsstyring, forsøk på nytt, batching og hastighetsbegrensende.

- Meldingskø (meglerlag): Megler med høy gjennomstrømning (f.eks. Kafka, RabbitMQ eller Google Pub/Sub) for avkobling av produsenter fra leveringslogikk.

- Enhetsregistertjeneste: Lagrer enhetsmetadata, brukerkartlegginger, token-gyldighet, plattformtype og opt-in status.

- Preferanse og regler Motor: Evaluerer brukervarslingsinnstillinger, undertrykkelsesregler (stille timer, frekvensdeksler) eller kanalspesifikke overstyringer.

- Planlegger: For forsinket eller tidsvindu-basert meldingslevering.

- Overvåking og tilbakemeldingssløyfe: Fanger oppleveringskvitteringer på plattformnivå, feil og analyser; Håndterer APNS -tilbakemeldinger, FCM avinstallerer osv.

Arkitekturdiagram på høyt nivå

+------------------+

| Ingestion API |

+--------+---------+

|

v

+---------------------+

| Routing Engine |

+--------+------------+

|

v

+---------------------+

| Message Broker |

| (Kafka / RabbitMQ) |

+--------+------------+

|

+--------------------------+--------------------------+

| | |

v v v

+-------------+ +--------------+ +----------------+

| APNs Worker | | FCM Worker | | WebPush Worker |

+------+------+ +------+-------+ +--------+-------+

| | |

v v v

+------------------+ +---------------------+ +------------------------+

| Apple Push Notif | | Firebase Cloud Msg | | Web Push Service (VAPID)|

| Service (APNs) | | (FCM) | | |

+------------------+ +---------------------+ +------------------------+

+------------------------+ +--------------------------+

| Device Registry Svc | <------> | User Preferences Engine |

+------------------------+ +--------------------------+

+---------------------------+

| Scheduler / Campaign Svc |

+---------------------------+

+---------------------------+

| Monitoring / Analytics |

| (Logs, Receipts, Metrics) |

+---------------------------+

Viktige arkitektoniske mønstre

- Hendelsesdrevet arkitektur: Meldingsstrømmen er fullt asynkron. Produsenter (API -er, interne systemer) kobles fra levering ved bruk av pub/sub- eller meldingskøer.

- Plattformspesifikk abstraksjon: Arbeidere er skreddersydd per plattform. Hver administrerer sine egne hastighetsgrenser, nyttelastformater, forsøk på nytt og API Auth.

- Baktrykksstøtte: Meldemeglere må håndtere bølger uten å slippe data. Buffering, døde bokstavkøer og autoscaling av forbrukere er innebygd.

- Idempotency & deduplication: Meldinger må ha unike ID-er for å unngå problemer med dobbeltgang, spesielt på forsøk.

- Feilisolasjon: Et plattformbrudd (si APNS) skal ikke kaskade og stall meldinger for FCM/WebPush. Hvert arbeiderbasseng er isolert og feiltolerant.

Denne arkitekturen kan horisontalt skalere hver komponent uavhengig – mer arbeidere for APN -er under iOS -kampanjeselper, eller flere rutingnoder under inntakspikene. Hver nivå kan overvåkes, strupet eller startes på nytt uten å påvirke hele systemet.

Trenger du hjelp med arkitektur til skala?

Planlegger du å rulle ut pushvarsler over millioner av brukere, men usikker på hvordan du skaleres levering eller administrere tvers av plattformer?

Vi kan hjelpe deg med å designe et kamptestet push-system skreddersydd for produktets vekst- og ytelsesbehov.

Databasedesign og tokenadministrasjon

push-varslingssystemer lever eller dør av deres evne til å administrere millioner av enhetstokener, brukerpreferanser og meldingstilstander effektivt. Denne delen bryter ned hvordan du designer et databaseskjema som skalerer horisontalt, opprettholder leveringskonsistens og støtter sanntidsmålretting og filtrering.

Kjernedataenheter

I det minste er følgende enheter påkrevd:

- Brukere: Logisk brukeridentitet (UID), knyttet til en eller mange enheter.

- Enheter: Plattformspesifikke enhetsopptak med symboler, appversjon, sist sett osv.

- Innstillinger: Brukerspesifikke opt-in/opt-out-flagg, kanalinnstillinger, stille timer osv.

- Meldinger: Historie med sendte varsler, deres leveringsstatus og metadata for feilsøking/revisjon.

Enhetsrelasjonsmodell (ERD)

Slik forholder enhetene seg på et høyt nivå:

+--------+ 1 +---------+ M +-----------+ | Users |---------------<| Devices |--------------->| Preferences| +--------+ +---------+ +-----------+ | | | | 1 | | | M | v v +-------------+ +--------------+ | Notifications| | Delivery Logs| +-------------+ +--------------+

Tabellskjemaer (forenklet)

users (

id UUID PRIMARY KEY,

email TEXT UNIQUE NOT NULL,

created_at TIMESTAMP DEFAULT NOW()

)

-- Index: unique email lookup

-- CREATE UNIQUE INDEX idx_users_email ON users(email);

devices (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

platform ENUM('ios', 'android', 'web') NOT NULL,

token TEXT UNIQUE NOT NULL,

app_version TEXT,

last_active TIMESTAMP,

is_active BOOLEAN DEFAULT true,

created_at TIMESTAMP DEFAULT NOW()

)

-- Indexes:

-- CREATE INDEX idx_devices_user_platform ON devices(user_id, platform);

-- CREATE UNIQUE INDEX idx_devices_token ON devices(token);

preferences (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

channel ENUM('transactional', 'marketing') NOT NULL,

enabled BOOLEAN DEFAULT true,

quiet_hours JSONB,

updated_at TIMESTAMP DEFAULT NOW()

)

-- Index: preference lookup

-- CREATE UNIQUE INDEX idx_prefs_user_channel ON preferences(user_id, channel);

notifications (

id UUID PRIMARY KEY,

title TEXT,

body TEXT,

payload JSONB,

scheduled_at TIMESTAMP,

priority ENUM('high', 'normal', 'low') DEFAULT 'normal',

created_by TEXT,

created_at TIMESTAMP DEFAULT NOW()

)

delivery_logs (

id UUID PRIMARY KEY,

notification_id UUID NOT NULL REFERENCES notifications(id) ON DELETE CASCADE,

device_id UUID NOT NULL REFERENCES devices(id) ON DELETE CASCADE,

status ENUM('pending', 'delivered', 'failed', 'dropped') DEFAULT 'pending',

attempt_count INT DEFAULT 0,

response_code TEXT,

error_message TEXT,

delivered_at TIMESTAMP

)

-- Indexes:

-- CREATE INDEX idx_logs_device_status ON delivery_logs(device_id, status);

-- CREATE INDEX idx_logs_notif_status ON delivery_logs(notification_id, status);

Eksempel på rader (bare illustrerende)

users

--------------------------------------------------------------

id | email

--------------------------------------+-------------------------

5b6e...d1 | user@example.com

devices

--------------------------------------------------------------

id | user_id | platform | token | is_active

----------+----------+----------+---------------+------------

f7a9...91 | 5b6e...d1| ios | abc123token...| true

preferences

--------------------------------------------------------------

id | user_id | channel | enabled | quiet_hours

----------+----------+----------------+---------+-------------

c1f3...72 | 5b6e...d1| marketing | false | {"start":"22:00","end":"07:00"}

notifications

--------------------------------------------------------------

id | title | priority | scheduled_at

----------+----------------+----------+--------------

e93f...55 | Order Shipped! | high | 2025-04-22 13:00:00

delivery_logs

--------------------------------------------------------------

id | notification_id | device_id | status | attempt_count

----------+-----------------+-----------+------------+---------------

d95b...11 | e93f...55 | f7a9...91 | delivered | 1

Beste praksis for Token Management

- De-dupliserte tokens: Flere enheter kan sende det samme symbolet (spesielt på Android); Deduplikat ved registrering.

- Token utløpshåndtering: Validerer periodisk symboler via tilbakemeldingstjenester (f.eks. APNS -tilbakemelding, FCM uregistrerte feil) og Mark Inactive.

- Myke sletter: Bruk `is_active` -flagg i stedet for harde slettinger for å unngå foreldreløse leveringslogger.

- Indeks klokt: Enheter skal indekseres på `(user_id, plattform)` og `(token)` for raske oppslag og de-duping.

- Unngå brukerkoblinger ved kjøretid: Oppbevar alle måldata (symboler, opt-ins) i hurtig tilgangsbutikker som Redis eller forhåndsinnsatt visning for høyhastighets leveringskjøringer.

Multi-tenancy og isolasjonsstrategier

Hvis du støtter flere apper eller klienter:

- Leietakers kolonnestrategi: Legg til en `Tenant_id`-kolonne i hver tabell og håndheve isolasjon på radnivå.

- Logisk DB -isolasjon: Bruk separate skjemaer eller databaser per leietaker hvis SLA og datafølsomhet krever det.

- Skriv-bane separasjon: Isoler transaksjonelle meldinger med høy prioritet fra bulk/markedsføringskø ved DB-laget for å unngå støyende naboer.

Partisjonering og skala

I skala, visse tabeller (som levering_logger) vil vokse raskt. Tenk:

- Tidsbasert partisjonering: Shard logger månedlig eller ukentlig for å unngå oppblåste indekser.

- Arkivpolitikk: Flytt eldre logger til kjølerom (f.eks. S3 + Athena) for tilgang til revisjon uten å påvirke live -ytelsen.

- Token -cache: Synkroniser aktive enhetstokener i Redis eller DynamoDB for utsendte løkker med høy gjennomstrømning.

Redis Token Cache-skjema

Redis brukes som et leseoptimalisert, oppslagslag i minnet. Den unngår å treffe den primære DB under meldingssending og støtter oppslag av konstant tid på tvers av massive bruker-/enhetssett.

Primærbrukssaker:

- Rask fan-out av enhetstokener per bruker

- Oppslag etter brukersegmenter (f.eks. Aktive iOS -enheter)

- Token Deduplication and Expiry Control

- TTL -håndhevelse for inaktive eller roterte symboler

Anbefalt nøkkelstruktur

Key: push:user::tokens Type: Redis Set Value: token:: TTL: Optional (based on last_active)

Eksempel:

Key: push:user:5b6ed...d1:tokens

Value: {

"token:ios:abc123token...",

"token:web:def456token...",

"token:android:xyz789token..."

}

Alternativ nøkkel for direkte tokenoppslag

Key: push:token::

Type: Hash

Fields: {

user_id: ,

app_version: ,

last_seen: ,

is_active: true/false

}

TTL: 30 days from last_seen

Eksempel:

Key: push:token:ios:abc123token...

Value: {

user_id: "5b6ed...d1",

app_version: "6.4.1",

last_seen: "2025-04-21T18:11:45Z",

is_active: true

}Beste praksis

- Bulkbelastning fra DB: Cache-oppvarmingsjobber skal synkronisere aktive symboler fra den relasjonelle DB ved oppstart eller via CDC (endre datafangst).

- Ugyldig på uregistrering: Når en enhet er uregistrert eller token er merket ugyldig av APNS/FCM, sletter du Redis -oppføringen.

- Hold ttl mager: Tokens som ikke brukes på 30–60 dager, bør utløpe for å forhindre oppblåsthet i hurtigbufferen.

- Fanout på settnivå: Bruk Redis-sett for å få alle symboler per bruker og utføre meldingsvifte effektivt i arbeiderprosesser.

- Multi-leietakerstøtte: Prefiks alle nøkler med leietaker-ID hvis du opererer i et miljø med flere leietakere.

Denne hurtigbufferen kompletterer det vedvarende DB-laget ved å tjene som oppslag av lav latens under den kritiske sendesløyfen. Det hjelper også segment leveringsstrømmer (f.eks. Send bare til brukere med aktive iOS -symboler) uten dyre relasjonelle sammenføyninger eller full skanninger.

Trenger du hjelp til å strukturere enhetsdata for skala?

Sliter med å administrere millioner av enhetstokener, leveringslogger og opt-in-preferanser på tvers av mobil og nett?

Vi kan hjelpe deg med å designe et robust datalag – SQL og Redis inkludert – som holder push -systemet raskt, konsistent og alltid klart til å levere.

Detaljert komponentdesign

Hver del av systemet har sitt eget ansvar – men måten de jobber sammen definerer om push -arkitekturen kan skalere eller smuldre. I dette avsnittet vil vi bryte ned kjernekomponentene lag for lag: databehandling, servicelogikk, leveringsarbeidere og valgfrie brukergrensesnitt.

1. Data lag (lagring, tilgang og hurtigbufring)

- Relasjonell DB: Lagrer kjerneenheter (brukere, enheter, preferanser, varsler, leveringslogger).

- Redis: Fungerer som et høyhastighetsoppslagslag for aktive symboler, nyere leveranser og sanntids undertrykkelsesregler.

- ORM eller datatilgangslag: Bruk en ren abstraksjon for å håndheve validering, feltavstand og skjema -begrensninger. Unngå å skrive rå SQL i leveringsløkker.

- Les replikabruk: Rute høyt volum leste spørsmål (f.eks. Fan-out-oppslag) til kopier for å forhindre skrive strid.

2. Applikasjonslag (ruting, filtrering, segmentering)

Applaget er hjernen i systemet. Den vet hva den skal sende, til hvem, når og under hvilke forhold. Det er her forretningslogikk lever.

- Svelging API: Håndterer innkommende forespørsler fra interne tjenester (OTP, markedsføringsverktøy, transaksjonsutløsere).

- Meldingsrutingstjeneste: Bestemmer hvilke brukere/enheter som skal få hvilken melding. Bli med på Message Metadata med Redis Token -sett.

- Preferanse og regler Motor: Håndhever opt-in/out, kanalgrenser (f.eks. Max 2 Marketing Pings per dag) og tidsvinduer (f.eks. Ingen meldinger kl. 02.00).

- Hastighetskontroller: Throttles Message Dispatch per leietaker, per plattform, per region. Integreres med Redis -tellere eller skyvevindualgoritmer.

3. Integrasjonslag (leveringstjenester og arbeidere)

Hver plattform (APN -er, FCM, WebPush) har sine rare – så ikke abstraherer dem bak et generisk grensesnitt. Behandle dem i stedet som førsteklasses borgere med dedikerte leveringstjenester.

- APNS -arbeider: Bruker tokenbasert autentisering via JWT. Håndtak skyv over HTTP/2. Administrerer TCP -tilkoblingsbasseng og hastighetsgrenser fra Apple.

- FCM -arbeider: Auth via servicekontoer. Batches meldinger per emne eller brukergruppe. Sporfeil per enhet (f.eks. Uregistrert, kvoten overskred).

- Webpush -arbeider: Implementerer vapid, krypterer nyttelast ved bruk av elliptisk kurve kryptografi, og sender til sluttpunktet uris direkte.

- Prøv køen på nytt: Eventuell mislykket levering blir påstått med eksponentiell backoff. DLQS (dødskøer) fanger vedvarende feil for inspeksjon.

4. UI-lag (valgfritt, admin-vending)

Ikke alle systemer trenger dette, men for interne markedsføringsops eller produktteam kan et lett dashbord være nyttig.

- Kampanjekomponist: Lag og planlegg varsling sprengninger til brukersegmenter med WYSIWYG -verktøy.

- Forhåndsvisning og målretting: Live test på testenheter eller A/B -bøtter før en full utrulling.

- Aktivitetsrevisjon: Sanntids dashbord som viser hva som er i køen, hva som er levert og hva som mislyktes (med grunnkoder).

Designtips

- Bryt hver arbeider i statsløse mikroservices som kan skalere horisontalt.

- Ikke bruk den samme tjenesten for både levering og tilbakemelding (f.eks. APNS -kvitteringer). Isoler disse strømningene for spenst.

- Legg til strukturerte logg- og korrelasjons -ID -er ved hvert lag for sporbarhet.

Skalerbarhetshensyn

Push varslingssystemer trenger ikke bare å fungere – de trenger å jobbe *raskt *og *i skala *, under uforutsigbare trafikkstøt. Denne delen skisserer mønstrene, infrastrukturstrategiene og beskytter som er nødvendige for å holde gjennomstrømningen høyt og latenser lave, selv når du sender millioner av meldinger per minutt.

Horisontal skalering over nivåer

Hver komponent i systemet – 8 API, ruter, arbeidere, køer – skal være horisontalt skalerbar. Dette muliggjør uavhengig innstilling av flaskehalser uten å overleve hele rørledningen.

- API Gateways / Ingress: Front APIer skal autoskala basert på CPU/RPS. Bruk hastighetsbegrensning for å beskytte nedstrøms tjenester.

- Statsløse arbeidere: Leveringsarbeidere og rutere må være statsløse og containerisert. Bruk Kubernetes HPA (horisontal pod autoscaler) eller Fargate Autoscaling -regler basert på kødybde, CPU eller latens.

- Kødybdebasert skalering: Spor Backlog -størrelse og gyter flere arbeidere når dybden krysser terskel (f.eks. Kafka lag eller RabbitMQ kølengde).

Deling og partisjonering

- Shard av User_id: Partisjon levering av arbeidsmengder av hash -bruker -ID for å bevare lokaliteten og forhindre strid i DB- eller tokenbuffer.

- Kafka -partisjonering: Bruk meldingsnøkler basert på bruker- eller leietaker -ID for å rute varsler til riktig forbrukergruppe.

- Databasepartisjonering: For store bord som

levering_logger, Bruk tidsbasert partisjonering (f.eks. Månedlig) for å opprettholde spørringshastigheten.

Fan-out ytelsesoptimaliseringer

Den virkelige flaskehalsen i høyskala systemer er fan-out: å kartlegge en logisk melding til tusenvis eller millioner av enhetstokener.

- Redis Set Union: Bruk Redis for å få alle symboler til en bruker eller et årskull øyeblikkelig ved hjelp av SET -operasjoner.

- Batching API -samtaler: Gruppemeldinger etter plattform og batch-send (f.eks. FCM støtter opptil 500 symboler per batchforespørsel).

- Token deduplisering: Forsikre deg om at ingen dupliserte symboler går inn i leveringskøer. Oppretthold unikhet via Redis eller forbehandlingstrinnet.

Cache -strategi

- Symboler: Hurtigbufret per bruker -ID. TTL oppdatert ved levering eller pålogging.

- Innstillinger: Cache-undertrykkelsesregler (f.eks. Stille timer, frekvenshetter) i Redis eller Memory-Local Store.

- Grodd: Redis tellere (incrby + ttl) eller token bøtter for leietakernivå og globale caps.

Resiliensmønstre

- Skottisolasjon: Separate arbeiderbassenger per plattform. En FCM -nedgang skal ikke blokkere APNS Sends.

- Døde bokstavkøer: Vedvarende sviktende meldinger (f.eks. Ugyldige symboler) er lastet ut og logget for inspeksjon uten å stanse leveringsstrømmer.

- KRAFTBREKNINGER: Stopp på forsøk på forsøk på nedstrøms leverandører som viser høye sviktfrekvenser (f.eks. APNS 503S).

- Backoff -strategier: Bruk eksponentiell backoff med jitter for å prøve på nytt. Unngå stampedes under leverandøren av leverandøren.

Gjennomstrømnings benchmarks (baseline -mål)

- API inntak: 2.000–10 000 RPS per node avhengig av nyttelaststørrelse.

- Ruting og fan-out: 5.000–20 000 enhetstokenoppslag/sek med Redis + partisjonering.

- Leveringsarbeiders gjennomstrømning:

- APN -er: ~ 5.000–10.000 PUSHES/MIN PER CONNECTION (HTTP/2 Multiplekset)

- FCM: ~ 12 000/min med batchforespørsler

- Webpush: ~ 2000/min (enkelt endepunkt sender)

Trenger du hjelp til å gjøre din Push Pipeline skuddsikker?

Å bygge for skala er mer enn bare autoskalende belg. Fra Kafka Tuning til fan-out optimalisering og effektbrytere, kan vi hjelpe deg med å designe en push-infrastruktur som ikke vil blinke-selv på lanseringsdagen.

Sikkerhetsarkitektur

push-varslingssystemer Interface med sensitive brukerdata, skylmeldingsplattformer og interne tjenester. Hvis sikkerheten ikke blir bakt i hvert lag – fra tegn lagring til API -interaksjoner – legger du opp for personvernlekkasjer, misbruksvektorer og overholdelsesfeil. Denne delen dekker de essensielle sikkerhetsdesignprinsippene og praksisene for å herde systemet ditt ende-til-ende.

1. Autentisering og autorisasjon

- Intern tilgangskontroll: Alle interne API-er (inntak, planlegging, ruting) skal beskyttes med kortvarige JWT-er eller gjensidige TL-er-spesielt hvis de er tilgjengelige på tvers av tjenester eller miljøer.

- API-gateway-policyer: Bruk IAM eller RBAC på gateway-nivå for å begrense hvilke tjenester eller brukere som kan sende inn forskjellige typer varsler (f.eks. Transaksjonell kontra markedsføring).

- Leietakers separasjon: Hvis du støtter flere leietakersystemer, må du håndheve streng leietakerbasert isolasjon i hver spørring, rute og meldingsutsendingsstrøm.

2. Plattformpåleggsadministrasjon

Tredjepartsintegrasjoner med APN-er og FCM krever hemmeligheter som må håndteres med omhu.

- Oppbevar nøkler i en hemmelig leder: Bruk verktøy som AWS Secrets Manager, Hashicorp Vault eller GCP Secret Manager for å lagre APNS -nøkler og FCM -legitimasjon.

- Roter legitimasjon med jevne mellomrom: Bygg automatisering for å rotere serviceopplysning minst kvartalsvis.

- Begrens nøkkelomfang: Bruk servicekontoer med de minst privilegiene som kreves – ingen mer, ikke mindre.

3. nyttelastsikkerhet

- Ikke ta med PII i PUSH -nyttelast: Nyttelast er ofte synlige på OS -nivå (spesielt Android). Ta aldri navn, e -postadresser eller sensitive symboler.

- Krypter i ro og i transitt: Alle data i databasen og Redis må krypteres ved hjelp av AES-256 eller plattformspesifikk kryptering av Rest.

- Nettpush nyttelastkryptering: VAPID-basert nettpush krever elliptisk kurvekryptering (NIST P-256); Dette må håndteres riktig for å unngå taus leveringssvikt.

4. Misbruksbeskyttelse og rentebegrensning

Venstre ukontrollert, kan et push -system bli våpnet – enten til spam -brukere eller for å overbelaste leveringsinfrastruktur.

- Per-service rate grenser: Bruk Redis-tellere eller lekker-bøtte-algoritmer for å håndheve per-API og per-leietakerhastigheter.

- Kvotehåndhevelse: Daglige meldingsgrenser per bruker eller segment (spesielt for markedsføring) bør håndheves ved rutingslaget.

- Audit Trails på autoritetsnivå: Alle forespørsler om å sende meldinger skal være revisible med tjenestenavn, brukeridentitet, IP og meldingsmetadata.

5. Hemmeligheter og legitimasjonshygiene

- Bruk isolasjon på miljønivå: Del aldri Dev, iscenesettelse og PROD -legitimasjon for push -tjenester.

- Deaktiver klagetekstlogger: Unngå loggtokener, legitimasjon eller skyv nyttelast med sensitive metadata i logger. Masker alt som ikke er nødvendig for feilsøking.

- Overvåking for misbruk: Varsle om brukspikene utenfor forventede mønstre-spesielt sender høyt volum fra ikke-produkter eller plutselige FCM-feil.

6. Klientsiden beskyttelse (minimal, men verdt å nevne)

- Rotasjon på appnivå: Forsikre deg om at mobil SDK din oppdaterer symboler med jevne mellomrom og avregistrerer dem på innlogging eller avinstaller.

- SSL -pinning (valgfritt): Hvis appen kobles til din backend direkte for å registrere deg for push, kan du vurdere å feste for å forhindre MITM -angrep.

Utvidbarhet og vedlikeholdbarhet

Et skalerbart push-system er ikke en engangsbygging-det må utvikle seg med endrede forretningsbehov, plattformoppdateringer og bruksmønstre. Arkitekturen må være modulær, enkel å utvide og trygt å vedlikeholde uten å innføre regresjoner. Denne delen skisserer hvordan du strukturerer push-infrastrukturen for langsiktig evolusjon og utviklerens fornuft.

1. Plugin-vennlig arkitektur

En ren skille mellom kjernelogikk og leveringsspesifikk logikk muliggjør raskere iterasjon uten å destabilisere produksjonsstrømmer.

- Leveringsarbeidere som plugins: Innkapsler APN -er, FCM og Webpush -logikk i frittstående moduler med et delt leveringsgrensesnitt (f.eks. `Send (token, nyttelast, konfigurasjon)`).

- Meldingstransformatorer: Implementere transformasjonskroker per plattform (f.eks. APNS bruker `Alert`, FCM bruker` Notification` + `Data`).

- Kroker for tilpasset logikk: Tillat forhåndssending og ettersendingskroker i rutingslaget for leietakerspesifikke overstyringer, for eksempel tilpasset gass- eller A/B-logikk.

2. Rengjør kodepraksis

Push CodeBases har en tendens til å bli dumping av plattformspesifikke hacks med mindre de opprettholdes strengt.

- Strenge grensesnittkontrakter: Bruk klare grensesnitt for leveringsmoduler og meldingsdefinisjoner (f.eks. `MessagePayload`,` DeliveryContext`).

- Central Config Management: Alle hastighetsgrenser, policyer på nytt og plattforminformasjon bør defineres eksternt i konfigurasjonsfiler eller hemmelighetsledere.

- Servicegrenser: Unngå å koble rutinglogikk med leveringslogikk. Behandle hver som en uavhengig distribuert mikroservice.

3. Funksjonsflagg og versjonering

Støtt iterativ funksjonsutvikling og bakoverkompatibilitet gjennom streng versjon.

- Versjonerte meldingsformater: Definer meldingsskjemaer med versjonering (`V1`,` V2`, etc.) og støtteoppgraderinger parallelt uten å bryte eldre formater.

- Funksjonsflagg for nye strømmer: Rull ut ny leveringslogikk bak flagg per leietaker eller miljø for å minimere eksplosjonsradius.

- Myk-avhendingsmodell: Merke arv APIer og meldingstrukturer for planlagt fjerning; Legg til logging når den brukes.

4. Testing og valideringslag

Én ødelagt nyttelast kan kaskade til leveringssvikt. Ivareta hver ny utgivelse med sterk validering.

- Skjemavalidering: Bruk JSON -skjema eller protobuf -validering før du gir meldinger til utsendelse.

- Kontraktstesting: Definer forventningene til plattformmoduler ved å bruke pakt eller lignende verktøy for å forhindre integrasjonsdrift.

- Sandkassemodus: Gi en tørrkjørt eller testmodus for interne tjenester for å simulere push uten å treffe levende endepunkter.

5. Vedlikeholdbarhet Anti-mønster for å unngå

- Hardkodende plattformspesifikk oppførsel: Alltid abstrakt plattformlogikk i moduler eller plugins.

- Blanding av leietakerlogikk med global logikk: Bruk scoped-tjenester eller forhold på rutenivå-ikke overstyring av leietaker.

- Mangel på observerbarhet i nye strømmer: Nye ruter eller moduler må inneholde strukturerte logger, beregninger og feilhåndtering fra første dag.

Ytelsesoptimalisering

Å skyve millioner av varsler handler ikke bare om systemdesign – det handler også om hvor effektivt hver komponent kjører under press. Ytelsesinnstilling kan redusere latens, forbedre gjennomstrømningen og forhindre svikt nedstrøms. Denne delen fokuserer på hvordan du optimaliserer push -rørledningen ved dataene, behandlingen og leveringslagene.

1. Tuning av databasesøk

- Målrettede indekser: Sørg for indekser på `token`,` user_id` og `varsling_id` i sine respektive tabeller. Sammensatte indekser hjelper til med fan-out-avlesninger (f.eks. `Enhet_id, status`).

- Spørring etter segment -ID, ikke rå brukerfilter: Unngå komplekse spørsmål om spørsmål under sendetid. Precompute segmenter og cache -bruker -ID -er eller symboler i Redis.

- Tilkoblingsbassengstyring: Bruk tilkoblingssamling (f.eks. PGBOUNCER) for å unngå spiky be om flaskehalser under løp med høyt volum.

2. Token fan-out effektivitet

- Batch lyder fra Redis: Når du henter symboler per bruker eller per segment, bruker du alltid `Smembers` +` mget` i rørleder.

- Bulkleveringsløkker: Prosess i partier (f.eks. 500–1 000 symboler per iterasjon) for å unngå overhead per enhet.

- Nyttelast mal hurtigbufring: Cache gjengitte nyttelast (tittel/kropp/metadata) når du sender til lignende enhetsgrupper.

3. ASYNC -prosessering og arbeidstakerinnstilling

- Melding Prefetch: Bruk Melding Prefetch -tellinger (f.eks. Kafka `Fetch.min.bytes`, RabbitMQ` prefetch_count`) for å redusere ledig tid hos leveringsarbeidere.

- Levering Batching: FCM og WebPush tillater en viss grad av batching-bruk dette når du sender ikke-personaliserte kampanjer.

- Arbeiderbassenging per region: Kjør isolerte arbeiderbassenger (eller pods) per geografisk region for å minimere tverrregions latens og redusere skyutgangskostnadene.

4. Ratebegrensning og strømningskontroll

- Skyving av vinduseller: Bruk Redis Lua-skript for å implementere plattformrente (f.eks. Maks 100k/sek per plattform eller leietaker).

- Købesting: Dynamisk reduserer meldingshastigheten fra megleren når feilrater spike (f.eks. APNS 429s eller FCM kvotefeil).

- Backoff Control: Bruk jitteret eksponentiell backoff for å forhindre at dundrende besetninger på nytt mislykkede leveranser.

5. Frontend-gjengivelsesytelse (bare nettpush)

- Nyttelast minimering: Webpush -meldinger skal være kompakte – Strip ekstra metadata, hold til ~ 2KB eller mindre for raskest gjengivelse.

- Ruting på klikk: Bruk spørringsparametere eller dype lenker i webpush `click_action` for å drive raskere opplevelser i appen eller nettleser.

- Lat gjengivelse av berikelse: Der det er mulig, viser minimalt varslingsinnhold og last inn alle detaljer etter at brukeren har klikket.

6. Overvåkning og tilbakemeldingssløyfeoptimalisering

- Spor latens prosentiler: Ikke bare overvåke gjennomsnittlig leveringstid. Spor P90, P99 for å fange langhale-levering.

- Tilbakemeldingsfiltrering: Innta bare kritisk levering av levering (Token utløpt, enhet ugjennomtrengelig) i stedet for alt, for å redusere analyselastningen.

- Metrics Aggregation: Bruk verktøy som Prometheus med kardinalitetsbevisste etiketter for å unngå metrisk eksplosjon under høyt volum.

Teststrategi

Et system som presser til millioner av enheter kan ikke stole på manuelle QA eller isolerte tester. Levering er asynkron, tredjepartsavhengig og sanntid-noe som betyr at testing må være lagdelt, automatisert og svikt-spenstig. Denne delen dekker hvordan du nærmer deg testing i alle faser: lokal utvikling, CI -rørledninger og herding av produksjonen.

1. Enhetstesting

Enhetstester sikrer at intern logikk oppfører seg riktig på tvers av ruting, tokenoppløsning og generering av nyttelast.

- Testrutingslogikk: Valider brukermålretting av filtre, preferansehåndhevelse og plattformsplitting.

- Mock Token -sett: Simuler Redis/DB-svar med falske token-kartlegginger for å teste fan-out logikk.

- Skjemavalidering: Forsikre deg om at nyttelast er i samsvar med plattformskjemaer-varsling/meldingsstruktur, plattformspesifikke felt osv.

2. Integrasjonstesting

- Meldingskøer i minnet: Kjør Kafka/RabbitMQ lokalt (eller bruk testbeholdere) for å simulere full flyt fra produsent-til-forbruker.

- Falske leveringsadaptere: Mock APNS, FCM og WebPush med lokale endepunkter som simulerer tilfeller av suksess/svikt, inkludert gasspjeld eller uregistrerte enheter.

- Ende-til-ende leveringsstrøm: Hevder at en melding som er sendt til inntak API, når vellykket den hånede leveringsadapteren via kø, regler motor og arbeidstakers tjenester.

3. Kontraktstesting

Kontraktstester validerer at plattformleveringsmoduler ikke brytes på grunn av eksterne API- eller meldingsformatendringer.

- Bruk pakt eller lignende verktøy: Definer kontraktsforventninger for hver leveringsmodul (APNS, FCM, WebPush).

- Versjonerte skjemaer: Hold meldingsformater versjonert, og verifiser bakoverkompatibilitet på endringer.

4. Last- og stresstesting

Push Systems må holde opp under volum i den virkelige verden. Lasttesting hjelper til med å validere køens ytelse, Redis treff og DB -strid.

- Simulere kampanjer: Injiser 10m+ spotte meldinger i køen for å observere arbeidstakers skalering, feilrater og meldingsforsinkelse.

- Spike og suge tester: Valider hvordan systemet håndterer korte utbrudd (100K/min) mot langsiktig jevn volum (10K/sek i timevis).

- Isoler langsomme tjenester: Overvåke hvilke komponenter (f.eks. Ruting, DB skriver, tokenbuffer) bremser under volum.

5. CI -rørledningsdekning

- Test hver push -bane: Inkluder leveringslogikk, tilbakeslag på nytt og feilhåndtering som en del av automatiserte CI -løp.

- Bruk syntetiske symboler: Generer dummy APNS/FCM -symboler for test nyttelast (bruk aldri ekte i CI).

- Lint -skjemaer: Auto-validerer alle nyttelast mot plattformspesifikasjon før fusjoner ved bruk av JSON-skjema eller protobuf-sjekker.

6. Kaos og feilinjeksjon (avansert)

For team som opererer i massiv skala, introduserer kontrollert kaos for å fange kantsaker før brukere gjør det.

- Slipperverdier: Simuler nettverksforsinkelser eller tap mellom arbeidstaker og push -leverandør.

- Injiser dårlig nyttelast: Korrupte felt eller krenke skjemakontrakter for å bekrefte systemfangst og isolerer problemet.

- Inntak av tilbakemelding av gasser: Forsink leveringskvitteringer for å sikre at systemet ikke blokkerer eller krasjer på grunn av manglende statusoppdateringer.

DevOps og CI/CD

push-varslingssystemer spenner over flere tjenester, køer, databaser og tredjepartsintegrasjoner. Denne kompleksiteten krever en automatisert, pålitelig DevOps -rørledning som kan bygge, teste, distribuere og rulle tilbake med selvtillit. Denne delen dekker verktøyet og praksis som er nødvendig for å holde leveringsrørledningen rask, trygg og observerbar.

1. CI/CD -rørledningsdesign

- CI praksisplasser: Lint → Enhetstester → Kontraktstester → Integrasjonstester → Skjemavalidering → Docker Build

- CD -trinn: Kanariutvikling → Helsekontroller → Metrikk Gate → Full utrulling

- Forhåndsutviklingsskjema Diff: Auto-sjekk databasemigrasjoner for kompatibilitet og potensielle problemer med driftsstans (f.eks. Legge til ikke-null kolonner uten standardverdier).

2. Distribusjonsstrategier

- Blågrønn distribusjon: For statlige tjenester som planleggere eller inntak API-er, bruk blågrønn for å bytte trafikk uten driftsstans.

- Kanariutplassering: For leveringsarbeidere og rutere, distribuerer du til et lite POD -delmengde (f.eks. 5%) og observerer for leveringsfeil eller plattform -API -feil.

- Progressive utrullinger: Rull ut funksjoner ved hjelp av konfigurasjonsflagg (ikke kodegrener), slik at endringer kan kobles ved kjøretid.

3. Infrastruktur som kode (IAC)

- Bruk terraform eller pulumi: Administrer infra på tvers av AWS/GCP for køer, DBS, Redis -klynger og VPC -er.

- Dynamiske miljøer: Spinn opp isolerte testmiljøer på funksjonsgrener for å teste push-strømmer ende-til-ende uten å forurense iscenesettelse.

- Secrets Automation: Butikk Push Service -legitimasjon i hemmelige ledere og injiserer i POD -er via forseglede hemmeligheter eller sidevogn.

4. Gitops og konfigurasjonsadministrasjon

- Versjonerte konfigurasjoner: Hold rentegrensene, prøvene på nytt og leietaker overstyrer i GIT – ikke hardkodet til tjenester.

- ConfigMap-drevet oppførsel: Injiser plattformspesifikke innstillinger i arbeidere (f.eks. APNS-bassengstørrelse, Webpush TTL) via Kubernetes ConfigMaps.

- Rollback via Git REVERT: Hvis en konfigurasjon eller flagg bryter produksjonen, muliggjør Gitops rask tilbakevending med revisjonbarhet.

5. Utgivelsesvalidering og sjekker etter distribusjon

- Hooks etter distribusjon: Utløs helsekontroller eller røykprøver automatisk etter utrulling.

- Se leveringsmålinger: Overvåk leveringshastigheter, feilkoder og køstørrelse i 15–30 minutter etter distribusjon før skalering fullt ut.

- Mislykkesfast oppførsel: Hvis leveringsfeil spike (f.eks. Ugyldige symboler, 403 fra FCM), auto-Halt-distribusjon og varsle på samtale.

Trenger du hjelp til å sende pushvarsler med selvtillit?

Å bygge et robust push -system er en ting – å drive det i produksjon uten frykt er en annen. Hvis du trenger hjelp til å sette opp en CI/CD-rørledning, sikre distribusjoner og rollback-sikre utgivelser for push-stabelen din, har vi gjort det før.

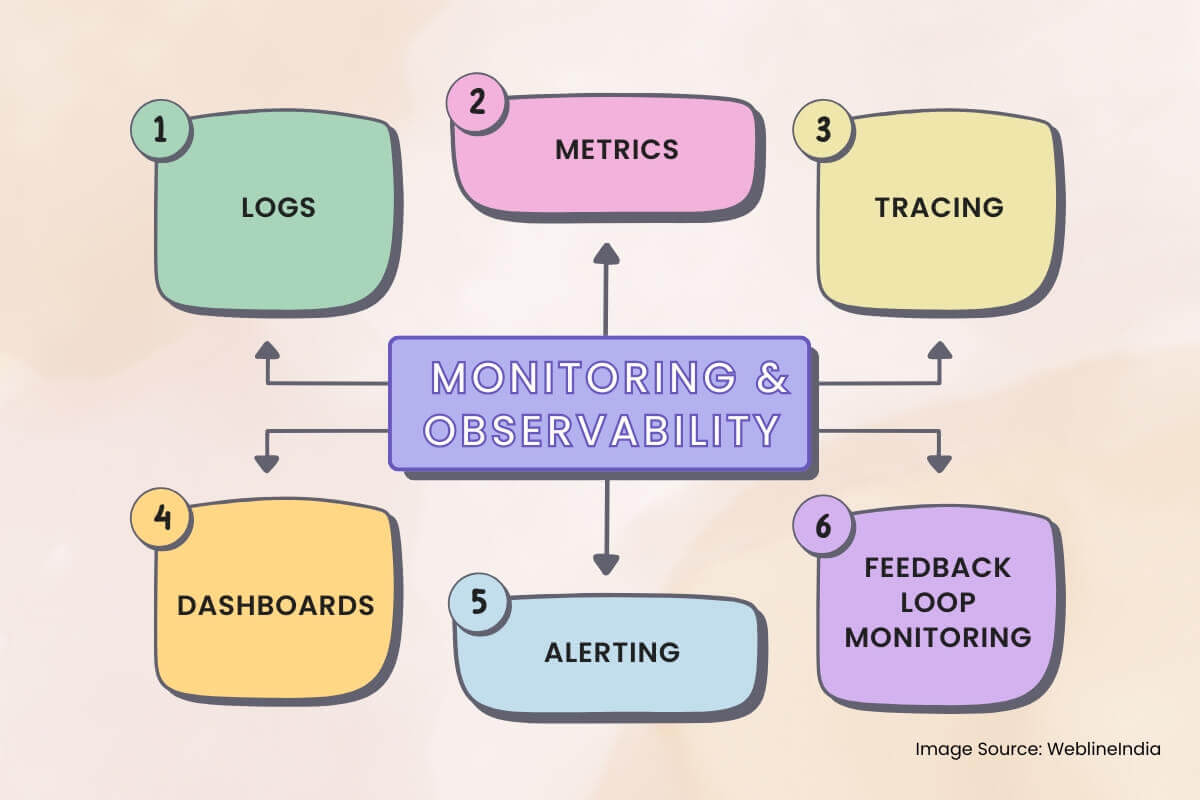

Overvåking og observerbarhet

push-varslingssystemer er asynkrone, distribuert og er avhengige av svartboks tredjeparts tjenester som APN-er og FCM. Uten riktig observerbarhet går feil upåaktet hen, lydløse leveringsdråper oppstår, og feilsøking blir gjetning. Denne delen skisserer hva du skal overvåke, hvordan du sporer meldingsstrømmen og hvordan du bygger meningsfulle varsler.

1. Logger

- Strukturert logging: Bruk JSON -logger med felt som `message_id`,` enhet_id`, `plattform`,` status` og `error_code` for alle leveringsstadier.

- Korrelasjons -ID -er: Taglogger fra inntak → Ruting → Leveringsarbeidere med en delt forespørsel-ID for ende-til-ende sporbarhet.

- Redact Sensitive Fields: Maskekikker, bruker-ID-er eller nyttelastinnhold i logger-spesielt på delte eller tredjepartsplattformer.

2. Metriker

Metrics forteller deg hva som skjer på makronivå. Agent dem på tvers av tjenester for å oppdage plattformens brede problemer tidlig.

- Leveringsgjennomstrømning: Meldinger sendt per plattform per minutt. Bryt ned av `leietaker`,` prioritert `og` message_type` (transaksjonell/markedsføring).

- Leveringssuksess/feilrate: Spor `levert`,` dropped`, `mislyktes` og `på nytt` bøtter – med tagger for grunnårsak (`uregistrert`,` rate_limited`, `ugyldig_token`).

- Kø latens: Tid fra enqueue til arbeidstakers henting og arbeidstaker til plattformbestemmelse.

3. Sporing

Spor er kritiske når meldinger lydløst forsvinner eller blir forsinket. Integrer distribuert sporing i hver intern tjeneste.

- Spor spenner: Svelging → Redis/Token -oppslag → Preferansekontroll → Køskø ENQUEUE → Arbeiderutlevering → Plattformlevering.

- Koblingslogger til spor: Inkluder sporings -ID -er i logger og dashbordlenker (f.eks. Fra Kibana til Jaeger/Tempo).

- Samplingshastighetskontroll: Spor alltid OTP -er og mislykkede meldinger; Bruk sannsynlig prøvetaking for kampanjer for å redusere overhead.

4. Dashboards

Dashboards i sanntid hjelper operatører og ingeniører på samtale med å forstå systemets helse på et øyeblikk.

- Plattformleveringsstatus: Sanntidstellinger av sendt, mislykkede, gjeninnførte meldinger per plattform (APNS/FCM/WebPush).

- Køyedybde: Levende synlighet i ruting og leveringskøer – Stigende kødybde indikerer metning eller nedstrøms nedgang.

- Tilbakemeldingssignalanalyse: Visualiser token ugyldige, hastighetsgrenser rammet og tilbakemeldingskvitteringer fra push -plattformer.

5. Varsling

- Feil Spike Alerts: Hvis mislykkede meldinger overstiger en terskel (absolutt telling eller feilrate %) i et skyvevindu.

- Latensvarsler for levering: Hvis P95 latens overstiger SLA (f.eks. OTP> 3S, Kampanje> 30 -tallet).

- Vekst av dødsbrev: Varsel om DLQ -er begynner å samle meldinger – signaliserer en vedvarende feilbane.

6. Tilbakemeldingssløyfeovervåking

Plattformer som APN -er og FCM sender tilbakemelding asynkront. Disse kvitteringene trenger sin egen rørledning.

- Tilbakemeldingsinntak av arbeidere: Forbruk og lagre uregistrerte tokenhendelser, leveringsfeil og rådgivning om rate-limit.

- Metrikk Extraction: Aggregerte tilbakemeldingssignaler til dashboards og feilklassefordelinger.

- Token Cleanup Automation: Utløs bakgrunnsjobber for å deaktivere eller fjerne foreldede symboler basert på tilbakemeldinger fra plattformen.

Avveininger og designbeslutninger

Hvert arkitektonisk valg kommer med avveininger. Å designe et skalerbart pushvarslingssystem betyr kontinuerlig balansering av latens kontra gjennomstrømning, enkelhet kontra fleksibilitet og pålitelighet kontra kostnad. Denne delen skisserer noen av de viktigste beslutningene som ble tatt i hele systemet og alternativene som ble vurdert.

1. Plattformspesifikke arbeidere kontra enhetlig leveringsgrensesnitt

- Avgjørelse: Separat APN -er, FCM og WebPush i isolerte leveringstjenester.

- Avveining: Mer kode og distribusjonskompleksitet, men mye bedre feil isolasjon, skalerbarhet og feilsøkbarhet per plattform.

- Alternativ: Et generisk enhetlig grensesnitt kan redusere kodeduplisering, men vil kreve omfattende betinget logikk og redusere observerbarhet.

2. Redis Token Cache vs. DB-bare levering

- Avgjørelse: Bruk Redis for aktiv tokenoppslag og fan-out under meldingsruting.

- Avveining: Krever bakgrunnssynkroniseringer og ugyldige logikk, men forbedrer leveringsgjennomstrømningen drastisk og reduserer DB -belastningen.

- Alternativ: Direkte DB-lesninger under fan-out ville forenkle arkitekturen, men ville ikke skalere på volum på kampanjivå.

3. Kafka for meldingskø kontra enklere køer

- Avgjørelse: Bruk Kafka eller tilsvarende distribuert logg for ruting og leveringskø.

- Avveining: Brattere læringskurve- og infra -styringsbelastning, men muliggjør høy holdbarhet, forsøk på nytt og forbrukerskalabilitet.

- Alternativ: RabbitMQ/SQS er enklere å betjene, men gir mindre fleksibilitet for storskala fan-out eller leveringsgarantier.

4. Døde bokstavkøer vs. Inline Retry Loops

- Avgjørelse: Bruk dedikerte DLQ-er for permanente feil og begrens på prøver på nytt til 2–3 forsøk.

- Avveining: Litt høyere operativ overhead, men forhindrer køblokkering og tillater prosessering av async.

- Alternativ: Inline Retry med Backoff er enklere å implementere, men risikerer å overbelaste nedstrøms systemer eller forsinke meldinger.

5. Tidsbasert DB-partisjonering kontra flat bordvekst

- Avgjørelse: Partisjonsleveringslogger etter måned for å kontrollere indeksstørrelse og oppbevaringspolitikk.

- Avveining: Mer komplisert spørringsruting og potensiell datatilgangsfragmentering.

- Alternativ: Et monolitisk bord ville være lettere å administrere innledningsvis, men ville forringe ytelsen og komplisere opprydding av oppbevaring.

6. Avveininger i funksjonshastighet vs. leveringsgarantier

- Avgjørelse: Separat transaksjonell fra markedsføring strømmer ved hvert lag – svelging, køer, leveringstjenester.

- Avveining: Mer rutingkompleksitet og ytterligere infrastruktur, men forhindrer ikke-kritisk trafikk fra nedbrytende kritiske veier (f.eks. OTPs).

- Alternativ: En enhetlig flyt forenkler ruting, men risikerer kundepåvirkning under tunge kampanjer eller plattformbestandighet.

7. Kjente tekniske gjeldsområder

- Stale tokenopprydding: Trenger optimalisering eller automatisering via inntak av tilbakemeldingssløyfe.

- Segment pre-materialisering: For tiden kjører Just-in-Time under kampanjesending; bør flyttes til bakgrunnsjobber.

- Hastighetsbegrensningsskalering: Delte Redis-forekomster for takstkontroll kan bli en flaskehals under kampanjer i global skala.

Hva denne arkitekturen blir riktig

Å designe et skalerbart pushvarslingssystem handler ikke bare om å sende meldinger – det handler om å levere de riktige meldingene, til de rette enhetene, pålitelig og i skala. Denne arkitekturen er spesialbygget for å møte den utfordringen, balansere gjennomstrømning, kontroll og vedlikeholdbarhet på tvers av et sterkt distribuert system.

Viktige takeaways

- Avkoblet arkitektur: Svelging, ruting og levering er rent atskilt for spenst og skalerbarhet.

- Plattformisolasjon: Hver push -tjeneste (APNS, FCM, WebPush) håndteres av en dedikert arbeidersett innstilt til quirks.

- Token hurtigbufring og fan-out: Redis styrker rask tokenoppløsning, noe som muliggjør levering med høy gjennomstrømning uten å hamre din primære DB.

- Data holdbarhet: Meldingskøer sikrer pålitelig levering selv når plattform APIer mislykkes, med DLQ -er som fanger kantsaker for senere inspeksjon.

- Observerbarhet overalt: Sporing, beregninger og strukturerte logger gjør feilsøking av leveringsrørledninger og brukernivåstrømmer praktiske i skala.

- Funksjonssikker utvidbarhet: Modulære komponenter, krokbasert logikk og skjemaversjoning lar systemet utvikle seg uten å bryte arvestier.

Muligheter for fremtidig forbedring

- Finkornet gass: Perbruker- eller planer om enheter kan ytterligere redusere overmelding og forbedre UX.

- Segment -materialiseringsrørledning: Avlasting av segmentering til forhåndsplanlagte bakgrunnsjobber ville gjøre kampanjesentre enda raskere.

- Regional leveringsoptimalisering: GEO-lokal leveringsarbeidere kan redusere latens- og skyutgangskostnader ved å holde plattformanrop nærmere brukerens opprinnelse.

Dette systemet fungerer ikke bare – det vil holde under press, skala med vekst og holde seg vedlikeholdbart etter hvert som brukssaker utvikler seg. Det er det som skiller innkast varslingsskript fra en leveringsplattform i sanntid, produksjonsklasse.

Trenger du hjelp til å få pushvarslingssystemet til dette nivået?

Å designe og skalere en multi-platform push-varslingsarkitektur er ikke et helgeprosjekt. Hvis du ønsker å bygge noe pålitelig fra første dag eller fikse det som allerede viser sprekker, kan vi hjelpe konstruere systemet brukerne dine forventer.

Kundeuttalelser: Hør det direkte fra våre globale kunder

Våre utviklingsprosesser leverer dynamiske løsninger for å håndtere forretningsutfordringer, optimalisere kostnader og drive digital transformasjon. Løsninger støttet av eksperter styrker kundefrafall og digital tilstedeværelse, og dokumenterte suksesshistorier fremhever problemløsning i praksis gjennom innovative applikasjoner. Våre anerkjente kunder over hele verden har allerede opplevd det.

Priser og Anerkjennelser

Selv om fornøyde kunder er vår største motivasjon, har bransjeerkjennelse betydelig verdi. WeblineIndia har konsekvent ledet an innen teknologi, med priser og utmerkelser som bekrefter vår fremragende kvalitet.

OA500 Globale outsourcing‑selskaper 2025, av Outsource Accelerator

Ledende programvareutviklingsselskap, av GoodFirms

Beste fintech-produktselskap – 2022, av GESIA

Tildelt som – Beste apputviklingsselskap i India 2020, av SoftwareSuggest