Der Aufstieg der KI -Tools für künstliche Intelligenz (KI) hat die Branchen revolutioniert und die Effizienz und Automatisierung verbessert. Eine der anhaltendsten Herausforderungen in der KI -Forschung und -entwicklung ist jedoch das Black -Box -Problem in der KI. Dieses Problem umfasst KI -Systeme, die Entscheidungen treffen, ohne transparente Erklärungen für diese Entscheidungen zu liefern. Das Verständnis, wie sich dieses Problem auf die Entwicklung von KI -Technologien auswirkt, und die potenziellen verfügbaren Lösungen sind entscheidend, um Vertrauen in KI und ihre Anwendungen aufzubauen.

Verwirrt über KI-Entscheidungen? Lassen Sie sich von unseren Experten helfen, erklärbare KI zu implementieren!

Das schwarze Boxproblem in KI: Ein Überblick

Im Kern bezieht sich die Black Box in AI auf die Deckkraft von Entscheidungsprozessen in vielen Modellen für maschinelles Lernen, insbesondere Deep-Learning-Modelle. Diese Modelle können genaue Ergebnisse erzielen, aber ihre internen Arbeiten sind oft zu komplex, um sie zu interpretieren. Das Black Box-Problem in der KI wird in Bereichen mit hohen Einsätzen wie Gesundheitswesen, Finanzen und Strafverfolgungsbehörden besonders problematisch, in denen das Verständnis, warum eine Entscheidung getroffen wurde, von entscheidender Bedeutung ist.

- KI -Tools wie tiefe neuronale Netze sind bei der Mustererkennung ausgestattet, sind jedoch oft zu verworren, als dass Menschen vollständig verstehen, um sie vollständig zu verstehen.

- Die Komplexität entsteht, da diese Modelle mehrere Berechnungs- und Transformationenschichten beinhalten, sodass es schwierig ist, festzustellen, wie Eingabedaten in Ausgabeentscheidungen werden.

Der Einfluss des Black Box -Problems in der KI

Der Mangel an Transparenz bei der Entscheidungsfindung schafft in vielerlei Hinsicht Herausforderungen:

- Rechenschaftspflicht: In Fällen, in denen KI -Systeme fehlerhafte oder schädliche Entscheidungen treffen, ist es schwierig, die genaue Ursache des Problems zu bestimmen, die die Rechenschaftspflicht und das Vertrauen erschweren.

- Voreingenommenheit: Ohne Einblick in die Funktionsweise von KI-Systemen wird es schwieriger, alle Verzerrungen im Entscheidungsprozess des Modells zu identifizieren und zu korrigieren.

- Regulatorische Bedenken: Während sich die KI weiterentwickelt, stehen die Aufsichtsbehörden vor Herausforderungen, um sicherzustellen, dass diese Technologien den ethischen Standards und Gesetzen entsprechen. Mangel an Interpretierbarkeit behindert die Regulierung.

Verständnis der Notwendigkeit von erklärbarer KI

Um das Problem der Black Box in AI zu mildern, wenden sich die Forscher der erklärbaren KI (XAI) zu. Erklärbare AI Ziel ist es, eine klare, verständliche Erklärung zu geben, wie KI -Systeme zu ihren Entscheidungen gelangen. Dies ist entscheidend für die Förderung des Vertrauens, die Gewährleistung der Fairness und die Aufrechterhaltung der Rechenschaftspflicht.

Mit KI -Transparenz zu kämpfen? Holen Sie sich AI -Lösungen, die klar und verantwortlich sind.

Wie erklärbare KI hilft

- Transparenz: Mit erklärbarer KI können Benutzer auf Einblicke in die Verarbeitung von KI -Systemen zugreifen und Vorhersagen treffen.

- Vertrauen und Adoption: Da Stakeholder die KI-Entscheidungsfindung verstehen können, vertrauen sie eher KI-Tools für kritische Anwendungen.

- Ethische Entscheidungen: Erklärbare KI fördert ethische Entscheidungen, indem sie Verzerrungen oder diskriminierende Muster in AI-Systemen aufzeigen.

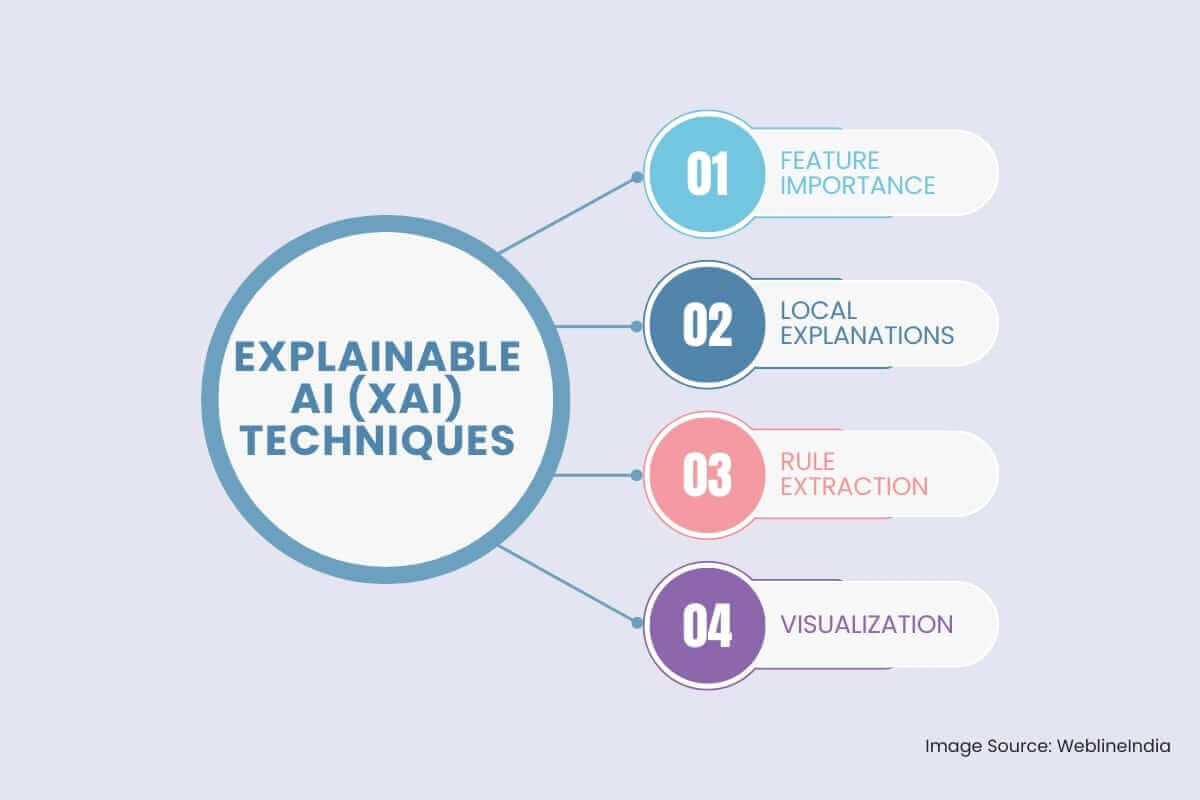

Erklärbare KI (XAI) -Techniken

Um das Problem mit schwarzem Box anzugehen, ist das Feld der erklärbaren KI (XAI) entstanden. XAI konzentriert sich auf die Entwicklung von Techniken, die die Entscheidungsprozesse von KI-Modellen transparenter und verständlicher machen. Einige wichtige XAI -Techniken umfassen:

- Wichtigkeit aufweisen: Diese Technik zielt darauf ab, die Eingabefunktionen zu identifizieren, die den größten Einfluss auf die Ausgabe des Modells haben.

Permutationswichtigkeit: Diese Methode bewertet die Bedeutung eines Merkmals, indem sie ihre Werte zufällig mischt und beobachtet, wie sich dies auf die Leistung des Modells auswirkt.

Shap (Shapley-Additive Erklärungen): Dieser auf Spieltheorie basierende Ansatz bietet ein nuancierteres Verständnis der Merkmals Bedeutung, indem die Ausgabe des Modells auf einzelne Merkmale zurückzuführen ist.

- Lokale Erklärungen: Diese Methoden liefern Erklärungen für einzelne Vorhersagen des Modells.

LIME (lokale interpretierbare Modell-Agnostische Erklärungen): Diese Technik nähert sich dem Verhalten des Modells lokal um einen bestimmten Datenpunkt unter Verwendung eines einfacheren, interpretierbaren Modells wie einem linearen Modell oder einem Entscheidungsbaum.

Anker: Diese Methode identifiziert eine Reihe von Bedingungen (Anker), die, falls vorhanden, eine spezifische Vorhersage mit hoher Wahrscheinlichkeit garantieren.

- Regelextraktion: Dieser Ansatz beinhaltet das Extrahieren von Regeln für menschliche Lesbare aus dem geschulten Modell.

Entscheidungsbauminduktion: Diese Technik beinhaltet den Aufbau eines Entscheidungsbaums, der leicht vom Menschen interpretiert werden kann, um die Vorhersagen des Modells zu approximieren. Regelbasierte Systeme: Diese Systeme repräsentieren explizit das Wissen des Modells in Form von IF-Then-Regeln.

- Visualisierung: Die Visualisierung der internen Funktionsweise eines KI-Modells kann wertvolle Einblicke in den Entscheidungsprozess liefern.

Aktivierungskarten: Diese Visualisierungen unterstreichen die Bereiche eines Bildes, auf das sich das Modell bei einer Vorhersage konzentriert.

Aufmerksamkeitsmechanismen: Diese Techniken können verwendet werden, um die Teile eines Textes oder einer Sequenz zu visualisieren, auf die das Modell bei einer Vorhersage aufmerksam macht.

Herausforderungen bei der Entwicklung erklärbarer KI überwinden

Während die erklärbare KI eine vielversprechende Lösung bietet, wird die Implementierung effektiv mit eigenen Herausforderungen verbunden:

- Kompromiss zwischen Genauigkeit und Erklärung: Einige der leistungsstärksten KI-Tools wie tiefe neuronale Netze bieten möglicherweise eine hohe Genauigkeit, aber auf Kosten, um schwerer zu erklären. Das Ausgleich dieser beiden Faktoren bleibt eine erhebliche Herausforderung.

- Komplexität von Modellen: Viele AI -Technologien stützen sich auf fortschrittliche Algorithmen, die von Natur aus schwer zu erklären sind. Untersuchungen untersuchen weiterhin, wie diese komplexen Modelle interpretierbar machen können, ohne ihre Leistung zu beeinträchtigen.

- Skalierbarkeit: Wenn KI -Tools in größeren Maßstäben eingesetzt werden, kann die Aufrechterhaltung effektiver Erklärungen für jede Entscheidung, die das System getroffen hat, überwältigend werden.

Die Rolle von AI -Technologien bei der Lösung des Black Box -Problems

KI -Technologien entwickeln sich ständig weiter, um transparentere und interpretierbarere Systeme zu schaffen. Von der Entwicklung besserer Algorithmen bis hin zur Verbesserung der Datenvisualisierungstechniken ebnen diese Technologien den Weg für Lösungen für das Black -Box -Problem in der KI.

- Hybridmodelle: Die Kombination von Erklärungs- und Black-Box-Modellen kann ein Gleichgewicht zwischen Leistung und Transparenz liefern. Beispielsweise kann es sowohl Genauigkeit als auch Interpretierbarkeit ermöglichen, wenn sie einfachere Modelle für die Entscheidungsfindung bei gleichmäßigeren Vorhersagen auf komplexere Modelle für Vorhersagen ermöglichen.

- Datenvisualisierung: Eine effektive Datenvisualisierung kann dazu beitragen, AI-Modelle transparenter zu gestalten, indem der Entscheidungsprozess in einem zugänglichen Format angezeigt wird. Interaktive Tools können es Benutzern ermöglichen, AI -Systeme für weitere Erklärungen abzufragen.

Schlussfolgerung: Streben nach Transparenz bei KI-Entscheidungsfindung

Das Black Box -Problem in der KI hat ein erhebliches Hindernis für die breitere Einführung und ethische Umsetzung von AI -Technologien. KI -Tools müssen zwar leistungsstarker, transparenter werden, um sicherzustellen, dass ihre Entscheidungen verständlich, vertrauenswürdig und fair sind. Als

KI -Entwicklung Fortschritte, der Bereich der erklärbaren KI entwickelt sich weiter. Forscher untersuchen innovative Lösungen, um diese Herausforderungen zu bewältigen, und ermöglichen es, die Vorteile von AI -Technologien zu genießen, ohne die Rechenschaftspflicht oder Ethik zu beeinträchtigen.

Soziale Hashtags

#ErklärbareKI #KI-Transparenz #Blackbox-Problem #XKI #VertrauenswürdigeKI #MaschinellesLernen #DeepLearning #KI-Modelle #shap #lime

Möchten Sie KI für Ihr Unternehmen transparenter und vertrauenswürdiger machen?

Häufig gestellte Fragen

Referenzen: Hören Sie es direkt von unseren globalen Kunden

Unsere Entwicklungsprozesse liefern dynamische Lösungen, um geschäftliche Herausforderungen zu meistern, Kosten zu optimieren und die digitale Transformation voranzutreiben. Expertenunterstützte Lösungen stärken die Kundenbindung und die Online-Präsenz, während belegte Erfolgsgeschichten reale Problemlösungen durch innovative Anwendungen hervorheben. Unsere geschätzten Kunden weltweit haben es bereits erlebt.

Auszeichnungen und Anerkennungen

Zufriedene Kunden sind unsere größte Motivation, doch auch Branchenanerkennung hat einen hohen Stellenwert. WeblineIndia ist seit Jahren führend in der Technologie, und Auszeichnungen sowie Ehrungen bestätigen kontinuierlich unsere Exzellenz.

OA500 Globale Outsourcing-Unternehmen 2025, von Outsource Accelerator

Top Softwareentwicklung-Unternehmen, von GoodFirms

Bestes FinTech-Produktlösungsunternehmen – 2022, von GESIA

Ausgezeichnet als – Bestes App-Entwicklungsunternehmen in Indien 2020, von SoftwareSuggest