Lorsque le marché est stimulé par la numérisation, le pouvoir transformateur des grands modèles linguistiques (LLM) est indéniable. De l’automatisation du service client à la génération de code complexe, les LLM promettent une efficacité et une innovation sans précédent. Pourtant, pour de nombreuses grandes entreprises, en particulier celles opérant dans des secteurs hautement réglementés comme la finance, la santé et le gouvernement, la poursuite de l’innovation en matière d’intelligence artificielle (IA) est entravée par un obstacle important et non négociable : la confidentialité et la sécurité des données.

L’architecture par défaut pour le déploiement de LLM sophistiqués implique souvent l’externalisation vers les principaux fournisseurs de cloud public. Bien que pratique, ce modèle signifie intrinsèquement que les données sensibles de l’entreprise, utilisées pour former, affiner et interagir avec ces modèles, doivent quitter les limites sécurisées du réseau interne de l’entreprise. Cette exposition n’est pas seulement un risque ; il s’agit d’une violation directe des mandats réglementaires (comme le RGPD, la HIPAA et diverses lois nationales sur la localisation des données) et des politiques de conformité internes.

C’est là que le concept de LLM sur site apparaît, non seulement comme une alternative, mais comme l’architecture essentielle pour les entreprises déterminées à donner la priorité à la confidentialité et choisissant souvent de embaucher une équipe dédiée pour une mise en œuvre sécurisée de l’IA. Le déploiement de LLM directement sur le matériel interne de l’entreprise est la solution définitive pour atteindre une souveraineté absolue des données, garantissant que les informations propriétaires ne quittent jamais le contrôle physique et numérique de l’organisation.

Prêt à préserver la confidentialité des données de votre entreprise tout en utilisant l’IA ? Parlez à nos experts LLM dès aujourd’hui.

Le grand conflit : innovation contre conformité

L’analyse de rentabilisation de l’IA est claire : avantage concurrentiel, réduction des coûts et prise de décision supérieure. Cependant, le paysage des entreprises est de plus en plus défini par une gouvernance stricte des données.

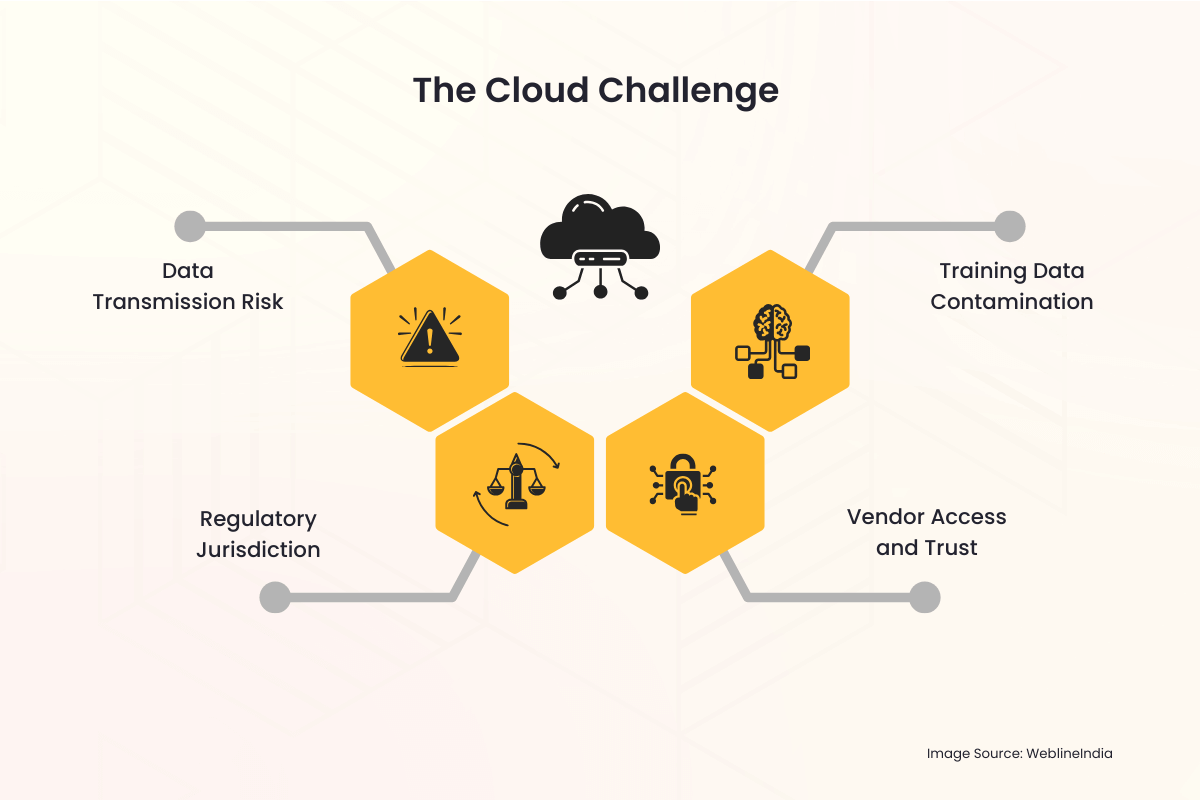

Le défi du cloud

Lorsqu’une entreprise utilise un service LLM hébergé dans le cloud, plusieurs pièges en matière de confidentialité apparaissent immédiatement :

- Risque de transmission de données : Chaque requête, chaque entrée et la sortie qui en résulte doivent traverser l’Internet public et résider temporairement sur un serveur tiers. L’ensemble de ce processus est un vecteur potentiel d’interception ou d’accès non autorisé.

- Juridiction réglementaire : Les données stockées dans un pays ou une juridiction autre que celui d’origine de l’entreprise peuvent déclencher des lois internationales complexes, souvent contradictoires. Réaliser la localisation des données (l’exigence que les données soient stockées et traitées au sein de frontières spécifiques) devient pratiquement impossible avec un fournisseur de cloud multinational.

- Accès et confiance des fournisseurs : Les entreprises sont obligées de faire confiance aux protocoles de sécurité, aux contrôles d’accès des employés et aux politiques de rétention des fournisseurs de cloud. Cela introduit un tiers dans les flux de travail de données les plus sensibles.

- Contamination des données de formation : Si les données propriétaires d’une entreprise sont utilisées pour affiner un modèle hébergé dans le cloud, il existe toujours un risque que les pondérations du modèle soient partagées par inadvertance, voire par malveillance, ou influencent les réponses des modèles utilisés par d’autres locataires, entraînant une fuite de données.

Ces préoccupations ne sont pas théoriques. Les incidents très médiatisés de violations de données et les sanctions sévères imposées par les organismes de réglementation mondiaux ont fait passer la confidentialité des données d’un casse-tête informatique à une priorité essentielle des conseils d’administration. Pour les organisations gérant des informations personnelles identifiables (PII), des informations de santé protégées (PHI) ou des propriétés intellectuelles classifiées (IP), le profil de risque des LLM du cloud public est souvent tout simplement trop élevé pour être accepté.

La solution sur site : reconquérir le contrôle et la souveraineté

Le modèle de déploiement LLM sur site répond et résout directement ces profonds problèmes de confidentialité en plaçant l’ensemble de l’infrastructure d’IA (le matériel, les logiciels, les pondérations des modèles et les données de formation) sous le contrôle physique et numérique direct et exclusif de l’entreprise.

1. Souveraineté absolue des données

La souveraineté des données signifie que les données sont soumises uniquement aux lois et aux règles de gouvernance du pays ou de l’organisation où elles sont collectées et stockées.

- Contrôle géographique : Avec une configuration sur site, le matériel est physiquement situé dans le centre de données de l’entreprise, souvent dans un pays spécifique ou même dans une salle sécurisée spécifique. Cela satisfait intrinsèquement aux exigences de résidence et de localisation des données, facilitant ainsi la conformité aux réglementations telles que le RGPD de l’UE ou diverses lois sur la sécurité nationale.

- Zéro transmission externe : Tous les traitements de données, la formation du modèle et l’inférence (interrogation du modèle) se déroulent dans le pare-feu de l’entreprise. Les invites sensibles et les documents internes propriétaires utilisés par le LLM ne quittent jamais l’environnement réseau sécurisé.

2. Sécurité et conformité améliorées

Un déploiement sur site permet à l’équipe de sécurité d’appliquer le cadre de sécurité robuste existant de l’organisation directement au système d’IA.

- Infrastructure de sécurité existante : La solution LLM peut être intégrée de manière transparente aux outils de sécurité d’entreprise établis, notamment les systèmes de détection d’intrusion (IDS), les pare-feu sophistiqués, les solutions de gestion des identités et des accès (IAM) et les systèmes de prévention des pertes de données (DLP). Celle-ci est souvent plus complète et adaptée que les couches de sécurité proposées par un service cloud générique.

- Contrôle d’accès personnalisé : L’accès au modèle lui-même peut être strictement contrôlé via Active Directory interne de l’entreprise ou d’autres solutions IAM d’entreprise. Seuls les employés, services ou applications autorisés peuvent interagir avec le modèle, et les journaux d’accès sont conservés en interne à des fins d’audit.

- Audit simplifié : La conformité réglementaire nécessite souvent des pistes d’audit détaillées. Posséder l’intégralité de la pile permet à l’entreprise de conserver des journaux détaillés de chaque utilisation de modèle, tâche de formation et action administrative, ce qui facilite grandement les contrôles de conformité pour les auditeurs internes et externes.

3. Protection de la propriété intellectuelle

Pour les entreprises, la véritable valeur d’un LLM ne réside pas seulement dans le modèle fondateur (comme Llama, Mistral ou autres) mais dans les connaissances exclusives utilisées pour l’affiner. Ces données de réglage fin constituent l’adresse IP de l’organisation.

- Environnement de formation isolé : Lorsque le réglage fin est effectué sur site, les ensembles de données propriétaires (tels que les dossiers clients, les rapports internes, les dépôts de brevet ou les spécifications du produit) ne sont jamais téléchargés vers un tiers. Les pondérations de modèle affinées qui en résultent, qui codent efficacement les connaissances de l’entreprise, sont également conservées en interne, empêchant toute partie externe d’obtenir un accès non autorisé à la propriété intellectuelle principale.

Besoin d’un LLM conforme et sur site, adapté à votre secteur ? Construisons-le en toute sécurité.

Les aspects pratiques de l’architecture LLM sur site

Même si les avantages en matière de confidentialité sont convaincants, le déploiement d’un LLM sur site nécessite une planification minutieuse et un investissement dans la technologie sous-jacente.

Le défi matériel : le besoin de GPU

Les LLM sont exigeants en termes de calcul. Le principal facteur de déploiement efficace sur site est le matériel spécialisé, principalement les GPU (Graphics Processing Units).

- Pouvoir d’inférence : Pour répondre aux requêtes des utilisateurs en temps réel (inférence), le LLM nécessite une mémoire à haute vitesse et une puissance de traitement parallèle fournie par des GPU, souvent dans des racks de serveurs dédiés.

- Formation et mise au point : Former un modèle à partir de zéro est une entreprise colossale, mais le réglage fin (adaptation d’un modèle existant) est réalisable sur moins de GPU puissants. L’investissement dans ce matériel constitue une dépense en capital (CapEx) qui remplace les dépenses opérationnelles continues (OpEx) liées aux frais de service cloud, offrant ainsi une prévisibilité des coûts à long terme.

La pile logicielle

La solution complète sur site implique bien plus que du matériel ; cela nécessite une couche logicielle et d’orchestration robuste :

- Sélection du modèle : Choisir un LLM de base open source et commercialement viable (comme Llama 3, Mistral, etc.) qui peut être légalement téléchargé et déployé sur une infrastructure privée est la première étape.

- Conteneurisation (par exemple, Docker/Kubernetes) : Pour gérer le déploiement complexe, le LLM et ses dépendances sont souvent regroupés dans des conteneurs. Les outils d’orchestration tels que Kubernetes gèrent le cluster de serveurs GPU, garantissant l’évolutivité et la haute disponibilité, un peu comme un environnement de cloud privé, souvent mis en œuvre par des entreprises qui Embaucher des ingénieurs Cloud et DevOps pour gérer une infrastructure d’IA aussi complexe.

- Couche API interne : Une interface de programmation d’application (API) est intégrée au pare-feu, permettant aux applications internes (chatbots, assistants de codage, analystes de données) d’envoyer des invites au LLM sans jamais toucher l’Internet public.

Surmonter la latence des données et la gouvernance

Les solutions sur site éliminent la latence des données et améliorent la gouvernance des sources de données internes.

- Accès aux données internes en temps réel : Les LLM doivent souvent accéder aux données internes les plus récentes, un processus appelé Retrieval-Augmented Generation (RAG). En étant sur site, le LLM dispose d’un accès à faible latence et à large bande passante aux bases de données internes, aux lacs de données et aux référentiels de documents, conduisant à des résultats plus précis, contextuels et opportuns sans avoir besoin de transfert de données sur Internet.

- Gouvernance unifiée : L’équipe de gouvernance des données peut appliquer un ensemble unique de règles aux données, à l’index RAG et au LLM lui-même, créant ainsi un environnement de conformité unifié et plus simple.

Avantages stratégiques pour les industries soucieuses de la confidentialité

Le passage à une architecture sur site est une décision stratégique qui témoigne d’un engagement fort en faveur du respect de la réglementation et de la confiance des clients.

| Industrie | Principale préoccupation en matière de confidentialité | Avantage de la solution sur site |

| Santé (HIPAA) | Protection des PHI et des dossiers des patients. | S’assure que PHI reste dans un environnement sécurisé et dédié ; simplifie les journaux d’audit requis pour la conformité. |

| Services financiers (RGPD, PCI-DSS) | PII client, données de transaction, IP algorithmique. | Garantit la résidence et la localisation des données ; protège les algorithmes de trading exclusifs et les modèles de notation des clients contre toute exposition externe. |

| Gouvernement / Défense | Informations classifiées, hautement sensibles ou secrètes d’État. | Permet un déploiement dans des environnements isolés (réseaux physiquement isolés d’Internet), garantissant une sécurité absolue. |

| Fabrication / R&D | Propriété intellectuelle (PI), conceptions exclusives et secrets commerciaux. | Empêche la fuite de processus de fabrication uniques ou de détails de conception de produits utilisés lors du RAG ou du réglage fin. |

Combler le fossé avec des services informatiques professionnels

La décision de passer à une architecture LLM sur site, bien que stratégiquement judicieuse en termes de confidentialité, introduit une complexité opérationnelle importante. Cela nécessite des compétences spécialisées dans l’approvisionnement en matériel (en particulier les GPU hautes performances), la mise en place d’un environnement conteneurisé robuste (comme Kubernetes), le réglage fin des modèles sur les données sensibles et l’intégration du LLM aux systèmes d’entreprise existants. C’est là qu’un partenaire de services informatiques de confiance devient inestimable.

WeblineIndia est une agence informatique renommée aux États-Unis, spécialisée dans la fourniture de l’expertise complète nécessaire pour gérer cette transition en toute transparence. Ils offrent des services professionnels de bout en bout, depuis la conception de la pile matérielle sur site optimale adaptée à vos besoins d’inférence et de formation, jusqu’à la gestion du déploiement sécurisé de LLM open source au sein de votre pare-feu.

Les experts cloud du centre de développement de WeblineIndia en Inde possèdent une expérience approfondie de l’infrastructure cloud sécurisée et de la mise en œuvre de l’IA. Les entreprises peuvent déployer rapidement leur environnement LLM privé, garantissant le strict respect des politiques de conformité internes et accélérant le délai de rentabilisation sans avoir besoin d’embaucher et de former des équipes d’ingénierie IA internes spécialisées et coûteuses, en tirant parti de développeurs distants expérimentés. Ce partenariat transforme un projet d’infrastructure ambitieux en une initiative gérable et exécutée de manière stratégique, entièrement dédiée au maintien de votre souveraineté absolue en matière de données.

L’avenir est privé et sécurisé avec WeblineIndia

L’engouement suscité par les LLM ne doit pas éclipser la responsabilité fondamentale des entreprises de protéger les données sensibles qui leur sont confiées. Pour toute grande organisation où la conformité, la confidentialité et la souveraineté des données ne sont pas négociables (c’est-à-dire la plupart des entreprises qui réussissent aujourd’hui), le modèle LLM du cloud public constitue une inadéquation fondamentale.

Le passage au déploiement LLM sur site représente une voie à suivre claire. C’est l’investissement nécessaire en matériel et en expertise qui comble les lacunes en matière de sécurité, satisfait aux exigences réglementaires mondiales les plus strictes et permet finalement à l’entreprise d’exploiter tout le potentiel de transformation de l’intelligence artificielle sans jamais compromettre son atout le plus précieux : ses données.

Contacter WeblineIndia Des services de conseil informatique pour échapper aux risques inhérents au cloud et reprendre le contrôle de leur pile d’IA pour innover avec audace. Vous pouvez garantir que la confiance des clients, la conformité et la propriété intellectuelle soient absolument sécurisées au sein de leur propre domaine souverain.

Hashtags sociaux

#LLMsurSite #SouverainetéDesDonnées #IApourEntreprises #ConformitéIA #ConfidentialitéAvantTout #IASécurisée #SécuritéDesLLM #TechnologiePourEntreprises

Vous voulez un contrôle total sur votre pile d’IA sans risque lié aux données ? Commencez par WeblineIndia.

Foire aux questions

Témoignages : écoutez-le directement de nos clients à travers le monde

Nos processus de développement fournissent des solutions dynamiques pour relever les défis métiers, optimiser les coûts et accélérer la transformation numérique. Des solutions appuyées par des experts renforcent la fidélisation et la présence en ligne, tandis que des succès avérés mettent en avant la résolution de problèmes concrets grâce à des applications innovantes. Nos clients estimés à travers le monde l’ont déjà constaté.

Prix et Reconnaissances

Bien que les clients satisfaits soient notre plus grande motivation, la reconnaissance de l'industrie a une valeur significative. WeblineIndia a constamment été un leader en technologie, avec des prix et des distinctions réaffirmant notre excellence.

OA500 Entreprises mondiales d’externalisation 2025, par Outsource Accelerator

Meilleure entreprise de développement logiciel, par GoodFirms

Meilleure entreprise de solutions fintech – 2022, par GESIA

Récompensée comme – Meilleure entreprise de développement d’apps en Inde 2020, par SoftwareSuggest