La montée des outils d’intelligence artificielle (IA) a révolutionné les industries, améliorant l’efficacité et l’automatisation. Cependant, l’un des défis les plus persistants de la recherche et du développement de l’IA est le problème de la boîte noire dans l’IA. Ce problème implique des décisions de prise de systèmes d’IA sans fournir des explications transparentes à ces décisions. Comprendre comment ce problème a un impact sur le développement des technologies d’IA et les solutions potentielles disponibles est crucial pour établir la confiance dans l’IA et ses applications.

Confus à propos de la prise de décision de l’IA? Laissez nos experts vous aider à mettre en œuvre l’IA explicable!

Le problème de la boîte noire dans l’IA: un aperçu

À la base, la boîte noire dans l’IA fait référence à l’opacité des processus de prise de décision dans de nombreux modèles d’apprentissage automatique, en particulier des modèles d’apprentissage en profondeur. Ces modèles peuvent produire des résultats précis, mais leur fonctionnement interne est souvent trop complexe pour interpréter. Le problème de la boîte noire dans l’IA devient particulièrement problématique dans les domaines à enjeux élevés comme les soins de santé, la finance et les forces de l’ordre, où comprendre pourquoi une décision a été prise est essentielle.

- Les outils d’IA tels que les réseaux de neurones profonds excellent à la reconnaissance des modèles, mais sont souvent trop alambiqués pour que les humains comprennent pleinement.

- La complexité survient parce que ces modèles impliquent plusieurs couches de calculs et de transformations, ce qui rend difficile de tracer comment les données d’entrée se transforment en décisions de sortie.

L’impact du problème de la boîte noire dans l’IA

Le manque de transparence dans la prise de décision crée des défis de plusieurs façons:

- Responsabilité: Dans les cas où les systèmes d’IA prennent des décisions erronées ou nuisibles, il est difficile de déterminer la cause exacte du problème, ce qui complique la responsabilité et la confiance.

- Biais: Sans un aperçu du fonctionnement des systèmes d’IA, il devient plus difficile d’identifier et de corriger tout biais dans le processus de prise de décision du modèle.

- Préoccupations réglementaires: Alors que l’IA continue d’évoluer, les régulateurs sont confrontés à des défis pour s’assurer que ces technologies sont conformes aux normes et lois éthiques. Le manque d’interprétabilité entrave la réglementation.

Comprendre la nécessité d’une IA explicable

Pour atténuer le problème de la boîte noire dans l’IA, les chercheurs se tournent vers une IA explicable (XAI). AI explicable vise à fournir une explication claire et compréhensible de la façon dont les systèmes d’IA arrivent à leurs décisions. Ceci est crucial pour favoriser la confiance, assurer l’équité et maintenir la responsabilité.

Vous êtes aux prises avec la transparence de l’IA? Obtenez des solutions AI claires et responsables.

Comment l’IA explicable aide

- Transparence: avec une IA explicable, les utilisateurs peuvent accéder à des informations sur la façon dont les systèmes AI traitent les données et font des prédictions.

- Confiance et adoption: Comme les parties prenantes peuvent comprendre la prise de décision de l’IA, ils sont plus susceptibles de faire confiance aux outils d’IA pour les applications critiques.

- Décisions éthiques: L’IA explicable favorise la prise de décision éthique en révélant des biais ou des modèles discriminatoires dans les systèmes d’IA.

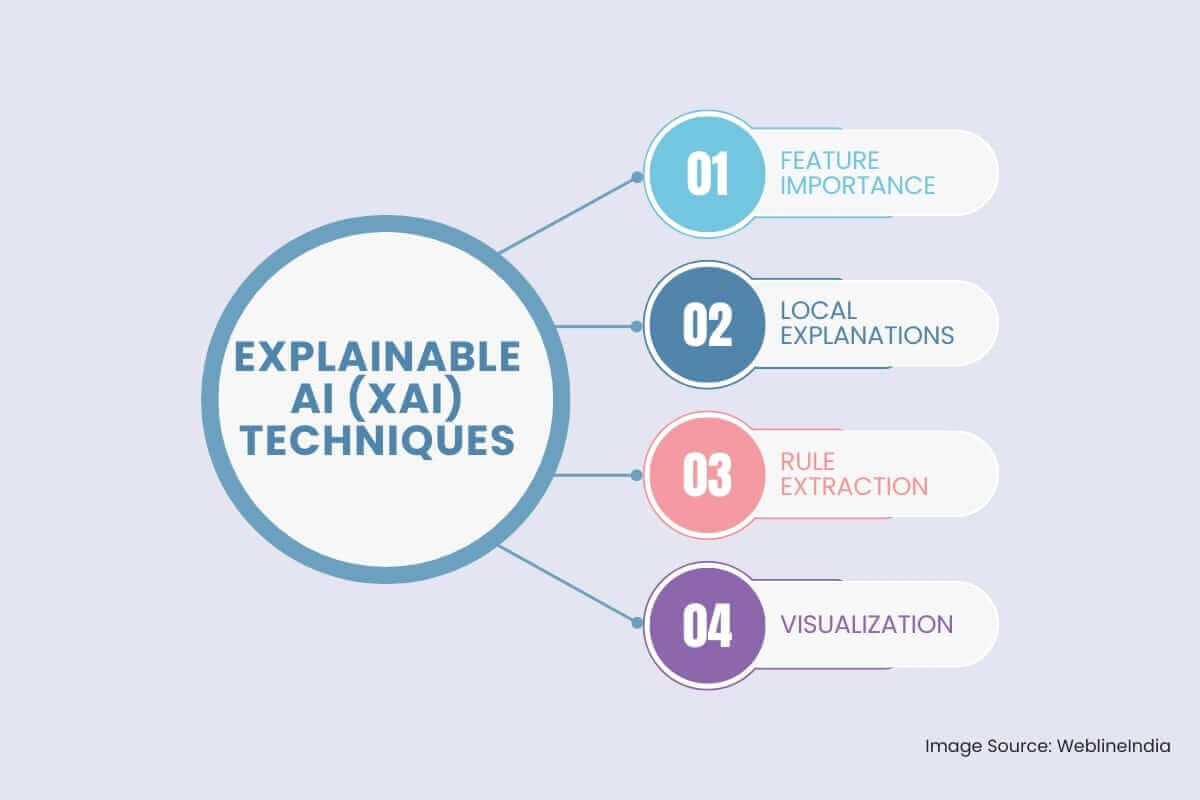

Techniques d’IA explicable (XAI)

Pour résoudre le problème de la boîte noire, le domaine de l’IA explicable (XAI) a émergé. XAI se concentre sur le développement de techniques qui rendent les processus décisionnels des modèles d’IA plus transparents et compréhensibles. Certaines techniques clés XAI comprennent:

- Importance des fonctionnalités: Cette technique vise à identifier les caractéristiques d’entrée qui ont la plus grande influence sur la sortie du modèle.

Importance de la permutation: Cette méthode évalue l’importance d’une caractéristique en mélangeant de manière aléatoire ses valeurs et en observant comment cela affecte les performances du modèle.

Shap (Explications additives de Shapley): Cette approche basée sur la théorie des jeux fournit une compréhension plus nuancée de l’importance des caractéristiques en attribuant la sortie du modèle aux fonctionnalités individuelles.

- Explications locales: Ces méthodes fournissent des explications pour les prédictions individuelles faites par le modèle.

Chaux (explications locales sur le modèle interprétable): Cette technique se rapproche localement du comportement du modèle autour d’un point de données spécifique en utilisant un modèle plus simple et plus interprétable, comme un modèle linéaire ou un arbre de décision.

Ancre: Cette méthode identifie un ensemble de conditions (ancres) qui, si elles sont présentes, garantissent une prédiction spécifique avec une forte probabilité.

- Extraction des règles: Cette approche consiste à extraire des règles lisibles par l’homme du modèle formé.

Induction de l’arbre de décision: Cette technique consiste à construire un arbre de décision, qui peut être facilement interprété par les humains, pour approximer les prédictions du modèle.

Systèmes basés sur des règles: ces systèmes représentent explicitement les connaissances du modèle sous la forme de règles if-alors.

- Visualisation: La visualisation du fonctionnement interne d’un modèle d’IA peut fournir des informations précieuses sur son processus décisionnel.

Cartes d’activation: ces visualisations mettent en évidence les domaines d’une image sur lesquels le modèle se concentre lors de la prédiction.

Mécanismes d’attention: ces techniques peuvent être utilisées pour visualiser les parties d’un texte ou d’une séquence auquel le modèle fait attention lors de la prédiction.

Surmonter les défis dans le développement de l’IA explicable

Bien que l’IA explicable offre une solution prometteuse, la mise en œuvre efficacement est livrée avec son propre ensemble de défis:

- Le compromis entre précision et explicabilité: certains des outils d’IA les plus puissants, comme les réseaux de neurones profonds, peuvent offrir une grande précision mais au prix d’être plus difficile à expliquer. L’équilibrage de ces deux facteurs reste un défi important.

- Complexité des modèles: de nombreuses technologies d’IA reposent sur des algorithmes avancés qui sont intrinsèquement difficiles à expliquer. La recherche continue d’explorer comment rendre ces modèles complexes interprétables sans sacrifier leurs performances.

- Évolutivité: Comme les outils d’IA sont déployés à plus grande échelle, le maintien d’explications efficaces pour chaque décision prise par le système peut devenir écrasante.

Le rôle des technologies de l’IA dans la résolution du problème de la boîte noire

Technologies d’IA évoluent constamment pour créer des systèmes plus transparents et interprétables. Du développement de meilleurs algorithmes à l’amélioration des techniques de visualisation des données, ces technologies ouvrent la voie aux solutions au problème de la boîte noire dans l’IA.

- Modèles hybrides: La combinaison de modèles explicables et noirs pourrait fournir un équilibre entre les performances et la transparence. Par exemple, l’utilisation de modèles plus simples pour la prise de décision tout en s’appuyant sur des modèles plus complexes pour les prédictions pourrait permettre à la fois la précision et l’interprétabilité.

- Visualisation des données: une visualisation efficace des données peut aider à rendre les modèles d’IA plus transparents en montrant le processus décisionnel dans un format accessible. Les outils interactifs peuvent permettre aux utilisateurs d’interroger les systèmes d’IA pour d’autres explications.

Conclusion: rechercher la transparence dans la prise de décision de l’IA

Le problème de la boîte noire dans l’IA présente un obstacle important à l’adoption plus large et à la mise en œuvre éthique des technologies d’IA. Bien que puissants, les outils d’IA doivent devenir plus transparents pour garantir que leurs décisions sont compréhensibles, dignes de confiance et juste. Comme Développement d’IA progresse, le domaine de l’IA explicable continue d’évoluer, les chercheurs explorent des solutions innovantes pour surmonter ces défis, ce qui permet de profiter des avantages des technologies de l’IA sans compromettre la responsabilité ou l’éthique.

Hashtags sociaux

#IAExplicable #TransparenceIA #ProblèmeDeBoîteNoire #IAX #ConfianceEnMoi #ApprentissageMachine #ApprentissageProfond #ModèlesIA

#Forme #LIME

Vous voulez rendre l’IA plus transparent et digne de confiance pour votre entreprise?

Questions fréquemment posées

Témoignages : écoutez-le directement de nos clients à travers le monde

Nos processus de développement fournissent des solutions dynamiques pour relever les défis métiers, optimiser les coûts et accélérer la transformation numérique. Des solutions appuyées par des experts renforcent la fidélisation et la présence en ligne, tandis que des succès avérés mettent en avant la résolution de problèmes concrets grâce à des applications innovantes. Nos clients estimés à travers le monde l’ont déjà constaté.

Prix et Reconnaissances

Bien que les clients satisfaits soient notre plus grande motivation, la reconnaissance de l'industrie a une valeur significative. WeblineIndia a constamment été un leader en technologie, avec des prix et des distinctions réaffirmant notre excellence.

OA500 Entreprises mondiales d’externalisation 2025, par Outsource Accelerator

Meilleure entreprise de développement logiciel, par GoodFirms

Meilleure entreprise de solutions fintech – 2022, par GESIA

Récompensée comme – Meilleure entreprise de développement d’apps en Inde 2020, par SoftwareSuggest