Le app di monitoraggio del fitness si sono evolute ben oltre semplici contatori di gradini o registri di attività basati su GPS. Gli utenti di oggi si aspettano una ricca interattività sociale, gamification competitiva, sincronizzazione dei dati in tempo reale e integrazione senza soluzione di continuità con un crescente ecosistema di dispositivi indossabili e piattaforme sanitarie. Strava ha fissato un punto di riferimento in questo spazio fondendo il monitoraggio delle attività atletiche con l’impegno sociale – classifiche, sfide, commenti, club e persino razze virtuali – tutte avvolte in una slick UX che dà la priorità sia alle prestazioni che alla comunità.

La progettazione di un sistema come questo va ben oltre le operazioni di Crud di base sugli allenamenti degli utenti. Richiede un’architettura robusta in grado di gestire:

- Aggiornamenti di geo-location ad alta frequenza da milioni di utenti simultanei

- Generazione di mangimi in tempo reale e trasmissione di attività su reti follower

- Query scalabili e a bassa latenza

- Archiviazione e recupero dei media (ad es. Mappe, foto, badge)

- Pipeline di dati basate sugli eventi per segmenti di calcolo, classifiche e sfide

- Controlli di sicurezza e privacy attraverso complesse preferenze di condivisione dei dati

La sfida è architettare un backend che supporti un’esperienza rapida, coinvolgente e socialmente ricca, pur rimanendo abbastanza flessibile da integrarsi con dispositivi di fitness di terze parti, supportare la moderazione della comunità ed evolvere nuove funzionalità senza rompere quelle vecchie.

Questa immersione profonda tecnica suddivide l’architettura di tale sistema. Descrive i requisiti fondamentali, i progetti per la scalabilità e la reattività in tempo reale, i modelli di dati per i contenuti generati dagli utenti e i modelli di infrastrutture per supportare una piattaforma di fitness sociale che può crescere a milioni di utenti senza degradare le prestazioni o l’affidabilità.

Requisiti di sistema

1. Requisiti funzionali

Le funzionalità fondamentali dell’app di fitness devono supportare sia il monitoraggio delle attività che l’impegno sociale su vasta scala. I requisiti funzionali chiave includono:

- Gestione degli utenti: Iscrizione, autenticazione, modifica del profilo e recupero dell’account.

- Registrazione delle attività: Gli allenamenti basati su GPS log (ad es. Run, corse), l’ingresso manuale di supporto e cattura di metadati come distanza, ritmo, elevazione, frequenza cardiaca e attrezzatura utilizzata.

- Sincronizzazione dei dati in tempo reale: Posizione dello streaming e dati del sensore da dispositivi mobili o indossabili con bassa latenza.

- Grafico sociale: Seguire/non seguire i meccanismi, i suggerimenti degli amici e la visibilità delle attività controllate dalla privacy (ad es. Private, solo follower, pubblico).

- Feed di attività: La sequenza temporale dinamica che mostra gli allenamenti degli utenti seguiti, inclusi Mi piace, commenti e ricostruzioni.

- Sfide e classifiche: Crea competizioni in scatola a tempo (ad esempio, “cavalca 100 km in 7 giorni”), classifiche per segmenti di binario e classifiche di calcolo in modo asincrono.

- Supporto mediatico: Carica e visualizza foto, percorsi le mappe di calore e risultati personali (ad es. Badge, pietre miliari).

- Notifiche: Notifiche push e in-app in tempo reale per Mi piace, commenti, nuovi follower e aggiornamenti di sfida.

- Integrazione di terze parti: Sincronizzare con Apple Health, Google Fit, Garmin e altri ecosistemi di fitness.

2. Requisiti non funzionali

Per supportare l’interazione in tempo reale e le basi in crescita degli utenti, il sistema deve soddisfare severi requisiti non funzionali:

- Scalabilità: Servizi e negozi di dati scalabili orizzontalmente per gestire milioni di utenti attivi e terabyte di dati geo-temporali.

- Latenza bassa: Tempo di risposta secondario per le interazioni sociali e il rendering delle mappe in tempo reale.

- Disponibilità: 99,9%+ tempo di up -time con tolleranza ai guasti tra regioni e zone.

- Sicurezza e privacy: Autenticazione basata su OAUTH2, controllo degli accesso granulari, archiviazione crittografata e impostazioni di condivisione controllate dall’utente.

- Estensibilità: Confini di servizi modulari per supportare funzionalità future come gare virtuali, chat con sede a club o coaching dal vivo.

- Coerenza dei dati: L’eventuale coerenza è accettabile nei feed e nelle classifiche, ma è necessaria una forte coerenza per transazioni come impostazioni di conto o acquisti premium.

- Supporto offline: Consenti agli utenti di registrare e mettere in coda attività quando offline, con sincronizzazione automatica al momento della riconnessione.

3. Vincoli e ipotesi

- Le app mobili (iOS e Android) saranno i client principali; L’interfaccia web è secondaria.

- I dati sulla posizione e sulla salute devono essere elaborati ai sensi delle normative di conformità regionale (ad es. GDPR, HIPAA ove applicabile).

- La maggior parte degli utenti sincronizzerà 1-2 attività al giorno, ma gli utenti e le integrazioni di alimentazione possono aumentare i tassi di ingestione durante gli eventi o i periodi di sfida.

- Implementazione nativa cloud; L’architettura presuppone l’uso di servizi cloud gestiti per calcolo, archiviazione e streaming.

Usa caso / scenario

1. Contesto aziendale

L’app di fitness si rivolge a un ampio demografico – dai camminatori occasionali ai ciclisti competitivi – ma sottolinea il coinvolgimento della comunità sul monitoraggio individuale. Pensalo come un ibrido tra un personal trainer e un social network. L’obiettivo è quello di guidare l’utilizzo ricorrente attraverso la concorrenza, la responsabilità sociale e i progressi gamificati, aumentando in definitiva la fidelizzazione e la conversione dell’abbonamento.

La monetizzazione in-app può includere:

- Abbonamenti premium per analisi avanzate, segmenti dal vivo e approfondimenti di formazione più profondi

- Sfide con marchio o competizioni sponsorizzate

- Promozione in ingranaggio in-app (ad es. Marketplace affiliato per scarpe, bici, dispositivi indossabili)

L’app deve pertanto consentire una solida base per le metriche di prestazioni in tempo reale, offrendo anche esperienze coinvolgenti e socialmente dinamiche che gli utenti tornano ogni giorno, anche se non si stanno allenando quel giorno.

2. Personas e modelli di utilizzo

- Atleti solisti: Gli utenti che seguono i loro allenamenti, confrontano le prestazioni passate e occasionalmente si uniscono a sfide o segmenti globali.

- Appassionati sociali: Utenti altamente coinvolti che pubblicano frequentemente, commentano le attività degli amici e prosperano sull’interazione della comunità.

- Manager di club: Power utenti che coordinano eventi di gruppo, gestiscono classifiche private e spazi sociali moderati all’interno dei club.

- Nerd di dati: Abbonati premium interessati a zone di cuore, curve di alimentazione, metriche di recupero ed esportazione di dati.

3. Scala prevista

Il sistema dovrebbe essere progettato per supportare:

- 10m+ utenti registrati

- 2–3 m maus (utenti attivi mensili), con ~ 500k DAU (utenti attivi giornalieri)

- 10 m+ carichi di attività al mese, con picchi durante i fine settimana e importanti eventi di sfida

- 500k+ utenti simultanei durante i periodi di punta

- Miliardi di punti dati al mese attraverso sensori GPS, elevazione, frequenza cardiaca e moto

- Milioni di query di mangime giornaliere, interazioni sociali e notifiche in tempo reale

Per soddisfare queste richieste, l’architettura deve ottimizzare per i carichi di assistenza sociale pesanti, inghiottire il traffico di carichi di attività e l’elaborazione asincrona ad alto rendimento per l’abbinamento e gli aggiornamenti della classifica.

Hai bisogno di aiuto per la progettazione della propria app di fitness o social?

Costruire una piattaforma di fitness social-first che si ridimensiona a milioni di utenti richiede più che un codice pulito: richiede l’architettura giusta dal primo giorno.

Vuoi una guida di esperti sulla progettazione per prestazioni, sincronizzazione in tempo reale e coinvolgimento degli utenti su larga scala?

Architettura di alto livello

L’architettura deve supportare in modo efficiente l’ingestione di attività in tempo reale, la distribuzione dei mangimi sociali, l’analisi geospaziale e l’interazione dell’utente, il tutto su vasta scala. Ciò richiede un approccio modulare orientato ai servizi con confini ben definiti tra sistemi di base come il monitoraggio delle attività, la gestione degli utenti, l’elaborazione dei grafici sociali e la consegna delle notifiche.

1. Panoramica del componente

Il sistema è strutturato attorno ai seguenti componenti principali:

- API Gateway: Punto di ingresso centrale per tutte le comunicazioni clienti. Gestisce l’autenticazione, la limitazione della tariffa e percorre il traffico verso i servizi interni.

- Servizio di auth: Gestisce flussi OAuth2, emissione di token, gestione delle sessioni e integrazione con fornitori di identità di terze parti (ad esempio Apple, Google).

- Servizio del profilo utente: Memorizza le impostazioni personali, le preferenze, gli attrezzi e la privacy.

- Servizio di attività: Gestisce l’ingestione di allenamento basata su GPS, l’analisi del percorso, la validazione dell’attività ed estrazione dei metadati (ad es. PACE, guadagno di elevazione).

- Servizio di feed: Genera e memorizza i feed di attività, elabora gli aggiornamenti del grafico sociale e gestisce Fan-Out per nuovi post di attività.

- Servizio del grafico sociale: Gestisce le relazioni follower e calcola la visibilità per attività e sfide.

- Motore di sfida e classifica: Calcola le classifiche, gestisce la logica della sfida e aggiorna trofei e segmenti virtuali.

- Servizio multimediale: Gestisce i caricamenti di immagini (foto, mappe di percorso), la memorizzazione nella cache della CDN e il controllo degli accessi.

- Servizio di notifica: Pubblica notifiche in tempo reale e batch tramite WebSockets, FCM/APNS o Inbox in-APP.

- Pipeline di analisi: Elabora flussi di attività per approfondimenti, rilevamento delle tendenze e raccomandazioni per atleti.

- Portale di amministrazione e moderazione: Strumenti per la gestione dei rapporti di abuso, della creazione di sfida e dei dashboard di analisi.

2. Diagramma di architettura di alto livello

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Riepilogo del flusso di dati

Quando un utente inizia un allenamento:

- L’app mobile trasmette i dati GPS e sensore tramite un WebSocket o un caricamento API in batch su Servizio di attività.

- Il servizio analizza i dati, memorizza l’allenamento ed emette un evento al Generatore di alimentazione.

- IL Servizio di grafico sociale determina chi può vedere l’attività.

- L’articolo di feed viene archiviato e spinto agli utenti pertinenti tramite il Servizio di notifica.

- Se applicabile, l’attività viene valutata dal Motore di classifica per l’ammissibilità alla sfida e gli aggiornamenti di classifica.

- Foto e visualizzazioni di percorso vengono inviate al Servizio multimediale e memorizzato nella cache attraverso una CDN.

Questo design modulare supporta sia la scala orizzontale che l’evoluzione del servizio isolata. Consente inoltre la ventola in tempo reale per feed e notifiche utilizzando la comunicazione basata su eventi (ad es. Kafka o NATS).

Progettazione del database

1. Modelli di dati core e panoramica ERD

Il sistema utilizza un approccio di persistenza poliglotta: database relazionali per l’integrità transazionale, serie temporale/NOSQL per i dati di attività e negozi grafici o in memoria per query sociali ad alte prestazioni.

Entità primarie:

- Utente: Informazioni del profilo, impostazioni di autori, preferenze, livello di abbonamento

- Attività: Dati di allenamento tra cui punti GPS, metriche, attrezzatura, media

- Seguire: Regolamento di relazione e visibilità che seguono i follower

- Feeditem: Eventi rendering legati agli utenti (ad es. Attività pubblicata, commento, badge)

- Sfida: Metadati e stato per le competizioni di gruppo

- Leaderboardentry: Sfida o posizione del segmento e metriche

Diagramma delle relazioni di entità (concettuale):

[Utente]

├── id (PK)

├── nome, email, avatar_url

└── settings_json

[Attività]

├── id (PK)

├── user_id (FK → Utente)

├── tipo, ora_inizio, durata

├── distanza, altitudine, media_ora

├── geo_data_ref (FK → GeoStore)

└── visibilità (pubblica / follower / privata)

[GeoStore] (indice di archiviazione esterna o riferimento S3)

├── id (PK)

├── activity_id (FK → Attività)

└── gps_data (array o puntatore a file)

[Segui]

├── follower_id (FK → Utente)

├── followee_id (FK → Utente)

└── created_at

[FeedItem]

├── id (PK)

├── actor_id (FK → Utente)

├── verb ("pubblicato", "commentato", "mi piace")

├── object_id (ad es. activity_id, comment_id)

└── target_user_id (FK → Utente)

[Sfida]

├── id (PK)

├── nome, descrizione, tipo

├── data_inizio, data_fine

└── visibilità, rule_json

[LeaderboardEntry]

├── id (PK)

├── challenge_id (FK → Sfida)

├── user_id (FK → Utente)

├── metric_value (distanza, durata)

└── posizione

2. Scelte tecnologiche del database

Ogni dominio di dati è ottimizzato per il proprio modello di accesso:

- PostgreSQL: Origine dei dati canonici per profili utente, attività, metadati di alimentazione e sfide. Eccellente per l’integrità transazionale e l’applicazione della chiave estera.

- Timescaledb / afflusso: Per ingestione GPS, telemetria di attività e analisi delle serie temporali (ad es. Pace nel tempo, zone delle risorse umane).

- S3 + CD: Utilizzato per la memorizzazione di tracce GPS RAW, immagini di rotta e supporti caricati (con accesso URL pre-firmato sicuro).

- Redis / Memcached: Per un rapido recupero di classifiche, attività recenti e dati di mangime precompitati.

- Neo4j o dGraph (opzionale): Per il complesso attraversamento del grafico sociale, l’appartenenza al club e i suggerimenti reciproci di follower su vasta scala.

3. Strategia multi-tenancy e partizionamento

- Sharding: Le attività e gli elementi di alimentazione sono ridotti dall’ID utente o dall’ID regione per consentire il ridimensionamento orizzontale tra le partizioni.

- Partizionamento basato sul tempo: La telemetria GPS e le classifiche sono divise in partizioni mensili/settimanali per l’invecchiamento e le prestazioni.

- Multinancy morbida: I club o le organizzazioni (ad es. Gruppi in esecuzione, team ciclistici) operano all’interno dello spazio dei nomi globali ma possono ottenere domande con ambito (tramite Tenant_ID) quando necessario.

4. Replica e alta disponibilità

- PostgreSQL: Distribuito con repliche di standby hot e wal spedizione per il failover.

- Redis: Configurato con Sentinel per alta disponibilità e elezione principale automatizzata.

- Media & Geostore:L’archiviazione degli oggetti viene replicata tra le regioni e consegnata attraverso una CDN globale per l’accesso a bassa latenza.

Questo design del database garantisce l’evoluzione flessibile dello schema, l’ingestione di attività rapide e il supporto scalabile per i carichi di assistenza sociale e l’analisi, il tutto preservando l’integrità referenziale dove conta di più.

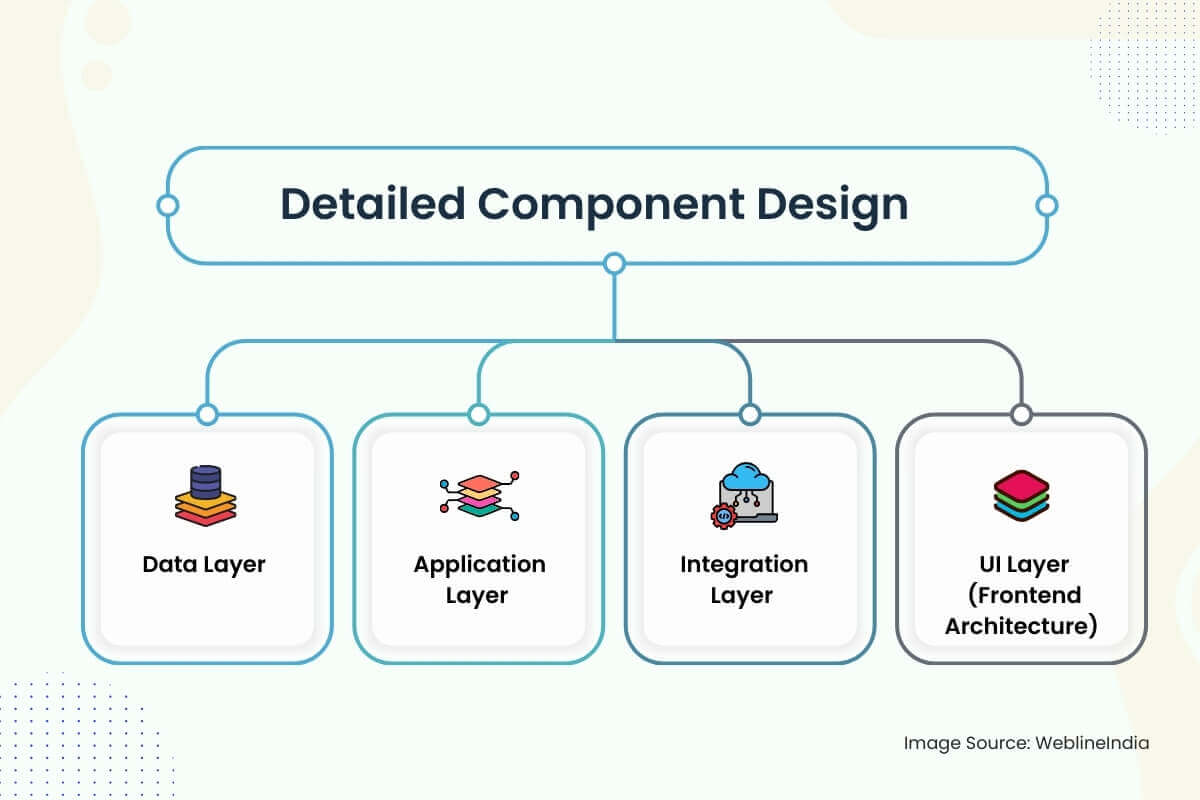

Design dettagliato dei componenti

1. Livello dati

- Strategia dello schema: Gli schemi sono progettati attorno a chiari confini del dominio: utenti, attività, feed, grafici sociali e sfide. Colonne come `visibilità`,` status` e `attività_type` usano tipi enumerati per l’efficienza di indicizzazione. Gli uuidi sono preferiti su numeri interi autoincesti per evitare problemi di chiave calda nei negozi distribuiti.

- Accesso ai dati: L’accesso ai dati di base passa attraverso repository a strato di servizio sottili che applicano le politiche di controllo degli accessi (ad es. Controlli di visibilità sulle attività). Le operazioni di lettura sono ottimizzate tramite viste materializzate e istantanee di alimentazione pre-joined. Percorsi ricchi di scrittura come l’ingestione di attività utilizzano code scritte e condutture di inserimento di massa a picchi di ingestione levigati.

- Convalida: La convalida di input si verifica a più livelli: applicazione dello schema dei bordi tramite OpenAPI o graphQL, convalida profonda nei livelli di servizio (ad esempio, punti GPS validi, timestamp non sovrapposti) e controlli di sanità mentale asincrona sui dati di telemetria tramite lavori in background.

2. Livello dell’applicazione

Design del servizio: Ogni dominio principale (utente, attività, feed, notifica, grafico sociale) è implementato come microservizio isolato. I servizi espongono sia endpoint GRPC che di riposo-riposo per API pubbliche, GRPC per la comunicazione inter-servizio. Principi di architettura pulita separa la logica di dominio dal codice di trasporto e infrastruttura.

Framework:

- Vai o ruggine per i servizi critici per le prestazioni (attività, feed, classifica)

- Node.js o python per codice colla, integrazioni e flussi di lavoro asincroni

- GraphQL Server (Apollo o Hasura) per l’aggregazione front-end e interrogazioni dichiarative

Autenticazione: I token JWT vengono emessi tramite flussi OAuth2. Chiamate da servizio a servizio utilizzano token interni firmati con ambiti basati su ruoli.

Limitazione della tariffa e quote: Implementato tramite secchi token sostenuti da Redis al gateway e granularità a livello di utente (specialmente per i caricamenti di attività).

3. Livello di integrazione

MESSAGGIO CORSE: Kafka o NATS viene utilizzato per i flussi di lavoro asincroni: elaborazione dell’attività, ventilatore da mangime, corrispondenza del segmento e pubblicazione di notifica. Vengono utilizzati gestori di ideenti con forti garanzie di consegna per prevenire posti duplicati o voci di classifica.

Sincronizzazione di terze parti: Integrazioni OAuth con Garmin, Fitbit, Apple Health, ecc. Nuovi dati vengono messi in coda ed elaborati tramite la pipeline di ingestione dell’attività.

Tipi di eventi:

Activity.created→ Fan-Out per il servizio di alimentazione, avvisare i followersfida.joined→ Controllare l’ammissibilità, inserzione della classifica triggerUser.foled→ Aggiorna grafico, aggiornamento feed, notifica di benvenuto

4. UI Layer (Frontend Architecture)

Stack di app: Reagire nativo per app mobili multipiattaforma, con toolkit dattiloscritti e redux per la gestione dello stato. L’app Web utilizza Next.js per SSR/ISR con lo stile dell’utilità di TailWind e le query GraphQL al backend.

Preoccupazioni di sicurezza:

- I segreti del cliente non sono mai incorporati: il flusso di oauth pkce è obbligatorio

- Tutte le chiamate API richiedono token firmati e gli endpoint rivolti al pubblico sono filtrati per tasso, origine e ruolo

- I dati GEO sono sandbox per impostazione di visibilità – Le attività private sono escluse da mappe di calore, mangimi e calcoli del segmento

Caratteristiche in tempo reale: Websockets o SSE vengono utilizzati per spingere le notifiche, lo stato della sfida e gli aggiornamenti dei feed. Fallback al lungo polling su reti vincolate. Il frontend mantiene una cache SQLite locale per la registrazione delle attività offline.

Architecando qualcosa di simile?

La progettazione di piattaforme socialmente interattive in tempo reale, consapevole del tempo interattivo, assume precisione attraverso il flusso di dati, la gestione degli eventi e l’architettura mobile.

Se stai costruendo qualcosa di ambizioso-come una piattaforma di fitness sociale, integrazione indossabile o feed in tempo reale-ci piacerebbe aiutarti a ottenerlo fin dall’inizio.

Considerazioni sulla scalabilità

1. Ridimensionamento del livello dell’applicazione

- Servizi apolidi: Tutti i servizi di base (attività, feed, sfida, ecc.) Sono apolidi e scalabili orizzontalmente. Ogni istanza è usa e getta e fronteggiata da un bilanciamento del carico. I principi non condivisi non assicurano che le istanze non si basino sullo stato locale.

- Scaleggio automatico: Il POD orizzontale basato su K8S (HPA) viene utilizzato per servizi in base a metriche di profondità CPU, memoria e coda. Per i servizi sensibili alla latenza (come il feed o la notifica), le metriche personalizzate (ad es. LAG EVENT) possono innescare scale più veloci.

- API Gateway Throttling: I limiti di tariffa basati su client e IP impediscono le inondazioni API. La tolleranza a burst è supportata usando la finestra scorrevole con redazione Redis o algoritmi di secchio che perdono.

2. Ridimensionamento del livello dati

Leggi l’ottimizzazione: I dati frequentemente accessibili (ad es. Attività recenti, istantanee della classifica) sono memorizzati nella cache in modo aggressivo in Redis con TTLS e sfratto di LRU. Le repliche di lettura di PostgreSQL sono ridimensionate in base al traffico per scaricare l’analisi e le query dell’interfaccia utente.

Strateghi di frammenti:

- Dati di attività: Shardato dall’ID utente tra partizioni o cluster logici (ad es. Activity_01, Activity_02, …)

- Articoli di alimentazione: Partizionato dall’ID dell’attore e dall’ID destinatario con indici compositi per ricerche veloci

- Geostore: Utilizza il prefisso chiave S3 per regione e timestamp per l’elenco degli oggetti ottimizzati e il livello di costi efficienti

3. Feed and Social Graph Fan-Out

La generazione di feed è una grande sfida di scalabilità nelle piattaforme sociali. Il sistema utilizza un approccio ibrido per la ventola:

- Fan-Out-on-Write (primario): Quando un utente pubblica un’attività, il servizio di alimentazione lo spinge in file di alimentazione precomputate per i follower.

- Fan-Out-on-Read (Fallback): Per gli utenti ad alto contenuto di fanout (celebrità, influencer), i feed sono costruiti al momento della query con una paginazione da registri degli eventi sostenuti da Kafka o tabelle di indice di feed.

Archiviazione dei mangimi: Implementato tramite tabelle ottimizzate con scrittura o negozi di famiglie a colonna (ad es. Scilladb o negozi simili a cassandra) con TTL per eventi effimeri e JSON pre-reso per idratazione rapida.

4. Elaborazione della sfida e della classifica

- Calcolo batch: Le classifiche vengono calcolate in batch utilizzando un motore di elaborazione del flusso (ad es. Apache Flink, Spark Streaming). Le corrispondenze del segmento e le validazioni di sfida corrono in modo asincrono dall’ingestione di attività utilizzando argomenti durevoli Kafka.

- Aggregazione finestra: Le statistiche di sfida vengono finestra (quotidianamente, settimanalmente) per prevenire le scansioni della storia completa e ridurre la pressione di stoccaggio. Le opinioni di materiali aggregate sono indicizzate per sfida e segmento.

5. INGRESSIONE DATI GEO e SENSORE

- Ingesco ad alta frequenza: I punti GPS sono scritti in batch ai negozi di serie temporali (o file S3 con indicizzazione) e checkpoint per evitare l’overflow di memoria. Il batching riduce l’amplificazione della scrittura sul DB e accelera la gestione della contropressione.

- Compressione: Le coordinate GPS sono codificate dalta e gzippate prima dello stoccaggio. La reidratazione si verifica al rendering della mappa o al tempo di esportazione, non durante la visualizzazione del feed in tempo reale.

6. TRATTURA DI TRAFFE TRAFFE

I picchi di sincronizzazione di Garmin o Apple vengono assorbiti usando code di ingestione disaccoppiate e condutture ETL controllate dalla velocità. Ogni integrazione ha un interruttore e una politica di riproduzione per prevenire abusi a monte o tempeste di fan.

Architettura di sicurezza

1. Autenticazione e autorizzazione

- Autenticazione: Tutte le interazioni client utilizzano OAuth 2.0 con PKCE per i flussi mobili. I JWT sono emessi e firmati dal servizio di auth, contenente ID utente, portata e scadenza. I token di aggiornamento vengono ruotati e crittografati a riposo.

- Accesso federato: I segni di Google, Apple e Facebook sono supportati, ma sempre collegati a un’identità utente nativa. I token di accesso social sono convalidati sul lato server, non direttamente fidati.

- Autorizzazione: Ogni servizio convalida il token JWT e applica le regole a livello di ambito (ad es. `Leggi: Feed`,` Post: Activity`). RBAC (controllo di accesso basato sul ruolo) viene utilizzato per gli strumenti interni (ad es. Amministratore, ruoli del moderatore).

2. Protezione dei dati

- A riposo:

- I negozi PostgreSQL, Redis e Object sono crittografati utilizzando la crittografia AES-256 con le chiavi gestite dal cliente (CMK).

- I campi sensibili (ad es. E -mail, metriche di salute) sono crittografati nel livello delle applicazioni prima che DB scriva.

- In transito: Tutto il traffico inter-servizio e client-a-server è protetto da TLS 1.2+. TLs reciproco viene utilizzato per la comunicazione GRPC tra i servizi di backend di fiducia.

- Mascheramento a livello di campo: I campi sensibili sono mascherati o redatti in tronchi e dashboard. Gli strumenti di osservabilità applica il tag di campo e la scansione PII automatizzata prima dell’ingestione.

- GEO Privacy: Le attività contrassegnate come private o “solo follower” sono completamente escluse da feed, classifiche e indici di ricerca. I dati di HeatMap sono anonimi e campionati solo da attività pubbliche, con geo-blu vicino alle zone di casa.

3. IAM Design & Secrets Management

- Segreti: Tutte le chiavi API, le credenziali DB e i token Webhook sono archiviati in una volta centralizzata (ad esempio, Hashicorp Vault o AWS Secrets Manager) e iniettati via ambiente in fase di esecuzione. Le politiche di rotazione sono automatizzate per credenziali di breve durata.

- SONO: Ogni microservizio ha un’identità univoca e un insieme di ruoli. Le politiche IAM sono esposte alle autorizzazioni minime richieste (ad es. Accesso di sola lettura alla memoria degli oggetti, accesso solo alla scrittura agli argomenti di Kafka). Gli agenti CI/CD assumono ruoli temporanei utilizzando OIDC Trust.

4. Codice sicura e protezione API

- Convalida dell’input: Tutti gli ingressi esterni sono validati allo schema utilizzando lo schema OpenAPI o JSON. I controlli del frontend e del backend applicano la lunghezza, il formato e i limiti.

- Limitazione della tariffa: I limiti di velocità per utente e per-IP vengono applicati tramite plug-in Redis o API Gateway. I modelli di rilevamento degli abusi (ad es. Storm di accesso o comportamento di spam) alimentano in politiche di limitazione dinamica.

- Replay Protection: Tutte le richieste firmate includono non GEI o timestamp. I caricamenti di attività e i webhook utilizzano le firme HMAC per convalidare l’origine e prevenire la manomissione.

- Sicurezza del codice: L’analisi statica (SAST) e la scansione delle dipendenze sono integrate nelle condotte CI. Il rilevamento dei segreti (ad es. Gitleaks) blocca l’esposizione accidentale. Tutti i flussi critici passano attraverso richieste pull peer-review e verificate.

Estensibilità e manutenibilità

1. Confini del servizio modulare

Ogni dominio importante – utenti, attività, feed, notifiche, sfide – è incapsulato nel proprio servizio, con il proprio schema, API e runtime distribuibile. Questi servizi comunicano in modo asincrono tramite code di messaggi o sincrono tramite GRPC/REST, a seconda della sensibilità alla latenza.

Questo isolamento consente un ridimensionamento indipendente, cicli di rilascio e onboarding di nuovi ingegneri senza rischi di danni collaterali a caratteristiche non correlate. Ad esempio, la spedizione di un nuovo formato di classifica o trigger di notifica non tocca la logica o l’utente di Ingest.

2. Modelli orientati al plug-in

- Ascoltatori di eventi: Nuove funzionalità (ad es. Risultati, avvisi di coaching dal vivo o badge basati su dispositivi) vengono introdotte sottoscrivendo eventi di base come activity.created or challenge.completed. Ciò consente l’innovazione senza riscrivere la logica a monte.

- Flag di funzionalità: Tutte le funzionalità rivolte all’utente sono controllate da flag dinamici (ad es. LaunchDarkly o Internal Leveling Systems), consentendo implementazioni di canarie, test A/B o versioni messe in scena in base a regione, livello utente o piattaforma.

- Logica di sfida personalizzata: Il motore a sfida è estensibile tramite motori di regole o script incorporati (ad es. Lua o cel). Ciò consente ai gestori di marketing o club di creare nuovi tipi di sfide (ad esempio, “salire 2K metri in 3 giorni”) senza la logica del codifica hard nel backend.

3. Codice e pattern puliti

- Design-guidato dal dominio (DDD): I servizi utilizzano DDD per organizzare la logica per contesto limitato – aggregazione di attività, punteggio di segmento, gestione dei follower – piuttosto che per livello tecnico. Ciò riduce la logica trasversale e l’espansione del codice.

- Test e fodera: CI applica il rigoroso rivestimento, soglie di copertura del codice e test a contratto per tutte le API. La velocità degli sviluppatori rimane alta perché le configurazioni di sviluppo locali utilizzano contenitori con database seminati e code finte per una rapida iterazione.

- Monorepo vs polyrepo: Il backend è in genere polyrepo (uno per servizio), mentre l’app mobile può vivere in un monorepo con pacchetti modulari. Protobufs condiviso o le definizioni di schema graphql sono controllate in versione in un repository contrattuale separato.

4. Servizio versione e compatibilità all’indietro

- Versioni API: Tutte le API pubbliche sono in versione (ad esempio, `/v1/attività`). Gli endpoint deprecati vengono mantenuti per un periodo tramonto definito, con l’osservabilità per monitorare l’utilizzo.

- Evoluzione dello schema: Gli schemi di PostgreSQL utilizzano migrazioni additive (aggiungendo colonne, senza rimuoverle) e non rinominare mai enum o vincoli senza interruggini a doppia lettura/scrittura. Per i negozi NOSQL, ogni oggetto viene etichettato con una versione dello schema per la deserializzazione compatibile all’indietro.

- Compatibilità del protocollo: I contratti GRPC e Protobuf sono progettati per evitare di rompere le modifiche: i campi non vengono mai rimossi e gli ID sul campo non vengono riutilizzati. Per GraphQL, i campi deprecati rimangono disponibili con le testate di avvertimento e il fianco nel frontend.

Stai pensando a lungo termine per la tua piattaforma?

Hai bisogno di aiuto per la progettazione di un’architettura modulare e a prova di futuro che non si sgretoli sotto i colli di bottiglia dell’inferno o della crescita?

Che tu stia ridimensionando un’app sociale o che estendi una piattaforma di fitness, siamo qui per aiutare l’architetto per il lungo raggio.

Ottimizzazione delle prestazioni

1. Tuning query del database

- Indicizzazione delle query: Ogni colonna ad alta cardinalità utilizzata in filtri o join-come `user_id`,` attività_id`, `create_at` o` sfida_id`-è supportata da indici Btree o gin. Gli indici compositi vengono creati per query frequenti come `follower_id + created_at desc` nei feed o` user_id + sfida_id` nelle ricerche di classifica.

- Viste materializzate: I rollup giornalieri (ad es. “Distanza totale questa settimana”) sono memorizzati come viste materializzate e aggiornati tramite lavori di asincroni. Ciò evita scansioni di aggregazione ripetitiva e accelera le metriche del cruscotto mobile.

- Caching di query: Le classifiche, i profili pubblici e le pagine di sfida statica utilizzano Redis come livello di memorizzazione nella cache con TTL intelligenti e invalida esplicita su eventi pertinenti.

2. Elaborazione asincrona

- Carichi di lavoro differiti: Compiti pesanti come la corrispondenza dei segmenti, la generazione di mappa di calore, la valutazione dei badge e i ventilatori di follower sono tutti differiti agli operai di fondo che consumano argomenti Kafka/NATS. Ciò mantiene reattivo il percorso di presentazione dell’attività (~ 100–200 ms p99).

- Percorsi di ingestione di massa: I caricamenti da Garmin o Apple Health sono intagliati ed elaborati in parallelo, con deduplicazione e isolamento degli errori per evitare di bloccare la sincronizzazione completa del dispositivo a causa di singoli file corrotti.

3. Controlli di limitazione e abuso della tariffa

- Controllo della tariffa: Ogni endpoint API ha limiti di velocità a livello di utente e a livello IP applicato al gateway. Le operazioni ad alto costo (ad esempio, pubblicare attività con i media) sono ulteriormente limitate attraverso la limitazione adattativa legata per richiedere latenza e lag di coda.

- Rilevamento degli abusi: I modelli con apprendimento di macchine punteggiano azioni come seguire lo spam, le inondazioni dei commenti o il geo-post abusivo. Questi sono legati a filtri in tempo reale che rallentano automaticamente i client maliziosi sandbox.

4. Strati di cache

- Caching Edge: Le mappe di percorso, gli avatar del profilo, le pagine di sfida e le piastrelle di mappa di calore vengono tutti serviti attraverso nodi di bordo CDN (cloudflare, velocemente). Le chiavi della cache sono contrassegnate con hash di versione per consentire una rapida invalidazione globale.

- Caching sul lato cliente: L’app mobile utilizza SQLite locale per la modalità offline, con idratazione da blob JSON aggiornati delta ricevuti all’avvio o post-login. Ciò consente il rendering di mangimi istantanei e le inizia a freddo più fluide.

5. Performance del frontend

- Caricamento incrementale: Feed Scrolls, Visualizzazioni del profilo e elenchi di sfide All implementano una scorrimento infinito o una paginazione finestra utilizzando token a base di cursori. Ciò riduce al minimo le dimensioni del payload e la pressione della memoria sui client mobili.

- Ottimizzazione dell’immagine: Tutte le immagini caricate sono ridimensionate, compresse e convertite in formato (ad esempio, WebP) dal servizio multimediale prima della consegna CDN. Le varianti di risorse specifiche del dispositivo sono selezionate utilizzando le intestazioni di negoziazione del contenuto.

- JS Bundling & Tree Shaking: I client Web utilizzano bundler moderni (ad es. Vite o webpack 5) con divisione dinamica di importazione e agitazione degli alberi. Il caricamento pigro viene impiegato per componenti dell’interfaccia utente non critici come grafici, mappe o analisi.

Strategia di test

1. Tipi di test

- Test unitario: Ogni livello di servizio ha estesi test unitari che coprono la logica del dominio, la convalida di input e le funzioni di utilità. Questi sono rapidi e isolati: nessuna dipendenza esterna consentita. Le biblioteche derisa (ad es. Gomock, Pytest-mock, Jest) vengono utilizzate per isolare gli effetti collaterali.

- Test di integrazione: Le interazioni chiave del servizio-come l’invio dell’attività che attivano la generazione di mangimi o controlli di ammissibilità alla sfida-sono coperte da ambienti di test basati su docker. Questi test girano dipendenze reali (Postgresql, Redis, Kafka) e convalidano il comportamento in condizioni realistiche.

- Test del contratto: Per le API GRPC e REST, i test a contratto (ad es. Utilizzo di Pact o BUF per ProtoBuf) convalidano che i servizi di produttore e consumatore aderiscono agli schemi concordati, in particolare attraverso i dossi della versione di servizio o durante le distribuzioni parallele.

- Test end-to-end (E2E): I flussi di utenti critici – iscrizione, accesso, tracciamento delle attività, commenti – vengono testati utilizzando cipressi o disintossicazione (per react nativo). Questi test funzionano su emulatori e dispositivi reali in CI contro gli ambienti di stadiazione.

2. Strategia di copertura del test CI

- Applicazione della copertura del codice: Le soglie minime vengono applicate per PRS utilizzando strumenti come Codecov o Sonarqube. Copertura Gates Block si fonde se il nuovo codice manca di casi di test adeguati, in particolare per le funzioni di logica della logica del servizio o di trasformazione dei dati.

- Pipeline CI parallelizzate: I test sono raggruppati per servizio ed eseguiti in parallelo tramite azioni GitHub, Circleci o Buildkite. La matrice di test include permutazioni ambientali (ad es. Diverse versioni DB, versioni API).

- Test Fidetures & Seeding: I dati di test condivisi vengono forniti tramite snapshot containeried o dispositivi YAML/JSON dichiarativi. Tutti i servizi supportano il bootstrap della modalità test per gli ambienti di test locali e CI.

3. Test di carico e resilienza

- Test di carico: Script locust, artiglieria o K6 simulano i modelli di traffico di picco-grandi ventilatori, caricamenti di attività in blocco, aggiornamenti della classifica sfida-per testare la risposta del sistema sotto stress. I test di carico vengono eseguiti settimanalmente e durante le versioni importanti.

- Ingegneria del caos: Strumenti come Gremlin o Litmuschaos Iniettano guasti al servizio, al DB o al livello di rete (ad es. Picchi di latenza, divisioni cafka, failover DB). L’obiettivo è convalidare le politiche di riproduzione, la logica di fallback e la copertura di allerta.

- Affermazioni di resilienza: Gli interruttori, le paratie e i fallback di timeout vengono testati esplicitamente. Le distribuzioni Canary includono test di iniezione di errori prima del completamento del lancio.

DevOps & CI/CD

1. Panoramica della pipeline CI/CD

L’intero sistema è basato su flussi di lavoro basati su GIT (GitHub, Gitlab o BitBucket) con condutture automatizzate attivate su richieste di pull, fusioni e versioni basate su tag. CI/CD è trattato come un prodotto di prima classe con prestazioni, isolamento e visibilità come principi di base.

Fase della pipeline:

- Costruire: Le immagini del contenitore sono costruite per servizio utilizzando DockerFiles multi-stage. Le immagini di base comuni sono memorizzate nella cache e riutilizzate. Per le app di frontend, i passaggi di build includono agitazione sugli alberi, trapilazione e analisi del pacchetto.

- Test: I test di unità, integrazione e contratto eseguono in lavori isolati con caricamento artefatto (ad es. Rapporti di copertura, tronchi di test). I lavori falliti sono annotati in linea in PRS per il triage veloce.

- Scansione di sicurezza: SAST (ad es. Sonarqube, Snyk) e scansioni di vulnerabilità della dipendenza vengono applicate prima che vengano promossi artefatti. I segreti degli strumenti di scansione bloccano l’esposizione accidentale.

- Firma dell’immagine: Le immagini del contenitore sono firmate e archiviate in un registro sicuro (ad esempio, AWS ECR, Registro artefatto GCP) con tag immutabili e metadati di provenienza.

- Distribuzione di staging: Le build contrassegnate vengono distribuite automaticamente in un cluster di gestione temporanea. Test di Canarie, test di fumo e controlli sanitari sintetici vengono eseguiti contro questo ambiente con brevi TTL.

- Promozione della produzione: Le distribuzioni su Prod vengono attivate manualmente (con cancelli di approvazione) o automaticamente dopo aver approvato le condizioni di controllo qualità. Gli strumenti Gitops (ad es. Argocd, Flux) applicano manifesti da un repository di stato in versione.

2. Infrastruttura come codice (IAC)

- Terraform: Tutte le infrastrutture – VPC, cluster K8S, istanze DB, ruoli IAM, code – sono gestite tramite moduli Terraform. Le modifiche vengono esaminate e visualizzate in anteprima utilizzando

Piano Terraformin PRS. Il rilevamento della deriva funziona di notte per rilevare i cambiamenti manuali. - Personalizza e caschi: I manifesti di K8S sono modello tramite elmo e gestiti in tutti gli ambienti usando le sovrapposizioni di Kustomize. Ciò semplifica la sostituzione di repliche, configurazioni e segreti per ambiente.

- Gestione dei segreti: Segreti e mappe di configurazione vengono iniettati tramite segreti sigillati (ad es. SOPS Mozilla, segreti sigillati Bitnami) o sincronizzati da Vault usando gli iniettori Sidecar. Tutti i segreti vengono ruotati e controllati regolarmente.

3. Strategia di distribuzione

- Distribuzioni blu-verde: Per i servizi di percorso critico come l’autenticazione o l’attività, vengono utilizzate strategie blu-verdi. Il traffico viene spostato gradualmente utilizzando regole di ingresso, con rollback automatizzato se i controlli sanitari non riescono.

- Release Canary: I servizi non critici (ad es. Notifiche, classifiche) utilizzano le impugnature del Canarie-distribuendo al 5%, quindi 25%, quindi al 100%nel tempo. Le metriche (latenza, tasso di errore, CPU) vengono confrontate con le baseline prima di continuare.

- Flag di funzionalità: Tutti i nuovi percorsi di codice sono protetti da interruttori di funzionalità. Ciò consente un’esposizione progressiva, lanci scuri e interruttori di uccisione istantanea durante gli incidenti.

4. Artefatto e igiene ambientale

- Ciclo di vita dell’immagine: Le vecchie build vengono automaticamente potate in base alle politiche di conservazione dell’età o SHA. Le immagini inutilizzate non vengono mai mantenute oltre i 30 giorni a meno che non siano state contrassegnate come LTS o versioni di rollback.

- Anteprima ambienti: Gli ambienti di stadiazione effimeri vengono creati per PR usando spazi dei nomi dinamici in Kubernetes. Questi ambienti imitano le topologie di produzione e vengono distrutti dopo unione o la chiusura delle pubbliche relazioni.

- Meccanismo di rollback: Ogni distribuzione è atomica e pinne in versione. I rollback possono essere attivati tramite Git Revert, Helm History Rollback o Argocd UI Click – In pochi secondi.

Hai bisogno di aiuto per la spedizione più veloce senza rompere le cose?

Vuoi costruire una pipeline di ingegneria ad alta velocità con rollback a prova di proiettile, flussi di lavoro Gitops e CI/CD di grado di produzione?

Sia che tu stia ridimensionando un back -end di microservizi o lanciando una nuova funzione mobile, andiamo in architetto un sistema DevOps che funziona sotto pressione.

Monitoraggio e osservabilità

1. Registrazione

- Registrazione strutturata: Ogni servizio registri in formato JSON utilizzando campi strutturati come `request_id`,` user_id`, `attività_id` e` duration_ms`. I registri vengono trasmessi in streaming tramite bit fluente o file di file in una pipeline centrale (ad es. Elasticsearch, Loki) per query e analisi indicizzate.

- ID correlazione: Ogni richiesta genera un ID di correlazione univoco che si propaga attraverso i confini del servizio tramite intestazioni e contesto di registro. Ciò consente la tracciabilità end-to-end completa dall’app mobile alle code di backend a DB.

- Igiene del registro: Le regole di mascheramento PII vengono applicate a livello di pipeline di registro. Segreti, token di accesso, coordinate GPS e telemetria grezza sono esclusi o redatti automaticamente prima dell’archiviazione dei registri.

2. Metriche

- Metriche del sistema: CPU, memoria, disco e utilizzo della rete vengono esportati da ogni nodo e pod tramite esportatori di Prometheus. Le soglie di allerta sono impostate per saturazione, pressione delle risorse e insoliti baccelli.

- Metriche aziendali:

- Attività al minuto, eventi di mangime al secondo

- Sfida si unisce, scrive classifica, corrispondenza del segmento

- Latenza per endpoint, tassi di errore del 99 ° percentile

- Strumentazione personalizzata: I servizi utilizzano le librerie client Prometheus per esportare contatori, istogrammi e calibri per la logica personalizzata, come “valutazioni di badge elaborate” o “punti GPS per caricamento”.

3. Tracciamento distribuito

- Sistema di tracciamento: OpenTelemetry viene utilizzato per i servizi di strumento con campate per chiamate HTTP/GRPC, query DB e gestione delle code asincroni. Le tracce vengono esportate in backend come Jaeger, Honeycomb o Tempo.

- Campionamento di traccia: Il campionamento basato sulla testa (con velocità regolabili) garantisce che le transazioni di alto valore come l’ingestione di attività o la ventola di mangime vengono sempre catturate, mentre i lavori di fondo a bassa priorità sono campionati probabilisticamente.

- Traccia collegare: Tutte le tracce retringono agli ID utente e richiedono metadati, consentendo il debug di singole richieste di attività, bug di classifica o generazione di mangime lenti con catene di causalità esatte.

4. Avviso e dashboard

- Gestione degli avvisi: Prometheus AlertManager o Opsgenie gestisce la deduplicazione, le finestre di silenzio, le rotazioni su chiamata e le politiche di escalation. Gli avvisi includono ganci Slack/Teams, SMS e PagerDuty quando vengono incrociate le soglie critiche.

- Dashboard: I dashboard di Grafana sono predefiniti per servizio con funzionalità di perforazione per latenza, tassi di errore, throughput DB, arretrati in coda e guasti dell’API esterna. Le parti interessate aziendali ottengono anche viste KPI (ad es. Utenti attivi, tassi di completamento delle sfide).

- SLOS e budget di errore: Gli endpoint chiave (ad es. Presentazione dell’attività, carico di alimentazione, giunzione della sfida) sono legati a SLO formali con soglie di latenza/errore. Le tariffe di bruciatura sono calcolate per informare il gate della bandiera delle caratteristiche e il ritmo di lancio.

5. Controlli sanitari e sonde di prontezza

- Livezza e prontezza: Tutti i servizi espongono gli endpoint `/Healthz` per la vita di base (ad es. Stato del pool di thread, memoria) e prontezza (ad es. Connettività DB, ritardo della coda). Kubernetes li utilizza per l’orchestrazione automatica e di distribuzione.

- Controlli profondi: Le attività di background periodiche eseguono transazioni sintetiche (ad es. Inserisci attività di test + lettura di alimentazione) per convalidare la salute della logica aziendale, non solo il tempo di up di sistema.

Compromessi e decisioni di progettazione

1. Fan-Out-on-Write vs. Fan-Out-on-Read

- Decisione: È stato scelto un modello ibrido. Per gli utenti medi, il sistema utilizza Fan-Out-on-Write per pre-popolare feed. Per gli utenti ad alto contenuto di fanout (ad es. Influencer), passa a Fan-Out-on-Read.

- Perché: Le voci di alimentazione precomputata minimizza la latenza e scarica il percorso di lettura, ma è costoso quando un utente ha migliaia di follower. Il design ibrido ottimizza per il caso al 95% proteggendo l’infrastruttura dalle tempeste di ventole.

- Scambio: Più complessità operativa. Il sistema deve inserire dinamicamente le scritture/letture attraverso diversi percorsi di codice in base al conteggio del livello dell’utente o dei follower. Aumenta anche la superficie di test.

2. Persistenza poliglotta

- Decisione: PostgreSQL, Redis, Kafka e S3 sono stati scelti come stack di base. L’uso facoltativo di NEO4J per il grafico sociale è stato differito.

- Perché: Questi strumenti si allineano bene con i modelli di accesso: PostgreSQL per integrità, Redis per accesso a bassa latenza, Kafka per scala guidata da eventi e S3 per la memoria BLOB. Evitare un grafico specializzato DB semplificato e onboarding.

- Scambio: Alcune query grafiche (ad esempio, “seguaci reciproci in un club”) sono meno efficienti senza un motore grafico dedicato. La memorizzazione nella cache basata su Redis lo mitiga ma aggiunge la complessità della coerenza della cache.

3. Sync GPS in tempo reale contro caricamento post-allenamento

- Decisione: Il caricamento post-allenamento è il valore predefinito; La sincronizzazione in tempo reale è facoltativo e opt-in (ad esempio, per il monitoraggio in diretta o le gare virtuali).

- Perché: Lo streaming GPS in tempo reale crea un carico di backend costante, introduce sfide di coerenza per attività parziali e aumenta lo scarico di energia sui dispositivi mobili. Per la maggior parte degli utenti, il caricamento batch è sufficiente.

- Scambio: Riduzione della capacità di alimentare funzionalità come applausi dal vivo, abbinamento pacer o aggiornamenti di classifica in corso. Le versioni future possono espandere il supporto in tempo reale dietro le flag di funzionalità.

4. Microservizi contro monolite

- Decisione: I microservizi sono stati scelti in anticipo, con chiari confini del dominio: attività, feed, utente, sfida, media, ecc.

- Perché: Abilita ridimensionamento indipendente, sviluppo parallelo e proprietà specifica del dominio. L’ingestione di mangimi e attività ha profili di prestazioni selvaggiamente diversi: separarli consente l’ottimizzazione mirata.

- Scambio: Richiede strumenti robusti: scoperta di servizi, tracciamento, isolamento CI/CD e maturità ingegneristica della piattaforma. Per le piccole squadre, questo aggiunge complessità iniziale, ma l’agilità a lungo termine supera il dolore a breve termine.

5. Flussi di lavoro sincroni guidati e basati su eventi

- Decisione: Tutti i percorsi non critici (Feed Fan-Out, Aggiornamenti della classifica, Notifiche) sono asincroni tramite Kafka/Nats. Solo le query di autenticazione e flussi di risposta/risposta utilizzano solo.

- Perché: I sistemi Async si adattano meglio e disaccoppiano i flussi di lavoro. Consentono inoltre di essere in lotta, batch e prioritizzazione della coda, essenziali per i modelli di ingressi variabili come le sincronizzazioni di terze parti o i picchi di sfida.

- Scambio: Eventuale coerenza e complessità del debug. Richiede DLQS (code morti), replay eventi e un’attenta logica di deduplicazione. Il monitoraggio e l’osservabilità sono fondamentali per la sicurezza qui.

Debito architettonico e mitigazioni

- Alcuni percorsi di feed più vecchi assumono ancora scritture sincroni: essere refattorate nei servizi Fan-Out con sede a Kafka.

- Il motore a sfida iniziale aveva regole con codice rigido, sostituito con un motore di regola per la flessibilità.

- Logica di autorizzazione sparsa tra i servizi, essendo centralizzato in un servizio di politica di accesso per far rispettare la coerenza.

Takeaway e aree chiave per migliorare

1. Cosa va bene questa architettura

- Scalabilità per design: I servizi apolidi, l’elaborazione basata su eventi e i database shardici mantengono il sistema reattivo anche a milioni di utenti e alti tassi di ingestione.

- Confini modulari: La chiara separazione tra attività, social, media e logica di analisi consente l’ottimizzazione focalizzata e lo sviluppo sicuro e parallelo.

- Asincroni prima: La generazione di mangimi per disaccoppiamento, il punteggio della sfida e le notifiche dal percorso di Ingest di base forniscono prestazioni e isolamento dei guasti dove conta.

- Sicurezza e privacy: Controlli di accesso a grana fine, archiviazione crittografata e rigorose pratiche di osservabilità si allineano con la responsabilità dei dati a livello di GDPR.

- Velocità dello sviluppatore: Pipeline CI/CD, flag di funzionalità e test a contratto supportano un’iterazione rapida e sicura, senza compromettere la stabilità della produzione.

2. Opportunità di miglioramento

- Query di grafico dinamico: Rivalutando l’uso di Redis vs. grafico appositamente costruito DBS (ad es. DGRAPH, NEBULA) per il rilevamento di follower reciproci o le caratteristiche avanzate del club.

- Controllo di accesso unificato: Centralizzazione di tutti i controlli di autorizzazione in un servizio politico (OPA o personalizzato) per evitare la duplicazione e la deriva tra i servizi.

- Caratteristiche dal vivo: Espandere le capacità in tempo reale (ad es. Segmenti in diretta, pacer, corse di gruppo) con protocolli di streaming affidabili e lancio controllato.

- Sincronizzazione offline mobile: Migliorare la prima UX offline per gli utenti nelle aree rurali o durante lunghe attività all’aperto con migliori strategie di risoluzione dei conflitti.

- Analisi avanzata: Costruire pipeline di approfondimenti per atleti dedicati (ad es. VO2 MAX stima, carico di allenamento) utilizzando laghi dati pre-aggregati e modelli ML.

Questa piattaforma Design bilancia prestazioni, flessibilità e esperienza utente in un impegnativo contesto di fitness sociale. È pronto per la produzione, testato in battaglia e costruito per la crescita, ma con spazio per evolversi in un ecosistema di fitness più intelligente, in tempo reale e personalizzato.

Costruire qualcosa di così ambizioso?

Progettare piattaforme scalabili, sicure e socialmente coinvolgenti non si tratta solo di scegliere lo stack giusto: si tratta di prendere le giuste decisioni al momento giusto.

Che tu stia lanciando un’app di fitness, migliorando il coinvolgimento degli utenti o modernizzando il tuo backend, siamo pronti ad aiutarti a architetto con fiducia.

Le persone chiedono anche (FAQ)

Come sviluppare un’app per tracker fitness?

Inizia definendo le caratteristiche principali: monitoraggio delle attività GPS, ingestione dei dati sanitari (frequenza cardiaca, passaggi), profili utente e registrazione offline. Da lì, progetta un’esperienza mobile-first utilizzando React Native o Swift/Kotlin, implementa l’autenticazione per utenti sicura (OAuth2) e connettiti a un backend che può ingerire, elaborare e analizzare i dati dei sensori in tempo reale. Infrastruttura nativa cloud, negozi di dati scalabili ed elaborazione basata sugli eventi sarà la chiave per mantenere strette le prestazioni e la reattività.

Quanto costa costruire un’app di fitness?

Dipende dall’ambito, ma un’app di fitness di grado di produzione con monitoraggio GPS, autentica $ 50k a $ 500k+ per costruire e lanciare. Ciò include UI/UX, sviluppo mobile, architettura backend, DevOps e QA. La scala dei costi basata sulla complessità: monitoraggio live, grafici sociali, integrazioni e analisi aumentano tutti gli sforzi di ingegneria.

Come creare un’app Strava?

Per creare un’app simile a Strava, avrai bisogno di un client mobile per la registrazione delle attività basata su GPS, un back-end per la memorizzazione e l’analisi degli allenamenti degli utenti e un livello di grafico sociale per feed, segue e interazioni. I componenti principali includono una pipeline di posizione in tempo reale, un servizio di alimentazione scalabile e un motore basato su eventi per sfide e classifiche. È essenziale l’architettura per la scalabilità, la bassa latenza e i confini del servizio modulare.

Quanto costa costruire un’app come Strava?

Una piattaforma Strava in stile Strava può facilmente superare $ 500k a $ 1m+ In costi di sviluppo, a seconda del set di funzionalità, della struttura del team e del time-to-market. I costi includono sviluppo mobile e backend, infrastrutture cloud, ottimizzazione delle prestazioni e supporto per cose come carichi di media, impostazioni di privacy e integrazioni di dispositivi di terze parti.

Quale database usa Strava?

Strava non ha dettagliato pubblicamente il loro stack completo, ma sulla base di modelli comuni a sistemi di scala simile, probabilmente usano un mix di database relazionali (ad es. PostgreSQL), negozi di dati distribuiti per la telemetria (ad es. Cassandra o DBS serie temporale) e sistemi simili a Redis per la cache. La loro architettura è basata sugli eventi e basati su microservizi, con infrastrutture cloud che gestiscono milioni di attività al giorno.

Perché Strava è così popolare?

Strava ha inchiodato la miscela del monitoraggio del fitness e dell’impegno sociale. Non si tratta solo di registrare le corse: si tratta di condividerle, competere su segmenti, guadagnare badge e impegnarsi con una comunità. Il feed social, le caratteristiche di gamification e l’ecosistema di sfida rendono la piattaforma appiccicosa e formante, che guida sia la ritenzione che la viralità.

Un’app di fitness è redditizia?

Sì, se eseguito bene. Le app di fitness basate su abbonamento (come Strava Premium, MyFitnesspal, ecc.) Si sono dimostrate altamente redditizie. Le entrate possono provenire da analisi premium, strumenti di coaching, sfide con marchio o mercati degli attrezzi. Ma la redditività richiede una forte strategia di conservazione, l’efficienza delle infrastrutture e la crescita degli utenti oltre MVP.

Come monetizzare la mia app di fitness?

Le strategie comuni di monetizzazione includono: abbonamenti freemium (ad es. Analisi o coaching più profondi), acquisti in-app (ad es. Piani di formazione), partnership di marca (ad es. Sfide sponsorizzate) e mercati di affiliazione (ad es. Scarpe, dispositivi indossabili). Gli annunci sono possibili ma spesso degradano l’esperienza dell’utente. Concentrati sulla fiducia dell’utente e sul valore a lungo termine durante la progettazione di percorsi di monetizzazione.

Testimonianze: ascoltale direttamente dai nostri clienti globali

I nostri processi di sviluppo offrono soluzioni dinamiche per affrontare le sfide aziendali, ottimizzare i costi e guidare la trasformazione digitale. Soluzioni supportate da esperti migliorano la fidelizzazione e la presenza online, mentre casi di successo comprovati evidenziano la risoluzione di problemi reali tramite applicazioni innovative. I nostri stimati clienti in tutto il mondo lo hanno già sperimentato.

Premi e Riconoscimenti

Sebbene i clienti soddisfatti siano la nostra più grande motivazione, il riconoscimento del settore ha un valore significativo. WeblineIndia è stata costantemente leader nella tecnologia, con premi e riconoscimenti che riaffermano la nostra eccellenza.

OA500 Aziende globali di outsourcing 2025, di Outsource Accelerator

Migliore azienda di sviluppo software, di GoodFirms

Migliore azienda di soluzioni fintech – 2022, di GESIA

Premiata come – Migliore azienda di sviluppo app in India 2020, da SoftwareSuggest