Quando il mercato è guidato dalla digitalizzazione, il potere di trasformazione dei Modelli linguistici di grandi dimensioni (LLM) è innegabile. Dall’automazione del servizio clienti alla generazione di codici complessi, gli LLM promettono efficienza e innovazione senza precedenti. Tuttavia, per molte grandi imprese, in particolare quelle che operano in settori altamente regolamentati come finanza, sanità e governo, il perseguimento dell’innovazione dell’intelligenza artificiale (AI) è ostacolato da un ostacolo significativo e non negoziabile: la privacy e la sicurezza dei dati.

L’architettura predefinita per l’implementazione di LLM sofisticati prevede spesso l’outsourcing ai principali fornitori di cloud pubblico. Sebbene conveniente, questo modello implica intrinsecamente che i dati aziendali sensibili, utilizzati per addestrare, mettere a punto e interagire con questi modelli, devono lasciare i confini sicuri della rete interna dell’azienda. Questa esposizione non è solo un rischio; si tratta di una violazione diretta dei mandati normativi (come GDPR, HIPAA e varie leggi nazionali sulla localizzazione dei dati) e delle politiche di conformità interna.

È qui che emerge il concetto di LLM on-premise, non semplicemente come alternativa, ma come architettura essenziale per le imprese determinate a mettere al primo posto la privacy e che spesso scelgono di assumere un team dedicato per un’implementazione sicura dell’IA. L’implementazione di LLM direttamente su hardware interno di proprietà dell’azienda è la soluzione definitiva per ottenere la sovranità assoluta dei dati, garantendo che le informazioni proprietarie non lascino mai il controllo fisico e digitale dell’organizzazione.

Sei pronto a mantenere privati i dati aziendali mentre utilizzi l’intelligenza artificiale? Parla oggi con i nostri esperti LLM.

Il grande conflitto: innovazione vs conformità

Il business case dell’intelligenza artificiale è chiaro: vantaggio competitivo, riduzione dei costi e processo decisionale superiore. Tuttavia, il panorama aziendale è sempre più definito da una rigorosa governance dei dati.

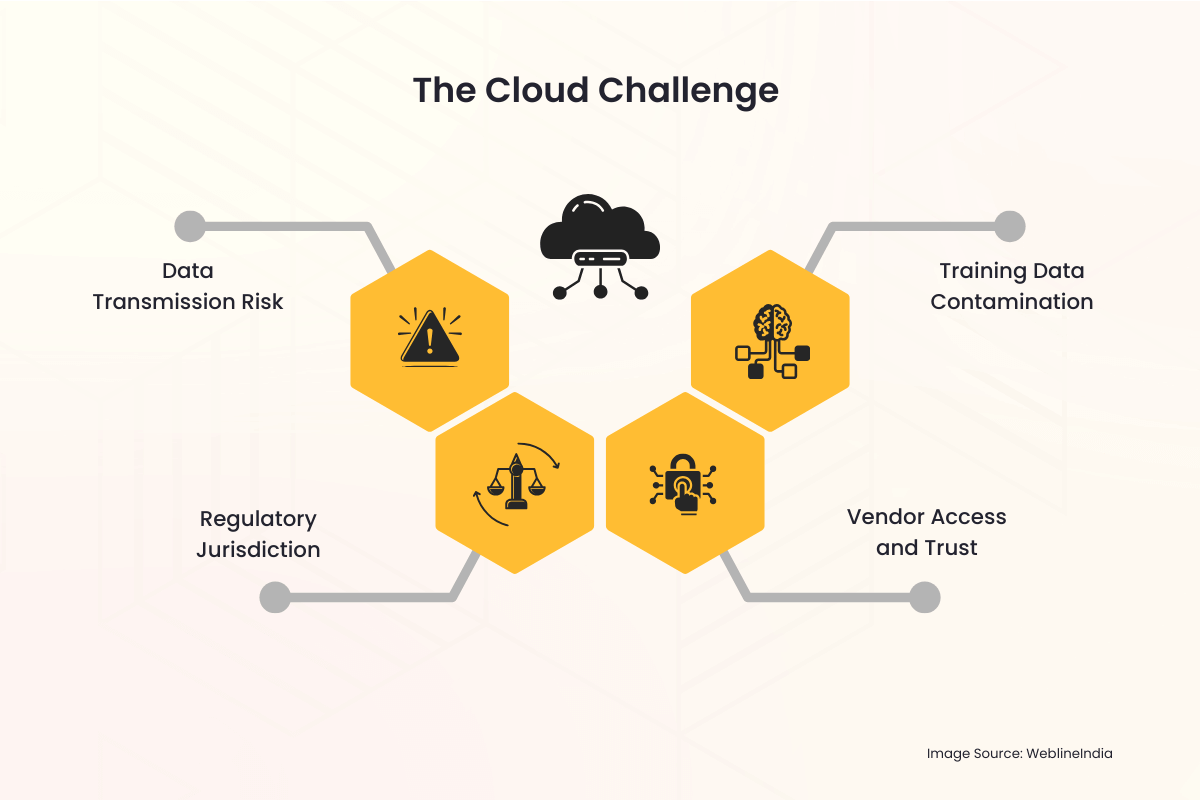

La sfida del cloud

Quando un’azienda utilizza un servizio LLM ospitato nel cloud, emergono immediatamente diverse insidie della privacy:

- Rischio di trasmissione dati: Ogni query, ogni input e l’output risultante devono attraversare la rete Internet pubblica e risiedere temporaneamente su un server di terze parti. L’intero processo è un potenziale vettore di intercettazione o accesso non autorizzato.

- Giurisdizione normativa: I dati archiviati in un Paese o in una giurisdizione diversa da quella di origine dell’impresa possono innescare leggi internazionali complesse, spesso contrastanti. Raggiungere la localizzazione dei dati, ovvero il requisito per cui i dati devono essere archiviati ed elaborati entro confini specifici, diventa praticamente impossibile con un fornitore cloud multinazionale.

- Accesso e fiducia del fornitore: Le aziende sono costrette a fidarsi dei protocolli di sicurezza, dei controlli di accesso dei dipendenti e delle politiche di conservazione del fornitore di servizi cloud. Ciò introduce una terza parte nei flussi di lavoro dei dati più sensibili.

- Contaminazione dei dati di addestramento: Se i dati proprietari di un’azienda vengono utilizzati per mettere a punto un modello ospitato nel cloud, c’è sempre il rischio che i pesi del modello possano essere inavvertitamente, o anche intenzionalmente, condivisi o influenzare le risposte dei modelli utilizzati da altri tenant, con conseguente perdita di dati.

Queste preoccupazioni non sono teoriche. Episodi di violazione dei dati di alto profilo e le severe sanzioni imposte dagli organismi di regolamentazione globali hanno elevato la privacy dei dati da un grattacapo IT a una priorità fondamentale nei consigli di amministrazione. Per le organizzazioni che gestiscono informazioni di identificazione personale (PII), informazioni sanitarie protette (PHI) o proprietà intellettuale classificata (IP), il profilo di rischio dei LLM su cloud pubblico è spesso semplicemente troppo alto per essere accettato.

La soluzione on-premise: rivendicare controllo e sovranità

Il modello di distribuzione LLM in sede affronta e risolve direttamente questi profondi problemi di privacy ponendo l’intera infrastruttura AI (hardware, software, pesi del modello e dati di formazione) sotto il controllo fisico e digitale diretto ed esclusivo dell’azienda.

1. Sovranità assoluta dei dati

Sovranità dei dati significa che i dati sono soggetti solo alle leggi e alle regole di governance del paese o dell’organizzazione in cui vengono raccolti e archiviati.

- Controllo geografico: Con una configurazione on-premise, l’hardware si trova fisicamente all’interno del data center aziendale, spesso all’interno di un paese specifico o addirittura in una specifica stanza protetta. Ciò soddisfa intrinsecamente i requisiti di residenza e localizzazione dei dati, rendendo semplice la conformità a normative come il GDPR dell’UE o varie leggi sulla sicurezza nazionale.

- Trasmissione esterna zero: Tutta l’elaborazione dei dati, l’addestramento del modello e l’inferenza (interrogazione del modello) avvengono all’interno del firewall aziendale. Le richieste sensibili e i documenti interni proprietari utilizzati da LLM non lasciano mai l’ambiente di rete sicuro.

2. Sicurezza e conformità migliorate

Una distribuzione in sede consente al team di sicurezza di applicare il solido framework di sicurezza esistente dell’organizzazione direttamente al sistema di intelligenza artificiale.

- Infrastruttura di sicurezza esistente: La soluzione LLM può essere perfettamente integrata con strumenti di sicurezza aziendali consolidati, inclusi sistemi di rilevamento delle intrusioni (IDS), firewall sofisticati, soluzioni di gestione delle identità e degli accessi (IAM) e sistemi di prevenzione della perdita di dati (DLP). Questo è spesso più completo e personalizzato rispetto ai livelli di sicurezza offerti da un servizio cloud generico.

- Controllo accessi personalizzato: L’accesso al modello stesso può essere rigorosamente controllato tramite Active Directory aziendale interna o altre soluzioni IAM aziendali. Solo i dipendenti, i dipartimenti o le applicazioni autorizzati possono interagire con il modello e i registri di accesso vengono conservati internamente a fini di controllo.

- Controllo semplificato: La conformità normativa spesso richiede audit trail dettagliati. Possedere l’intero stack consente all’azienda di conservare registri dettagliati di ogni utilizzo del modello, attività di formazione e azione di amministrazione, rendendo i controlli di conformità molto più semplici per i revisori interni ed esterni.

3. Tutela della proprietà intellettuale

Per le imprese, il vero valore di un LLM non risiede solo nel modello fondamentale (come Llama, Mistral o altri) ma nella conoscenza proprietaria utilizzata per metterlo a punto. Questi dati di perfezionamento rappresentano l’IP dell’organizzazione.

- Ambiente di formazione isolato: Quando l’ottimizzazione viene condotta in sede, i set di dati proprietari (come record dei clienti, report interni, domande di brevetto o specifiche di prodotto) non vengono mai caricati a terzi. I pesi del modello ottimizzati risultanti, che codificano efficacemente la conoscenza dell’azienda, vengono conservati anche internamente, impedendo a qualsiasi parte esterna di ottenere accesso non autorizzato all’IP principale.

Hai bisogno di un LLM conforme e on-premise su misura per il tuo settore? Costruiamolo in sicurezza.

Gli aspetti pratici dell’architettura LLM on-premise

Sebbene i vantaggi in termini di privacy siano convincenti, l’implementazione di un LLM in sede richiede un’attenta pianificazione e investimenti nella tecnologia sottostante.

La sfida hardware: la necessità di GPU

Gli LLM sono impegnativi dal punto di vista computazionale. L’elemento chiave per un’efficiente distribuzione in sede è l’hardware specializzato, principalmente le GPU (unità di elaborazione grafica).

- Potenza di inferenza: Per servire le query degli utenti in tempo reale (inferenza), LLM richiede memoria ad alta velocità e potenza di elaborazione parallela fornita dalle GPU, spesso in rack di server dedicati.

- Formazione e messa a punto: Addestrare un modello da zero è un’impresa enorme, ma la messa a punto (adattando un modello esistente) è realizzabile su un numero inferiore di GPU potenti. L’investimento in questo hardware è una spesa in conto capitale (CapEx) che sostituisce la spesa operativa continua (OpEx) dei costi del servizio cloud, offrendo prevedibilità dei costi a lungo termine.

Lo stack software

La soluzione on-premise completa non coinvolge solo l’hardware; richiede un software robusto e un livello di orchestrazione:

- Selezione del modello: Il primo passo è scegliere un LLM di base open source e commercialmente fattibile (come Llama 3, Mistral, ecc.) che possa essere scaricato e distribuito legalmente su un’infrastruttura privata.

- Containerizzazione (ad esempio, Docker/Kubernetes): Per gestire la complessa distribuzione, LLM e le sue dipendenze sono spesso impacchettati in contenitori. Strumenti di orchestrazione come Kubernetes gestiscono il cluster di server GPU, garantendo scalabilità e disponibilità elevata, proprio come un ambiente cloud privato, spesso implementato da aziende che Assumi ingegneri cloud e DevOps per gestire un’infrastruttura IA così complessa.

- Livello API interno: All’interno del firewall è integrata un’interfaccia di programmazione dell’applicazione (API), che consente alle applicazioni interne (chatbot, assistenti di codifica, analisti di dati) di inviare richieste all’LLM senza mai toccare l’Internet pubblica.

Superare la latenza dei dati e la governance

Le soluzioni on-premise eliminano la latenza dei dati e migliorano la governance per le origini dati interne.

- Accesso ai dati interni in tempo reale: Gli LLM spesso hanno bisogno di accedere ai dati interni più aggiornati, un processo chiamato Retrieval-Augmented Generation (RAG). Essendo on-premise, LLM dispone di un accesso a bassa latenza e larghezza di banda elevata a database interni, data lake e repository di documenti, garantendo risultati più accurati, contestuali e tempestivi senza la necessità di trasferire dati su Internet.

- Governance unificata: Il team di governance dei dati può applicare un unico set di regole ai dati, all’indice RAG e allo stesso LLM, creando un ambiente di conformità unificato e più semplice.

Vantaggi strategici per le industrie attente alla privacy

Il passaggio a un’architettura on-premise è una decisione strategica che segnala un forte impegno verso il rispetto delle normative e la fiducia dei clienti.

| Industria | Preoccupazione primaria in materia di privacy | Vantaggio della soluzione on-premise |

| Sanità (HIPAA) | Protezione delle PHI e delle cartelle cliniche dei pazienti. | Garantisce che le PHI rimangano all’interno di un ambiente sicuro e dedicato; semplifica i registri di controllo necessari per la conformità. |

| Servizi finanziari (GDPR, PCI-DSS) | PII del cliente, dati delle transazioni, IP algoritmico. | Garantisce residenza e localizzazione dei dati; protegge gli algoritmi di trading proprietari e i modelli di scoring dei clienti dall’esposizione esterna. |

| Governo/Difesa | Informazioni riservate, altamente sensibili o segrete di stato. | Consente l’implementazione in ambienti air-gapped (reti fisicamente isolate da Internet), garantendo una sicurezza assoluta. |

| Produzione/Ricerca e sviluppo | Proprietà intellettuale (PI), design proprietari e segreti commerciali. | Previene la perdita di processi di produzione esclusivi o di dettagli di progettazione del prodotto utilizzati durante il RAG o la messa a punto. |

Colmare il divario con i servizi IT professionali

La decisione di passare a un’architettura LLM on-premise, sebbene strategicamente valida per la privacy, introduce una significativa complessità operativa. Richiede competenze specializzate nell’approvvigionamento di hardware (in particolare GPU ad alte prestazioni), nella creazione di un ambiente robusto e containerizzato (come Kubernetes), nella messa a punto di modelli su dati sensibili e nell’integrazione del LLM con i sistemi aziendali esistenti. È qui che un partner affidabile per i servizi IT diventa prezioso.

WeblineIndia è una rinomata agenzia IT negli Stati Uniti specializzata nel fornire le competenze complete necessarie per affrontare senza problemi questa transizione. Offrono servizi professionali end-to-end, dalla progettazione dello stack hardware locale ottimale su misura per le tue esigenze di inferenza e formazione, alla gestione della distribuzione sicura di LLM open source all’interno del tuo firewall.

Gli esperti cloud presso l’hub di sviluppo di WeblineIndia in India possiedono una profonda esperienza nell’infrastruttura cloud sicura e nell’implementazione dell’intelligenza artificiale. Le aziende possono implementare rapidamente il proprio ambiente LLM privato, garantendo una rigorosa aderenza alle politiche di conformità interna e accelerando il time-to-value senza la necessità di assumere e formare costosi team interni specializzati di ingegneria dell’intelligenza artificiale, sfruttando sviluppatori remoti esperti. Questa partnership trasforma un progetto infrastrutturale impegnativo in un’iniziativa gestibile, eseguita strategicamente, completamente dedicata al mantenimento della sovranità assoluta dei dati.

Il futuro è privato e sicuro con WeblineIndia

L’entusiasmo per i LLM non dovrebbe oscurare la responsabilità fondamentale che le imprese hanno di proteggere i dati sensibili loro affidati. Per qualsiasi organizzazione di grandi dimensioni in cui conformità, privacy e sovranità dei dati non sono negoziabili (vale a dire, le aziende di maggior successo oggi), il modello LLM del cloud pubblico rappresenta una discrepanza fondamentale.

Il passaggio all’implementazione LLM in sede rappresenta un chiaro percorso da seguire. È l’investimento necessario in hardware e competenze che colma il divario di sicurezza, soddisfa i più severi requisiti normativi globali e, in definitiva, consente all’azienda di sfruttare l’intero potenziale di trasformazione dell’intelligenza artificiale senza mai compromettere la sua risorsa più preziosa: i suoi dati.

Contatta WeblineIndia Servizi di consulenza IT per sfuggire ai rischi intrinseci del cloud e recuperare il controllo sul proprio stack AI per innovare con coraggio. Puoi garantire che la fiducia dei clienti, la conformità e la proprietà intellettuale siano assolutamente protetti all’interno del loro dominio sovrano.

Hashtag sociali

#LLMOnPremise #SovranitàDeiDati #IAperleAziende #ConformitàIA #PrivacyAlPrimoPosto #IAsicura #SicurezzaLLM #TecnologiaAziendale

Desideri il pieno controllo del tuo stack AI senza rischi per i dati? Inizia con WeblineIndia.

Domande frequenti

Testimonianze: ascoltale direttamente dai nostri clienti globali

I nostri processi di sviluppo offrono soluzioni dinamiche per affrontare le sfide aziendali, ottimizzare i costi e guidare la trasformazione digitale. Soluzioni supportate da esperti migliorano la fidelizzazione e la presenza online, mentre casi di successo comprovati evidenziano la risoluzione di problemi reali tramite applicazioni innovative. I nostri stimati clienti in tutto il mondo lo hanno già sperimentato.

Premi e Riconoscimenti

Sebbene i clienti soddisfatti siano la nostra più grande motivazione, il riconoscimento del settore ha un valore significativo. WeblineIndia è stata costantemente leader nella tecnologia, con premi e riconoscimenti che riaffermano la nostra eccellenza.

OA500 Aziende globali di outsourcing 2025, di Outsource Accelerator

Migliore azienda di sviluppo software, di GoodFirms

Migliore azienda di soluzioni fintech – 2022, di GESIA

Premiata come – Migliore azienda di sviluppo app in India 2020, da SoftwareSuggest