Når markedet er drevet av digitalisering, er den transformative kraften til Store språkmodeller (LLM) ubestridelig. Fra automatisering av kundeservice til å generere kompleks kode, LLM-er lover enestående effektivitet og innovasjon. Likevel, for mange store bedrifter, spesielt de som opererer i sterkt regulerte sektorer som finans, helsevesen og myndigheter, er jakten på kunstig intelligens (AI) innovasjon hemmet av en betydelig, ikke-omsettelig veisperring: datasikkerhet og sikkerhet.

Standardarkitekturen for å distribuere sofistikerte LLM-er involverer ofte outsourcing til store offentlige skyleverandører. Selv om den er praktisk, betyr denne modellen i seg selv at sensitive bedriftsdata, som brukes til å trene, finjustere og samhandle med disse modellene, må forlate de sikre rammene til selskapets interne nettverk. Denne eksponeringen er ikke bare en risiko; det er et direkte brudd på regulatoriske mandater (som GDPR, HIPAA og ulike nasjonale datalokaliseringslover) og interne retningslinjer for samsvar.

Det er her konseptet med lokale LLM-er dukker opp, ikke bare som et alternativ, men som den essensielle arkitekturen for bedrifter som er fast bestemt på å være personvernet først og ofte velger å ansette et dedikert team for sikker AI-implementering. Å distribuere LLM-er direkte på bedriftseid, intern maskinvare er den definitive løsningen for å oppnå absolutt datasuverenitet, som sikrer at proprietær informasjon aldri forlater den fysiske og digitale kontrollen til organisasjonen.

Klar til å holde bedriftsdata private mens du bruker AI? Snakk med våre LLM-eksperter i dag.

Den store konflikten: innovasjon vs. samsvar

Forretningssaken for AI er klar: konkurransefortrinn, kostnadsreduksjon og overlegen beslutningstaking. Imidlertid blir bedriftslandskapet i økende grad definert av streng datastyring.

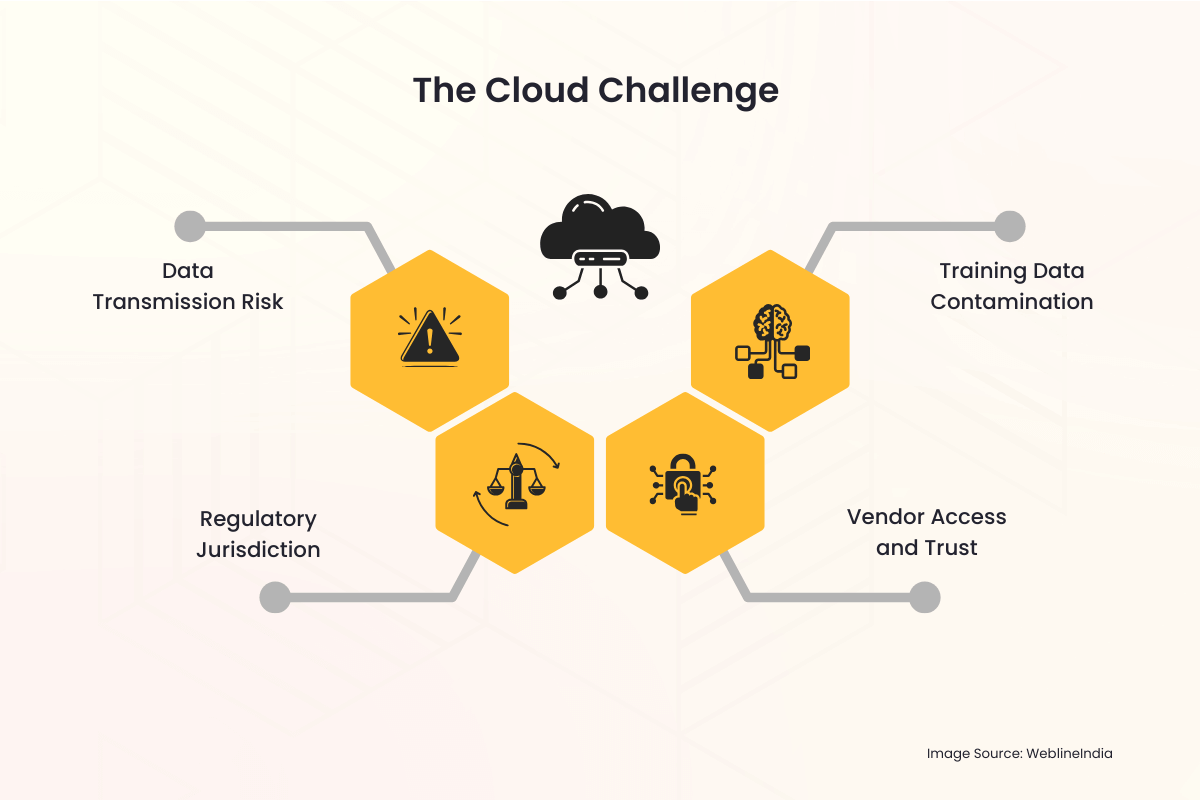

Skyutfordringen

Når en bedrift bruker en skybasert LLM-tjeneste, dukker det umiddelbart opp flere personvernfeller:

- Dataoverføringsrisiko: Hver spørring, hver inngang og den resulterende utgangen må krysse det offentlige internett og ligge midlertidig på en tredjeparts server. Hele denne prosessen er en potensiell vektor for avskjæring eller uautorisert tilgang.

- Regulatorisk jurisdiksjon: Data lagret i et annet land eller jurisdiksjon enn bedriftens opprinnelse kan utløse komplekse, ofte motstridende, internasjonale lover. Å oppnå datalokalisering – kravet om at data skal lagres og behandles innenfor spesifikke grenser – blir praktisk talt umulig med en multinasjonal skyleverandør.

- Leverandørtilgang og tillit: Bedrifter er tvunget til å stole på skyleverandørens sikkerhetsprotokoller, ansattes tilgangskontroller og oppbevaringspolicyer. Dette introduserer en tredjepart i de mest sensitive dataarbeidsflytene.

- Forurensning av treningsdata: Hvis et selskaps proprietære data brukes til å finjustere en modell som er vert i skyen, er det alltid en risiko for at modellvekter utilsiktet, eller til og med ondsinnet, kan deles eller påvirke responsene til modeller brukt av andre leietakere, noe som fører til datalekkasje.

Disse bekymringene er ikke teoretiske. Høyprofilerte hendelser med datainnbrudd og de strenge straffene som håndheves av globale reguleringsorganer har løftet personvernet fra IT-hodepine til en kjerneprioritet i styrerommet. For organisasjoner som håndterer personlig identifiserbar informasjon (PII), beskyttet helseinformasjon (PHI) eller klassifisert intellektuell eiendom (IP), er risikoprofilen til LLM-er i offentlig sky ofte ganske enkelt for høy til å akseptere.

Løsningen på stedet: Gjenvinne kontroll og suverenitet

Den lokale LLM-implementeringsmodellen adresserer og løser disse dype personvernproblemene direkte ved å plassere hele AI-infrastrukturen (maskinvaren, programvaren, modellvektene og treningsdataene) under direkte og eksklusiv fysisk og digital kontroll av bedriften.

1. Absolutt datasuverenitet

Datasuverenitet betyr at data kun er underlagt lovene og styringsreglene i landet eller organisasjonen der de samles inn og lagres.

- Geografisk kontroll: Med et lokalt oppsett er maskinvaren fysisk plassert i bedriftens datasenter, ofte i et spesifikt land eller til og med et spesifikt sikkert rom. Dette tilfredsstiller i seg selv krav til dataopphold og datalokalisering, noe som gjør samsvar med forskrifter som EUs GDPR eller ulike nasjonale sikkerhetslover enkel.

- Null ekstern overføring: All databehandling, modellopplæring og inferens (søking etter modellen) skjer innenfor bedriftens brannmur. Sensitive meldinger og proprietære interne dokumenter som brukes av LLM forlater aldri det sikre nettverksmiljøet.

2. Forbedret sikkerhet og samsvar

En lokal distribusjon lar sikkerhetsteamet bruke organisasjonens eksisterende, robuste sikkerhetsrammeverk direkte på AI-systemet.

- Eksisterende sikkerhetsinfrastruktur: LLM-løsningen kan integreres sømløst med etablerte sikkerhetsverktøy for bedrifter, inkludert Intrusion Detection Systems (IDS), sofistikerte brannmurer, løsninger for identitets- og tilgangsadministrasjon (IAM) og systemer for forebygging av datatap (DLP). Dette er ofte mer omfattende og skreddersydd enn sikkerhetslagene som tilbys av en generisk skytjeneste.

- Tilpasset tilgangskontroll: Tilgang til selve modellen kan kontrolleres strengt via intern bedrifts Active Directory eller andre enterprise IAM-løsninger. Bare autoriserte ansatte, avdelinger eller applikasjoner kan samhandle med modellen, og tilgangslogger beholdes internt for revisjonsformål.

- Forenklet revisjon: Overholdelse av regelverk krever ofte detaljerte revisjonsspor. Å eie hele stabelen lar bedriften føre detaljerte logger over hver modellbruk, opplæringsoppgave og admin handling, noe som gjør samsvarskontroller mye enklere for interne og eksterne revisorer.

3. Beskyttelse av intellektuell eiendom

For bedrifter ligger den sanne verdien av en LLM ikke bare i den grunnleggende modellen (som Llama, Mistral eller andre), men i den proprietære kunnskapen som brukes til å finjustere den. Disse finjusteringsdataene er organisasjonens IP.

- Isolert treningsmiljø: Når finjustering utføres på stedet, blir de proprietære datasettene (som kunderegistre, interne rapporter, patentsøknader eller produktspesifikasjoner) aldri lastet opp til en tredjepart. De resulterende finjusterte modellvektene, som effektivt koder for selskapets kunnskap, beholdes også internt, og hindrer enhver ekstern part i å få uautorisert tilgang til kjerne-IPen.

Trenger du en kompatibel, lokal LLM skreddersydd for din bransje? La oss bygge det sikkert.

Det praktiske ved on-premise LLM-arkitektur

Mens personvernfordelene er overbevisende, krever implementering av en lokal LLM nøye planlegging og investering i den underliggende teknologien.

Maskinvareutfordringen: Behovet for GPUer

LLM-er er beregningsmessig krevende. Nøkkelen muliggjører for effektiv distribusjon på stedet er spesialisert maskinvare, først og fremst GPUer (Graphics Processing Units).

- Inferenskraft: For å betjene sanntidsbrukerspørringer (inferens), krever LLM høyhastighetsminne og parallell prosessorkraft levert av GPUer, ofte i dedikerte serverrack.

- Trening og finjustering: Å trene en modell fra bunnen av er en enorm oppgave, men finjustering (tilpasse en eksisterende modell) er oppnåelig på færre, kraftige GPUer. Investeringen i denne maskinvaren er en kapitalutgift (CapEx) som erstatter de løpende driftsutgiftene (OpEx) til skytjenesteavgifter, og tilbyr langsiktig kostnadsforutsigbarhet.

Programvarestabelen

Den fullstendige lokale løsningen involverer mer enn bare maskinvare; det krever et robust programvare- og orkestreringslag:

- Modellvalg: Å velge en åpen kildekode, kommersielt levedyktig grunnleggende LLM (som Llama 3, Mistral, etc.) som lovlig kan lastes ned og distribueres på privat infrastruktur er det første trinnet.

- Containerisering (f.eks. Docker/Kubernetes): For å administrere den komplekse distribusjonen, er LLM og dens avhengigheter ofte pakket inn i containere. Orkestreringsverktøy som Kubernetes administrerer klyngen av GPU-servere, og sikrer skalerbarhet og høy tilgjengelighet, omtrent som et privat skymiljø – ofte implementert av bedrifter som Ansett Cloud- og DevOps-ingeniører å administrere en slik kompleks AI-infrastruktur.

- Internt API-lag: Et applikasjonsprogrammeringsgrensesnitt (API) er bygget i brannmuren, slik at interne applikasjoner (chatbots, kodeassistenter, dataanalytikere) kan sende meldinger til LLM uten å berøre det offentlige internett.

Overvinne dataforsinkelse og styring

Lokale løsninger eliminerer dataforsinkelse og forbedrer styringen for interne datakilder.

- Tilgang til intern data i sanntid: LLM-er trenger ofte tilgang til de nyeste interne dataene – en prosess som kalles Retrieval-Augmented Generation (RAG). Ved å være på stedet har LLM tilgang med lav latens og høy båndbredde til interne databaser, datainnsjøer og dokumentlager, noe som fører til mer nøyaktige, kontekstuelle og rettidige resultater uten behov for dataoverføring over internett.

- Samlet styring: Datastyringsteamet kan bruke et enkelt sett med regler på dataene, RAG-indeksen og selve LLM, og skaper et enhetlig og enklere samsvarsmiljø.

Strategiske fordeler for personvernbevisste bransjer

Overgangen til en lokal arkitektur er en strategisk avgjørelse som signaliserer en sterk forpliktelse til regulatorisk overholdelse og kundetillit.

| Industri | Primær personvernhensyn | Løsningsfordel på stedet |

| Helsetjenester (HIPAA) | Beskyttelse av PHI og pasientjournaler. | Sikrer at PHI forblir i et sikkert, dedikert miljø; forenkler revisjonslogger som kreves for samsvar. |

| Finansielle tjenester (GDPR, PCI-DSS) | Kunde PII, transaksjonsdata, algoritmisk IP. | Garanterer dataopphold og lokalisering; beskytter proprietære handelsalgoritmer og kundescoringsmodeller mot ekstern eksponering. |

| Regjeringen / Forsvaret | Klassifisert, svært sensitiv eller statshemmelig informasjon. | Tillater distribusjon i miljøer med luftgap (nettverk fysisk isolert fra internett), og sikrer absolutt sikkerhet. |

| Produksjon / FoU | Intellectual Property (IP), proprietære design og forretningshemmeligheter. | Forhindrer lekkasje av unike produksjonsprosesser eller produktdesigndetaljer brukt under RAG eller finjustering. |

Bygg bro over gapet med profesjonelle IT-tjenester

Beslutningen om å gå over til en lokal LLM-arkitektur, selv om den er strategisk god for personvern, introduserer betydelig operasjonell kompleksitet. Det krever spesialiserte ferdigheter innen maskinvareinnkjøp (spesielt høyytelses GPUer), å sette opp et robust, containerisert miljø (som Kubernetes), finjustere modeller på sensitive data og integrere LLM med eksisterende bedriftssystemer. Det er her en pålitelig IT-tjenestepartner blir uvurderlig.

WeblineIndia er et anerkjent IT-byrå i USA som spesialiserer seg på å tilby den omfattende ekspertisen som trengs for å navigere denne overgangen sømløst. De tilbyr ende-til-ende profesjonelle tjenester, fra å designe den optimale lokale maskinvarestabelen skreddersydd for dine slutnings- og opplæringsbehov, til å administrere sikker distribusjon av åpen kildekode LLM-er i brannmuren din.

Skyeksperter ved WeblineIndia’s utviklingssenter i India har dyp erfaring med sikker skyinfrastruktur og AI-implementering. Bedrifter kan raskt distribuere sitt private LLM-miljø, sikre streng overholdelse av interne overholdelsespolicyer og akselerere tid til verdi uten å måtte ansette og trene dyre, spesialiserte interne AI-ingeniørteam, ved å utnytte erfarne eksterne utviklere. Dette partnerskapet forvandler et utfordrende infrastrukturprosjekt til et håndterbart, strategisk utført initiativ, fullt dedikert til å opprettholde din absolutte datasuverenitet.

Fremtiden er privat og sikker med WeblineIndia

Spenningen rundt LLM-er bør ikke overskygge det grunnleggende ansvaret bedrifter har for å beskytte de sensitive dataene som er betrodd dem. For enhver stor organisasjon der overholdelse, personvern og datasuverenitet er ikke-omsettelige (som vil si de fleste vellykkede bedrifter i dag), er den offentlige skyen LLM-modellen en grunnleggende mismatch.

Skiftet til lokal LLM-distribusjon representerer en klar vei fremover. Det er den nødvendige investeringen i maskinvare og ekspertise som tetter sikkerhetsgapet, tilfredsstiller de strengeste globale regulatoriske kravene, og til slutt lar bedriften utnytte det fulle, transformative potensialet til kunstig intelligens uten å gå på akkord med dens mest verdifulle ressurs: dataene.

Kontakt WeblineIndia IT-konsulenttjenester for å unnslippe de iboende risikoene til skyen og gjenvinne kontrollen over AI-stabelen deres for å innovere modig. Du kan forsikre kundenes tillit, overholdelsesstatus og intellektuell eiendom er absolutt sikret innenfor deres eget suverene domene.

Sosiale Hashtags

#OnPremiseLLM #DataSovereignty #EnterpriseAI #AICompliance #PrivacyFirst #SecureAI #LLMSecurity #EnterpriseTechnology

Vil du ha full kontroll over AI-stakken din med null datarisiko? Start med WeblineIndia.

Ofte stilte spørsmål

Kundeuttalelser: Hør det direkte fra våre globale kunder

Våre utviklingsprosesser leverer dynamiske løsninger for å håndtere forretningsutfordringer, optimalisere kostnader og drive digital transformasjon. Løsninger støttet av eksperter styrker kundefrafall og digital tilstedeværelse, og dokumenterte suksesshistorier fremhever problemløsning i praksis gjennom innovative applikasjoner. Våre anerkjente kunder over hele verden har allerede opplevd det.

Priser og Anerkjennelser

Selv om fornøyde kunder er vår største motivasjon, har bransjeerkjennelse betydelig verdi. WeblineIndia har konsekvent ledet an innen teknologi, med priser og utmerkelser som bekrefter vår fremragende kvalitet.

OA500 Globale outsourcing‑selskaper 2025, av Outsource Accelerator

Ledende programvareutviklingsselskap, av GoodFirms

Beste fintech-produktselskap – 2022, av GESIA

Tildelt som – Beste apputviklingsselskap i India 2020, av SoftwareSuggest