Push-meddelelser er overalt-uanset om det er en brud på nyhedsadvarsler, en vejropdatering eller en “din ordre har sendt” besked, de driver engagement og leverer realtidsværdi til brugerne. Men at designe et push -meddelelsessystem, der kan håndtere milliarder af meddelelser på tværs af platforme, mens du forbliver performant og pålidelig, er ingen gåtur i parken.

Moderne applikationer er ofte nødt til at skubbe tidsfølsomme oplysninger til brugere på mobile enheder (iOS/Android), desktops (MACOS/Windows) og browsere (Chrome, Firefox, Safari). Hver af disse platforme leveres med sin egen protokol, leveringsbegrænsninger og satsgrænser. Nu er lag i forretningsregler som brugerpræferencer, segmentering, throttling, forsøg og lokalisering-du stirrer pludselig på et ikke-trivielt distribueret system.

En grundlæggende implementering fungerer muligvis i lav skala eller i et proof-of-concept. Men hvad sker der, når du har 50 millioner brugere, hver med flere enheder, og marketing ønsker at køre kampagner til 10% af dit publikum hvert par minutter? Det er her ting begynder at falde fra hinanden, hvis din arkitektur ikke var bygget til den fra bunden af.

Denne guide går gennem den arkitektoniske plan for at opbygge en skalerbar, fejltolerant og udvideligt push-meddelelsessystem. Det vil fokusere på levering på tværs af platform (APNS, FCM, WebPush), bekymringer på systemniveau som kø og forsøg, samt hvordan man indstiller til ydeevne under høj belastning.

Målet er at udstyre dig med den mentale model og designmønstre, der er nødvendige for at opbygge et system, der ikke spænder under pres – og kan udvikle sig med dine produktbehov.

Systemkrav

Funktionelle krav

I kernen skal push-meddelelsessystemet levere beskeder til slutbrugerenheder. Men “levering” er ikke nok. Her er hvad systemet faktisk skal gøre:

- Levering af flere platform: Støtte Apple Push Notifikation Service (APNS), Firebase Cloud Messaging (FCM) og Web Push-protokol (WPP).

- Enhedsregistrering og styring: Butik enhedstokener, der er kortlagt til brugere, platforme og applikationer.

- Målretning af kapaciteter: Send meddelelser til specifikke brugere, enhedsgrupper, brugersegmenter eller alle brugere (udsendelse).

- Planlægning: Lad meddelelser sendes øjeblikkeligt eller på et fremtidig planlagt tidspunkt.

- Bedømmelsesbegrænsning: Gasmeddelelser baseret på platformbegrænsninger eller interne forretningsregler.

- RETTY LOGIC: RETRE AUTOMATISK FABRING FÆLLESE FORSÆTNINGER med eksponentiel backoff eller brugerdefinerede retry -politikker.

- Brugerpræferencer: Respekter opt-in/opt-out-status, stille timer eller specifikke kanaltyper (f.eks. Salgsfremmende vs. transaktions).

- Revision og analyse: Spor levering succes/fiasko, åbnes (når det er muligt) og diagnostiske metadata til fejlfinding.

Ikke-funktionelle krav

Dette er rygradene bekymringer-mister disse, og din platform vil kollapse under brug af den virkelige verden.

- Skalerbarhed: Systemet skal håndtere pigge af millioner af meddelelser pr. Minut.

- Tilgængelighed: Målretning af 99,99% oppetid, især for kritiske stier som enhedsregistrering og leveringsrørledninger.

- Latens: Under-sekundbehandling til transaktionel (f.eks. OTP, sikkerhedsadvarsler); Tolerable Delay (5-15S) for batchmarkedsføringsmeddelelser.

- Holdbarhed: Meddelelser må ikke gå tabt i tilfælde af node eller servicesvigt.

- Sikkerhed: End-to-End-beskyttelse af brugerdata, godkendelse til 3.-party-tjenester, kryptering af nyttelast i transit og i hvile.

- Multi-tenance: Evne til at understøtte flere applikationer/kunder med isolerede data og leveringsrørledninger.

Begrænsninger og antagelser

Definition af grænser er kritisk for at reducere arkitektonisk tvetydighed.

- Antag platform Push -udbydere (APNS, FCM, Webpush) er eksterne og fungerer som sorte kasser med offentliggjorte SLA’er.

- Meddelelses nyttelast er små (2 kb – 4 kb), med de fleste logik håndteret på klientsiden.

- Der er en eksisterende brugeridentitetsplatform, der afslører kortlægning af enheder til brugere og brugerpræferencer.

- Systemet garanterer ikke levering – når det hænder til APNS/FCM, er ansvaret deres.

- Systemet kører i et sky-indfødte miljø (Kubernetes eller administrerede containere, autoskalering osv.).

Kernebrugssag og leveringslandskab

Før du dykker ned i arkitektur, er det vigtigt at afklare, hvad dette system løser for – fordi “push -meddelelser” betyder forskellige ting i forskellige forretningsmæssige sammenhænge. Dette afsnit udforsker det virkelige verdens operationelle landskab, der bruger systemet, og hvordan skalaen påvirker designvalg.

Primær forretningsbrugssag

Lad os definere en typisk brug med høj påvirkning: En storskala B2C-e-handelsplatform ønsker at sende realtids-push-meddelelser på tværs af mobile og web for at drive brugerengagement, advare brugere af ordrestatusopdateringer eller udløse adfærdsbaserede påmindelser (f.eks. Forladte indkøbskurv). Der er også sager om interne brug – ops -alarmer, svigssystemer og partnerintegrationer. Men kernedriveren er brugercentrisk meddelelse med høj kapacitet med forskellige kritiske niveauer.

Brugere og meddelelseskanaler

Slutbrugere af systemet er ikke kun kunder, der modtager push -meddelelserne. Der er flere skuespillere:

- Marketingfolk: Kør store kampagner, tidsplan og segmentbrugerkohorter.

- Produkthold: Trigger-kontekstuelle meddelelser fra appadfærd (milepæle i appen, gamification-løkker).

- Backend -systemer: Udløser automatisk transaktionsmeddelelser som OTP’er, betalingsbekræftelser eller leveringsadvarsler.

I den modtagende ende kan hver bruger have flere enhedstyper:

- Mobilapps: iOS via APNS og Android via FCM.

- Webbrowsere: Via Web Push-protokol (Vapid-baseret), typisk for brugere af desktop/bærbar computer.

- Tredjepartstjenester: I nogle tilfælde er integrationer med tredjeparts leveringskanaler som WhatsApp eller in-app-meddelelsesoverlejringer involveret-men ud af omfanget af dette system.

Volumen og skalaovervejelser

Her er hvad systemet forventes at håndtere i den virkelige verdens skala:

- 100 m+ registrerede enheder På tværs af platforme med 5-10% aktive på daglig basis.

- Transaktionsbegivenheder: 3–5 m meddelelser/dag, med hård latens SLA’er (f.eks. OTP inden for 3 sekunder).

- Kampagner: Burst sender til 10-20 millioner brugere på under 5 minutter, ofte udløst via instrumentbræt eller backend jobkøer.

- Peak samtidighed: 200k+ meddelelser/minut under begivenheder med sort fredag-type eller under virale pigge.

Dette handler ikke om at sende en besked til en bruger – det handler om at sende millioner af skræddersyede meddelelser på tværs af tusinder af noder, med pålidelighed, forsøg og minimal forsinkelse. Designet skal rumme denne form for dynamisk arbejdsbyrde, hvilket betyder statsløse kernetjenester, distribuerede køer og vandret skalerbarhed på hvert niveau.

Systemarkitektur på højt niveau

Arkitekturen for et skalerbart push -meddelelsessystem drejer sig om tre principper: afkobling, parallelisme, og platformspecifik levering. I skala falder monolitiske design fra hinanden-så denne arkitektur omfavner en mikroservicebaseret, begivenhedsdrevet tilgang, der kan vifte, gashåndtag, prøve igen og revidere milliarder af meddelelser med minimale flaskehalse.

Lad os gå gennem de centrale delsystemer, dataflow og platformspecifikke abstraktioner, der får det hele til at fungere.

Komponentoversigt

Arkitekturen er opdelt i følgende logiske komponenter:

- Indtagelse API: Modtager meddelelsesanmodninger – Batch eller transaktion – Validerer input, enqueues -meddelelser i rørledningen.

- Routing Engine: Slå op på enheder, opdeler meddelelser pr. Enhedsplatformpar, indfører dem i respektive køer.

- Platform leveringsarbejdere: Dedikerede mikroservices til APN’er, FCM og Webpush. Disse håndterer forbindelsesstyring, forsøg, batching og hastighedsbegrænsende.

- Meddelelseskø (mæglerlag): High-Throughput Broker (f.eks. Kafka, RabbitMQ eller Google Pub/Sub) til afkobling af producenter fra leveringslogik.

- Enhedsregistreringstjeneste: Butikker enhedsmetadata, brugerkortlægning, token gyldighed, platformtype og opt-in status.

- Præference og regler motor: Evaluerer brugeranmeldelsesindstillinger, undertrykkelsesregler (stille timer, frekvenshætter) eller kanalspecifikke tilsidesættelser.

- Scheduler: For forsinket eller tidsvinduge-baseret meddelelseslevering.

- Overvågning og feedback loop: Fanger leveringskvitteringer på platformniveau, fejl og analyse; Håndterer APNS -feedback, FCM -afinstallation osv.

Arkitekturdiagram på højt niveau

+------------------+

| Ingestion API |

+--------+---------+

|

v

+---------------------+

| Routing Engine |

+--------+------------+

|

v

+---------------------+

| Message Broker |

| (Kafka / RabbitMQ) |

+--------+------------+

|

+--------------------------+--------------------------+

| | |

v v v

+-------------+ +--------------+ +----------------+

| APNs Worker | | FCM Worker | | WebPush Worker |

+------+------+ +------+-------+ +--------+-------+

| | |

v v v

+------------------+ +---------------------+ +------------------------+

| Apple Push Notif | | Firebase Cloud Msg | | Web Push Service (VAPID)|

| Service (APNs) | | (FCM) | | |

+------------------+ +---------------------+ +------------------------+

+------------------------+ +--------------------------+

| Device Registry Svc | <------> | User Preferences Engine |

+------------------------+ +--------------------------+

+---------------------------+

| Scheduler / Campaign Svc |

+---------------------------+

+---------------------------+

| Monitoring / Analytics |

| (Logs, Receipts, Metrics) |

+---------------------------+

Nøglearkitektoniske mønstre

- Begivenhedsdrevet arkitektur: Meddelelsesstrømmen er fuldt asynkron. Producenter (API’er, interne systemer) afkobles fra levering ved hjælp af pub/sub- eller messaging -køer.

- Platformspecifik abstraktion: Arbejdstagere er skræddersyet pr. Platform. Hver administrerer sine egne rentegrænser, nyttelastformater, forsøg og API -autoritet.

- Modtryk støtte: Meddelelsesmæglere skal håndtere overspændinger uden at droppe data. Buffering, døde-bogstaver køer og autoscering af forbruger er indbygget.

- Idempotens og deduplikation: Meddelelser skal bære unikke ID’er for at undgå problemer med dobbelt-send, især på forsøg.

- Fejlisolering: En platformafbrydelse (f.eks. APNS) bør ikke kaskade- og stallmeddelelser til FCM/Webpush. Hver arbejderpool er isoleret og fejltolerant.

Denne arkitektur kan vandret skala hver komponent uafhængigt – flere arbejdstagere for APN’er under iOS -kampagnens bursts eller flere routingknudepunkter under indtagelsesspidser. Hvert niveau kan overvåges, kastes eller genstartes uden at påvirke det fulde system.

Brug for hjælp til arkitektering i skala?

Planlægger du at rulle ud push-meddelelser på tværs af millioner af brugere, men usikker på, hvordan man skalere levering eller administrere tværplatform-quirks?

Vi kan hjælpe dig med at designe et kamptestet push-system, der er skræddersyet til dit produkts vækst- og ydeevnebehov.

Databasedesign & Token Ledelse

Push notifikationssystems Live eller Die ved deres evne til at administrere millioner af enhedstokener, brugerpræferencer og meddelelsesstater effektivt. Dette afsnit bryder ned, hvordan man designer et databaseskema, der skalerer vandret, opretholder leveringskonsistensen og understøtter realtidsmålretning og filtrering.

Kerneedataenheder

Som minimum kræves følgende enheder:

- Brugere: Logisk brugeridentitet (UID), bundet til en eller mange enheder.

- Enheder: Platformspecifikke enheder med tokens, appversion, sidst set osv.

- Præferencer: Brugerspecifikke opt-in/opt-out-flag, kanalindstillinger, stille timer osv.

- Beskeder: Historie om sendte meddelelser, deres leveringsstatus og metadata til fejlfinding/revision.

Enhed Relationship Model (ERD)

Sådan forholder enhederne sig på et højt niveau:

+--------+ 1 +---------+ M +-----------+ | Users |---------------<| Devices |--------------->| Preferences| +--------+ +---------+ +-----------+ | | | | 1 | | | M | v v +-------------+ +--------------+ | Notifications| | Delivery Logs| +-------------+ +--------------+

Tabelskemaer (forenklet)

users (

id UUID PRIMARY KEY,

email TEXT UNIQUE NOT NULL,

created_at TIMESTAMP DEFAULT NOW()

)

-- Index: unique email lookup

-- CREATE UNIQUE INDEX idx_users_email ON users(email);

devices (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

platform ENUM('ios', 'android', 'web') NOT NULL,

token TEXT UNIQUE NOT NULL,

app_version TEXT,

last_active TIMESTAMP,

is_active BOOLEAN DEFAULT true,

created_at TIMESTAMP DEFAULT NOW()

)

-- Indexes:

-- CREATE INDEX idx_devices_user_platform ON devices(user_id, platform);

-- CREATE UNIQUE INDEX idx_devices_token ON devices(token);

preferences (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

channel ENUM('transactional', 'marketing') NOT NULL,

enabled BOOLEAN DEFAULT true,

quiet_hours JSONB,

updated_at TIMESTAMP DEFAULT NOW()

)

-- Index: preference lookup

-- CREATE UNIQUE INDEX idx_prefs_user_channel ON preferences(user_id, channel);

notifications (

id UUID PRIMARY KEY,

title TEXT,

body TEXT,

payload JSONB,

scheduled_at TIMESTAMP,

priority ENUM('high', 'normal', 'low') DEFAULT 'normal',

created_by TEXT,

created_at TIMESTAMP DEFAULT NOW()

)

delivery_logs (

id UUID PRIMARY KEY,

notification_id UUID NOT NULL REFERENCES notifications(id) ON DELETE CASCADE,

device_id UUID NOT NULL REFERENCES devices(id) ON DELETE CASCADE,

status ENUM('pending', 'delivered', 'failed', 'dropped') DEFAULT 'pending',

attempt_count INT DEFAULT 0,

response_code TEXT,

error_message TEXT,

delivered_at TIMESTAMP

)

-- Indexes:

-- CREATE INDEX idx_logs_device_status ON delivery_logs(device_id, status);

-- CREATE INDEX idx_logs_notif_status ON delivery_logs(notification_id, status);

Prøve rækker (kun illustrerende)

users

--------------------------------------------------------------

id | email

--------------------------------------+-------------------------

5b6e...d1 | user@example.com

devices

--------------------------------------------------------------

id | user_id | platform | token | is_active

----------+----------+----------+---------------+------------

f7a9...91 | 5b6e...d1| ios | abc123token...| true

preferences

--------------------------------------------------------------

id | user_id | channel | enabled | quiet_hours

----------+----------+----------------+---------+-------------

c1f3...72 | 5b6e...d1| marketing | false | {"start":"22:00","end":"07:00"}

notifications

--------------------------------------------------------------

id | title | priority | scheduled_at

----------+----------------+----------+--------------

e93f...55 | Order Shipped! | high | 2025-04-22 13:00:00

delivery_logs

--------------------------------------------------------------

id | notification_id | device_id | status | attempt_count

----------+-----------------+-----------+------------+---------------

d95b...11 | e93f...55 | f7a9...91 | delivered | 1

Token Management bedste praksis

- De-duplicate tokens: Flere enheder kan sende det samme token (især på Android); deduplicate on registrering.

- Token udløbshåndtering: Valider med jævne mellemrum tokens via feedback -tjenester (f.eks. APNS -feedback, FCM -uregistrerede fejl) og Mark Inactive.

- Blød sletter: Brug ‘IS_AKTIVE’ flag snarere end hårde sletninger for at undgå forældreløse leveringslogfiler.

- Indeks klogt: Enheder skal indekseres på `(user_id, platform)` og `(token)` til hurtige opslag og de-dukelige.

- Undgå brugerophold ved kørsel: Opbevar alle målretningsdata (symboler, opt-ins) i hurtige adgangsbutikker som Redis eller forudgående påbudte synspunkter for højhastighedsleveringskørsler.

Multi-tenance & isolationsstrategier

Hvis der understøtter flere apps eller klienter:

- Lejersøjlestrategi: Tilføj en `Tenant_ID`-kolonne til hver tabel og håndhæver isolering på række-niveau.

- Logisk DB -isolering: Brug separate skemaer eller databaser pr. Lejer, hvis SLA og datafølsomhed kræver det.

- Skrivesti-adskillelse: Isolere transaktionsmeddelelser med høj prioritet fra bulk-/marketingkøer på DB-laget for at undgå støjende nabo-spørgsmål.

Opdeling og skala

I skala, visse tabeller (som Levering_logs) vil vokse hurtigt. Overvej:

- Tidsbaseret opdeling: Shard logfiler månedligt eller ugentligt for at undgå oppustede indekser.

- Arkivpolitik: Flyt ældre logfiler til koldopbevaring (f.eks. S3 + Athena) til revisionsadgang uden at påvirke live -ydeevnen.

- Token cache: Synkronisering af aktive enheder tokens i Redis eller DynamoDB til loops med høj kapacitet.

Redis token cache skema

Redis bruges som et læseoptimeret token-look-lag i hukommelsen. Det undgår at ramme den primære DB under meddelelsesforsendelse og understøtter konstant-tid-opslag på tværs af massive bruger/enhedssæt.

Sager for primær brug:

- Hurtig fan-out af enhedstokens pr. Bruger

- Opslag efter brugersegmenter (f.eks. Aktive iOS -enheder)

- Token Deduplication and Expiry Control

- TTL håndhævelse for inaktive eller roterede tokens

Anbefalet nøglestruktur

Key: push:user::tokens Type: Redis Set Value: token:: TTL: Optional (based on last_active)

Eksempel:

Key: push:user:5b6ed...d1:tokens

Value: {

"token:ios:abc123token...",

"token:web:def456token...",

"token:android:xyz789token..."

}

Alternativ nøgle til direkte tokenopslag

Key: push:token::

Type: Hash

Fields: {

user_id: ,

app_version: ,

last_seen: ,

is_active: true/false

}

TTL: 30 days from last_seen

Eksempel:

Key: push:token:ios:abc123token...

Value: {

user_id: "5b6ed...d1",

app_version: "6.4.1",

last_seen: "2025-04-21T18:11:45Z",

is_active: true

}

Bedste praksis

- Bulkbelastning fra DB: Cache-opvarmningsopgaver skal synkronisere aktive tokens fra den relationelle DB ved opstart eller via CDC (ændring af datafangst).

- Uvurderer på uregistrering: Når en enhed er uregistreret eller token er markeret ugyldigt af APNS/FCM, skal du slette Redis -posten.

- Hold TTL magert: Tokens, der ikke bruges i 30-60 dage, skal udløbe for at forhindre cache -oppustethed.

- Set-niveau fanout: Brug REDIS-sæt for at få alle tokens pr. Bruger og udføre meddelelsesudvalg effektivt i arbejderprocesser.

- Støtte til flere lejer: Præfiks alle nøgler med lejer-ID, hvis du fungerer i et multi-lejer-miljø.

Denne cache supplerer det vedvarende DB-lag ved at fungere som lav-latensopslagsniveau under den kritiske sendsløjfe. Det hjælper også segmentleveringsstrømme (f.eks. Kun sende til brugere med aktive iOS -symboler) uden dyre relationelle sammenføjninger eller fulde scanninger.

Brug for hjælp til at strukturere enhedsdata til skala?

Kæmper for at administrere millioner af enhedstokens, leveringslogfiler og opt-in-præferencer på tværs af mobil og web?

Vi kan hjælpe dig med at designe et robust datalag – SQL og Redis inkluderet – der holder dit push -system hurtigt, konsistent og altid klar til at levere.

Detaljeret komponentdesign

Hver del af systemet har sit eget ansvar – men den måde, de arbejder sammen, definerer, om din push -arkitektur kan skalere eller smuldre. I dette afsnit nedbryder vi kernekomponenterne lag for lag: datahåndtering, servicelogik, leveringsarbejdere og valgfri UI -kroge.

1. datalag (opbevaring, adgang og cache)

- Relationel DB: Gemmer kerneenheder (brugere, enheder, præferencer, meddelelser, leveringslogfiler).

- Redis: Tjener som et højhastighedsopslagslag til aktive tokens, nylige leverancer og realtidsundertrykkelsesregler.

- ORM eller datatilgangslag: Brug en ren abstraktion til at håndhæve validering, feltstandarder og skema -begrænsninger. Undgå at skrive rå SQL i leveringssløjfer.

- Læs Replica -brug: Rute højvolumenlæsningsforespørgsler (f.eks. Fan-out-opslag) til kopier for at forhindre skrivekonkurrence.

2. applikationslag (routing, filtrering, segmentering)

Applaget er systemets hjerne. Det ved, hvad de skal sende, til hvem, hvornår og under hvilke betingelser. Det er her forretningslogik bor.

- Indtagelse API: Håndtag indgående anmodninger fra interne tjenester (OTP, marketingværktøjer, transaktionsudløsere).

- Meddelelsesrutingstjeneste: Beslutter hvilke brugere/enheder, der skal få hvilken besked. Slutter sig til meddelelsesmetadata med Redis token sæt.

- Præference og regler motor: Håndhæver opt-in/out, kanalgrænser (f.eks. Max 2 marketing pings pr. Dag) og tidsvinduer (f.eks. Ingen beskeder kl.

- Rate controller: Gasmeddelelse Dispatch pr. Lejer pr. Platform pr. Region. Integreres med Redis -tællere eller skydevinduesalgoritmer.

3. Integrationslag (Leveringstjenester og -arbejdere)

Hver platform (APNS, FCM, Webpush) har sine quirks – så abstraher dem ikke bag en generisk grænseflade. I stedet skal du behandle dem som førsteklasses borgere med dedikerede leveringstjenester.

- APNS Worker: Bruger token-baseret godkendelse via JWT. Håndtag Push over HTTP/2. Administrerer TCP -forbindelsespool og hastighedsgrænser fra Apple.

- FCM -arbejdstager: Autoritet via servicekonti. Batches -meddelelser pr. Emne eller brugergruppe. Spor pr. Device-fejl (f.eks. Uregistreret, kvote overskredet).

- Webpush-medarbejder: Implementerer vapid, krypterer nyttelast ved hjælp af elliptisk kurve kryptografi og sender direkte til slutpoint URI’er.

- Ret igen kø: Enhver mislykket levering bliver genindet med eksponentiel backoff. DLQS (død-bogstavskøer) fanger vedvarende fiaskoer til inspektion.

4. UI-lag (valgfrit, admin-vender)

Ikke alle systemer har brug for dette, men for intern markedsføring af markedsføring eller produktteam kan et let dashboard være nyttigt.

- Kampagnekomponist: Opret og planlæg anmeldelse sprænger til brugersegmenter med WYSIWYG -værktøjer.

- Preview & målretning: Live test på testenheder eller A/B -spande før en fuld udrulning.

- Aktivitetsrevision: Dashboard i realtid, der viser, hvad der er i køen, hvad der er leveret, og hvad der mislykkedes (med fornuftkoder).

Designtips

- Opdel hver arbejdstager i statsløse mikroservices, der kan skalere vandret.

- Genbrug ikke den samme service til både levering og feedback (f.eks. APNS -kvitteringer). Isoler disse strømme for modstandsdygtighed.

- Tilføj strukturerede logning og korrelations -id’er ved hvert lag for sporbarhed.

Overvejelser om skalerbarhed

Push -meddelelsessystemer behøver ikke bare at arbejde – de er nødt til at arbejde *hurtigt *og *i skala *under uforudsigelige trafikbølger. Dette afsnit skitserer mønstre, infrastrukturstrategier og beskyttelsesforanstaltninger, der er nødvendige for at holde gennemstrømning høje og latenser lave, selv når du sender millioner af meddelelser pr. Minut.

Vandret skalering på tværs af niveauer

Hver komponent i systemet – indtagelse af API, router, arbejdere, køer – skal være vandret skalerbare. Dette muliggør uafhængig tuning af flaskehalse uden at overdrive levering af hele rørledningen.

- API Gateways / Ingress: Front API’er skal autoscale baseret på CPU/RPS. Brug hastighedsbegrænsning for at beskytte downstream -tjenester.

- Statløse arbejdere: Leveringsarbejdere og routere skal være statsløse og container. Brug Kubernetes HPA (Horisontal Pod AutoScaler) eller Fargate AutoScaling -regler baseret på kødybde, CPU eller latenstid.

- Kødybde-baseret skalering: Spor efterslæbestørrelse og gyder flere arbejdstagere, når dybden krydser tærsklen (f.eks. Kafka forsinkelse eller kaninmq -kølængde).

Sharding & Partitioning

- Shard af user_id: Opdelingsleverings arbejdsbelastning af hashed bruger -ID for at bevare lokaliteten og forhindre strid i DB eller token cache.

- Kafka -opdeling: Brug meddelelsestaster baseret på bruger- eller lejer -ID til at rute meddelelser til den rigtige forbrugergruppe Shard.

- Databaseopdeling: For store borde som

Levering_logs, brug tidsbaseret partitionering (f.eks. Månedligt) til at opretholde forespørgselshastigheden.

Fan-out ydelsesoptimeringer

Den rigtige flaskehals i systemer med høj skala er fan-out: kortlægning af en logisk meddelelse til tusinder eller millioner af enhedstokens.

- Redis Set Union: Brug REDIS til at få alle tokens til en bruger eller kohort med det samme ved hjælp af sæt operationer.

- Batching API -opkald: Gruppemeddelelser efter platform og batch-send (f.eks. FCM understøtter op til 500 tokens pr. Batchanmodning).

- Token Deduplication: Sørg for, at ingen duplikat tokens går ind i leveringskøer. Oprethold unikhed via Redis eller forbehandlingstrin.

Cache -strategi

- Tokens: Cache pr. Bruger -id. TTL opdateret ved levering eller login.

- Præferencer: Regler for cache-undertrykkelse (f.eks. Stille timer, frekvenshætter) i Redis eller hukommelseslokal butik.

- Throttling: Redis tællere (incrby + ttl) eller token spande til lejerniveau og globale hætter.

Resilience mønstre

- Skotterisolering: Separate arbejderpooler pr. Platform. En FCM -afmatning bør ikke blokere APNS -sendinger.

- Dead-bogstavskøer: Vedvarende svigtende meddelelser (f.eks. Ugyldige tokens) er aflæst og logget til inspektion uden at stoppe leveringsstrømme.

- Circuit Breakers: Stop midlertidigt tilbage for at nedstrømsudbydere, der viser høje svigthastigheder (f.eks. APNS 503S).

- Backoff -strategier: Brug eksponentiel backoff med jitter til retry -køer. Undgå stampedes under udbyderens throttling.

Gennemstrømning af benchmarks (baseline -mål)

- API -indtagelse: 2.000–10.000 RPS pr. Knudepunkt afhængigt af nyttelaststørrelse.

- Routing og fan-out: 5.000–20.000 enhedstokenopslag/sek med Redis + -partitionering.

- Leveringsarbejder gennemstrømning:

- APNS: ~ 5.000–10.000 skubber/min pr. Forbindelse (HTTP/2 multiplexed)

- FCM: ~ 12.000/min med batchanmodninger

- Webpush: ~ 2.000/min (Single Endpoint Sends)

Brug for hjælp til at lave din push -pipeline -skudsikker?

Bygning til skala er mere end bare autoscaling bælge. Fra Kafka-tuning til fan-out optimering og afbrydere kan vi hjælpe dig med at designe en push-infrastruktur, der ikke blinker-selv på lanceringsdagen.

Sikkerhedsarkitektur

Push notifikationssystems interface med følsomme brugerdata, cloud -messaging -platforme og interne tjenester. Hvis sikkerhed ikke bages i hvert lag – fra token -opbevaring til API -interaktioner – opretter du op til lækage af privatlivets fred, misbrugsvektorer og overholdelsesfejl. Dette afsnit dækker de vigtige sikkerhedsdesignprincipper og -praksis for at hærde dit system ende til ende.

1. godkendelse og autorisation

- Intern adgangskontrol: Alle interne API’er (indtagelse, planlægning, routing) skal beskyttes med kortvarige JWT’er eller gensidige TLS-især hvis der er tilgængelige på tværs af tjenester eller miljøer.

- API Gateway -politikker: Brug gateway-niveau IAM eller RBAC til at begrænse hvilke tjenester eller brugere, der kan indsende forskellige typer meddelelser (f.eks. Transaktionsmæssig vs. marketing).

- Lejerseparation: Hvis du understøtter multi-lejersystemer, skal du håndhæve streng lejebaseret isolering i hver forespørgsel, rute og meddelelsesafsendelsesflow.

2. platformoplysning

Tredjepartsintegrationer med APN’er og FCM kræver hemmeligheder, der skal håndteres med omhu.

- Butiknøgler i en hemmelig leder: Brug værktøjer som AWS Secrets Manager, Hashicorp Vault eller GCP Secret Manager til at gemme APNS -nøgler og FCM -legitimationsoplysninger.

- Roter legitimationsoplysninger med jævne mellemrum: Byg automatisering til at rotere service -legitimationsoplysninger mindst kvartalsvis.

- Begræns nøgleomfang: Brug servicekonti med de mindst krævede privilegier – ikke mere, ikke mindre.

3. nyttelastsikkerhed

- Medtag ikke PII i push -nyttelast: Nyttelast er ofte synlige på OS -niveau (især Android). Medtag aldrig navne, e -mail -adresser eller følsomme symboler.

- Krypter i hvile og i transit: Alle data i databasen og Redis skal krypteres ved hjælp af AES-256 eller platformspecifik AT-hvilekryptering.

- Web Push Pushlast Cryption: Vapid-baseret webpush kræver elliptisk kurvekryptering (NIST P-256); Dette skal håndteres korrekt for at undgå tavse leveringsfejl.

4. Beskyttelse af misbrug og sats

Venstre ikke -markeret, et push -system kan våben – enten til spam -brugere eller overbelaste leveringsinfrastruktur.

- Per-service rentegrænser: Brug Redis-tællere eller lækkende-spucket-algoritmer til at håndhæve Per-API og per-lejerhastighedshætter.

- Kvotehåndhævelse: Daglige meddelelsesgrænser pr. Bruger eller segment (især til markedsføring) skal håndhæves ved routinglaget.

- Auditstier på autorniveau: Alle anmodninger om at sende meddelelser skal være revideret med servicenavn, brugeridentitet, IP og meddelelsesmetadata.

5. Hemmeligheder og legitimationshygiejne

- Brug isolering på miljøniveau: Del aldrig dev, iscenesættelse og prod -legitimationsoplysninger for push -tjenester.

- Deaktiver Plaintext -logfiler: Undgå at logge tokens, legitimationsoplysninger eller skubbe nyttelast med følsomme metadata i logfiler. Mask alt, hvad der ikke er nødvendigt til fejlsøgning.

- Overvågning for misbrug: Alert, hvis brug spidser uden for forventede mønstre-især sendinger med høj volumen fra ikke-produktkonti eller pludselige FCM-fejl.

6. Beskyttelse af klientsiden (minimal, men værd at nævne)

- App-niveau token rotation: Sørg for, at din mobile SDK opdaterer tokens med jævne mellemrum og uregister dem på logout eller afinstallerer.

- SSL -fastgørelse (valgfrit): Hvis appen opretter forbindelse til din backend direkte for at registrere dig for push, kan du overveje at fastgøre for at forhindre MITM -angreb.

Udvidelighed og vedligeholdelighed

Et skalerbart push-system er ikke en engangsbygning-det skal udvikle sig med ændrede forretningsbehov, platformopdateringer og brugsmønstre. Arkitekturen skal være modulopbygget, let at udvide og sikkert at opretholde uden at indføre regressioner. Dette afsnit skitserer, hvordan du strukturerer din push-infrastruktur til langvarig udvikling og udvikler-fornuft.

1. plugin-venlig arkitektur

En ren adskillelse mellem kerne logik og leveringsspecifik logik muliggør hurtigere iteration uden at destabilisere produktionsstrømme.

- Leveringsarbejdere som plugins: Indkapslet APNS, FCM og WebPush -logik i fristående moduler med en delt leveringsgrænseflade (f.eks. `Send (token, nyttelast, config)`).

- Meddelelsestransformatorer: Implementere transformationskroge pr. Platform (f.eks. Bruger APNS `Alert ‘, FCM bruger’ anmeldelse ‘ +’ data ‘).

- Kroge til brugerdefineret logik:

Tillad for-send og post-send-kroge i routinglaget for lejespecifikke tilsidesættelser, f.eks. Brugerdefineret throttling eller A/B-logik.

2. rent kodepraksis

Push-kodebaser har en tendens til at blive dumping af platformspecifikke hacks, medmindre det er strengt opretholdt.

- Strenge interface -kontrakter: Brug klare grænseflader til leveringsmoduler og meddelelsesdefinitioner (f.eks. ‘MessagePayload’, ‘DeliveryContext’).

- Central Konfig Ledelse: Alle satsgrænser, forsøgspolitikker og platformoplysninger skal defineres eksternt i konfigurationsfiler eller hemmelighedsledere.

- Servicegrænser: Undgå at koble routinglogik med leveringslogik. Behandl hver som en uafhængigt implementerbar mikroservice.

3. Funktionsflag og versionering

Støtte iterativ funktionsudvikling og bagudkompatibilitet gennem streng versionering.

- Versioned meddelelsesformater: Definer meddelelsesskemaer med versionering (`V1`,` V2 ‘osv.) Og understøtt opgraderinger parallelt uden at bryde ældre formater.

- Funktionsflag til nye strømme: Rul ny leveringslogik bag flag pr. Lejer eller miljø for at minimere eksplosionsradius.

- Soft-afskrivningsmodel: Mark Legacy API’er og meddelelsesstrukturer til planlagt fjernelse; Tilføj logning, når det bruges.

4. Test og valideringslag

En brudt nyttelast kan kaskade til leveringsfejl. Beskyttelse af hver ny udgivelse med stærk validering.

- Skema validering: Brug JSON -skema eller Protobuf -validering, før du enqueueing af meddelelser til afsendelse.

- Kontrakttest: Definer forventninger til platformmoduler ved hjælp af PACT eller lignende værktøjer til at forhindre integrationsdrift.

- Sandkassetilstand: Giv en tør-drevet eller testtilstand til interne tjenester til at simulere skub uden at ramme live endpoint.

5. Anti-mønster til vedligeholdelighed for at undgå

- Hardcoding platformspecifik opførsel: ALTID abstrakt platformlogik i moduler eller plugins.

- Blanding af lejerlogik med global logik: Brug scoped-tjenester eller forhold på ruteniveau-tilsidesætter ikke lejer.

- Mangel på observerbarhed i nye strømme: Nye ruter eller moduler skal omfatte strukturerede logfiler, målinger og fejlhåndtering fra første dag.

Præstationsoptimering

At skubbe millioner af meddelelser handler ikke kun om systemdesign – det handler også om, hvor effektivt hver komponent udføres under pres. Performance Tuning kan reducere latenstid, forbedre gennemstrømningen og forhindre nedstrøms fejl. Dette afsnit fokuserer på, hvordan du optimerer din push -rørledning ved data-, behandlings- og leveringslag.

1. Databaseforespørgsel

- Målrettede indekser: Sørg for indekser på `token`,` user_id` og `Notification_ID` i deres respektive tabeller. Sammensatte indekser hjælper med fan-out-læsninger (f.eks. `Device_ID, status ‘).

- Forespørgsel efter segment -ID, ikke rå brugerfiltre: Undgå komplekse sammenføjningsforespørgsler under send-tid. Precompute -segmenter og cache -bruger -id’er eller symboler i Redis.

- Forbindelsespoolstyring: Brug forbindelsespooling (f.eks. PGBouncer) for at undgå spiky anmoder om flaskehalse under løb med høj volumen.

2. Token-fan-out-effektivitet

- Batch læser fra Redis: Når du henter tokens pr. Bruger eller pr. Segment, skal du altid bruge `smembers` +` mget` i rørledninger.

- Bulk leveringssløjfer: Proces i batches (f.eks. 500–1.000 tokens pr. Iteration) for at undgå netværk over hovedet.

- Tilmeldelsesskabelon Cache: Cache -gengivne nyttelast (titel/krop/metadata) ved udsendelse til lignende enhedsgrupper.

3. async -behandling og -arbejderindstilling

- Besked Prepetch: Brug meddelelser om meddelelser (f.eks. Kafka `Fetch.min.bytes`, Rabbitmq` prefetch_count`) for at reducere inaktiv tid i leveringsarbejdere.

- Leveringsbatching: FCM og Webpush tillader en vis grad af batching-brug dette, når du sender ikke-personaliserede kampagner.

- Arbejderpooling pr. Region: Kør isolerede arbejderpooler (eller POD’er) pr. Geografisk region for at minimere latenstid på tværs af region og reducere udgangsomkostninger til sky.

4. Rate Begrænsende og flowkontrol

- Skydningsvindue tællere: Brug Redis Lua-scripts til at implementere hætter på platformniveau (f.eks. Max 100K/sek pr. Platform eller lejer).

- Kø throttling: Dynamisk bremse meddelelseslæsning af hastigheder fra mægleren, når fejlhastigheder steg (f.eks. APNS 429s eller FCM kvotefejl).

- Backoff -kontrol: På forsøg, skal du bruge jitteret eksponentiel backoff for at forhindre, at tordnende besætninger i mislykkede leverancer.

5. Frontend-gengivelsesydelse (kun web push)

- Minimering af nyttelast: WebPush -meddelelser skal være kompakte – strip ekstra metadata, hold til ~ 2 kb eller mindre for hurtigste gengivelse.

- On-Click routing: Brug forespørgselsparametre eller dybe links i webpush `click_action` for at køre hurtigere in-app- eller browseroplevelser.

- Lazy Render Berigelse: Hvor det er muligt, skal du vise minimalt anmeldelsesindhold og indlæse fulde detaljer, når brugeren klikker.

6. Overvågning og feedback -loopoptimering

- Spor latency percentiler: Overvåg ikke bare den gennemsnitlige leveringstid. Spor P90, P99 for at fange langhale-levering langsomhed.

- Feedbackfiltrering: Indtagelse af kun kritisk leveringsfeedback (token udløbet, enhed, der ikke kan nås) i stedet for alt, for at reducere analyselasten.

- Metrics aggregering: Brug værktøjer som Prometheus med kardinalitetsbevidst etiketter for at undgå metrisk eksplosion under højt volumen.

Teststrategi

Et system, der skubber til millioner af enheder, kan ikke stole på manuelle QA eller isolerede tests. Levering er asynkron, tredjepartsafhængig og realtid-hvilket betyder, at test skal være lagdelt, automatiseret og fiasko-resilient. Dette afsnit dækker, hvordan man nærmer sig testning i alle faser: lokal udvikling, CI -rørledninger og produktionshærdning.

1. enhedstest

Enhedstests sikrer, at intern logik opfører sig korrekt på tværs af routing, tokenopløsning og generering af nyttelast.

- Test routing logik: Valider brugermålretning af filtre, præferencehåndhævelse og platformopdeling.

- Mock token sæt: Simulere Redis/DB-svar med falske token-kortlægninger for at teste fan-out logik.

- Skema validering: Sørg for nyttelast i overensstemmelse med platformskemaer-alarm/meddelelsesstruktur, platformspecifikke felter osv.

2. Integrationstest

- I-hukommelsesmeddelelseskøer: Kør Kafka/RabbitMQ lokalt (eller brug testcontainere) til at simulere fuld producent-til-forbruger flow.

- Falske leveringsadaptere: Mock APNS, FCM og Webpush med lokale slutpunkter, der simulerer sager om succes/fiasko, herunder throttling eller uregistrerede enheder.

- End-to-end leveringsstrøm: Hævde, at en meddelelse, der er indsendt til indtagelses -API, med succes når den hånede leveringsadapter via kø, reglermotor og arbejdertjenester.

3. Kontrakttest

Kontrakttest validerer, at platformleveringsmoduler ikke går i stykker på grund af eksterne API eller meddelelsesformatændringer.

- Brug pagt eller lignende værktøj: Definer kontraktforventninger for hvert leveringsmodul (APNS, FCM, WebPush).

- Versionerede skemaer: Hold meddelelsesformater, der er versioneret, og verificer bagudkompatibilitet på ændringer.

4. belastning og stresstest

Push-systemer skal holde op under mængderne i den virkelige verden. Lastetest hjælper med at validere køens ydelse, Redis hits og DB -strid.

- Simulere kampagner: Injicer 10m+ mock -meddelelser i køen for at observere arbejdstagerskalering, fejlhastigheder og meddelelsesforsinkelse.

- Spike og Soak Tests: Valider, hvordan systemet håndterer korte bursts (100k/min) vs. langvarig stabilt volumen (10k/sek i timevis).

- Isoler langsomme tjenester: Overvåg hvilke komponenter (f.eks. Routing, DB skriver, token cache) bremser under volumen.

5. CI -rørledningsdækning

- Test hver push -sti: Inkluder leveringslogik, tilbagefaldsforsøg og håndtering af fiasko som en del af automatiserede CI -kørsler.

- Brug syntetiske tokens: Generer dummy APNS/FCM -tokens til testlast (brug af rigtige i CI).

- Lint skemaer: Auto-validering Alle nyttelast mod platformspecifikation før fusion ved hjælp af JSON-skema eller Protobuf-kontroller.

6. Chaos & Fault Injektion (Avanceret)

For hold, der opererer i massiv skala, skal du introducere kontrolleret kaos for at fange kantssager, før brugerne gør det.

- Drop levering anerkendelser: Simulere netværksforsinkelser eller tab mellem arbejdstager og push -udbyder.

- Injicer dårlige nyttelast: Korrupte felter eller overtræder skemakontrakter for at bekræfte systemfangst og isolerer problemet.

- Indtagelse af gashåndtering: Forsinkelse af leveringskvitteringer for at sikre, at systemet ikke blokerer eller går ned på grund af manglende statusopdateringer.

DevOps & CI/CD

Push-meddelelsessystemer spænder over flere tjenester, køer, databaser og tredjepartsintegrationer. Denne kompleksitet kræver en automatiseret, pålidelig DevOps -rørledning, der kan opbygge, teste, implementere og rollback med selvtillid. Dette afsnit dækker værktøj og praksis, der er nødvendig for at holde din leveringsrørledning hurtig, sikker og observerbar.

1. CI/CD -rørledningsdesign

- CI -praktikpladser: Fødsel → Enhedstest → Kontrakttest → Integrationstest → Skema -validering → Docker Build

- CD -stadier: Canary Deployment → Sundhedskontrol → Metrics Gate → Full Rollout

- Forudsætningsskema diff: Auto-check-databasemigrationer for kompatibilitet og potentielle nedetidsproblemer (f.eks. Tilføjelse af ikke-nul-kolonner uden standarder).

2. installationsstrategier

- Blågrøn installation: For statsfulde tjenester som planlæggere eller indtagelse af API’er, skal du bruge blågrøn til at skifte trafik uden nedetid.

- Canary Deployment: For leveringsarbejdere og routere skal du implementere til en lille POD -undergruppe (f.eks. 5%) og observere for leveringsfejl eller platform API -fejl.

- Progressive udrulninger: Rul ud funktioner ved hjælp af config -flag (ikke kodeprene), så ændringer kan skiftes ved runtime.

3. Infrastruktur som kode (IAC)

- Brug Terraform eller Pulumi: Administrer infra på tværs af AWS/GCP til køer, DBS, Redis Clusters og VPCS.

- Dynamiske miljøer: Spin op isolerede testmiljøer på funktionsgrene for at teste push strømme ende til ende uden forurenende iscenesættelse.

- Hemmeligheder automatisering: Butik Push Service -legitimationsoplysninger i hemmelige ledere og injicer i bælg via forseglede hemmeligheder eller sidevogne.

4. Gitops og konfigurationsstyring

- Versionerede konfigurationer: Opbevar rentegrænser, prøve igen politikker og lejer tilsidesætter i Git – ikke hardkodet i tjenester.

- ConfigMap-drevet opførsel: Injicer platformspecifikke indstillinger i arbejdstagere (f.eks. APNS Pool Størrelse, WebPush TTL) via Kubernetes configmaps.

- Rollback via Git Revert: Hvis en konfiguration eller flag bryder produktionen, muliggør Gitops hurtig rollback med revisionsevne.

5. Frigør validering & post-definationskontroller

- Post-deploy kroge: Trigger sundhedskontrol eller røgforsøg automatisk efter udrulning.

- Se leveringsmetrik: Overvåg leveringshastigheder, fejlkoder og køstørrelse i de 15-30 minutter efter uddybningen, før du skalerer fuldt ud.

- Fejlhurtig adfærd: Hvis leveringsfejl Spike (f.eks. Ugyldigt tokens, 403s fra FCM), Auto-Halt-implementering og meddeler on-call.

Brug for hjælp til at sende push -meddelelser med tillid?

At opbygge et robust push -system er en ting – at operere det i produktion uden frygt er en anden. Hvis du har brug for hjælp til at opsætte en CI/CD-rørledning, sikre implementeringer og rollback-sikre udgivelser til din push-stak, har vi gjort det før.

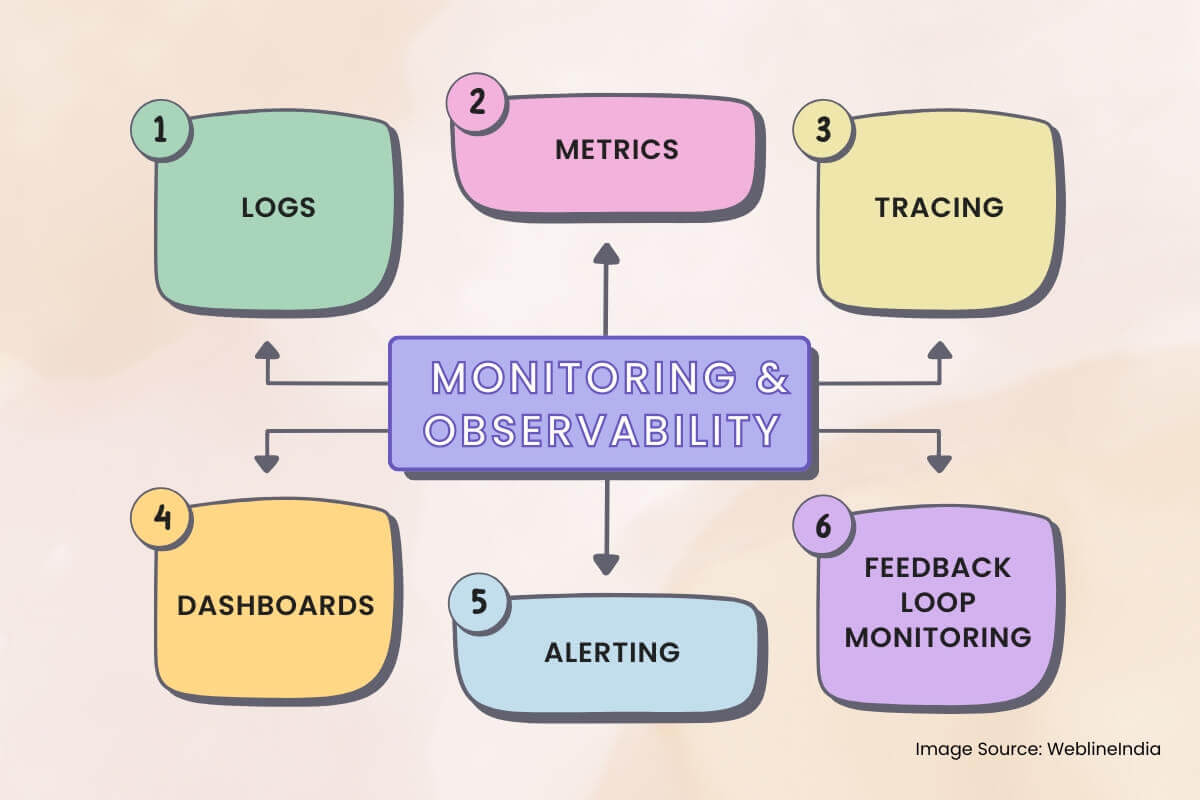

Overvågning og observerbarhed

Push-meddelelsessystemer er asynkron, distribueret og er afhængige af Black-Box tredjepartstjenester som APNS og FCM. Uden ordentlig observerbarhed går fejl ubemærket, tavse leveringsdråber forekommer, og fejlfinding bliver gætteri. Dette afsnit skitserer, hvad man skal overvåge, hvordan man sporer meddelelsesflow, og hvordan man opbygger meningsfulde alarmer.

1. logfiler

- Struktureret logning: Brug JSON -logfiler med felter som ‘Message_ID’, ‘Device_ID’, ‘Platform’, ‘Status’ og ‘Error_code’ for alle leveringsfaser.

- Korrelations -id’er: Taglogfiler fra indtagelse → Routing → Leveringsarbejdere med et delt anmodnings-ID for ende til ende sporbarhed.

- Redact følsomme felter: Mask-tokens, bruger-id’er eller indhold af nyttelast i logfiler-især på delte eller tredjepartsplatforme.

2. Metrics

Metrics fortæller dig, hvad der sker på et makroniveau. Samler dem på tværs af tjenester for at opdage platformdækkende problemer tidligt.

- Leveringsgennemstrømning: Meddelelser sendt pr. Platform pr. Minut. Bryde sammen med ‘lejer’, ‘prioritet’ og ‘message_type’ (transaktion/marketing).

- Leveringssucces/fejlhastighed: Spor ‘leveret’, ‘faldet’, ‘mislykkedes’, og ‘prøve igen’ spande – med tags til rodårsag (‘uregistreret’, ‘rate_limited’, ‘invalid_token`).

- Kølatens: Tid fra enqueue til arbejdstager afhentning og arbejdstager til platform anerkendelse.

3. Sporing

Spor er kritiske, når meddelelser lydløst forsvinder eller er forsinket. Integrer distribueret sporing i enhver intern service.

- Spor spænder: Indtagelse → Redis/Token -opslag → Præferencescheck → Kø Enqueue → Arbejdstagerforsendelse → Levering af platform.

- Linklogfiler til spor: Medtag sporings -id’er i logfiler og instrumentbrætlink (f.eks. Fra Kibana til Jaeger/Tempo).

- Prøveudtagningshastighedskontrol: Spor altid OTP’er og mislykkede beskeder; Brug probabilistisk prøveudtagning til kampagner for at reducere overhead.

4. Dashboards

Dashboards i realtid hjælper operatører og ingeniører på opkaldet med at forstå systemets sundhed med et øjeblik.

- Platform Leveringsstatus: Real-time-tællinger af sendte, mislykkede, tilbagetrækkede meddelelser pr. Platform (APNS/FCM/Webpush).

- Kødybde: Levende synlighed i routing- og leveringskøer – stigende kødybde indikerer mætning eller nedstrøms afmatning.

- Feedback Signalanalyse: Visualiser token ugyldige, hastighedsgrænser ramt og feedback -kvitteringer fra push -platforme.

5. Alerting

- Fejlpikalarmer: Hvis mislykkede meddelelser overstiger en tærskel (absolut tælling eller fejlhastighed %) inden for et glidevindue.

- Alarmer med levering af latens: Hvis P95 -latenstid overstiger SLA (f.eks. OTP> 3S, kampagne> 30s).

- Død-bogstaver køvækst: Alert Hvis DLQS starter at samle meddelelser – signaliserer en vedvarende fiasko.

6. Feedback loop overvågning

Platformer som APNS og FCM sender feedback asynkront. Disse kvitteringer har brug for deres egen rørledning.

- Feedback indtagelsesarbejdere: Forbruge og gemme uregistrerede tokenbegivenheder, leveringsfejl og rentegrænsningsrådgivere.

- Metricsekstraktion: Samlede feedback-signaler til dashboards og fejlklassefordelinger.

- Token Cleanup Automation: Trigger baggrundsjob for at deaktivere eller fjerne uaktuelle tokens baseret på platform feedback.

Afvejninger og designbeslutninger

Hvert arkitektonisk valg leveres med afvejninger. At designe et skalerbart push -meddelelsessystem betyder konstant afbalancering af latenstid kontra gennemstrømning, enkelhed vs. fleksibilitet og pålidelighed vs. omkostninger. Dette afsnit skitserer nogle af de vigtigste beslutninger, der er truffet i hele systemet og de alternativer, der blev overvejet.

1. platformspecifikke arbejdere vs. samlet leveringsgrænseflade

- Afgørelse: Separate APN’er, FCM og webpush i isolerede leveringstjenester.

- Afvejning: Mere kode og implementeringskompleksitet, men meget bedre svigtisolering, skalerbarhedsindstilling og fejlfinding pr. Platform.

- Alternativ: En generisk samlet grænseflade kunne reducere kodeduplicering, men ville kræve omfattende betinget logik og reducere observerbarheden.

2. Redis Token Cache vs. DB-kun levering

- Afgørelse: Brug Redis til aktiv tokenopslag og fan-out under meddelelsesruting.

- Afvejning: Kræver baggrundssynkroniseringer og ugyldighedslogik, men forbedrer drastisk leveringsgennemstrømning og reducerer DB -belastningen drastisk.

- Alternativ: Direkte DB-læsninger under fan-out ville forenkle arkitekturen, men ville ikke skalere på mængder på kampagniveau.

3. Kafka til beskedskø mod enklere køer

- Afgørelse: Brug Kafka eller tilsvarende distribueret log til routing- og leveringskøer.

- Afvejning: Stejlere læringskurve og infra management byrde, men muliggør høj holdbarhed, forsøg og forbrugernes skalerbarhed.

- Alternativ: RABBITMQ/SQ’er er lettere at betjene, men tilbyder mindre fleksibilitet til storstilet fan-out eller leveringsgarantier.

4. Døde bogstavskøer vs. Inline Retry Loops

- Afgørelse: Brug dedikerede DLQ’er til permanente fiaskoer og begræns på stedet for 2-3 forsøg.

- Afvejning: Lidt højere operationel overhead, men forhindrer blokering af køer og tillader async -genopretningsbehandling.

- Alternativ: Inline Retry med backoff er lettere at implementere, men risikerer overbelastning af nedstrøms systemer eller forsinkelse af meddelelser.

5. Tidsbaseret DB-opdeling mod vækst i fladt bord

- Afgørelse: Opdelingsleveringslogfiler efter måned for at kontrollere indeksstørrelse og tilbageholdelsespolitikker.

- Afvejning: Mere kompliceret forespørgsel routing og potentiel datatilgangsfragmentering.

- Alternativ: En monolitisk tabel ville være lettere at styre oprindeligt, men ville forringe ydelsen og komplicere opbevaringsoprydning.

6. Afvejninger i funktionshastighed vs. leveringsgarantier

- Afgørelse: Separat transaktion fra markedsføringsstrømme ved hvert lag – indtagelse, køer, leveringstjenester.

- Afvejning: Mere routingkompleksitet og yderligere infrastruktur, men forhindrer, at ikke-kritisk trafik ikke nedbrydes kritiske stier (f.eks. OTP’er).

- Alternativ: En samlet strømning forenkler routing, men risikerer kundepåvirkning under tunge kampagnebelastninger eller platform -throttling.

7. Kendte tekniske gældsområder

- Uaktuelt tokenoprydning: Behovsoptimering eller automatisering via indtagelse af feedback loop.

- Segment Pre-Materialization: Kører i øjeblikket just-in-time under kampagne send; skal flyttes til baggrundsjob.

- Rate begrænser skalering: Delte Redis-forekomster for hastighedskontrol kunne blive en flaskehals under kampagner i global skala.

Hvad denne arkitektur får rigtigt

At designe et skalerbart push -meddelelsessystem handler ikke kun om at sende beskeder – det handler om at levere de rigtige meddelelser, til de rigtige enheder, pålideligt og i skala. Denne arkitektur er specialbygget til at imødekomme denne udfordring head-on, afbalancere gennemstrømning, kontrol og vedligeholdelighed på tværs af et meget distribueret system.

Nøgle takeaways

- Afkoblet arkitektur: Indtagelse, routing og levering adskilles rent for modstandsdygtighed og skalerbarhed.

- Platformisolering: Hver push -service (APNS, FCM, Webpush) håndteres af en dedikeret arbejdstager, der er indstillet til sine quirks.

- Token Cache og fan-out: Redis kræfter hurtigt tokenopløsning, hvilket muliggør levering med høj kapacitet uden at hamre din primære DB.

- Data holdbarhed: Meddelelseskøer sikrer pålidelig levering, selv når platform API’er mislykkes, med DLQ’er, der fanger kanttilfælde til senere inspektion.

- Observerbarhed overalt: Sporing, målinger og strukturerede logfiler foretager debugging-leveringsrørledninger og brugerniveaustrømme praktiske i skala.

- Funktionssikker udvidelighed: Modulære komponenter, krogbaseret logik og skema-versionering giver systemet mulighed for at udvikle sig uden at bryde ældre stier.

Muligheder for fremtidig forbedring

- Finkornet throttling: Per-bruger- eller pr. Device-hastighedshætter kan yderligere reducere over-notificering og forbedre UX.

- Segmentmaterialiseringsrørledning: Offeloading-segmentering til forudbestemte baggrundsjob ville gøre kampagnelanceringer endnu hurtigere.

- Regional leveringsoptimering: Geo-lokale leveringsarbejdere kunne reducere latenstid og sky-udgangsomkostninger ved at holde platformopkald tættere på brugerens oprindelse.

Dette system fungerer ikke bare – det vil holde under pres, skalere med vækst og forblive vedligeholdelige, når brugssager udvikler sig. Det er det, der adskiller throwaway-meddelelsesskripts fra en leveringsplatform i realtid, produktionskvalitet.

Brug for hjælp til at få dit push -meddelelsessystem til dette niveau?

At designe og skalere en multi-platform push-meddelelsesarkitektur er ikke et weekendprojekt. Hvis du ønsker at bygge noget pålideligt fra første dag eller ordne det, der allerede viser revner, kan vi hjælpe med at konstruere det system, som dine brugere forventer.

Udtalelser: Hør det direkte fra vores globale kunder

Vores udviklingsprocesser leverer dynamiske løsninger til at håndtere forretningsudfordringer, optimere omkostninger og drive digital transformation. Ekspertunderstøttede løsninger forbedrer kundeloyaliteten og den digitale tilstedeværelse, og dokumenterede succeshistorier fremhæver virkelige problemløsninger gennem innovative applikationer. Vores anerkendte kunder verden over har allerede oplevet det.

Priser og anerkendelser

Mens glade kunder er vores største motivation, har branchens anerkendelse betydelig værdi. WeblineIndia har konsekvent føret inden for teknologi, med priser og anerkendelser, der bekræfter vores ekspertise.

OA500 Globale outsourcingvirksomheder 2025, af Outsource Accelerator

Top softwareudviklingsvirksomhed, af GoodFirms

Bedste fintech-produktløsningsvirksomhed – 2022, af GESIA

Tildelt som – Årets bedste appudviklingsvirksomhed i Indien 2020, af SoftwareSuggest