Når markedet er drevet af digitalisering, er den transformative kraft af Store sprogmodeller (LLM’er) ubestridelig. Fra automatisering af kundeservice til generering af kompleks kode lover LLM’er hidtil uset effektivitet og innovation. Men for mange store virksomheder, især dem, der opererer i stærkt regulerede sektorer som finans, sundhedspleje og regering, er jagten på kunstig intelligens (AI)-innovation hæmmet af en betydelig, ikke-forhandlingsbar vejblokering: databeskyttelse og sikkerhed.

Standardarkitekturen til implementering af sofistikerede LLM’er involverer ofte outsourcing til store offentlige cloud-udbydere. Selvom den er praktisk, betyder denne model i sagens natur, at følsomme virksomhedsdata, der bruges til at træne, finjustere og interagere med disse modeller, skal forlade de sikre rammer for virksomhedens interne netværk. Denne eksponering er ikke kun en risiko; det er en direkte overtrædelse af regulatoriske mandater (såsom GDPR, HIPAA og forskellige nationale love om datalokalisering) og interne overholdelsespolitikker.

Det er her, konceptet med on-premise LLM’er dukker op, ikke blot som et alternativ, men som den essentielle arkitektur for virksomheder, der er fast besluttet på at være privatliv først og ofte vælger at ansætte et dedikeret team til sikker AI-implementering. Implementering af LLM’er direkte på virksomhedsejet, intern hardware er den definitive løsning til at opnå absolut datasuverænitet, hvilket sikrer, at proprietære informationer aldrig forlader den fysiske og digitale kontrol af organisationen.

Klar til at holde virksomhedsdata private, mens du bruger AI? Tal med vores LLM-eksperter i dag.

Den store konflikt: Innovation vs. compliance

Business casen for AI er klar: konkurrencefordel, omkostningsreduktion og overlegen beslutningstagning. Virksomhedslandskabet er dog i stigende grad defineret af stram datastyring.

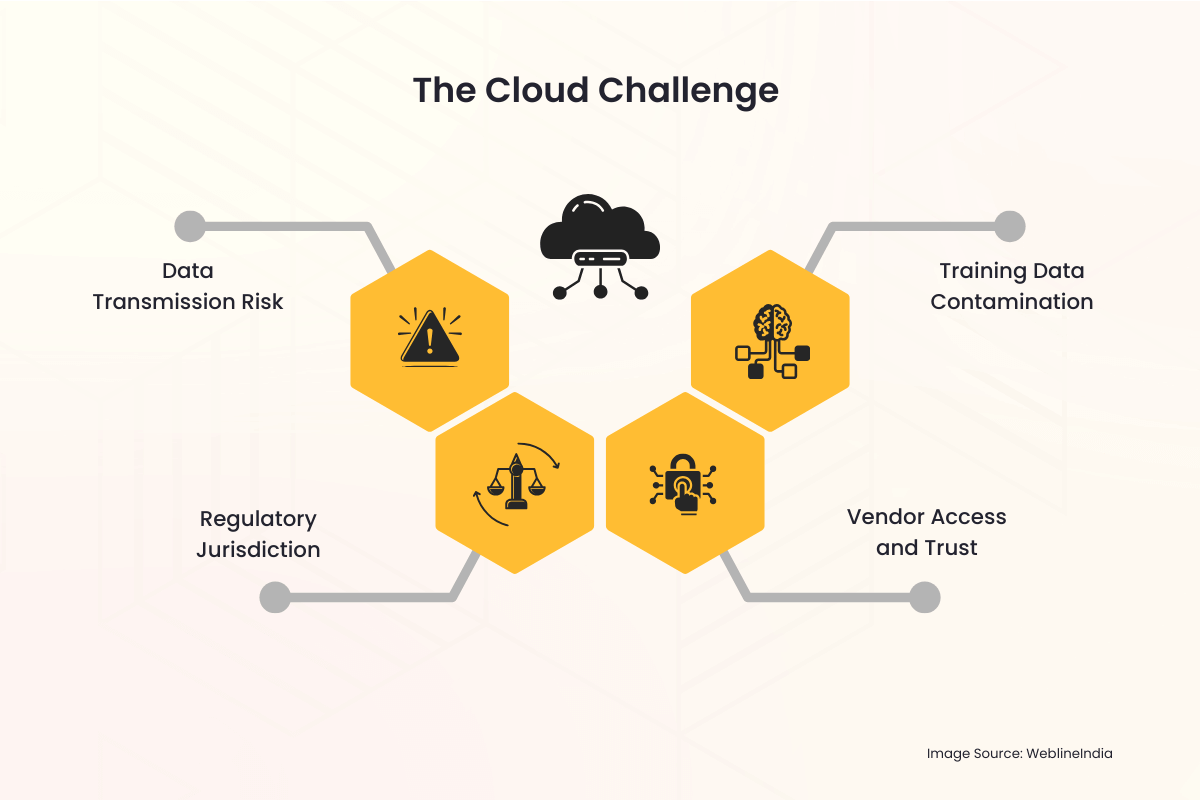

Skyudfordringen

Når en virksomhed bruger en cloud-hostet LLM-tjeneste, dukker der straks adskillige faldgruber i privatlivet op:

- Datatransmissionsrisiko: Hver forespørgsel, hvert input og det resulterende output skal krydse det offentlige internet og opholde sig midlertidigt på en tredjepartsserver. Hele denne proces er en potentiel vektor for aflytning eller uautoriseret adgang.

- Regulatorisk jurisdiktion: Data lagret i et andet land eller jurisdiktion end virksomhedens oprindelse kan udløse komplekse, ofte modstridende, internationale love. At opnå datalokalisering – kravet om, at data skal lagres og behandles inden for specifikke grænser – bliver praktisk talt umuligt med en multinational cloud-udbyder.

- Leverandøradgang og tillid: Virksomheder er tvunget til at stole på cloud-leverandørens sikkerhedsprotokoller, medarbejderadgangskontroller og opbevaringspolitikker. Dette introducerer en tredjepart i de mest følsomme dataarbejdsgange.

- Træningsdataforurening: Hvis en virksomheds proprietære data bruges til at finjustere en model, der er hostet i skyen, er der altid en risiko for, at modelvægte utilsigtet, eller endda ondsindet, kan deles eller påvirke svarene fra modeller, der bruges af andre lejere, hvilket fører til datalækage.

Disse bekymringer er ikke teoretiske. Højprofilerede hændelser med databrud og de strenge sanktioner, der håndhæves af globale reguleringsorganer, har hævet databeskyttelse fra en it-hovedpine til en kerneprioritet i bestyrelsen. For organisationer, der håndterer personligt identificerbare oplysninger (PII), beskyttede sundhedsoplysninger (PHI) eller klassificeret intellektuel ejendom (IP), er risikoprofilen for public-cloud LLM’er ofte simpelthen for høj til at acceptere.

Løsningen på stedet: Genvinde kontrol og suverænitet

Den lokale LLM-implementeringsmodel adresserer og løser direkte disse dybe privatlivsproblemer ved at placere hele AI-infrastrukturen (hardwaren, softwaren, modelvægtene og træningsdataene) under virksomhedens direkte og eksklusive fysiske og digitale kontrol.

1. Absolut datasuverænitet

Datasuverænitet betyder, at data kun er underlagt love og forvaltningsregler i det land eller den organisation, hvor de indsamles og opbevares.

- Geografisk kontrol: Med en on-premise opsætning er hardwaren fysisk placeret i virksomhedens datacenter, ofte i et specifikt land eller endda et specifikt sikkert rum. Dette opfylder i sagens natur krav til dataophold og datalokalisering, hvilket gør overholdelse af regler som EU’s GDPR eller forskellige nationale sikkerhedslove ligetil.

- Nul ekstern transmission: Al databehandling, modeltræning og inferens (forespørgsel efter modellen) sker inden for virksomhedens firewall. Følsomme prompter og proprietære interne dokumenter, der bruges af LLM, forlader aldrig det sikre netværksmiljø.

2. Forbedret sikkerhed og overholdelse

En on-premise-implementering giver sikkerhedsteamet mulighed for at anvende organisationens eksisterende, robuste sikkerhedsramme direkte på AI-systemet.

- Eksisterende sikkerhedsinfrastruktur: LLM-løsningen kan problemfrit integreres med etablerede virksomhedssikkerhedsværktøjer, herunder Intrusion Detection Systems (IDS), sofistikerede firewalls, løsninger til identitets- og adgangsstyring (IAM) og systemer til forebyggelse af datatab (DLP). Dette er ofte mere omfattende og skræddersyet end sikkerhedslagene, der tilbydes af en generisk cloud-tjeneste.

- Tilpasset adgangskontrol: Adgang til selve modellen kan kontrolleres strengt via intern virksomheds Active Directory eller andre virksomheds IAM-løsninger. Kun autoriserede medarbejdere, afdelinger eller applikationer kan interagere med modellen, og adgangslogfiler opbevares internt til revisionsformål.

- Forenklet revision: Overholdelse af lovgivningen kræver ofte detaljerede revisionsspor. At eje hele stakken giver virksomheden mulighed for at føre detaljerede logfiler over hver modelbrug, træningsopgave og administrationshandling, hvilket gør overensstemmelsestjek meget nemmere for interne og eksterne revisorer.

3. Beskyttelse af intellektuel ejendom

For virksomheder ligger den sande værdi af en LLM ikke kun i den grundlæggende model (som Llama, Mistral eller andre), men i den proprietære viden, der bruges til at finjustere den. Disse finjusteringsdata er organisationens IP.

- Isoleret træningsmiljø: Når finjustering udføres på stedet, uploades de proprietære datasæt (såsom kunderegistre, interne rapporter, patentansøgninger eller produktspecifikationer) aldrig til en tredjepart. De resulterende finjusterede modelvægte, som effektivt koder for virksomhedens viden, bibeholdes også internt, hvilket forhindrer enhver ekstern part i at få uautoriseret adgang til kerne-IP’en.

Har du brug for en kompatibel, on-premise LLM, der er skræddersyet til din branche? Lad os bygge det sikkert.

Det praktiske ved On-Premise LLM-arkitektur

Selvom privatlivsfordelene er overbevisende, kræver implementering af en lokal LLM omhyggelig planlægning og investering i den underliggende teknologi.

Hardwareudfordringen: Behovet for GPU’er

LLM’er er beregningskrævende. Nøglemuligheden for effektiv on-premise-implementering er specialiseret hardware, primært GPU’er (Graphics Processing Units).

- Inferensstyrke: For at betjene brugerforespørgsler i realtid (inferens) kræver LLM højhastighedshukommelse og parallel processorkraft leveret af GPU’er, ofte i dedikerede serverracks.

- Træning og finjustering: Træning af en model fra bunden er en massiv opgave, men finjustering (tilpasning af en eksisterende model) kan opnås på færre, kraftfulde GPU’er. Investeringen i denne hardware er en kapitaludgift (CapEx), der erstatter de løbende driftsudgifter (OpEx) til skytjenestegebyrer, hvilket giver langsigtet forudsigelighed af omkostninger.

Softwarestakken

Den fulde on-premise løsning involverer mere end bare hardware; det kræver et robust software- og orkestreringslag:

- Modelvalg: At vælge en open source, kommercielt levedygtig grundlæggende LLM (som Llama 3, Mistral osv.), der lovligt kan downloades og implementeres på privat infrastruktur er det første skridt.

- Containerisering (f.eks. Docker/Kubernetes): For at styre den komplekse implementering pakkes LLM og dets afhængigheder ofte i containere. Orkestreringsværktøjer som Kubernetes administrerer klyngen af GPU-servere, hvilket sikrer skalerbarhed og høj tilgængelighed, ligesom et privat cloudmiljø — ofte implementeret af virksomheder, der Hyr Cloud- og DevOps-ingeniører at administrere en så kompleks AI-infrastruktur.

- Internt API-lag: En applikationsprogrammeringsgrænseflade (API) er bygget i firewallen, som gør det muligt for interne applikationer (chatbots, kodningsassistenter, dataanalytikere) at sende prompter til LLM uden nogensinde at røre det offentlige internet.

Overvindelse af dataforsinkelse og styring

On-premise løsninger eliminerer dataforsinkelse og forbedrer styringen af interne datakilder.

- Intern dataadgang i realtid: LLM’er har ofte brug for at få adgang til de mest aktuelle interne data – en proces kaldet Retrieval-Augmented Generation (RAG). Ved at være on-premise har LLM lav latens, høj båndbredde adgang til interne databaser, datasøer og dokumentlagre, hvilket fører til mere nøjagtige, kontekstuelle og rettidige resultater uden behov for dataoverførsel over internettet.

- Unified Governance: Datastyringsteamet kan anvende et enkelt sæt regler på dataene, RAG-indekset og selve LLM, hvilket skaber et samlet og enklere compliance-miljø.

Strategiske fordele for privatlivsbevidste industrier

Skiftet til en on-premise-arkitektur er en strategisk beslutning, der signalerer en stærk forpligtelse til at overholde lovgivningen og kundernes tillid.

| Industri | Primær bekymring for privatlivets fred | On-Premise løsning fordel |

| Sundhedspleje (HIPAA) | Beskyttelse af PHI og patientjournaler. | Sikrer at PHI forbliver i et sikkert, dedikeret miljø; forenkler revisionslogfiler, der er nødvendige for overholdelse. |

| Finansielle tjenester (GDPR, PCI-DSS) | Kunde-PII, transaktionsdata, algoritmisk IP. | Garanterer dataophold og lokalisering; beskytter proprietære handelsalgoritmer og kundescoringsmodeller mod ekstern eksponering. |

| Regering / Forsvar | Klassificerede, meget følsomme eller statshemmelige oplysninger. | Giver mulighed for udrulning i luftgappede miljøer (netværk fysisk isoleret fra internettet), hvilket sikrer absolut sikkerhed. |

| Fremstilling / R&D | Intellektuel ejendom (IP), proprietære designs og forretningshemmeligheder. | Forhindrer lækage af unikke fremstillingsprocesser eller produktdesigndetaljer brugt under RAG eller finjustering. |

Bryd kløften med professionelle it-tjenester

Beslutningen om at gå over til en lokal LLM-arkitektur, mens den er strategisk sund for privatlivets fred, introducerer betydelig operationel kompleksitet. Det kræver specialiserede færdigheder i hardwareanskaffelse (specifikt højtydende GPU’er), opsætning af et robust, containeriseret miljø (som Kubernetes), finjustering af modeller på følsomme data og integration af LLM med eksisterende virksomhedssystemer. Det er her, en betroet IT-servicepartner bliver uvurderlig.

WeblineIndia er et anerkendt it-bureau i USA, der har specialiseret sig i at levere den omfattende ekspertise, der er nødvendig for at navigere problemfrit i denne overgang. De tilbyder end-to-end professionelle tjenester, lige fra design af den optimale on-premise hardware-stack skræddersyet til dine slutninger og træningsbehov, til styring af den sikre udrulning af open source LLM’er i din firewall.

Cloud-eksperter på WeblineIndia’s udviklingshub i Indien har stor erfaring med sikker cloud-infrastruktur og AI-implementering. Virksomheder kan hurtigt implementere deres private LLM-miljø og sikre streng overholdelse af interne overholdelsespolitikker og accelerere time-to-value uden behov for at ansætte og træne dyre, specialiserede interne AI-ingeniørteams ved at udnytte erfarne fjernudviklere. Dette partnerskab transformerer et udfordrende infrastrukturprojekt til et håndterbart, strategisk udført initiativ, fuldt dedikeret til at opretholde din absolutte datasuverænitet.

Fremtiden er privat og sikker med WeblineIndia

Begejstringen omkring LLM’er bør ikke overskygge det grundlæggende ansvar, virksomheder har for at beskytte de følsomme data, der er betroet dem. For enhver stor organisation, hvor compliance, privatliv og datasuverænitet ikke er til forhandling (hvilket vil sige de fleste succesrige virksomheder i dag), er den offentlige cloud LLM-model et grundlæggende misforhold.

Skiftet til on-premise LLM-implementering repræsenterer en klar vej fremad. Det er den nødvendige investering i hardware og ekspertise, der lukker sikkerhedshullet, opfylder de strengeste globale regulatoriske krav og i sidste ende giver virksomheden mulighed for at udnytte det fulde, transformative potentiale af kunstig intelligens uden nogensinde at gå på kompromis med dets mest værdifulde aktiv: dets data.

Kontakt WeblineIndia IT-konsulenttjenester for at undslippe skyens iboende risici og genvinde kontrollen over deres AI-stak for at innovere modigt. Du kan sikre, at kundernes tillid, overholdelsesstatus og intellektuel ejendomsret er absolut sikret inden for deres eget suveræne domæne.

Sociale Hashtags

#OnPremiseLLM #Datasoverhøjhed #VirksomhedsAI #AICompliance #PrivatlivFørst #SikkerAI #LLMSikkerhed #Virksomhedsteknologi

Vil du have fuld kontrol over din AI-stak uden datarisiko? Start med WeblineIndia.

Ofte stillede spørgsmål

Udtalelser: Hør det direkte fra vores globale kunder

Vores udviklingsprocesser leverer dynamiske løsninger til at håndtere forretningsudfordringer, optimere omkostninger og drive digital transformation. Ekspertunderstøttede løsninger forbedrer kundeloyaliteten og den digitale tilstedeværelse, og dokumenterede succeshistorier fremhæver virkelige problemløsninger gennem innovative applikationer. Vores anerkendte kunder verden over har allerede oplevet det.

Priser og anerkendelser

Mens glade kunder er vores største motivation, har branchens anerkendelse betydelig værdi. WeblineIndia har konsekvent føret inden for teknologi, med priser og anerkendelser, der bekræfter vores ekspertise.

OA500 Globale outsourcingvirksomheder 2025, af Outsource Accelerator

Top softwareudviklingsvirksomhed, af GoodFirms

Bedste fintech-produktløsningsvirksomhed – 2022, af GESIA

Tildelt som – Årets bedste appudviklingsvirksomhed i Indien 2020, af SoftwareSuggest