El surgimiento de las herramientas de inteligencia artificial (IA) ha revolucionado las industrias, mejorando la eficiencia y la automatización. Sin embargo, uno de los desafíos más persistentes en la investigación y el desarrollo de la IA es el problema de la caja negra en la IA. Este problema implica que los sistemas de IA tomen decisiones sin proporcionar explicaciones transparentes para esas decisiones. Comprender cómo este problema afecta el desarrollo de tecnologías de IA y las posibles soluciones disponibles es crucial para generar confianza en la IA y sus aplicaciones.

¿Confundido sobre la toma de decisiones de IA? ¡Deje que nuestros expertos lo ayuden a implementar la IA explicable!

El problema del cuadro negro en AI: una descripción general

En esencia, la caja negra en IA se refiere a la opacidad de los procesos de toma de decisiones dentro de muchos modelos de aprendizaje automático, particularmente modelos de aprendizaje profundo. Estos modelos pueden producir resultados precisos, pero sus trabajos internos a menudo son demasiado complejos para interpretar. El problema de la caja negra en la IA se vuelve particularmente problemática en los campos de alto riesgo como la atención médica, las finanzas y la aplicación de la ley, donde comprender por qué se tomó una decisión es fundamental.

- Las herramientas de IA como las redes neuronales profundas se destacan en el reconocimiento de patrones, pero a menudo son demasiado complicadas para que los humanos lo entiendan completamente.

- La complejidad surge porque estos modelos involucran múltiples capas de cálculos y transformaciones, lo que dificulta la rastreo de cómo los datos de entrada se convierten en decisiones de salida.

El impacto del problema de la caja negra en AI

La falta de transparencia en la toma de decisiones crea desafíos de varias maneras:

- Responsabilidad: en los casos en que los sistemas de IA toman decisiones erróneas o dañinas, es difícil determinar la causa exacta del problema, lo que complica la responsabilidad y la confianza.

- Sesgo: sin una idea de cómo funcionan los sistemas de IA, se hace más difícil identificar y corregir cualquier sesgo en el proceso de toma de decisiones del modelo.

- Preocupaciones regulatorias: a medida que AI continúa evolucionando, los reguladores enfrentan desafíos para garantizar que estas tecnologías cumplan con los estándares y leyes éticas. La falta de interpretabilidad dificulta la regulación.

Comprender la necesidad de AI explicable

Para mitigar el problema de la caja negra en la IA, los investigadores están recurriendo a la IA explicable (XAI).

AI explicable Su objetivo es proporcionar una explicación clara y comprensible de cómo llegan los sistemas de IA a sus decisiones. Esto es crucial para fomentar la confianza, garantizar la equidad y mantener la responsabilidad.

¿Luchando con la transparencia de IA? Obtenga soluciones de IA que sean claras y responsables.

¿Cómo ayuda la IA explicable?

- Transparencia: con AI explicable, los usuarios pueden acceder a las ideas sobre cómo los sistemas de IA procesan los datos y hacen predicciones.

- Confianza y adopción: como las partes interesadas pueden comprender la toma de decisiones de la IA, es más probable que confíen en las herramientas de IA para aplicaciones críticas.

- Decisiones éticas: la IA explicable promueve la toma de decisiones éticas al revelar sesgos o patrones discriminatorios en los sistemas de IA.

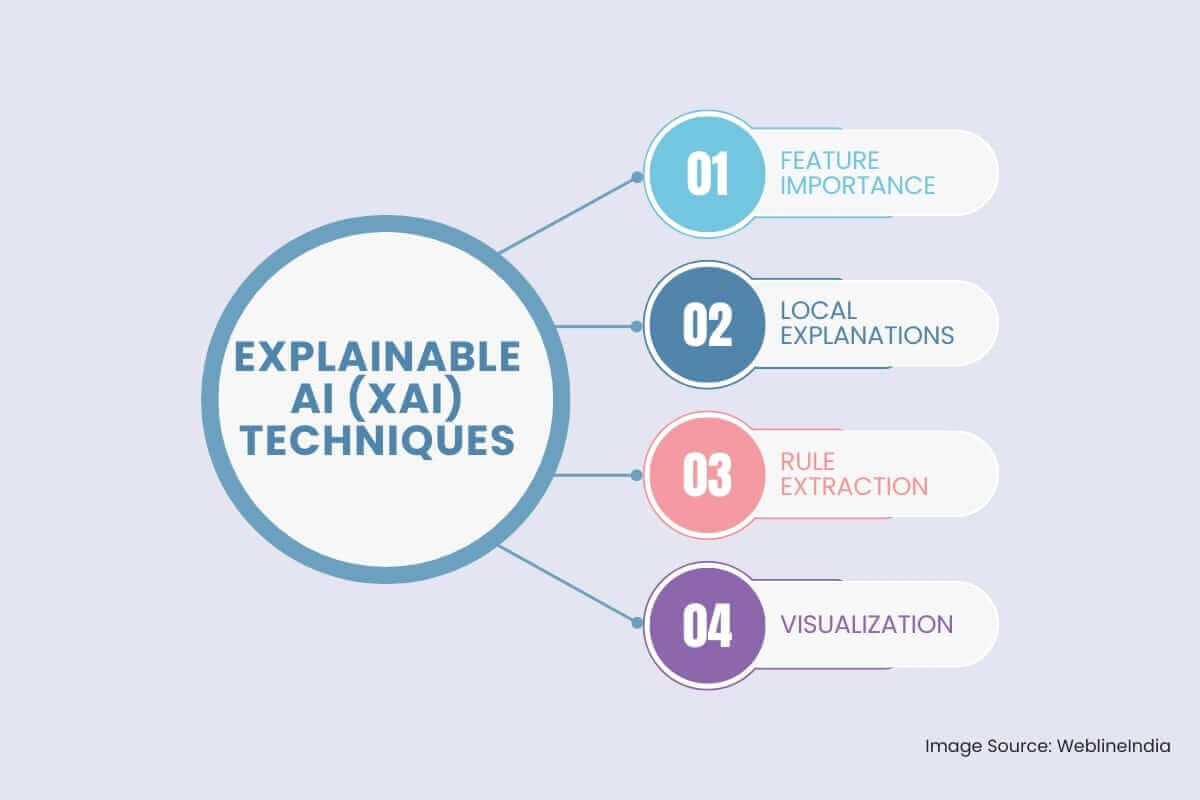

Técnicas explicables de ai (xai)

Para abordar el problema de la caja negra, ha surgido el campo de AI explicable (XAI). XAI se centra en el desarrollo de técnicas que hacen que los procesos de toma de decisiones de los modelos de IA sean más transparentes y comprensibles. Algunas técnicas de XAI clave incluyen:

- Importancia: Esta técnica tiene como objetivo identificar las características de entrada que tienen la mayor influencia en la salida del modelo.

Importancia de la permutación: este método evalúa la importancia de una característica al arrastrar aleatoriamente sus valores y observar cómo esto afecta el rendimiento del modelo.

Shap (explicaciones aditivas de Shapley): este enfoque basado en la teoría del juego proporciona una comprensión más matizada de la importancia de la característica al atribuir el resultado del modelo a las características individuales.

- Explicaciones locales: Estos métodos proporcionan explicaciones para las predicciones individuales hechas por el modelo.

Lima (explicaciones del modelo de modelo interpretable local): esta técnica se aproxima al comportamiento del modelo localmente alrededor de un punto de datos específico utilizando un modelo más simple e interpretable, como un modelo lineal o un árbol de decisión.

Anclajes: este método identifica un conjunto de condiciones (anclajes) que, si están presentes, garantizan una predicción específica con alta probabilidad.

- Extracción de reglas: Este enfoque implica extraer reglas legibles por humanos del modelo entrenado.

Inducción del árbol de decisión: esta técnica implica construir un árbol de decisión, que los humanos pueden interpretar fácilmente, para aproximar las predicciones del modelo.

Sistemas basados en reglas: estos sistemas representan explícitamente el conocimiento del modelo en forma de reglas IF-Then.

- Visualización: Visualizar el funcionamiento interno de un modelo de IA puede proporcionar información valiosa sobre su proceso de toma de decisiones.

Mapas de activación: estas visualizaciones destacan las áreas de una imagen en las que el modelo se centra al hacer una predicción.

Mecanismos de atención: estas técnicas se pueden utilizar para visualizar las partes de un texto o secuencia a las que el modelo presta atención al hacer una predicción.

Superar desafíos en el desarrollo de IA explicable

Si bien Explicable AI ofrece una solución prometedora, implementarla de manera efectiva viene con su propio conjunto de desafíos:

- La compensación entre precisión y explicación: algunas de las herramientas de IA más poderosas, como las redes neuronales profundas, pueden ofrecer una alta precisión pero a costa de ser más difícil de explicar. Equilibrar estos dos factores sigue siendo un desafío significativo.

- Complejidad de los modelos: muchas tecnologías de IA se basan en algoritmos avanzados que son inherentemente difíciles de explicar. La investigación continúa explorando cómo hacer que estos modelos complejos sean interpretables sin sacrificar su rendimiento.

- Escalabilidad: a medida que las herramientas de IA se implementan a escalas más grandes, mantener explicaciones efectivas para cada decisión tomada por el sistema puede volverse abrumadora.

El papel de las tecnologías de IA en la resolución del problema de la caja negra

Tecnologías de IA están evolucionando constantemente para crear sistemas más transparentes e interpretables. Desde desarrollar mejores algoritmos hasta mejorar las técnicas de visualización de datos, estas tecnologías están allanando el camino para soluciones al problema de la caja negra en IA.

- Modelos híbridos: la combinación de modelos explicables y de caja negra podría proporcionar un equilibrio entre el rendimiento y la transparencia. Por ejemplo, el uso de modelos más simples para la toma de decisiones mientras depende de modelos más complejos para las predicciones podría permitir tanto precisión como interpretabilidad.

- Visualización de datos: la visualización efectiva de datos puede ayudar a que los modelos de IA sean más transparentes al mostrar el proceso de toma de decisiones en un formato accesible. Las herramientas interactivas pueden permitir a los usuarios consultar a los sistemas AI para obtener más explicaciones.

Conclusión: luchar por la transparencia en la toma de decisiones de IA

El problema de la caja negra en IA presenta un obstáculo significativo para la adopción más amplia y la implementación ética de las tecnologías de IA. Si bien son poderosas, las herramientas de IA deben volverse más transparentes para garantizar que sus decisiones sean comprensibles, confiables y justas. Como Desarrollo de IA Progresos, el campo de la IA explicable continúa evolucionando, los investigadores están explorando soluciones innovadoras para superar estos desafíos, lo que permite disfrutar de los beneficios de las tecnologías de IA sin comprometer la responsabilidad o la ética.

Hashtags sociales

#AIExplicable #AIRRansparency #ProblemaDeCajaNegra #XAI #Trustinai #MachInelEarning #AprendizajeProfundo #ModelosDeIA #shap #Lime

¿Quiere hacer que la IA sea más transparente y confiable para su negocio?

Preguntas frecuentes

Testimonios: Escúchalo directamente de nuestros clientes globales

Nuestros procesos de desarrollo ofrecen soluciones dinámicas para afrontar retos empresariales, optimizar costos e impulsar la transformación digital. Soluciones respaldadas por expertos mejoran la retención de clientes y la presencia en línea, y casos de éxito comprobados muestran la resolución de problemas reales mediante aplicaciones innovadoras. Nuestros estimados clientes en todo el mundo ya lo han experimentado.

Premios y Reconocimientos

Aunque los clientes satisfechos son nuestra mayor motivación, el reconocimiento de la industria tiene un valor significativo. WeblineIndia ha liderado constantemente en tecnología, con premios y galardones que reafirman nuestra excelencia.

OA500 Empresas globales de externalización 2025, por Outsource Accelerator

Mejor empresa de desarrollo de software, por GoodFirms

Mejor empresa de soluciones de producto fintech – 2022, por GESIA

Premiada como – Mejor empresa de desarrollo de apps en India 2020, por SoftwareSuggest