עליית הכלים של בינה מלאכותית (AI) חוללה מהפכה בתעשיות, והעצמה את היעילות והאוטומציה. עם זאת, אחד האתגרים המתמשכים ביותר במחקר ופיתוח AI הוא בעיית התיבה השחורה ב- AI. סוגיה זו כוללת מערכות AI לקבל החלטות מבלי לספק הסברים שקופים לאותן החלטות. ההבנה כיצד בעיה זו משפיעה על פיתוח טכנולוגיות AI והפתרונות הפוטנציאליים הקיימים היא קריטית לבניית אמון ב- AI ויישומיה.

מבולבל לגבי קבלת החלטות AI? תן למומחים שלנו לעזור לך ליישם AI הניתן להסבר!

בעיית התיבה השחורה ב- AI: סקירה כללית

בבסיסה, התיבה השחורה ב- AI מתייחסת לאטימות תהליכי קבלת החלטות בתוך מודלים רבים של למידת מכונות, במיוחד מודלים של למידה עמוקה. מודלים אלה יכולים להניב תוצאות מדויקות, אך לעיתים קרובות פעולותיהם הפנימיות מורכבות מכדי לפרש. בעיית התיבה השחורה ב- AI הופכת לבעייתית במיוחד בתחומים בעלי השקעות גבוהות כמו שירותי בריאות, מימון ואכיפת החוק, כאשר ההבנה מדוע התקבלה החלטה היא קריטית.

- כלים AI כמו רשתות עצביות עמוקות מצטיינים בזיהוי דפוסים אך לרוב מפותלים מכדי לבני אדם להבין באופן מלא.

- המורכבות מתעוררת מכיוון שמודלים אלה כוללים שכבות מרובות של חישובים ושינוי, מה שמקשה על עקבות אופן קלט נתוני הקלט הופכים להחלטות תפוקה.

ההשפעה של בעיית התיבה השחורה ב- AI

חוסר השקיפות בקבלת ההחלטות יוצר אתגרים במספר דרכים:

- אחריות: במקרים בהם מערכות AI מקבלות החלטות שגויות או מזיקות, קשה להצביע על הגורם המדויק לבעיה, מה שמסבך את האחריות והאמון.

- הטיה: ללא תובנה כיצד פועלות מערכות AI, קשה יותר לזהות ולתקן כל הטיות בתהליך קבלת ההחלטות של המודל.

- חששות רגולטוריים: כאשר AI ממשיך להתפתח, הרגולטורים עומדים בפני אתגרים בהבטחת טכנולוגיות אלה עומדות בסטנדרטים וחוקים אתיים. חוסר הפרשנות מעכב את הרגולציה.

הבנת הצורך ב- AI הניתן להסבר

כדי להקל על בעיית התיבה השחורה ב- AI, החוקרים פונים ל- AI הניתן להסבר (XAI). AI הניתן להסבר נועד לספק הסבר ברור ומובן כיצד מערכות AI מגיעות להחלטותיהן. זה חיוני בטיפוח אמון, הבטחת הגינות ושמירה על אחריות.

נאבק בשקיפות AI? קבל פתרונות AI ברורים ואחריות.

עד כמה AI הניתן להסבר עוזר

- שקיפות: עם AI הניתן להסבר, המשתמשים יכולים לגשת לתובנות כיצד מערכות AI מעבדות נתונים ולבצע תחזיות.

- אמון ואימוץ: מכיוון שבעלי העניין יכולים להבין את קבלת ההחלטות של AI, הם נוטים יותר לסמוך על כלי AI ליישומים קריטיים.

- החלטות אתיות: AI הניתן להסבר מקדם קבלת החלטות אתיות על ידי חשיפת הטיות או דפוסים מפלים במערכות AI.

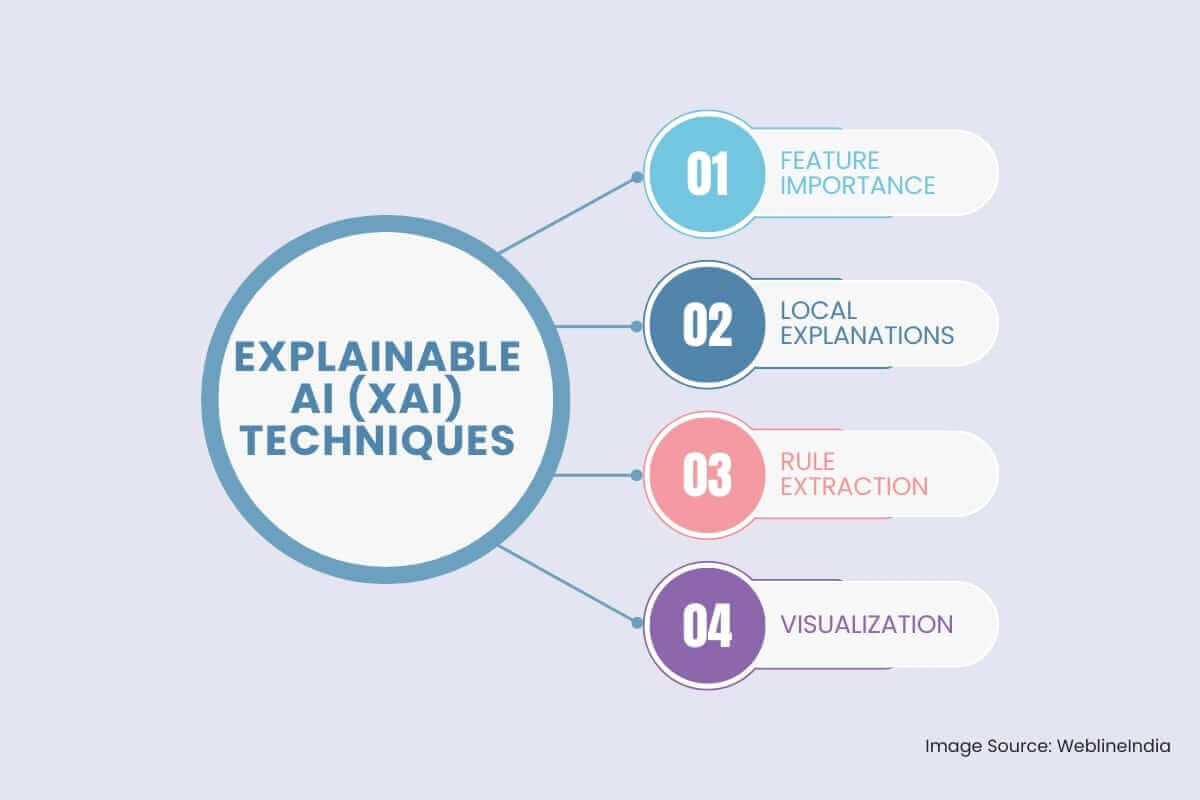

טכניקות AI (XAI) הניתנות להסבר

כדי לטפל בבעיית התיבה השחורה, עלה תחום ה- AI (XAI) להסבר. XAI מתמקד בפיתוח טכניקות שהופכות את תהליכי קבלת ההחלטות של מודלים של AI לשקופים ומובנים יותר. כמה טכניקות מפתח XAI כוללות:

- חשיבות תכונה: טכניקה זו נועדה לזהות את תכונות הקלט שיש להן את ההשפעה הגדולה ביותר על תפוקת הדגם.

חשיבות פרמוטציה: שיטה זו מעריכה את חשיבותה של תכונה על ידי דשדוש באופן אקראי את ערכיה והתבוננות כיצד זה משפיע על ביצועי המודל.

SHAP (הסברים תוספים של Shapley): גישה זו מבוססת תיאוריית משחק מספקת הבנה ניואנסית יותר של חשיבות התכונה על ידי ייחוס תפוקת המודל לתכונות אינדיבידואליות.

- הסברים מקומיים: שיטות אלה מספקות הסברים לתחזיות אינדיבידואליות שנעשו על ידי המודל.

סיד (הסברים מקומיים שניתן לפרש מודל-אגנוסטי): טכניקה זו מתקרבת להתנהגות המודל באופן מקומי סביב נקודת נתונים ספציפית באמצעות מודל פשוט יותר וניתן לפרשנות יותר, כמו מודל לינארי או עץ החלטה.

עוגנים: שיטה זו מזהה קבוצה של תנאים (עוגנים) אשר אם קיימים, מבטיחים תחזית ספציפית עם סבירות גבוהה.

- חילוץ שלטון: גישה זו כוללת חילוץ כללים קריאים לבני אדם מהמודל המאומן.

אינדוקציה של עץ ההחלטה: טכניקה זו כוללת בניית עץ החלטה, שניתן לפרש בקלות על ידי בני אדם, כדי להתקרב לתחזיות המודל.

מערכות מבוססות כללים: מערכות אלה מייצגות במפורש את הידע של המודל בצורה של כללי אם.

- רְאִיָה: הדמיה של פעולות הפנימיות של מודל AI יכולה לספק תובנות חשובות לגבי תהליך קבלת ההחלטות שלו.

מפות הפעלה: הדמיות אלה מדגישות את תחומי הדימוי שהמודל מתמקד בה בעת חיזוי.

מנגנוני תשומת לב: ניתן להשתמש בטכניקות אלה כדי להמחיש את חלקי הטקסט או הרצף שהמודל מפנה אליהם בעת ביצוע חיזוי.

התגברות על אתגרים בפיתוח AI הניתן להסבר

אמנם AI הניתן להסבר מציע פיתרון מבטיח, אך יישוםו מגיע למעשה עם מערך אתגרים משלו:

- סחר בין דיוק והסבר: חלק מכלי ה- AI החזקים ביותר, כמו רשתות עצביות עמוקות, עשויים להציע דיוק גבוה אך במחיר של להיות קשה יותר להסביר. איזון בין שני גורמים אלה נותר אתגר משמעותי.

- מורכבות של דגמים: טכנולוגיות AI רבות מסתמכות על אלגוריתמים מתקדמים שקשה להסביר. מחקרים ממשיכים לחקור כיצד להפוך את המודלים המורכבים הללו לפרשניים מבלי להקריב את ביצועיהם.

- מדרגיות: מכיוון שכלי AI נפרסים בקנה מידה גדול יותר, שמירה על הסברים אפקטיביים לכל החלטה שהתקבלה על ידי המערכת עלולה להפוך למדהימה.

תפקידה של טכנולוגיות AI בפתרון בעיית התיבה השחורה

AI Technologies מתפתחים כל הזמן כדי ליצור מערכות שקופות וניתנות לפרשנות יותר. מפיתוח אלגוריתמים טובים יותר ועד שיפור טכניקות הדמיה של נתונים, טכנולוגיות אלה סוללות את הדרך לפתרונות לבעיית התיבה השחורה ב- AI.

- דגמים היברידיים: שילוב של דגמים ניתנים להסבר וגם של קופסא שחורה יכול לספק איזון בין ביצועים לשקיפות. לדוגמה, שימוש במודלים פשוטים יותר לקבלת החלטות תוך הסתמכות על מודלים מורכבים יותר לתחזיות עשוי לאפשר דיוק ופרשנות כאחד.

- הדמיית נתונים: הדמיית נתונים אפקטיבית יכולה לעזור להפוך את דגמי ה- AI לשקופים יותר על ידי הצגת תהליך קבלת ההחלטות בפורמט נגיש. כלים אינטראקטיביים יכולים לאפשר למשתמשים לשאילת מערכות AI לקבלת הסברים נוספים.

מסקנה: חתירה לשקיפות בקבלת החלטות AI

בעיית התיבה השחורה ב- AI מהווה מכשול משמעותי לאימוץ הרחב והיישום האתי של טכנולוגיות AI. למרות החזקים, כלי AI חייבים להיות שקופים יותר כדי להבטיח שההחלטות שלהם מובנות, אמינות והוגנות. כְּמוֹ פיתוח AI התקדמות, תחום ה- AI הניתן להסבר ממשיך להתפתח, החוקרים בוחנים פתרונות חדשניים כדי להתגבר על אתגרים אלה, ומאפשרים ליהנות מהיתרונות של טכנולוגיות AI מבלי להתפשר על אחריות או באתיקה.

Hashtags חברתיים

#Explabableai #ATRANSPARENCY #BLACKBOXPROBLEMBLE #XAI #TRUSTINAI #MACHINELEARNING #DEEPLEARNING #AIMODELS #SHAP #LIME

רוצה להפוך את AI לשקוף ואמין יותר לעסק שלך?

שאלות נפוצות

המלצות: שמעו ישירות מלקוחותינו ברחבי העולם

תהליכי הפיתוח שלנו מספקים פתרונות דינמיים להתמודדות עם אתגרי עסק, אופטימיזציה של עלויות והובלת טרנספורמציה דיגיטלית. פתרונות הנתמכים על ידי מומחים משפרים את נאמנות הלקוחות והנוכחות הדיגיטלית, וסיפורי הצלחה מוכחים מדגישים פתרון בעיות בעולם האמיתי באמצעות יישומים חדשניים. לקוחותינו המוערכים ברחבי העולם כבר חוו זאת.

פרסים והכרה

בעוד שלקוחות מרוצים הם המוטיבציה הגדולה ביותר שלנו, להכרה בתעשייה יש ערך משמעותי. WeblineIndia הובילה באופן עקבי בטכנולוגיה, כאשר פרסים וציונים מחזקים את מצוינותנו.

OA500 חברות מיקור חוץ גלובליות 2025, מאת Outsource Accelerator

חברת פיתוח התוכנה המובילה, מאת GoodFirms

חברת פתרונות הפינטק הטובה ביותר – 2022, מאת GESIA

זוכת פרס – חברת פיתוח האפליקציות הטובה ביותר בהודו 2020, מאת SoftwareSuggest