כאשר השוק מונע על ידי דיגיטליזציה, אין להכחיש את כוח הטרנספורמציה של מודלים של שפה גדולה (LLMs). מאוטומציה של שירות לקוחות ועד ליצירת קוד מורכב, LLMs מבטיחים יעילות וחדשנות חסרי תקדים. עם זאת, עבור ארגונים גדולים רבים, במיוחד אלה הפועלים במגזרים מוסדרים מאוד כמו פיננסים, בריאות וממשל, השאיפה לחדשנות בבינה מלאכותית (AI) מופרעת על ידי מחסום דרכים משמעותי, בלתי נתון למשא ומתן: פרטיות ואבטחת נתונים.

ארכיטקטורת ברירת המחדל לפריסת LLMs מתוחכמים כוללת לעתים קרובות מיקור חוץ לספקי ענן ציבוריים גדולים. למרות שנוח, מודל זה אומר מטבעו כי נתונים ארגוניים רגישים, המשמשים לאימון, כוונון ואינטראקציה עם מודלים אלה, חייבים לעזוב את הגבולות המאובטחים של הרשת הפנימית של החברה. חשיפה זו אינה רק סיכון; זוהי הפרה ישירה של מנדטים רגולטוריים (כמו GDPR, HIPAA וחוקי לוקליזציה לאומיים שונים) ומדיניות ציות פנימית.

כאן מתגלה הרעיון של LLMs on-premise, לא רק כאלטרנטיבה, אלא כארכיטקטורה החיונית עבור ארגונים שנחושים להיות בראש ובראשונה לפרטיות ולעיתים קרובות בוחרים לשכור צוות מסור ליישום AI מאובטח. פריסת LLMs ישירות על חומרה פנימית בבעלות תאגיד היא הפתרון הסופי להשגת ריבונות נתונים מוחלטת, המבטיחה שמידע קנייני לעולם לא יוצא מהשליטה הפיזית והדיגיטלית של הארגון.

מוכן לשמור על פרטיות הנתונים הארגוניים בזמן השימוש בבינה מלאכותית? שוחח עם מומחי LLM שלנו עוד היום.

הקונפליקט הגדול: חדשנות מול ציות

המקרה העסקי של AI ברור: יתרון תחרותי, הפחתת עלויות וקבלת החלטות מעולה. עם זאת, הנוף הארגוני מוגדר יותר ויותר על ידי ניהול נתונים קפדני.

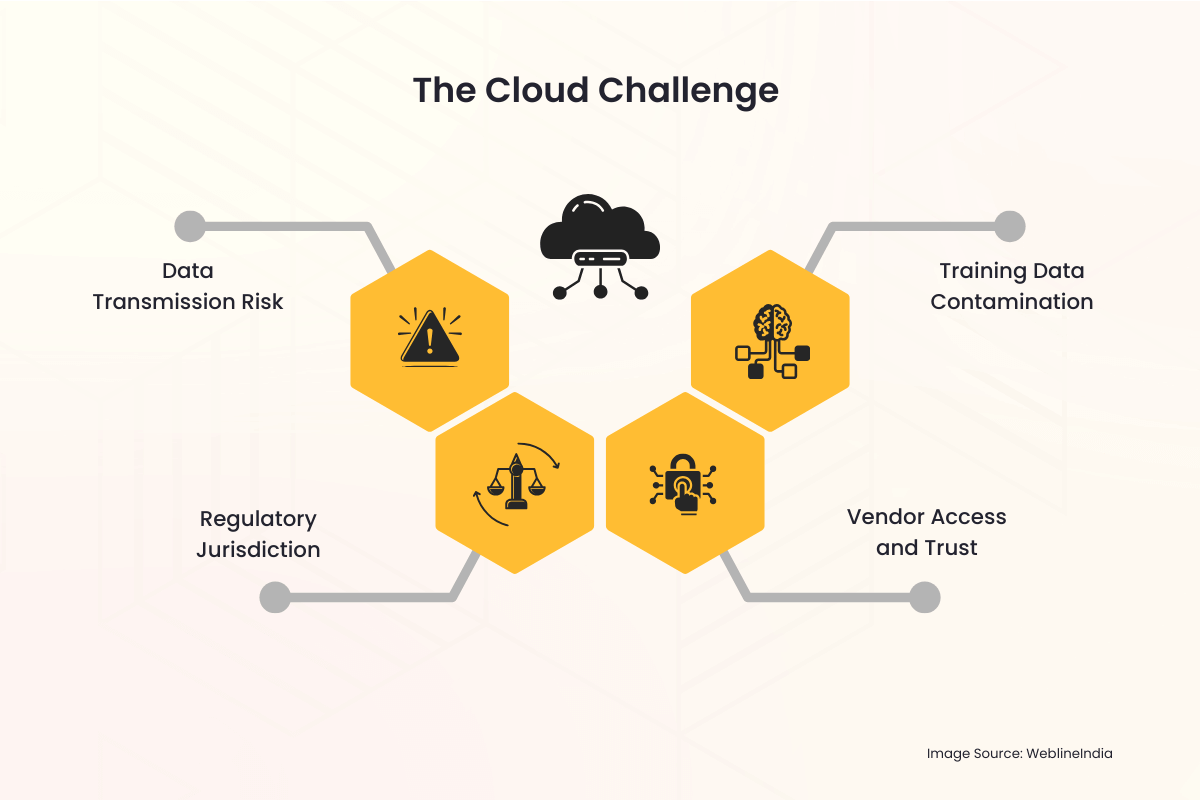

אתגר הענן

כאשר ארגון משתמש בשירות LLM המתארח בענן, צצות מיד כמה מלכודות פרטיות:

- סיכון להעברת נתונים: כל שאילתה, כל קלט והפלט המתקבל חייבים לעבור את האינטרנט הציבורי ולהימצא באופן זמני בשרת של צד שלישי. כל התהליך הזה הוא וקטור פוטנציאלי ליירוט או גישה לא מורשית.

- סמכות שיפוט רגולטורית: נתונים המאוחסנים במדינה או בתחומי שיפוט שונים מהמקור של הארגון עלולים להפעיל חוקים בינלאומיים מורכבים, לעתים סותרים. השגת לוקליזציה של נתונים – הדרישה לאחסון ועיבוד נתונים בגבולות ספציפיים – הופכת כמעט בלתי אפשרית עם ספק ענן רב לאומי.

- גישת ספקים ואמון: ארגונים נאלצים לסמוך על פרוטוקולי האבטחה של ספק הענן, בקרות הגישה לעובדים ומדיניות השמירה. זה מכניס צד שלישי לזרימות העבודה הרגישות ביותר של הנתונים.

- זיהום נתוני אימון: אם נעשה שימוש בנתונים קנייניים של חברה לכוונון עדין של מודל שמתארח בענן, תמיד קיים סיכון שמשקולות מודל עלולים להיות משותפים בטעות, או אפילו בזדון, או להשפיע על התגובות של מודלים המשמשים דיירים אחרים, מה שיוביל לדליפת נתונים.

חששות אלה אינם תיאורטיים. אירועים בעלי פרופיל גבוה של הפרות נתונים והעונשים החמורים שנאכפים על ידי גופי רגולציה גלובליים העלו את פרטיות הנתונים מכאב ראש IT לעדיפות מרכזית בחדר הישיבות. עבור ארגונים המטפלים במידע אישי מזהה (PII), מידע בריאותי מוגן (PHI) או קניין רוחני מסווג (IP), פרופיל הסיכון של LLMs בענן ציבורי הוא לרוב פשוט גבוה מכדי לקבל.

הפתרון המקומי: החזרת שליטה וריבונות

מודל הפריסה המקומי של LLM מטפל ופותר ישירות את חששות הפרטיות העמוקים הללו על ידי הצבת תשתית הבינה המלאכותית כולה (החומרה, התוכנה, משקלי הדגם ונתוני ההדרכה) תחת שליטה פיזית ודיגיטלית ישירה ובלעדית של הארגון.

1. ריבונות נתונים מוחלטת

ריבונות נתונים פירושה שהנתונים כפופים רק לחוקים ולכללי הממשל של המדינה או הארגון שבו הם נאספים ומאוחסנים.

- שליטה גיאוגרפית: עם הגדרה מקומית, החומרה ממוקמת פיזית בתוך מרכז הנתונים של הארגון, לרוב במדינה מסוימת או אפילו בחדר מאובטח ספציפי. זה עונה באופן מהותי על דרישות תושבות נתונים ולוקליזציה של נתונים, מה שהופך את הציות לתקנות כמו GDPR של האיחוד האירופי או חוקי ביטחון לאומי שונים לפשוטה.

- אפס שידור חיצוני: כל עיבוד הנתונים, הדרכת המודלים וההסקות (שאילתת המודל) מתרחשים בתוך חומת האש הארגונית. הנחיות רגישות ומסמכים פנימיים קנייניים המשמשים את LLM לעולם אינם יוצאים מסביבת הרשת המאובטחת.

2. אבטחה ותאימות משופרים

פריסה מקומית מאפשרת לצוות האבטחה ליישם את מסגרת האבטחה הקיימת והחזקה של הארגון ישירות על מערכת הבינה המלאכותית.

- תשתית אבטחה קיימת: ניתן לשלב את פתרון ה-LLM בצורה חלקה עם כלי אבטחה ארגוניים מבוססים, לרבות מערכות זיהוי חדירות (IDS), חומות אש מתוחכמות, פתרונות ניהול זהויות וגישה (IAM) ומערכות למניעת אובדן נתונים (DLP). זה לרוב מקיף ומותאם יותר משכבות האבטחה שמציע שירות ענן גנרי.

- בקרת גישה מותאמת אישית: ניתן לשלוט בקפדנות על הגישה למודל עצמו באמצעות Active Directory פנימי ארגוני או פתרונות IAM ארגוניים אחרים. רק עובדים מורשים, מחלקות או יישומים יכולים ליצור אינטראקציה עם המודל, ויומני גישה נשמרים באופן פנימי למטרות ביקורת.

- ביקורת פשוטה: ציות לרגולציה מחייבת לעתים קרובות מסלולי ביקורת מפורטים. בעלות על הערימה כולה מאפשרת לארגון לשמור יומנים מפורטים של כל שימוש במודל, משימת הדרכה ופעולת מנהל, מה שמקל בהרבה על בדיקות התאימות למבקרים פנימיים וחיצוניים.

3. הגנת קניין רוחני

עבור ארגונים, הערך האמיתי של LLM טמון לא רק במודל הבסיסי (כמו Llama, Mistral או אחרים), אלא בידע הקנייני המשמש כדי לכוונן אותו. נתוני כוונון זה הם ה-IP של הארגון.

- סביבת אימון מבודדת: כאשר כוונון עדין מתבצע במקום, מערכי הנתונים הקנייניים (כגון רישומי לקוחות, דוחות פנימיים, הגשת פטנטים או מפרטי מוצרים) לעולם אינם מועלים לצד שלישי. משקלי הדגמים המכוונים המתקבלים, המקודדים למעשה את הידע של החברה, נשמרים גם באופן פנימי, ומונעים מכל גורם חיצוני לקבל גישה לא מורשית ל-IP הליבה.

זקוק ל-LLM תואם, מקומי המותאם לענף שלך? בואו נבנה אותו בצורה מאובטחת.

המעשיות של אדריכלות LLM On-Premise

בעוד שיתרונות הפרטיות משכנעים, פריסת LLM מקומית דורשת תכנון קפדני והשקעה בטכנולוגיה הבסיסית.

אתגר החומרה: הצורך במעבדי GPU

לימודי תואר שני תובעניים מבחינה חישובית. המאפשר העיקרי לפריסה יעילה במקום הוא חומרה מיוחדת, בעיקר GPUs (יחידות עיבוד גרפיות).

- כוח מסקנות: כדי לשרת שאילתות משתמש בזמן אמת (הסקת מסקנות), ה-LLM דורש זיכרון מהיר וכוח עיבוד מקביל המסופקים על ידי GPUs, לעתים קרובות במדפי שרתים ייעודיים.

- אימון וכיוונון עדין: אימון דגם מאפס הוא משימה עצומה, אך ניתן לבצע כוונון עדין (התאמת דגם קיים) בפחות מעבדי GPU חזקים. ההשקעה בחומרה זו היא הוצאה הונית (CapEx) המחליפה את ההוצאה התפעולית השוטפת (OpEx) של עמלות שירותי ענן, ומציעה חיזוי עלויות לטווח ארוך.

מחסנית התוכנה

הפתרון המקומי המלא כולל יותר מסתם חומרה; זה דורש שכבת תוכנה ותזמור חזקה:

- בחירת דגם: בחירה ב-LLM בסיסית בעלת קוד פתוח, בר-קיימא (כמו Llama 3, Mistral וכו’) שניתן להוריד ולפריסה באופן חוקי על תשתית פרטית היא הצעד הראשון.

- מיכליות (למשל, Docker/Kubernetes): כדי לנהל את הפריסה המורכבת, ה-LLM והתלות שלו נארזים לרוב בקונטיינרים. כלי תזמור כמו Kubernetes מנהלים את אשכול שרתי ה-GPU, ומבטיחים מדרגיות וזמינות גבוהה, בדומה לסביבת ענן פרטית – המיושמות לרוב על ידי ארגונים אשר שכור מהנדסי ענן ו-DevOps לנהל תשתית AI מורכבת כזו.

- שכבת API פנימית: ממשק תכנות יישומים (API) נבנה בתוך חומת האש, המאפשר ליישומים פנימיים (צ’אטבוטים, עוזרי קידוד, מנתחי נתונים) לשלוח הנחיות ל-LLM מבלי לגעת מעולם באינטרנט הציבורי.

התגברות על השהיית נתונים וממשל

פתרונות מקומיים מבטלים את השהיית הנתונים ומשפרים את הממשל של מקורות נתונים פנימיים.

- גישה לנתונים פנימיים בזמן אמת: LLMs צריכים לעתים קרובות לגשת לנתונים הפנימיים העדכניים ביותר – תהליך הנקרא יצירת אחזור מוגברת (RAG). בהיותו מקומי, ל-LLM יש גישה נמוכה ברוחב פס למסדי נתונים פנימיים, אגמי נתונים ומאגרי מסמכים, מה שמוביל לתוצאות מדויקות יותר, הקשריות ובזמניות ללא צורך בהעברת נתונים דרך האינטרנט.

- ממשל מאוחד: צוות ניהול הנתונים יכול להחיל קבוצה אחת של כללים על הנתונים, על מדד ה-RAG ועל ה-LLM עצמו, וליצור סביבת ציות אחידה ופשוטה יותר.

יתרונות אסטרטגיים לתעשיות המודעות לפרטיות

המעבר לארכיטקטורה מקומית היא החלטה אסטרטגית המאותתת על מחויבות חזקה לעמידה ברגולציה ואמון הלקוחות.

| תַעֲשִׂיָה | חשש עיקרי לפרטיות | הטבת פתרון מקומי |

| שירותי בריאות (HIPAA) | הגנה על רישומי PHI ומטופלים. | מבטיח ש-PHI נשאר בסביבה מאובטחת ויעודית; מפשט את יומני הביקורת הנדרשים לציות. |

| שירותים פיננסיים (GDPR, PCI-DSS) | PII של לקוחות, נתוני עסקאות, IP אלגוריתמי. | מבטיח תושבות נתונים ולוקליזציה; מגן על אלגוריתמי מסחר קנייניים ומודלים של ניקוד לקוחות מפני חשיפה חיצונית. |

| ממשלה / הגנה | מידע מסווג, רגיש מאוד או סודי מדינה. | מאפשר פריסה בסביבות מרווחות אוויר (רשתות מבודדות פיזית מהאינטרנט), ומבטיח אבטחה מוחלטת. |

| ייצור / מו”פ | קניין רוחני (IP), עיצובים קנייניים וסודות מסחריים. | מונע דליפה של תהליכי ייצור ייחודיים או פרטי עיצוב מוצר המשמשים במהלך RAG או כוונון עדין. |

גישור על הפער עם שירותי IT מקצועיים

ההחלטה לעבור לארכיטקטורת LLM on-premise, על אף שהיא נכונה מבחינה אסטרטגית לפרטיות, מציגה מורכבות תפעולית משמעותית. הוא דורש מיומנויות מיוחדות ברכש חומרה (במיוחד GPUs בעלי ביצועים גבוהים), הקמת סביבה חזקה ומכילה (כמו Kubernetes), כוונון עדין של מודלים על נתונים רגישים ושילוב ה-LLM עם מערכות ארגוניות קיימות. זה המקום שבו שותף שירותי IT מהימן הופך לבעל ערך רב.

WeblineIndia היא סוכנות IT ידועה בארה”ב המתמחה במתן המומחיות המקיפה הדרושה כדי לנווט את המעבר הזה בצורה חלקה. הם מציעים שירותים מקצועיים מקצה לקצה, החל מתכנון מחסנית החומרה המקומית האופטימלית המותאמת לצרכי ההסקה וההדרכה שלך, ועד לניהול הפריסה המאובטחת של LLMs קוד פתוח בתוך חומת האש שלך.

מומחי ענן במרכז הפיתוח של WeblineIndia בהודו הם בעלי ניסיון מעמיק בתשתית ענן מאובטחת והטמעת בינה מלאכותית. ארגונים יכולים לפרוס במהירות את סביבת ה-LLM הפרטית שלהם, להבטיח עמידה קפדנית במדיניות התאימות הפנימית והאצת הזמן לערך ללא צורך בגיוס והכשרת צוותי הנדסת AI יקרים ומתמחים, על ידי מינוף מפתחים מרוחקים מנוסים. שותפות זו הופכת פרויקט תשתית מאתגר ליוזמה ניתנת לניהול, מבוצעת אסטרטגית, המוקדשת במלואה לשמירה על ריבונות הנתונים המוחלטת שלך.

העתיד הוא פרטי ומאובטח עם WeblineIndia

ההתרגשות מסביב ל-LLM לא צריכה להאפיל על האחריות הבסיסית שיש לארגונים להגן על הנתונים הרגישים שהופקדו עליהם. עבור כל ארגון גדול שבו תאימות, פרטיות וריבונות נתונים אינם ניתנים למשא ומתן (כלומר, רוב הארגונים המצליחים כיום), מודל ה-LLM בענן הציבורי הוא אי התאמה מהותית.

המעבר לפריסת LLM מקומית מייצג נתיב ברור קדימה. ההשקעה הדרושה בחומרה ובמומחיות היא שסוגרת את פער האבטחה, עומדת בדרישות הרגולציה העולמיות המחמירות ביותר, ובסופו של דבר מאפשרת לארגון לרתום את מלוא הפוטנציאל הטרנספורמטיבי של בינה מלאכותית מבלי להתפשר על הנכס היקר ביותר שלו: הנתונים שלו.

צור קשר עם WeblineIndia שירותי ייעוץ IT כדי לברוח מהסיכונים הטמונים בענן ולהשיב לעצמם שליטה על ערימת הבינה המלאכותית שלהם כדי לחדש באומץ. אתה יכול להבטיח שאמון לקוחות, עמידה בציות וקניין רוחני מאובטחים לחלוטין בתחום הריבוני שלהם.

Hashtags חברתיים

#LLM_במקום_העסקה #ריבונות_נתונים #בינה_מלאכותית_ארגונית #תאימות_בינה_מלאכותית #פרטיות_קודם_כל #בינה_מלאכותית_מאובטחת #אבטחת_LLM #טכנולוגיה_ארגונית

רוצה שליטה מלאה על ערימת הבינה המלאכותית שלך עם אפס סיכון נתונים? התחל עם WeblineIndia.

שאלות נפוצות

המלצות: שמעו ישירות מלקוחותינו ברחבי העולם

תהליכי הפיתוח שלנו מספקים פתרונות דינמיים להתמודדות עם אתגרי עסק, אופטימיזציה של עלויות והובלת טרנספורמציה דיגיטלית. פתרונות הנתמכים על ידי מומחים משפרים את נאמנות הלקוחות והנוכחות הדיגיטלית, וסיפורי הצלחה מוכחים מדגישים פתרון בעיות בעולם האמיתי באמצעות יישומים חדשניים. לקוחותינו המוערכים ברחבי העולם כבר חוו זאת.

פרסים והכרה

בעוד שלקוחות מרוצים הם המוטיבציה הגדולה ביותר שלנו, להכרה בתעשייה יש ערך משמעותי. WeblineIndia הובילה באופן עקבי בטכנולוגיה, כאשר פרסים וציונים מחזקים את מצוינותנו.

OA500 חברות מיקור חוץ גלובליות 2025, מאת Outsource Accelerator

חברת פיתוח התוכנה המובילה, מאת GoodFirms

חברת פתרונות הפינטק הטובה ביותר – 2022, מאת GESIA

זוכת פרס – חברת פיתוח האפליקציות הטובה ביותר בהודו 2020, מאת SoftwareSuggest