Pushmeldingen zijn overal-of het nu een breeknieuwswaarschuwing is, een weersupdate of een “uw bestelling heeft verzonden” -bericht, ze stimuleren betrokkenheid en leveren realtime waarde aan gebruikers. Maar het ontwerpen van een push -meldingssysteem dat miljarden berichten op verschillende platforms kan verwerken, terwijl ze performant en betrouwbaar blijven, is geen wandeling in het park.

Moderne applicaties moeten vaak tijdgevoelige informatie pushen voor gebruikers op mobiele apparaten (iOS/Android), desktops (macOS/Windows) en browsers (Chrome, Firefox, Safari). Elk van deze platforms heeft een eigen protocol, afleveringsbeperkingen en rentelimieten. Laag nu in bedrijfsregels zoals gebruikersvoorkeuren, segmentatie, smoorzetting, pesten en lokalisatie-u staart plotseling naar een niet-triviaal gedistribueerd systeem.

Een basisimplementatie kan op lage schaal of in een proof-of-concept werken. Maar wat gebeurt er als je 50 miljoen gebruikers hebt, elk met meerdere apparaten, en marketing wil om de paar minuten campagnes uitvoeren naar 10% van je publiek? Dat is waar dingen uit elkaar beginnen te vallen als je architectuur er niet vanaf de grond voor is gebouwd.

Deze gids loopt door de architecturale blauwdruk van het bouwen van een schaalbaar, fouttolerant en uitbreidbaar pushmeldingssysteem. Het zal zich richten op cross-platform levering (APN’s, FCM, WebPush), zorgen op systeemniveau zoals wachtrijen en petries, evenals hoe ze kunnen afstemmen op prestaties onder hoge belasting.

Het doel is om u uit te rusten met het mentale model en ontwerppatronen dat nodig is om een systeem te bouwen dat niet onder druk wordt vastgemaakt – en kan evolueren met uw productbehoeften.

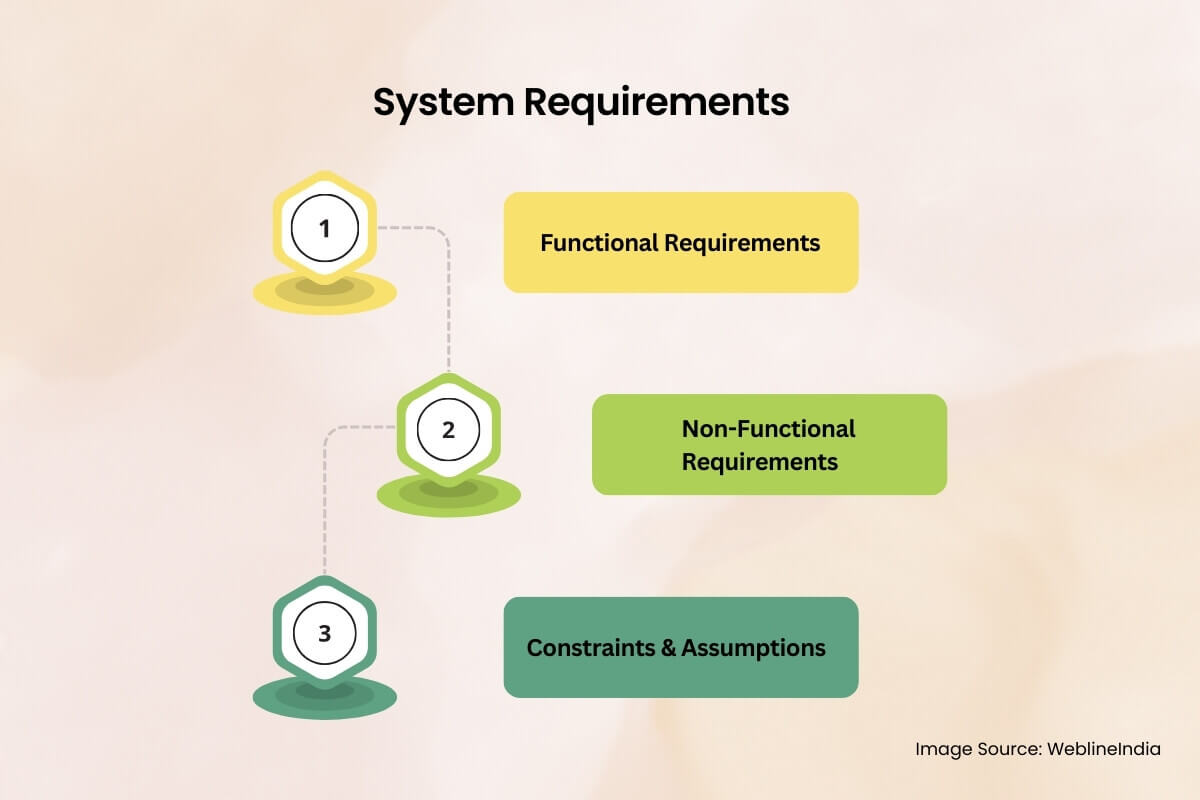

Systeemvereisten

Functionele vereisten

In de kern moet het push-meldingssysteem berichten leveren aan apparaten voor eindgebruikers. Maar “levering” is niet genoeg. Dit is wat het systeem eigenlijk zou moeten doen:

- Multi-platform levering: Ondersteuning Apple Push Notificatie Service (APNS), Firebase Cloudberichten (FCM) en Web-push-protocol (WPP).

- Apparaatregistratie en -beheer: Bewaar apparaattokens toegewezen aan gebruikers, platforms en applicaties.

- Targetingmogelijkheden: Stuur berichten naar specifieke gebruikers, apparaatgroepen, gebruikerssegmenten of alle gebruikers (uitgezonden).

- Planning: Laat berichten onmiddellijk of op een toekomstige geplande tijdstip worden verzonden.

- Rate beperkende: Gasberichten op basis van platformbeperkingen of interne bedrijfsregels.

- Logica opnieuw proberen: Probeer automatisch mislukte leveringen opnieuw met exponentiële back -off of op maat gemaakte beleid.

- Gebruikersvoorkeuren: Respecteer opt-in/opt-out status, stille uren of specifieke kanaaltypen (bijv. Promotie versus transactionele).

- Auditing & analyse: Spoor leveringssucces/falen, opent (indien mogelijk) en diagnostische metadata voor probleemoplossing.

Niet-functionele vereisten

Dit zijn de backbone-zorgen-deze manier van deze, en uw platform zal instorten onder real-world gebruik.

- Schaalbaarheid: Systeem moet pieken van miljoenen berichten per minuut verwerken.

- Beschikbaarheid: Richt op 99,99% uptime, vooral voor kritieke paden zoals apparaatregistratie en leveringspijpleidingen.

- Latentie: Sub-seconde verwerking voor transactionele (bijv. OTP, beveiligingswaarschuwingen); Vervoerbare vertraging (5-15s) voor batchmarketingberichten.

- Duurzaamheid: Berichten mogen niet verloren gaan in het geval van knooppunt- of servicefout.

- Beveiliging: End-to-end bescherming van gebruikersgegevens, authenticatie tegen services van 3e partijen, codering van payloads tijdens het transport en in rust.

- Multi-tenancy: Mogelijkheid om meerdere applicaties/klanten te ondersteunen met geïsoleerde gegevens en afleveringspijplijnen.

Beperkingen en veronderstellingen

Het definiëren van grenzen is van cruciaal belang om de architecturale dubbelzinnigheid te verminderen.

- Stel dat platformpushproviders (APN’s, FCM, WebPush) extern zijn en fungeren als zwarte dozen met gepubliceerde SLA’s.

- Payloads van berichten zijn klein (2KB – 4KB), met de meeste logica aan de clientzijde.

- Er is een bestaand gebruikersidentiteitsplatform dat apparaat-tot-gebruikers toewijzingen en gebruikersvoorkeuren blootlegt.

- Het systeem zal de levering niet garanderen – eenmaal het overhandigt aan APN’s/FCM, verantwoordelijkheid is van hen.

- Systeem wordt uitgevoerd in een cloud-native omgeving (Kubernetes of beheerde containers, autoscaling, enz.).

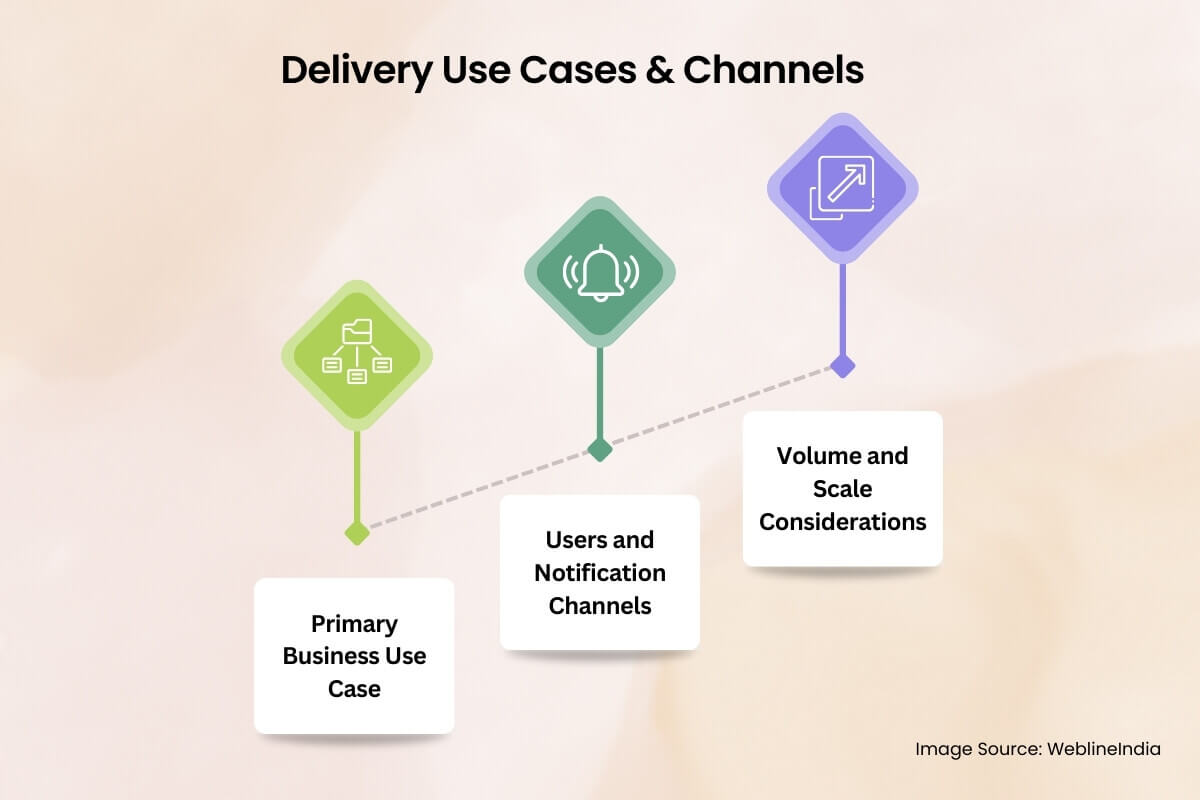

Kerngebruikscase en leveringslandschap

Voordat u in de architectuur duikt, is het belangrijk om te verduidelijken waarvoor dit systeem oplost – omdat “pushmeldingen” verschillende dingen in verschillende zakelijke contexten betekenen. Deze sectie onderzoekt het real-world operationele landschap, dat het systeem gebruikt en hoe de schaal de ontwerpkeuzes beïnvloedt.

Primaire bedrijfsgebruikscase

Laten we een typische, high-impact use case definiëren: een grootschalig B2C-e-commerce platform wil realtime pushmeldingen verzenden via mobiel en web om gebruikersbetrokkenheid te stimuleren, gebruikers te waarschuwen voor bestelstatusupdates of gebaseerde herinneringen op basis van gedrag (bijv. Verlaten karters). Er zijn ook interne use cases – waarschuwingen, fraudesystemen en partnerintegraties. Maar de kernstuurprogramma is high-throughput, gebruikersgerichte berichten met variërende kriticiteitsniveaus.

Gebruikers en meldingskanalen

De eindgebruikers van het systeem zijn niet alleen klanten die de push -berichten ontvangen. Er zijn meerdere acteurs:

- Marketeers: Voer grote campagnes uit, planning en segment gebruikerscohorten.

- Productteams: Trigger contextuele meldingen van app-gedrag (in-app-mijlpalen, gamificatielussen).

- Backend -systemen: Automatisch activeren transactionele berichten zoals OTP’s, betalingsbevestigingen of leveringswaarschuwingen.

Aan de ontvangende kant kan elke gebruiker meerdere apparaattypen hebben:

- Mobiele apps: iOS via APN’s en Android via FCM.

- Webbrowsers: Via Web Push Protocol (op VapID gebaseerd), meestal voor desktop-/laptopgebruikers.

- Services van derden: In sommige gevallen zijn integraties met leveringskanalen van derden zoals WhatsApp of in-app berichtenoverlays betrokken-maar uit het bereik van dit systeem.

Volume- en schaaloverwegingen

Dit is wat het systeem naar verwachting zal behandelen in de echte schaal:

- 100m+ geregistreerde apparaten Over platforms, met 5-10% dagelijks actief.

- Transactionele gebeurtenissen: 3–5m berichten/dag, met harde latentie SLA’s (bijvoorbeeld OTP binnen 3 seconden).

- Campagnes: Burst stuurt naar 10-20 miljoen gebruikers in minder dan 5 minuten, vaak geactiveerd via dashboard of backend taakwachtrijen.

- Peak gelijktijdigheid: 200k+ berichten/minuut tijdens Black Friday-type evenementen of tijdens virale spikes.

Dit gaat niet over het verzenden van één bericht naar een gebruiker – het gaat over het verzenden van miljoenen op maat gemaakte berichten over duizenden knooppunten, met betrouwbaarheid, hertries en minimale vertraging. Het ontwerp moet geschikt zijn voor dit soort dynamische werklast, wat staatloze kerndiensten, gedistribueerde wachtrijen en horizontale schaalbaarheid op elke laag betekent.

Systeemarchitectuur op hoog niveau

De architectuur voor een schaalbaar pushmeldingssysteem draait om drie principes: ontkoppelen, parallellisme, En platformspecifieke levering. Op schaal vallen monolithische ontwerpen uit elkaar-dus deze architectuur omarmt een op microservices gebaseerde, gebeurtenisgestuurde aanpak die miljarden berichten met minimale bottlenecks kan uitoefenen, gooien, opnieuw proberen en controleren.

Laten we door de kernsubsystemen, gegevensstroom en platformspecifieke abstracties lopen waardoor het allemaal werkt.

Componentoverzicht

De architectuur is verdeeld in de volgende logische componenten:

- Inname API: Ontvangt berichtverzoeken – batch of transactionele – valideert invoer, enqueuten in de pijplijn.

- Routemotor: Zoek apparaten op, splitst berichten per apparaat-platformpaar, maakt ze in respectieve wachtrijen.

- Platformbezorgers: Dedicated Microservices voor APN’s, FCM en WebPush. Deze omgaan met verbindingsbeheer, pensioen, batching en tariefbeperking.

- Berichtwachtrij (makelaarlaag): High-throughput-makelaar (bijv. Kafka, RabbitMQ of Google Pub/Sub) voor ontkoppelingsproducenten van leveringslogica.

- Device Registry Service: Slaat apparaatmetagegevens, gebruikersvertekeningen, tokenvaliditeit, platformtype en opt-in status op.

- Voorkeur en regels motor: Evalueert de instellingen voor gebruikersmeldingen, onderdrukkingsregels (stille uren, frequentiekaps) of kanaalspecifieke overrijden.

- Scheduler: Voor vertraagde of tijd-window-gebaseerde berichtenbezorging.

- Monitoring & feedback -lus: Legt leveringsontvangsten, fouten en analyses op platformniveau vast; verzorgt APNS -feedback, FCM -verwijderingen, enz.

Hoog niveau architectuurdiagram

+------------------+

| Ingestion API |

+--------+---------+

|

v

+---------------------+

| Routing Engine |

+--------+------------+

|

v

+---------------------+

| Message Broker |

| (Kafka / RabbitMQ) |

+--------+------------+

|

+--------------------------+--------------------------+

| | |

v v v

+-------------+ +--------------+ +----------------+

| APNs Worker | | FCM Worker | | WebPush Worker |

+------+------+ +------+-------+ +--------+-------+

| | |

v v v

+------------------+ +---------------------+ +------------------------+

| Apple Push Notif | | Firebase Cloud Msg | | Web Push Service (VAPID)|

| Service (APNs) | | (FCM) | | |

+------------------+ +---------------------+ +------------------------+

+------------------------+ +--------------------------+

| Device Registry Svc | <------> | User Preferences Engine |

+------------------------+ +--------------------------+

+---------------------------+

| Scheduler / Campaign Svc |

+---------------------------+

+---------------------------+

| Monitoring / Analytics |

| (Logs, Receipts, Metrics) |

+---------------------------+

Belangrijke architecturale patronen

- Evenementgestuurde architectuur: Berichtstroom is volledig asynchroon. Producenten (API’s, interne systemen) worden losgekoppeld van levering met behulp van pub/sub- of berichtenwachtrijen.

- Platformspecifieke abstractie: Werknemers zijn op maat per platform. Elk beheert zijn eigen tarieflimieten, laadindelingen, peters, petries en API Auth.

- Ondersteuning van de tegendruk: Berichtmakelaars moeten pieken afhandelen zonder gegevens te laten vallen. Buffering, dode-lettere wachtrijen en autoscaling van de consument worden ingebouwd.

- Idempotency & deduplication: Berichten moeten unieke ID’s hebben om problemen met dubbele verdeeldheid te voorkomen, vooral bij poets.

- Falen isolatie: Een platformstoring (zeg, APN’s) mag geen berichten in het kader van FCM/WebPush cascade en blokkeren. Elke werknemerspool is geïsoleerd en fouttolerant.

Deze architectuur kan elke component horizontaal onafhankelijk schalen – meer werknemers voor APN’s tijdens iOS -campagne -bursts, of meer routeringsknooppunten tijdens innamespieken. Elk niveau kan worden gemonitord, doorgegaan of opnieuw worden gestart zonder het volledige systeem te beïnvloeden.

Hulp nodig bij het architlaat van push op schaal?

Ben je van plan om pushmeldingen uit te rollen bij miljoenen gebruikers, maar niet zeker hoe je de levering kunt schalen of platformonafhankelijke eigenaardigheden kunnen beheren?

We kunnen u helpen een gevecht getest push-systeem te ontwerpen dat is afgestemd op de groei- en prestatiebehoeften van uw product.

Databaseontwerp en tokenbeheer

Push -meldingssystemen leven of sterven door hun vermogen om miljoenen apparaattokens, gebruikersvoorkeuren en berichten efficiënt te beheren. Dit gedeelte breekt uit hoe een databaseschema ontwerpt dat horizontaal schaalt, de consistentie van de levering onderhoudt en realtime targeting en filtering ondersteunt.

Kerngegevensentiteiten

Minimaal zijn de volgende entiteiten vereist:

- Gebruikers: Logische gebruikersidentiteit (UID), gekoppeld aan een of veel apparaten.

- Apparaten: Platformspecifieke apparaatrecords met tokens, app-versie, laatst gezien, etc.

- Voorkeuren: Gebruikersspecifieke opt-in/opt-out vlaggen, kanaalinstellingen, rustige uren, enz.

- Berichten: Geschiedenis van verzonden meldingen, hun leveringsstatus en metadata voor het oplossen van probleemoplossing/auditing.

Entiteitsrelatiemodel (ERD)

Dit is hoe de entiteiten zich op een hoog niveau verhouden:

+--------+ 1 +---------+ M +-----------+ | Users |---------------<| Devices |--------------->| Preferences| +--------+ +---------+ +-----------+ | | | | 1 | | | M | v v +-------------+ +--------------+ | Notifications| | Delivery Logs| +-------------+ +--------------+

Tabelschema’s (vereenvoudigd)

users (

id UUID PRIMARY KEY,

email TEXT UNIQUE NOT NULL,

created_at TIMESTAMP DEFAULT NOW()

)

-- Index: unique email lookup

-- CREATE UNIQUE INDEX idx_users_email ON users(email);

devices (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

platform ENUM('ios', 'android', 'web') NOT NULL,

token TEXT UNIQUE NOT NULL,

app_version TEXT,

last_active TIMESTAMP,

is_active BOOLEAN DEFAULT true,

created_at TIMESTAMP DEFAULT NOW()

)

-- Indexes:

-- CREATE INDEX idx_devices_user_platform ON devices(user_id, platform);

-- CREATE UNIQUE INDEX idx_devices_token ON devices(token);

preferences (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

channel ENUM('transactional', 'marketing') NOT NULL,

enabled BOOLEAN DEFAULT true,

quiet_hours JSONB,

updated_at TIMESTAMP DEFAULT NOW()

)

-- Index: preference lookup

-- CREATE UNIQUE INDEX idx_prefs_user_channel ON preferences(user_id, channel);

notifications (

id UUID PRIMARY KEY,

title TEXT,

body TEXT,

payload JSONB,

scheduled_at TIMESTAMP,

priority ENUM('high', 'normal', 'low') DEFAULT 'normal',

created_by TEXT,

created_at TIMESTAMP DEFAULT NOW()

)

delivery_logs (

id UUID PRIMARY KEY,

notification_id UUID NOT NULL REFERENCES notifications(id) ON DELETE CASCADE,

device_id UUID NOT NULL REFERENCES devices(id) ON DELETE CASCADE,

status ENUM('pending', 'delivered', 'failed', 'dropped') DEFAULT 'pending',

attempt_count INT DEFAULT 0,

response_code TEXT,

error_message TEXT,

delivered_at TIMESTAMP

)

-- Indexes:

-- CREATE INDEX idx_logs_device_status ON delivery_logs(device_id, status);

-- CREATE INDEX idx_logs_notif_status ON delivery_logs(notification_id, status);

Voorbeeldrijen (alleen illustratief)

users

--------------------------------------------------------------

id | email

--------------------------------------+-------------------------

5b6e...d1 | user@example.com

devices

--------------------------------------------------------------

id | user_id | platform | token | is_active

----------+----------+----------+---------------+------------

f7a9...91 | 5b6e...d1| ios | abc123token...| true

preferences

--------------------------------------------------------------

id | user_id | channel | enabled | quiet_hours

----------+----------+----------------+---------+-------------

c1f3...72 | 5b6e...d1| marketing | false | {"start":"22:00","end":"07:00"}

notifications

--------------------------------------------------------------

id | title | priority | scheduled_at

----------+----------------+----------+--------------

e93f...55 | Order Shipped! | high | 2025-04-22 13:00:00

delivery_logs

--------------------------------------------------------------

id | notification_id | device_id | status | attempt_count

----------+-----------------+-----------+------------+---------------

d95b...11 | e93f...55 | f7a9...91 | delivered | 1

Best practices voor tokenbeheer

- De-dupliceren tokens: Meerdere apparaten kunnen hetzelfde token verzenden (vooral op Android); Dedupliceren over registratie.

- Token vervalafhandeling: Valideer tokens periodiek via feedbackservices (bijv. APNS -feedback, FCM niet -geregistreerde fouten) en markeer inactief.

- Soft Deletes: Gebruik `is_active` vlaggen in plaats van harde verwijderingen om weesafgiftelogboeken te voorkomen.

- Index verstandig: Apparaten moeten worden geïndexeerd op `(user_id, platform)` en `(token)` voor snelle opzoekingen en de-duping.

- Vermijd gebruikersverbindingen tijdens runtime: Houd alle targetinggegevens (tokens, opt-ins) in snel toegangswinkels zoals Redis of vooraf samengevoegde weergaven voor snelle leveringsruns.

Strategieën voor meerdere tenancen en isolatie

Als u meerdere apps of klanten ondersteunt:

- Kolomstrategie voor huurder: Voeg een kolom `tenant_id` toe aan elke tabel en handhaaf de isolatie op rijniveau.

- Logische DB -isolatie: Gebruik afzonderlijke schema’s of databases per huurder als SLA en gegevensgevoeligheid dit vereisen.

- Schrijfpadscheiding: Isoleer transactionele berichten met hoge prioriteit van bulk/marketingwachtrijen in de DB-laag om problemen met lawaaierige buren te voorkomen.

Partitioning & Scale

Op schaal, bepaalde tabellen (zoals levering_logs) zal snel groeien. Overwegen:

- Tijdgebaseerde partitionering: Shard Logs maandelijks of wekelijks om opgeblazen indexen te voorkomen.

- Archiefbeleid: Verplaats oudere logboeken naar koude opslag (bijv. S3 + Athena) voor audittoegang zonder live prestaties te beïnvloeden.

- Token cache: Synchroniseer actieve apparaattokens in Redis of DynamoDB voor high-throughput verzendingslussen.

Redis Token Cache Schema

Redis wordt gebruikt als een lees-geoptimaliseerde, in-memory token-opzoeklaag. Het vermijdt het raken van de primaire DB tijdens het verzenden van berichten en ondersteunt constante tijd opzoeken in massale gebruikers-/apparaatsets.

Primaire use cases:

- Snelle fan-out van apparaattokens per gebruiker

- Opzoeken door gebruikerssegmenten (bijv. Actieve iOS -apparaten)

- Token deduplicatie en vervalregeling

- TTL -handhaving voor inactieve of geroteerde tokens

Aanbevolen sleutelstructuur

Key: push:user::tokens Type: Redis Set Value: token:: TTL: Optional (based on last_active)

Voorbeeld:

Key: push:user:5b6ed...d1:tokens

Value: {

"token:ios:abc123token...",

"token:web:def456token...",

"token:android:xyz789token..."

}

Alternatieve sleutel voor directe token -opzoeking

Key: push:token::

Type: Hash

Fields: {

user_id: ,

app_version: ,

last_seen: ,

is_active: true/false

}

TTL: 30 days from last_seen

Voorbeeld:

Key: push:token:ios:abc123token...

Value: {

user_id: "5b6ed...d1",

app_version: "6.4.1",

last_seen: "2025-04-21T18:11:45Z",

is_active: true

}

Best practices

- Bulkbelasting van DB: Cache-warming-up taken moeten actieve tokens synchroniseren van de relationele DB bij opstarten of via CDC (wijzigen gegevensverzameling).

- Ongeldig op niet -register: Wanneer een apparaat niet is geregistreerd of token wordt gemarkeerd als ongeldig door APNS/FCM, verwijdert u de Redis -invoer.

- Houd ttl mager: Tokens die niet in 30-60 dagen worden gebruikt, moeten vervallen om cache -bloat te voorkomen.

- Set-level fanout: Gebruik Redis-sets om alle tokens per gebruiker te krijgen en voert fan-fan efficiënt uit in werkprocessen.

- Multi-tenant ondersteuning: Voorvoegsel alle sleutels met huurder-ID bij het werken in een multi-tenant-omgeving.

Deze cache vormt een aanvulling op de persistente DB-laag door te dienen als de low-latentie opzoeking tijdens de kritische verzendlus. Het helpt ook bij het segmenteren van leveringsstromen (bijvoorbeeld alleen naar gebruikers met actieve iOS -tokens) zonder dure relationele joins of volledige scans.

Hulp nodig bij het structureren van apparaatgegevens voor schaal?

Worstelen om miljoenen apparaattokens, afleveringslogboeken en opt-in voorkeuren te beheren op mobiel en web?

We kunnen u helpen bij het ontwerpen van een robuuste gegevenslaag – inclusief SQL en Redis – die uw push -systeem snel, consistent en altijd klaar houdt om te leveren.

Gedetailleerd componentontwerp

Elk deel van het systeem heeft zijn eigen verantwoordelijkheid – maar de manier waarop ze samenwerken, bepaalt of uw push -architectuur kan schalen of afbrokkelen. In dit gedeelte breken we de kerncomponentenlaag op laag: gegevensbehandeling, servicogogica, leveringswerkers en optionele UI -hooks af.

1. Gegevenslaag (opslag, toegang en caching)

- Relationele DB: Slaat kern entiteiten op (gebruikers, apparaten, voorkeuren, meldingen, leveringslogboeken).

- Redis: Dient als een snelle opzoeklaag voor actieve tokens, recente leveringen en realtime onderdrukkingsregels.

- ORM of gegevenstoegang laag: Gebruik een schone abstractie om validatie, field -standaardwaarden en schema -beperkingen af te dwingen. Vermijd het schrijven van RAW SQL in leveringslussen.

- Replica -gebruik lezen: Route Hoogvolume leesvragen (bijv. Fan-out-lookups) naar replica’s om schrijfconflicten te voorkomen.

2. Toepassingslaag (routing, filtering, segmentatie)

De app -laag is de hersenen van het systeem. Het weet wat te verzenden, naar wie, wanneer en onder welke voorwaarden. Dit is waar bedrijfslogica leeft.

- Inname API: Behandelt inkomende verzoeken van interne services (OTP, marketingtools, transactionele triggers).

- Berichtrouteringsservice: Beslist welke gebruikers/apparaten welk bericht moeten krijgen. Sluit zich aan bij Message Metadata met Redis -tokensets.

- Voorkeur en regels motor: Handhaaft opt-in/out, kanaallimieten (bijv. Max 2 marketing pings per dag) en tijdstalven (bijvoorbeeld geen berichten om 2 uur).

- Rate controller: Throttles -berichtverzending per huurder, per platform, per regio. Integreert met redis -tellers of glijdende vensteralgoritmen.

3. Integratielaag (leveringsdiensten en werknemers)

Elk platform (APNS, FCM, WebPush) heeft zijn eigenaardigheden – dus abstraheer ze niet achter een generieke interface. Behandel ze in plaats daarvan als eersteklas burgers met speciale bezorgdiensten.

- APNS Worker: Gebruikt token-gebaseerde authenticatie via JWT. Behandelt push om http/2. Beheert de TCP -verbindingspool en rentelimieten van Apple.

- FCM -medewerker: Auth via serviceaccounts. Batches berichten per onderwerp of gebruikersgroep. Sporen per apparaat fouten (bijv. Niet-geregistreerd quotum overschreden).

- Webpush -medewerker: Implementeert Vapid, coörypts payloads met behulp van elliptische curve cryptografie en stuurt rechtstreeks naar eindpunt URIS.

- Probeer de wachtrij opnieuw: Elke mislukte levering wordt opnieuw gejaagd met exponentiële back-off. DLQS (Dead-Letter wachtrijen) leggen aanhoudende storingen vast voor inspectie.

4. UI-laag (optioneel, admin-gericht)

Niet alle systemen hebben dit nodig, maar voor interne marketing-ops of productteams kan een lichtgewicht dashboard nuttig zijn.

- Campagnecomponist: Meldingen maken en plannen voor het ontploffen van gebruikerssegmenten met WYSIWYG -tools.

- Preview & targeting: Live test op testapparaten of A/B -emmers voor een volledige uitrol.

- Activiteitsaudit: Real-time dashboard laat zien wat er in de wachtrij staat, wat wordt geleverd en wat is mislukt (met redencodes).

Ontwerptips

- Breek elke werknemer in stateless microservices die horizontaal kunnen schalen.

- Gebruik niet dezelfde service voor zowel levering als feedback (bijv. APNS -ontvangsten). Isoleer die stromen voor veerkracht.

- Voeg gestructureerde houtkap- en correlatie -ID’s toe aan elke laag voor traceerbaarheid.

Overwegingen van schaalbaarheid

Push -meldingssystemen hoeven niet alleen te werken – ze moeten werken *snel *en *op schaal *, onder onvoorspelbare verkeersstieken. Dit gedeelte schetst de patronen, infrastructuurstrategieën en waarborgen die nodig zijn om de doorvoer hoog en latenties laag te houden, zelfs wanneer u miljoenen berichten per minuut verzendt.

Horizontale schaling over lagen

Elk component in het systeem – Ingeving API, router, werknemers, wachtrijen – zou horizontaal schaalbaar moeten zijn. Dit maakt onafhankelijke afstemming van knelpunten mogelijk zonder de hele pijpleiding te overbevorderen.

- API Gateways / Ingress: Voorste API’s moeten autoschaal op basis van CPU/RPS. Gebruik tariefbeperking om stroomafwaartse diensten te beschermen.

- Stateless werknemers: Leveringsmedewerkers en routers moeten staatloos en containeriseerd zijn. Gebruik Kubernetes HPA (horizontale pod autoscaler) of fargate autoscaling regels op basis van wachtrijdiepte, CPU of latentie.

- Wachtrij op diepte gebaseerde schaalverdeling: Volg de achterstandsgrootte en spawn meer werknemers wanneer diepte de drempel overschrijdt (bijv. Kafka lag of rabbitmq wachtrijlengte).

Sharding en partitionering

- Shard door user_id: Partition -levering werklast door Hashed User ID om de plaats te behouden en stelling in DB of token -cache te voorkomen.

- Kafka-partitionering: Gebruik berichtensleutels op basis van de gebruikers- of huurder -ID om meldingen naar de juiste SHARD Consumer Group te routeren.

- Database -partitionering: Voor grote tafels zoals

levering_logs, gebruik op tijd gebaseerde partitionering (bijvoorbeeld maandelijks) om de querysnelheid te behouden.

Fan-out prestatie-optimalisaties

Het echte bottleneck in hoogwaardige systemen is fan-out: een logisch bericht in kaart brengen aan duizenden of miljoenen apparaattokens.

- Redis Set Union: Gebruik Redis om alle tokens voor een gebruiker of cohort direct te krijgen met behulp van ingestelde bewerkingen.

- Batching API -oproepen: Groepsberichten per platform en batch-send (bijv. FCM ondersteunt maximaal 500 tokens per batchverzoek).

- Token Deduplicatie: Zorg ervoor dat er geen dubbele tokens in de wachtrijen van de bezorging gaan. Handhaaf uniekheid via Redis of voorverwerkingstap.

Cachingstrategie

- Tokens: Cached per gebruikers -ID. TTL vernieuwd bij levering of inloggen.

- Voorkeuren: Cache-onderdrukkingsregels (bijv. Stille uren, frequentiekappen) in Redis of Memory-Local Store.

- Throttling: Redis-tellers (Incby + TTL) of token emmers voor huurdersniveau en globale caps.

Veerkrachtpatronen

- Bulkhead isolatie: Afzonderlijke werknemerspools per platform. Een FCM -vertraging mag APN’s niet blokkeren.

- Dead-letter wachtrijen: Aanhoudend falende berichten (bijvoorbeeld ongeldige tokens) worden ontlaadd en vastgelegd voor inspectie zonder het vasthouden van leveringsstromen.

- Stroomonderbrekers: Tijdelijk stoppen met porsen voor stroomafwaartse providers die hoge faalpercentages vertonen (bijv. APNS 503S).

- Backoff -strategieën: Gebruik exponentiële back -off met jitter voor het opnieuw proberen van wachtrijen. Vermijd stampedes tijdens de provider.

Doorvoerbenchmarks (basisdoelen)

- API -inname: 2.000-10.000 RPS per knooppunt, afhankelijk van de payloadgrootte.

- Routing en fan-out: 5.000 – 20.000 apparaattoken -opzoekingen/sec met redis + partitionering.

- Doorvoer van afleveringswerkers:

- APN’s: ~ 5.000-10.000 duwt/min per verbinding (http/2 multiplex)

- FCM: ~ 12.000/min met batchverzoeken

- Webpush: ~ 2.000/min (enkel eindpunt verzendt)

Hulp nodig bij het maken van uw push -pijplijn kogelvrij?

Het bouwen voor schaal is meer dan alleen autoscalingspods. Van Kafka Tuning tot fan-out optimalisatie en stroomonderbrekers, we kunnen u helpen een push-infrastructuur te ontwerpen die niet zal knipperen-zelfs op de lanceringsdag.

Beveiligingsarchitectuur

Interface voor pushmeldingssystemen met gevoelige gebruikersgegevens, cloud -berichtenplatforms en interne services. Als beveiliging niet in elke laag wordt gebakken – van tokenopslag tot API -interacties – zet u zich op voor privacylekken, misbruikvectoren en nalevingsfalen. Dit gedeelte omvat de essentiële principes en praktijken voor beveiliging om uw systeem end-to-end te verharden.

1. Authenticatie en autorisatie

- Interne toegangscontrole: Alle interne API’s (inname, planning, routing) moeten worden beschermd met kortstondige JWT’s of wederzijdse TL’s-vooral indien toegankelijk voor diensten of omgevingen.

- API Gateway -beleid: Gebruik gateway-niveau IAM of RBAC om te beperken welke services of gebruikers verschillende soorten meldingen kunnen indienen (bijvoorbeeld transactionele versus marketing).

- Scheiding van huurders: Als u multi-tenant-systemen ondersteunt, handhaaft u strikte isolatie op basis van huurders in elke stroom-, route- en berichtverzendingsstroom.

2. Platformreferentiebeheer

Integraties van derden met APN’s en FCM vereisen geheimen die met zorg moeten worden behandeld.

- Winkelsleutels in een geheime manager: Gebruik tools zoals AWS Secrets Manager, Hashicorp Vault of GCP Secret Manager om APNS -toetsen en FCM -referenties op te slaan.

- Draai regelmatig referenties: Bouw automatisering om servicegegevens minstens driemaandelijks te roteren.

- Beperk belangrijke scopes: Gebruik serviceaccounts met de minste vereiste privileges – niet meer, niet minder.

3. Payload -beveiliging

- Neem PII niet op in push payloads: Payloads zijn vaak zichtbaar op het OS -niveau (vooral Android). Neem nooit namen, e -mailadressen of gevoelige tokens op.

- Coderen in rust en tijdens het transport: Alle gegevens in de database en Redis moeten worden gecodeerd met behulp van AES-256 of platformspecifieke AT-Rest-codering.

- Web push payload codering: Vapid-gebaseerde webpush vereist elliptische curve-codering (NIST P-256); Dit moet correct worden afgehandeld om stille leveringsfouten te voorkomen.

4. Bescherming van misbruik en rentebeperking

Niet aangevinkt, kan een push -systeem worden bewapend – ofwel om gebruikers te spammen of om de leveringsinfrastructuur te overbelasten.

- Limieten per service tarief: Gebruik redis-tellers of lekkende-bucket-algoritmen om per-API en per-huurdersnelheidskappen af te dwingen.

- Quota -handhaving: Dagelijkse berichtlimieten per gebruiker of segment (vooral voor marketing) moeten op de routeringslaag worden afgedwongen.

- AUTH-niveau auditpaden: Alle verzoeken om berichten te verzenden, moeten auditeerbaar zijn met servicenaam, gebruikersidentiteit, IP en berichtmetadata.

5. Secrets & Credential Hygiene

- Gebruik isolatie op omgevingsniveau: Deel nooit Dev-, enscenerings- en prodecreventies voor push -services.

- Schakel platte tekstlogboeken uit: Vermijd logboektokens, referenties of push -ladingen met gevoelige metagegevens in logboeken. Maskeer alles wat niet nodig is voor foutopsporing.

- Monitoring voor misbruik: Waarschuwing als gebruikspikt buiten de verwachte patronen-vooral hoog volume verzendt vanuit niet-productrekeningen of plotselinge FCM-fouten.

6. Beschermingen aan de clientzijde (minimaal maar het vermelden waard)

- App-niveau token rotatie: Zorg ervoor dat uw mobiele SDK periodiek tokens vernieuwt en deze op het uitloggen of verwijdert niet registreert.

- SSL pinning (optioneel): Als de app rechtstreeks verbinding maakt met uw backend om zich te registreren voor Push, overweeg dan om te pinnen om MITM -aanvallen te voorkomen.

Uitbreidbaarheid en onderhoudbaarheid

Een schaalbaar push-systeem is geen eenmalige build-het moet evolueren met veranderende zakelijke behoeften, platformupdates en gebruikspatronen. De architectuur moet modulair zijn, gemakkelijk uit te breiden en veilig te behouden zijn zonder regressies te introduceren. Dit gedeelte schetst hoe u uw push-infrastructuur kunt structureren voor langdurige evolutie en ontwikkelaars gezond verstand.

1. Plugin-vriendelijke architectuur

Een schone scheiding tussen kernlogica en leveringsspecifieke logica maakt snellere iteratie mogelijk zonder productiestromen te destabiliseren.

- Leverwerkers als plug -ins: Inkapselen van APN’s, FCM en webpush -logica in zelfstandige modules met een gedeelde leveringsinterface (bijv. ‘Verzenden (token, payload, config) `).

- Berichttransformatoren: Transformatiehaken per platform implementeren (bijv. APNS gebruikt `alert`, FCM gebruikt` melding` + `data`).

- Hooks voor aangepaste logica: Sta pre-send en post-send haken toe in de routeringslaag voor huurderspecifieke overschrijvingen, bijvoorbeeld aangepaste throttling of A/B-logica.

2. Schone codepraktijken

Push-codebases worden meestal stortplaatsen van platformspecifieke hacks tenzij rigoureus onderhouden.

- Strikte interfacecontracten: Gebruik wissende interfaces voor leveringsmodules en berichtdefinities (bijv. `MessagePayload`,` DeliveryContext`).

- Central Config Management: Alle rentelimieten, het opnieuw proberen van beleid en platformreferenties moeten extern worden gedefinieerd in configuratiebestanden of Secrets -managers.

- Servicegrenzen: Vermijd het koppelen van routeringslogica met leveringslogica. Behandel elk als een onafhankelijk inzetbare microservice.

3. Feature vlaggen & versiebeheer

Ondersteuning van iteratieve functieontwikkeling en achterwaartse compatibiliteit door strikte versiebeheer.

- Versie -berichtindelingen: Definieer berichtschema’s met versiebeheer (`v1`,` v2`, enz.) En ondersteuning upgrades parallel zonder oudere formaten te breken.

- Feature vlaggen voor nieuwe stromen: Rol nieuwe leveringslogica uit achter vlaggen per huurder of omgeving om de blastradius te minimaliseren.

- Soft-deprecatiemodel: Mark Legacy API’s en berichtstructuren voor geplande verwijdering; Voeg logging toe bij gebruik.

4. Test- en validatielagen

Eén gebroken payload kan cascade in leveringsfouten. Beveiliging van elke nieuwe release met sterke validatie.

- Schema -validatie: Gebruik JSON -schema of protobuf -validatie voordat u berichten voor verzending verzendt.

- Contract testen: Definieer verwachtingen voor platformmodules met behulp van PACT of vergelijkbare hulpmiddelen om integratieafwijking te voorkomen.

- Sandbox -modus: Zorg voor een droge of testmodus voor interne services om push te simuleren zonder live eindpunten te raken.

5. onderhoudbaarheid anti-patroon om te vermijden

- Hardcoderingsplatformspecifiek gedrag: Samenvatting platformlogica altijd in modules of plug -ins.

- Huurderlogica combineren met globale logica: Gebruik Scoped Services of routesniveau-omstandigheden-Inline huurderoverschrijvingen niet.

- Gebrek aan waarneembaarheid in nieuwe stromen: Nieuwe routes of modules moeten gestructureerde logboeken, statistieken en foutafhandeling vanaf de eerste dag bevatten.

Prestatie -optimalisatie

Het pushen van miljoenen meldingen gaat niet alleen over systeemontwerp – het gaat ook over hoe efficiënt elke component onder druk wordt uitgevoerd. Prestatieafstemming kan de latentie verminderen, de doorvoer verbeteren en stroomafwaartse storingen voorkomen. Deze sectie richt zich op het optimaliseren van uw pushpijplijn bij de gegevens-, verwerkings- en leveringslagen.

1. Tuning voor databasequery

- Gerichte indexen: Zorg voor indexen op `token`,` user_id` en `melding_id ‘in hun respectieve tabellen. Composiet-indexen helpen bij het uit de fan-out leest (bijv. `Device_ID, status`).

- Vraag door segment -ID, niet RAW -gebruikersfilters: Vermijd complexe join query’s tijdens het verzenden. Precompute segmenten en cache -gebruikers -ID’s of tokens in Redis.

- Verbindingspoolbeheer: Gebruik verbindingspooling (bijv. PGBouncer) om bottlenecks van stekelige aanvragen te voorkomen tijdens hoog-volume runs.

2. Token fan-out efficiëntie

- Batch leest van Redis: Gebruik bij het ophalen van tokens per gebruiker of per segment altijd `smembers` +` mget` in pipelined batches.

- Bulk leveringslussen: Proces in batches (bijv. 500-1.000 tokens per iteratie) om netwerkoverhead per apparaat te voorkomen.

- Payload -sjabloon caching: Cache weergegeven payloads (titel/body/metadata) bij het uitzenden naar vergelijkbare apparaatgroepen.

3. Async -verwerking en afstemming van werknemers

- Bericht Prefetch: Gebruik het tellingen van de prefetch (bijv. Kafka `fetch.min.bytes`, RabbitMQ` prefetch_count`) om de inactieve tijd in leveringswerkers te verminderen.

- Leveringsbatching: FCM en WebPush staan een zekere mate van batching toe-gebruik dit bij het verzenden van niet-gepersonaliseerde campagnes.

- Worker Pooling per regio: Voer geïsoleerde werknemerspools (of pods) per geografische regio uit om cross-region latentie te minimaliseren en de cloud-uitgangskosten te verlagen.

4. Beperkende snelheid en stroomcontrole

- Glijdende raamtellers: Gebruik Redis Lua-scripts om snelheidscaps op platformniveau te implementeren (bijv. Max 100K/sec per platform of huurder).

- Wachte throttling: Vertrek het bericht van de makelaar dynamisch af van de makelaar wanneer foutenprijzen pieking (bijv. APNS 429S of FCM quota -fouten).

- Backoff Control: Gebruik bij portries gejuistde exponentiële back -off om te voorkomen dat donderende kuddes mislukte leveringen.

5. Prestaties voor frontend weergeven (alleen webduw)

- Minimalisatie van de lading: Webpush -berichten moeten compact zijn – Strip extra metagegevens, houd tot ~ 2KB of minder voor de snelste weergave.

- Routing op de klik: Gebruik queryparameters of diepe links in webpush `click_action` om snellere in-app of browser-ervaringen te stimuleren.

- Lazy render verrijking: Toon waar mogelijk minimale meldingsinhoud en laad volledige details nadat de gebruiker klikt.

6. Monitoring- en feedback -lusoptimalisatie

- Spoor latentie percentielen: Controleer niet alleen de gemiddelde levertijd. Spoor P90, P99 om traagheid met lange tail te vangen.

- Feedbackfiltering: Inname alleen kritieke leveringsfeedback (token verlopen, apparaat onbereikbaar) in plaats van alles, om analysebelasting te verminderen.

- Statistische aggregatie: Gebruik tools zoals Prometheus met labels van kardinaliteit om metrische explosie onder hoog volume te voorkomen.

Teststrategie

Een systeem dat naar miljoenen apparaten duwt, kan niet vertrouwen op handmatige QA- of geïsoleerde tests. Levering is asynchroon, afhankelijk van derden en realtime-wat betekent dat testen gelaagd, geautomatiseerd en faalwetend moet zijn. Deze sectie omvat hoe het testen in alle fasen te benaderen: lokale ontwikkeling, CI -pijpleidingen en productieharding.

1. Eenheidstests

Eenheidstests zorgen ervoor dat interne logica zich correct gedraagt over routing, tokenresolutie en het genereren van lading.

- Testrouteringslogica: Valideer de targeting van de gebruikersrichtingen, handhaving van de voorkeur en het splitsen van platform.

- Mock token -sets: Simuleren Redis/DB-reacties met nep-tokentoewijzingen om ventilator-uit-logica te testen.

- Schema -validatie: Zorg ervoor dat payloads voldoen aan platformschema’s-alert/berichtstructuur, platformspecifieke velden, enz.

2. Integratietesten

- Wachtrijen in het geheugen: Voer KAFKA/RabbitMQ lokaal uit (of gebruik testcontainers) om de volledige stroom van producent-tot-consumer te simuleren.

- Valse leveringsadapters: Mock APN’s, FCM en WebPush met lokale eindpunten die gevallen van succes/falen simuleren, waaronder throttling of niet -geregistreerde apparaten.

- End-to-end leveringsstroom: Beweert dat een bericht dat is ingediend bij de inname API met succes de bespotte leveringsadapter bereikt via wachtrij, regels engine en werknemersdiensten.

3. Contract testen

Contracttests valideren dat de afleveringsmodules van het platform niet breken vanwege externe API- of berichtindelingswijzigingen.

- Gebruik pact of soortgelijke gereedschap: Definieer contractverwachtingen voor elke leveringsmodule (APNS, FCM, WebPush).

- Versie -schema’s: Bewaar berichtindelingen versie en verifieer achterwaartse compatibiliteit bij wijzigingen.

4. Load & Sstringtests

Push-systemen moeten standhouden onder real-world volumes. Laadtests helpen bij het valideren van de wachtrijprestaties, Redis -hits en DB -stelling.

- Simuleren campagnes: Injecteer 10m+ mock -berichten in de wachtrij om de schaalverdeling van werknemers, foutenpercentages en berichtlatentie te observeren.

- Spike- en Soak -tests: Valideer hoe het systeem omgaat met korte bursts (100K/min) versus langdurige stabiel volume (10K/sec gedurende uren).

- Isoleer langzame diensten: Monitor welke componenten (bijv. Routing, DB schrijft, tokencache) vertragen onder volume.

5. CI -pijpleidingdekking

- Test elk duwpad: Neem leveringslogica, fallback -petries en faalbehandeling op als onderdeel van geautomatiseerde CI -runs.

- Gebruik synthetische tokens: Genereer dummy APN’s/FCM -tokens voor testpayloads (gebruik nooit echte in CI).

- Lint -schema’s: Auto-valideren alle payloads tegen platformspecling voordat ze samenvoegen met behulp van JSON-schema of ProtobUF-cheques.

6. Chaos & Fault Injection (Geavanceerd)

Voor teams die op massale schaal werken, introduceert u gecontroleerde chaos om randjes te vangen voordat gebruikers dat doen.

- DRAP DRAP DREVENDE BEWEGINGEN: Simuleren netwerkvertragingen of verlies tussen werknemer en push provider.

- Injecteren slechte ladingen: Corrupte velden of schema -contracten om het systeem te bevestigen en het probleem te isoleren.

- Inslikkering van de gasfeedback: Vertragingsbezorgingsontvangsten om ervoor te zorgen dat het systeem niet blokkeert of crasht vanwege ontbrekende statusupdates.

DevOps en CI/CD

Push-meldingssystemen omvatten meerdere services, wachtrijen, databases en integraties van derden. Die complexiteit vereist een geautomatiseerde, betrouwbare DevOps -pijplijn die met vertrouwen kan bouwen, testen, implementeren en terugdraaien. Dit gedeelte omvat de tooling en praktijken die nodig zijn om uw leveringspijplijn snel, veilig en waarneembaar te houden.

1. CI/CD -pijpleidingontwerp

- CI -stages: Lint → Unit Tests → Contracttests → Integratietests → Schema -validatie → Docker Build

- CD -fasen: Canarische implementatie → Gezondheidscontroles → Metrics gate → volledige uitrol

- Pre-implementatieschema diff: Auto-controle database-migraties voor compatibiliteit en potentiële downtime-problemen (bijvoorbeeld het toevoegen van niet-nulkolommen zonder standaardwaarden).

2. Implementatiestrategieën

- Blauwgroene implementatie: Voor stateful services zoals planners of inname-API’s, gebruik blauwgroen om verkeer zonder downtime te wisselen.

- Canarische implementatie: Voor bezorgwerkers en routers, implementeer je in een kleine pod -subset (bijv. 5%) en observeer ze voor leveringsfouten of platform API -fouten.

- Progressieve uitrols: Rol functies uit met behulp van config -vlaggen (geen codetakken), zodat wijzigingen tijdens runtime kunnen worden geschakeld.

3. Infrastructuur als code (IAC)

- Gebruik Terraform of Pulumi: Beheer infra over AWS/GCP voor wachtrijen, DBS, Redis -clusters en VPC’s.

- Dynamische omgevingen: Spin-up geïsoleerde testomgevingen op kenmerktakken om duwstromen end-to-end te testen zonder vervuiling van enscenering.

- Secrets Automatisering: Winkel Push Service -referenties in geheime managers en injecteren in pods via verzegelde geheimen of zijcarars.

4. Gitops & configuratiebeheer

- Versie -configs: Bewaar de tarieflimieten, poging het beleid en huurderoverbruggen in GIT – niet hard gecodeerd in diensten.

- Configmap-aangedreven gedrag: Injecteer platformspecifieke instellingen in werknemers (bijv. APNS poolgrootte, webpush TTL) via Kubernetes ConfigMaps.

- Rolback via Git keren terug: Als een configuratie of vlag de productie breekt, maakt Gitops snel terugdraaien met auditeerbaarheid.

5. Validatie van release en controles na de implementatie

- Haken na de implementatie: Trigger gezondheidscontroles of rooktests automatisch na de uitrol.

- Bekijk bezorgstatistieken: Monitor leveringspercentages, foutcodes en wachtrijgrootte in de 15-30 minuten na de implementatie voordat u volledig schaalt.

- Fail-fast gedrag: Als leveringsfouten piekeren (bijvoorbeeld ongeldige tokens, 403s van FCM), de inzet van auto-halt en de oprichting op de hoogte stellen.

Hulp nodig bij het verzenden van pushmeldingen met vertrouwen?

Het bouwen van een robuust push -systeem is één ding – het werk in productie zonder angst is een ander. Als u hulp nodig hebt bij het instellen van een CI/CD-pijplijn, implementaties beveiligen en rollback-safe-releases voor uw pushstack, hebben we het eerder gedaan.

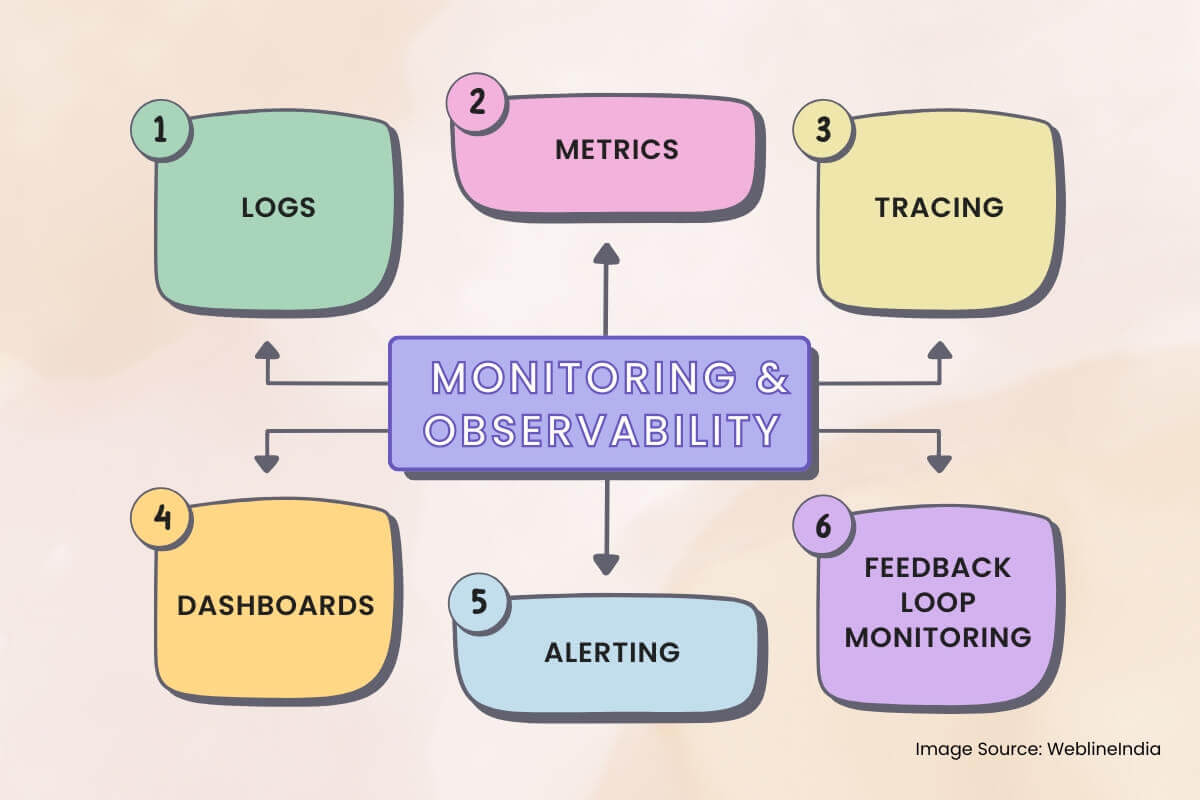

Monitoring en waarneembaarheid

Push-meldingssystemen zijn asynchroon, gedistribueerd en vertrouwen op black-box externe services zoals APN’s en FCM. Zonder de juiste waarneembaarheid blijven fouten onopgemerkt, druppels voor stille aflevering treden op en debuggen wordt giswerk. Dit gedeelte schetst wat je moet controleren, hoe je berichtenstroom kunt traceren en hoe je zinvolle meldingen kunt bouwen.

1. Logboeken

- Gestructureerde houtkap: Gebruik JSON -logboeken met velden zoals `message_id`,` device_id`, `platform`,` status` en `error_code` voor elke fase van levering.

- Correlatie -ID’s: Taglogboeken van inname → Routing → Leverwerkers met een gedeeld verzoek-ID voor end-to-end traceerbaarheid.

- Redact gevoelige velden: Masker tokens, gebruikers-ID’s of payloadinhoud in logboeken-vooral op gedeeld of platforms van derden.

2. Statistieken

Statistieken vertellen je wat er op macroniveau gebeurt. Verzamel ze over diensten om platformbrede problemen vroegtijdig te detecteren.

- Levering doorvoer: Berichten verzonden per platform, per minuut. Basis door `huurder ‘,` prioriteit’ en `message_type` (transactionele/marketing).

- Leveringssucces/foutenpercentage: Spoor `geleverd ‘,` droped`, `mislukt’, en` prey ’emmers – met tags voor hoofdoorzaak (`niet geregistreerd’,` rate_limited`, `invalid_token`).

- Wachtrij latentie: Tijd van enqueue naar werknemersopname en werknemer tot platformbevestiging.

3. Traceren

Sporen zijn van cruciaal belang wanneer berichten stil verdwijnen of vertraagd worden. Integratie van gedistribueerde tracering in elke interne service.

- Trace overspanningen: Inname → Redis/token -lookup → Voorkeurscontrole → Wachtrij enqueue → Worker Dispatch → Platformlevering.

- Link logboeken aan sporen: Neem sporen -ID’s op in logboeken en dashboard -links (bijvoorbeeld van Kibana tot Jaeger/Tempo).

- Bemonsteringssnelheidscontrole: Traceer altijd OTP’s en mislukte berichten; Gebruik probabilistische steekproef voor campagnes om overhead te verminderen.

4. Dashboards

Real-time dashboards helpen operators en op-call-ingenieurs begrijpen systeemgezondheid in één oogopslag.

- Platform leveringstatus: Real-time tellingen van verzonden, mislukte, verpleegde berichten per platform (APNS/FCM/WebPush).

- Wachtrijdiepte: Live zichtbaarheid in routerings- en leveringswachtrijen – stijgende wachtrijdiepte duidt op verzadiging of stroomafwaartse vertraging.

- Feedback signaalanalyse: Visualiseer token invalidaties, rate limieten hit en feedbackontvangsten van pushplatforms.

5. Alleert

- Failure Spike Alerts: Als mislukte berichten een drempel overschrijden (absolute telling of foutenpercentage %) in een schuifvenster.

- Leveren latentiewaarschuwingen: Als P95 -latentie de SLA overschrijdt (bijv. OTP> 3S, campagne> 30s).

- Groei van de dode wachtrij: Waarschuwing als DLQ’s beginnen met het verzamelen van berichten – signaleert een persistent faalpad.

6. Monitoring van feedbacklus

Platforms zoals APN’s en FCM verzenden feedback asynchroon. Deze bonnen hebben hun eigen pijplijn nodig.

- Feedback -inname werknemers: Consumeer en bewaar niet-geregistreerde tokengebeurtenissen, leveringsfouten en tariefbepalingsadviezen.

- Metrics Extractie: Geaggregeerde feedbacksignalen in dashboards en foutklasse distributies.

- Token Cleanup Automation: Trigger -achtergrondopdrachten om stale tokens te deactiveren of te verwijderen op basis van platformfeedback.

Afwegingen en ontwerpbeslissingen

Elke architecturale keuze komt met afwegingen. Het ontwerpen van een schaalbaar pushmeldingssysteem betekent constant in evenwicht brengen van latentie versus doorvoer, eenvoud versus flexibiliteit en betrouwbaarheid versus kosten. Deze sectie schetst enkele van de belangrijkste beslissingen die in het hele systeem zijn genomen en de alternatieven die werden overwogen.

1. Platformspecifieke werknemers versus uniforme leveringsinterface

- Beslissing: Afzonderlijke APN’s, FCM en WebPush in geïsoleerde bezorgservices.

- Afweging: Meer complexiteit van code en implementatie, maar veel betere isolatie van falen, schaalbaarheid afstemming en debugabiliteit per platform.

- Alternatief: Een generieke uniforme interface kan code -duplicatie verminderen, maar zou een uitgebreide voorwaardelijke logica vereisen en de waarneembaarheid verminderen.

2. Redis-tokencache versus DB-alleen-levering

- Beslissing: Gebruik Redis voor actieve token-lookup en fan-out tijdens berichtroutering.

- Afweging: Vereist achtergrondsynchronisaties en ongeldige logica, maar verbetert drastisch de doorvoer van de levering en vermindert de DB -belasting.

- Alternatief: Directe DB-lezingen tijdens Fan-out zouden de architectuur vereenvoudigen, maar zou niet op campagnepolumes schalen.

3. Kafka voor berichtwachtrijen versus eenvoudiger wachtrijen

- Beslissing: Gebruik Kafka of gelijkwaardig gedistribueerd logboek voor routerings- en leveringswachtrijen.

- Afweging: Steiler leercurve en infra management last, maar zorgt voor een hoge duurzaamheid, hertries en schaalbaarheid van consumenten.

- Alternatief: RabbitMQ/sqs zijn gemakkelijker te bedienen, maar bieden minder flexibiliteit voor grootschalige ventilator- of leveringsgaranties.

4. Dode letterwachtrijen versus inline pogt lussen opnieuw

- Beslissing: Gebruik speciale DLQ’s voor permanente storingen en beperk terdelpartij tot 2-3 pogingen.

- Afweging: Iets hogere operationele overhead maar voorkomt de wachtrijblokkering en maakt async -herstelverwerking mogelijk.

- Alternatief: Inline opnieuw proberen met back -off is gemakkelijker te implementeren, maar het risico lopen om stroomafwaartse systemen te overbelasten of berichten uit te stellen.

5. Tijdgebaseerde DB-partitionering versus vlakke tafelgroei

- Beslissing: Partition -leveringslogboeken per maand om indexgrootte en bewaarbeleid te regelen.

- Afweging: Meer gecompliceerde queryroutering en potentiële fragmentatie van gegevenstoegang.

- Alternatief: Een monolithische tabel zou in eerste instantie gemakkelijker zijn, maar zou de prestaties aantasten en het opruimen van retentie ingewikkeld zijn.

6. Afwegingen in functiesnelheid versus leveringsgaranties

- Beslissing: Afzonderlijke transactie van marketingstromen bij elke laag – inname, wachtrijen, bezorgdiensten.

- Afweging: Meer routeringscomplexiteit en extra infrastructuur, maar voorkomt dat niet-kritiek verkeer kritische paden afbreukt (bijv. OTP’s).

- Alternatief: Een uniforme stroom vereenvoudigt routering maar riskeert de impact van klanten tijdens zware campagneladingen of platform throttling.

7. Bekende technische schuldgebieden

- Malde token opruimen: Heeft optimalisatie of automatisering nodig via inname van feedbacklus.

- Segment pre-materialisatie: Momenteel is net in de tijd tijdens het verzenden van campagne; moet worden verplaatst naar achtergrondopdrachten.

- Beoordeel limiter schalen: Gedeelde Redis-instanties voor tariefcontrole kunnen een knelpunt worden onder campagnes op wereldschalige schaal.

Wat deze architectuur goed doet

Het ontwerpen van een schaalbaar push -meldingssysteem gaat niet alleen over het verzenden van berichten – het gaat erom de juiste berichten te leveren, naar de juiste apparaten, betrouwbaar en op schaal. Deze architectuur is speciaal gebouwd om die uitdaging aan te gaan, door de doorvoer, controle en onderhoudbaarheid van een hoog gedistribueerd systeem aan te gaan.

Belangrijke afhaalrestaurants

- Ontkoppelde architectuur: Inname, routing en levering zijn netjes gescheiden voor veerkracht en schaalbaarheid.

- Platformisolatie: Elke push -service (APNS, FCM, WebPush) wordt afgehandeld door een toegewijde werknemer die is afgestemd op zijn eigenaardigheden.

- Token caching en fan-out: Redis bevoegd een snelle tokenresolutie, waardoor de levering van high-throughput-berichten mogelijk is zonder uw primaire DB te hameren.

- Gegevens duurzaamheid: Berichtwachtrijen zorgen voor betrouwbare levering, zelfs wanneer platform -API’s mislukken, waarbij DLQ’s randgevallen vastleggen voor latere inspectie.

- Overal waarneembaarheid: Traceren, statistieken en gestructureerde logs maken debugging-leveringspijpleidingen en stromen op gebruikersniveau praktisch op schaal.

- Feature-safe-uitbreidbaarheid: Modulaire componenten, haakgebaseerde logica en schemaversie stellen het systeem in staat om te evolueren zonder legacy paden te breken.

Kansen voor toekomstige verbetering

- Fijnkorrelige smoorzetting: Caps per gebruiker of per apparaat kunnen de overnotificatie verder verminderen en de UX verbeteren.

- Segment Materialisatie Pijplijn: Het wegladen van segmentatie naar vooraf geplande achtergrondbanen zou campagnelanceringen nog sneller maken.

- Regionale levering optimalisatie: Geo-lokale leveringswerkers kunnen latentie- en cloud-uitgangskosten verlagen door platformoproepen dichter bij de oorsprong van de gebruiker te houden.

Dit systeem zal niet alleen werken – het zal onder druk staan, schaal met groei en onderhoudbaar blijven naarmate use cases evolueren. Dat is wat wegwerpmeldingsscripts scheidt van een realtime leveringsplatform voor productie-kwaliteit.

Heb je hulp nodig om je push -meldingssysteem op dit niveau te krijgen?

Het ontwerpen en schalen van een multi-platform push-meldingsarchitectuur is geen weekendproject. Als u vanaf de eerste dag iets betrouwbaars wilt bouwen of wilt repareren wat al scheuren toont, kunnen we helpen het systeem te ontwikkelen dat uw gebruikers verwachten.

Referenties: hoor het rechtstreeks van onze wereldwijde klanten

Onze ontwikkelprocessen leveren dynamische oplossingen om zakelijke uitdagingen aan te gaan, kosten te optimaliseren en digitale transformatie te versnellen. Door experts ondersteunde oplossingen versterken klantloyaliteit en online aanwezigheid, terwijl bewezen succesverhalen laten zien hoe innovatieve applicaties echte problemen oplossen. Onze gewaardeerde klanten wereldwijd hebben het al ervaren.

Prijzen en Erkenningen

Hoewel tevreden klanten onze grootste motivatie zijn, heeft erkenning van de industrie aanzienlijke waarde. WeblineIndia is consistent toonaangevend in technologie, met prijzen en onderscheidingen die onze uitmuntendheid bevestigen.

OA500 Wereldwijde outsourcingbedrijven 2025, door Outsource Accelerator

Topsoftware-ontwikkelingsbedrijf, door GoodFirms

Beste fintech-productoplossingsbedrijf – 2022, door GESIA

Bekroond als – Beste app-ontwikkelingsbedrijf in India 2020, door SoftwareSuggest