Wanneer de markt wordt aangestuurd door digitalisering, valt de transformerende kracht van Large Language Models (LLM’s) niet te ontkennen. Van het automatiseren van de klantenservice tot het genereren van complexe code: LLM’s beloven ongekende efficiëntie en innovatie. Toch wordt het streven naar innovatie op het gebied van kunstmatige intelligentie (AI) voor veel grote ondernemingen, vooral die welke actief zijn in sterk gereguleerde sectoren als de financiële sector, de gezondheidszorg en de overheid, belemmerd door een aanzienlijk, ononderhandelbaar obstakel: gegevensprivacy en -beveiliging.

De standaardarchitectuur voor het inzetten van geavanceerde LLM’s omvat vaak outsourcing aan grote publieke cloudproviders. Hoewel handig, betekent dit model inherent dat gevoelige bedrijfsgegevens, die worden gebruikt om deze modellen te trainen, te verfijnen en ermee te communiceren, de veilige grenzen van het interne netwerk van het bedrijf moeten verlaten. Deze blootstelling is niet alleen een risico; het is een directe schending van regelgevende mandaten (zoals GDPR, HIPAA en diverse nationale datalokalisatiewetten) en intern compliancebeleid.

Dit is waar het concept van on-premise LLM’s naar voren komt, niet alleen als alternatief, maar als de essentiële architectuur voor ondernemingen die vastbesloten zijn om privacy voorop te stellen en er vaak voor kiezen om huur een toegewijd team in voor veilige AI-implementatie. Het rechtstreeks inzetten van LLM’s op interne hardware van het bedrijf is de definitieve oplossing om absolute datasoevereiniteit te bereiken, waardoor bedrijfseigen informatie nooit de fysieke en digitale controle van de organisatie verlaat.

Klaar om bedrijfsgegevens privé te houden terwijl u AI gebruikt? Praat vandaag nog met onze LLM-experts.

Het grote conflict: innovatie versus compliance

De business case voor AI is duidelijk: concurrentievoordeel, kostenreductie en superieure besluitvorming. Het bedrijfslandschap wordt echter steeds meer bepaald door strikt databeheer.

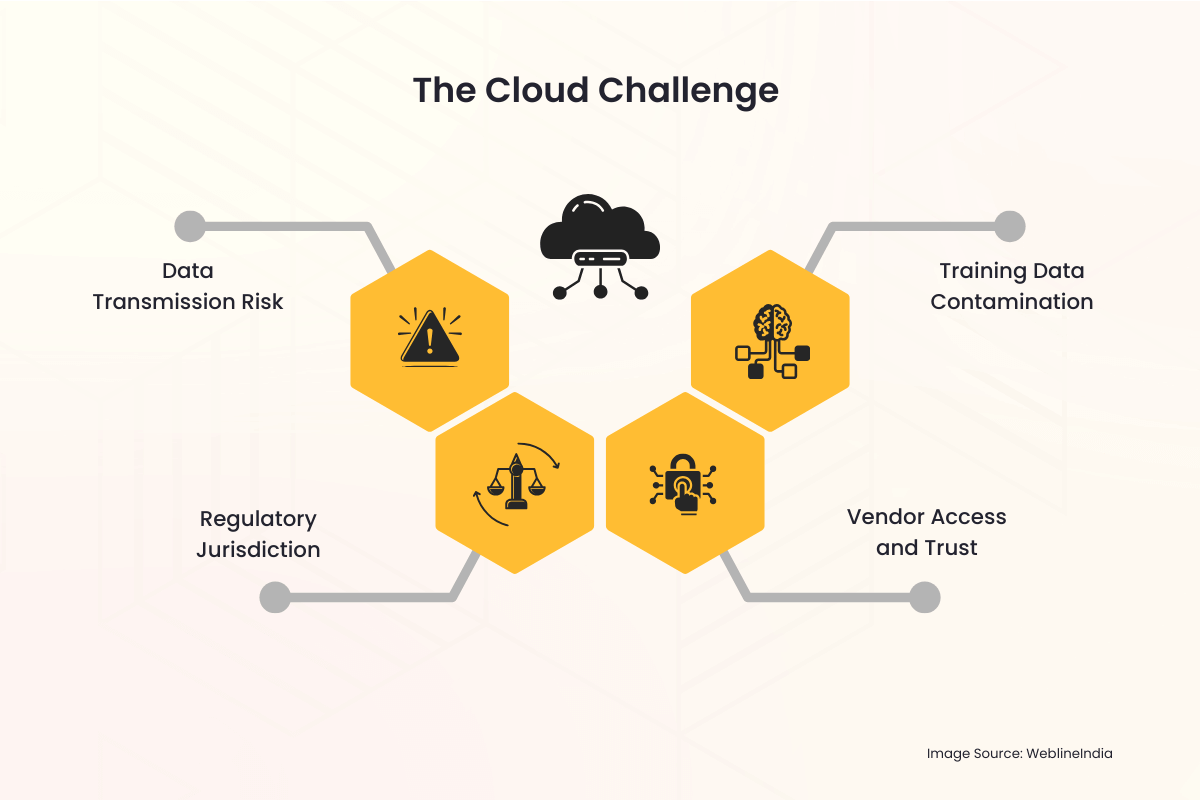

De cloud-uitdaging

Wanneer een onderneming een in de cloud gehoste LLM-service gebruikt, komen er onmiddellijk verschillende privacyvalkuilen naar voren:

- Risico op gegevensoverdracht: Elke zoekopdracht, elke invoer en de resulterende uitvoer moet het openbare internet doorkruisen en tijdelijk op een server van derden staan. Dit hele proces is een potentiële vector voor onderschepping of ongeautoriseerde toegang.

- Regelgevende jurisdictie: Gegevens die zijn opgeslagen in een ander land of rechtsgebied dan waar de onderneming vandaan komt, kunnen leiden tot complexe, vaak tegenstrijdige internationale wetten. Het realiseren van datalokalisatie – de eis dat data binnen specifieke grenzen moeten worden opgeslagen en verwerkt – wordt vrijwel onmogelijk bij een multinationale cloudprovider.

- Toegang en vertrouwen van leveranciers: Bedrijven worden gedwongen te vertrouwen op de beveiligingsprotocollen, de toegangscontroles voor medewerkers en het retentiebeleid van de cloudleverancier. Hierdoor wordt een derde partij geïntroduceerd in de meest gevoelige gegevensworkflows.

- Besmetting van trainingsgegevens: Als de eigen gegevens van een bedrijf worden gebruikt om een model dat in de cloud wordt gehost te verfijnen, bestaat altijd het risico dat modelgewichten onbedoeld of zelfs kwaadwillig worden gedeeld of de reacties van modellen die door andere tenants worden gebruikt, beïnvloeden, wat tot gegevenslekken kan leiden.

Deze zorgen zijn niet theoretisch. Opvallende incidenten op het gebied van datalekken en de strenge straffen die door mondiale regelgevende instanties worden opgelegd, hebben de privacy van gegevens van een IT-hoofdpijn tot een kernprioriteit in de bestuurskamer verheven. Voor organisaties die persoonlijk identificeerbare informatie (PII), beschermde gezondheidsinformatie (PHI) of geclassificeerd intellectueel eigendom (IP) verwerken, is het risicoprofiel van LLM’s in de publieke cloud vaak simpelweg te hoog om te accepteren.

De oplossing ter plekke: controle en soevereiniteit terugwinnen

Het on-premise LLM-implementatiemodel pakt deze diepgaande privacyproblemen direct aan en lost deze op door de gehele AI-infrastructuur (de hardware, de software, de modelgewichten en de trainingsgegevens) onder de directe en exclusieve fysieke en digitale controle van de onderneming te plaatsen.

1. Absolute datasoevereiniteit

Datasoevereiniteit betekent dat gegevens alleen onderworpen zijn aan de wetten en bestuursregels van het land of de organisatie waar ze worden verzameld en opgeslagen.

- Geografische controle: Bij een on-premise opstelling bevindt de hardware zich fysiek in het datacenter van de onderneming, vaak in een specifiek land of zelfs in een specifieke beveiligde ruimte. Dit voldoet intrinsiek aan de vereisten voor datalocatie en datalokalisatie, waardoor naleving van regelgeving zoals de AVG van de EU of verschillende nationale veiligheidswetten eenvoudig wordt.

- Nul externe transmissie: Alle gegevensverwerking, modeltraining en gevolgtrekking (het opvragen van het model) gebeuren binnen de bedrijfsfirewall. Gevoelige aanwijzingen en eigen interne documenten die door de LLM worden gebruikt, verlaten de beveiligde netwerkomgeving nooit.

2. Verbeterde beveiliging en compliance

Dankzij een implementatie op locatie kan het beveiligingsteam het bestaande, robuuste beveiligingsframework van de organisatie rechtstreeks op het AI-systeem toepassen.

- Bestaande beveiligingsinfrastructuur: De LLM-oplossing kan naadloos worden geïntegreerd met gevestigde bedrijfsbeveiligingstools, waaronder inbraakdetectiesystemen (IDS), geavanceerde firewalls, oplossingen voor identiteits- en toegangsbeheer (IAM) en systemen voor de preventie van gegevensverlies (DLP). Dit is vaak uitgebreider en op maat gemaakt dan de beveiligingslagen die een generieke clouddienst biedt.

- Aangepaste toegangscontrole: De toegang tot het model zelf kan strikt worden gecontroleerd via interne Active Directory van het bedrijf of andere IAM-oplossingen van het bedrijf. Alleen geautoriseerde medewerkers, afdelingen of applicaties kunnen met het model communiceren, en toegangslogboeken worden intern bewaard voor auditdoeleinden.

- Vereenvoudigde auditing: Naleving van de regelgeving vereist vaak gedetailleerde audittrails. Door de volledige stack in eigendom te hebben, kan de onderneming gedetailleerde logboeken bijhouden van elk modelgebruik, elke trainingstaak en elke beheerdersactie, waardoor nalevingscontroles veel eenvoudiger worden voor interne en externe auditors.

3. Bescherming van intellectuele eigendom

Voor ondernemingen ligt de echte waarde van een LLM niet alleen in het fundamentele model (zoals Llama, Mistral of andere), maar in de gepatenteerde kennis die wordt gebruikt om het te verfijnen. Deze afstemmingsgegevens vormen het IP-adres van de organisatie.

- Geïsoleerde trainingsomgeving: Wanneer de verfijning op locatie wordt uitgevoerd, worden de bedrijfseigen datasets (zoals klantgegevens, interne rapporten, patentaanvragen of productspecificaties) nooit naar een derde partij geüpload. De resulterende, verfijnde modelgewichten, die effectief de kennis van het bedrijf coderen, worden ook intern bewaard, waardoor wordt voorkomen dat externe partijen ongeautoriseerde toegang krijgen tot het kern-IP.

Heeft u een conforme, lokale LLM nodig die is afgestemd op uw branche? Laten we het veilig bouwen.

De praktische aspecten van on-premise LLM-architectuur

Hoewel de privacyvoordelen overtuigend zijn, vereist het inzetten van een LLM op locatie een zorgvuldige planning en investering in de onderliggende technologie.

De hardware-uitdaging: de behoefte aan GPU’s

LLM’s zijn rekenintensief. De belangrijkste factor voor een efficiënte implementatie op locatie is gespecialiseerde hardware, voornamelijk GPU’s (Graphics Processing Units).

- Inferentievermogen: Om real-time gebruikersvragen (gevolgtrekking) te kunnen verwerken, heeft de LLM snel geheugen en parallelle verwerkingskracht nodig die wordt geleverd door GPU’s, vaak in speciale serverracks.

- Training en verfijning: Een model helemaal opnieuw trainen is een enorme onderneming, maar het verfijnen (een bestaand model aanpassen) is haalbaar met minder, krachtige GPU’s. De investering in deze hardware is een kapitaaluitgaven (CapEx) die de lopende operationele uitgaven (OpEx) van cloudservicekosten vervangt, waardoor kostenvoorspelbaarheid op de lange termijn wordt geboden.

De softwarestapel

De volledige on-premise oplossing omvat meer dan alleen hardware; het vereist een robuuste software- en orkestratielaag:

- Modelselectie: Het kiezen van een open-source, commercieel levensvatbare fundamentele LLM (zoals Llama 3, Mistral, enz.) die legaal kan worden gedownload en ingezet op particuliere infrastructuur is de eerste stap.

- Containerisatie (bijvoorbeeld Docker/Kubernetes): Om de complexe implementatie te beheren, worden de LLM en zijn afhankelijkheden vaak verpakt in containers. Orkestratietools zoals Kubernetes beheren het cluster van GPU-servers en zorgen zo voor schaalbaarheid en hoge beschikbaarheid, vergelijkbaar met een private cloudomgeving, vaak geïmplementeerd door ondernemingen die Huur cloud- en DevOps-ingenieurs in om een dergelijke complexe AI-infrastructuur te beheren.

- Interne API-laag: Binnen de firewall is een applicatieprogrammeersinterface (API) ingebouwd, waardoor interne applicaties (chatbots, codeerassistenten, data-analisten) aanwijzingen naar de LLM kunnen sturen zonder ooit het openbare internet aan te raken.

Het overwinnen van de datalatentie en het bestuur

Lokale oplossingen elimineren de latentie van gegevens en verbeteren het beheer van interne gegevensbronnen.

- Realtime interne gegevenstoegang: LLM’s hebben vaak toegang nodig tot de meest actuele interne gegevens, een proces dat Retrieval-Augmented Generation (RAG) wordt genoemd. Door op locatie te zijn, heeft de LLM toegang met lage latentie en hoge bandbreedte tot interne databases, datameren en documentopslagplaatsen, wat leidt tot nauwkeurigere, contextuelere en actuelere resultaten zonder de noodzaak van gegevensoverdracht via internet.

- Uniform bestuur: Het data governance-team kan één set regels toepassen op de gegevens, de RAG-index en de LLM zelf, waardoor een uniforme en eenvoudiger compliance-omgeving ontstaat.

Strategische voordelen voor privacybewuste industrieën

De overstap naar een on-premise architectuur is een strategische beslissing die wijst op een sterke toewijding aan naleving van de regelgeving en het vertrouwen van de klant.

| Industrie | Primair privacyprobleem | Voordeel van een oplossing op locatie |

| Gezondheidszorg (HIPAA) | Bescherming van PHI en patiëntendossiers. | Zorgt ervoor dat PHI binnen een veilige, speciale omgeving blijft; vereenvoudigt auditlogboeken die nodig zijn voor naleving. |

| Financiële diensten (AVG, PCI-DSS) | Klant-PII, transactiegegevens, algoritmisch IP-adres. | Garandeert datalocatie en lokalisatie; beschermt bedrijfseigen handelsalgoritmen en klantenscoremodellen tegen blootstelling van buitenaf. |

| Overheid / Defensie | Geclassificeerde, zeer gevoelige of staatsgeheime informatie. | Maakt implementatie mogelijk in omgevingen met luchtspleten (netwerken die fysiek geïsoleerd zijn van het internet), waardoor absolute veiligheid wordt gegarandeerd. |

| Productie / R&D | Intellectueel eigendom (IP), eigen ontwerpen en bedrijfsgeheimen. | Voorkomt het lekken van unieke productieprocessen of productontwerpdetails die worden gebruikt tijdens RAG of fine-tuning. |

De kloof overbruggen met professionele IT-services

De beslissing om over te stappen naar een lokale LLM-architectuur is weliswaar strategisch verantwoord voor de privacy, maar brengt ook aanzienlijke operationele complexiteit met zich mee. Het vereist gespecialiseerde vaardigheden op het gebied van hardware-aankoop (met name krachtige GPU’s), het opzetten van een robuuste, gecontaineriseerde omgeving (zoals Kubernetes), het afstemmen van modellen op gevoelige gegevens en het integreren van de LLM met bestaande bedrijfssystemen. Dit is waar een vertrouwde IT-servicepartner van onschatbare waarde wordt.

WeblineIndia is een gerenommeerd IT-bureau in de VS dat gespecialiseerd is in het leveren van de uitgebreide expertise die nodig is om deze transitie naadloos te doorlopen. Ze bieden end-to-end professionele diensten, van het ontwerpen van de optimale on-premise hardwarestack, afgestemd op uw gevolgtrekkings- en trainingsbehoeften, tot het beheren van de veilige implementatie van open-source LLM’s binnen uw firewall.

Cloudexperts bij de ontwikkelingshub van WeblineIndia in India beschikken over diepgaande ervaring op het gebied van veilige cloudinfrastructuur en AI-implementatie. Bedrijven kunnen hun privé LLM-omgeving snel inzetten, waardoor strikte naleving van het interne compliancebeleid wordt gegarandeerd en de time-to-value wordt versneld zonder de noodzaak om dure, gespecialiseerde interne AI-engineeringteams in te huren en op te leiden, door gebruik te maken van ervaren externe ontwikkelaars. Dit partnerschap transformeert een uitdagend infrastructuurproject in een beheersbaar, strategisch uitgevoerd initiatief, volledig toegewijd aan het behoud van uw absolute datasoevereiniteit.

De toekomst is privé en veilig met WeblineIndia

De opwinding rond LLM’s mag de fundamentele verantwoordelijkheid van bedrijven om de gevoelige gegevens die hun zijn toevertrouwd te beschermen niet overschaduwen. Voor elke grote organisatie waar compliance, privacy en datasoevereiniteit niet onderhandelbaar zijn (dat wil zeggen de meest succesvolle ondernemingen van vandaag), is het LLM-model van de publieke cloud een fundamentele mismatch.

De verschuiving naar LLM-implementatie op locatie vertegenwoordigt een duidelijk pad voorwaarts. Het is de noodzakelijke investering in hardware en expertise die de veiligheidskloof dicht, voldoet aan de strengste mondiale regelgevingsvereisten en die de onderneming uiteindelijk in staat stelt het volledige, transformerende potentieel van kunstmatige intelligentie te benutten zonder ooit haar meest waardevolle bezit in gevaar te brengen: haar data.

Neem contact op met WeblineIndia IT-adviesdiensten om te ontsnappen aan de inherente risico’s van de cloud en de controle over hun AI-stack terug te winnen om moedig te innoveren. U kunt er zeker van zijn dat het vertrouwen van de klant, de nalevingsstatus en de intellectuele eigendom absoluut veilig zijn binnen hun eigen soevereine domein.

Sociale hashtags

#OnPremiseLLM #Gegevenssoevereiniteit #EnterpriseAI #AICompliance #PrivacyEerst #VeiligeAI #LLMBeveiliging #EnterpriseTechnologie

Wilt u volledige controle over uw AI-stack zonder gegevensrisico? Begin met WeblineIndia.

Veelgestelde vragen

Referenties: hoor het rechtstreeks van onze wereldwijde klanten

Onze ontwikkelprocessen leveren dynamische oplossingen om zakelijke uitdagingen aan te gaan, kosten te optimaliseren en digitale transformatie te versnellen. Door experts ondersteunde oplossingen versterken klantloyaliteit en online aanwezigheid, terwijl bewezen succesverhalen laten zien hoe innovatieve applicaties echte problemen oplossen. Onze gewaardeerde klanten wereldwijd hebben het al ervaren.

Prijzen en Erkenningen

Hoewel tevreden klanten onze grootste motivatie zijn, heeft erkenning van de industrie aanzienlijke waarde. WeblineIndia is consistent toonaangevend in technologie, met prijzen en onderscheidingen die onze uitmuntendheid bevestigen.

OA500 Wereldwijde outsourcingbedrijven 2025, door Outsource Accelerator

Topsoftware-ontwikkelingsbedrijf, door GoodFirms

Beste fintech-productoplossingsbedrijf – 2022, door GESIA

Bekroond als – Beste app-ontwikkelingsbedrijf in India 2020, door SoftwareSuggest