De De opkomst van kunstmatige intelligentie (AI) Hulpmiddelen heeft een revolutie teweeggebracht in industrieën, waardoor de efficiëntie en automatisering wordt verbeterd. Een van de meest aanhoudende uitdagingen in AI -onderzoek en ontwikkeling is echter het Black Box -probleem in AI. Deze kwestie omvat AI -systemen die beslissingen nemen zonder transparante verklaringen te geven voor die beslissingen. Inzicht in hoe dit probleem de ontwikkeling van AI -technologieën en de beschikbare mogelijke oplossingen beïnvloedt, is cruciaal voor het opbouwen van vertrouwen in AI en de toepassingen ervan.

Verward over AI-besluitvorming? Laat onze experts u helpen verklaringbare AI te implementeren!

Het Black Box -probleem in AI: een overzicht

In de kern verwijst de zwarte doos in AI naar de dekking van besluitvormingsprocessen binnen veel modellen voor machine learning, met name diepe leermodellen. Deze modellen kunnen nauwkeurige resultaten opleveren, maar hun interne werking is vaak te complex om te interpreteren. Het Black Box-probleem in AI wordt bijzonder problematisch in velden met hoge inzet zoals gezondheidszorg, financiën en wetshandhaving, waar het begrijpen waarom een beslissing werd genomen, van cruciaal belang is.

- AI -tools zoals diepe neurale netwerken blinken uit in patroonherkenning, maar zijn vaak te ingewikkeld voor mensen om volledig te begrijpen.

- De complexiteit ontstaat omdat deze modellen meerdere lagen van berekeningen en transformaties omvatten, waardoor het moeilijk is om te traceren hoe invoergegevens veranderen in uitvoerbeslissingen.

De impact van het Black Box -probleem in AI

Het gebrek aan transparantie in besluitvorming creëert op verschillende manieren uitdagingen:

- Verantwoording: in gevallen waarin AI -systemen onjuiste of schadelijke beslissingen nemen, is het moeilijk om de exacte oorzaak van het probleem te bepalen, wat verantwoording en vertrouwen bemoeilijkt.

- Bias: Zonder inzicht in hoe AI-systemen werken, wordt het moeilijker om eventuele vooroordelen in het besluitvormingsproces van het model te identificeren en te corrigeren.

- Regelgevende zorgen: naarmate AI blijft evolueren, staan regelgevers voor uitdagingen om ervoor te zorgen dat deze technologieën voldoen aan ethische normen en wetten. Gebrek aan interpreteerbaarheid belemmert de regelgeving.

Inzicht in de behoefte aan verklaringbare AI

Om het Black Box -probleem in AI te verminderen, draaien onderzoekers zich om te verklaren om AI (XAI) te verklaren. Uitlegbare AI streeft naar een duidelijke, begrijpelijke verklaring over hoe AI -systemen tot hun beslissingen komen. Dit is cruciaal bij het bevorderen van vertrouwen, het waarborgen van eerlijkheid en het handhaven van verantwoordingsplicht.

Worstelen met AI -transparantie? Ontvang AI -oplossingen die duidelijk en verantwoordelijk zijn.

Hoe verklaarbaar AI helpt

- Transparantie: met uitlegbare AI hebben gebruikers toegang tot inzichten in hoe AI -systemen gegevens verwerken en voorspellingen doen.

- Vertrouwen en adoptie: omdat belanghebbenden AI-besluitvorming kunnen begrijpen, hebben ze eerder geneigd AI-tools te vertrouwen op kritieke toepassingen.

- Ethische beslissingen: verklaarbare AI bevordert ethische besluitvorming door vooroordelen of discriminerende patronen in AI-systemen te onthullen.

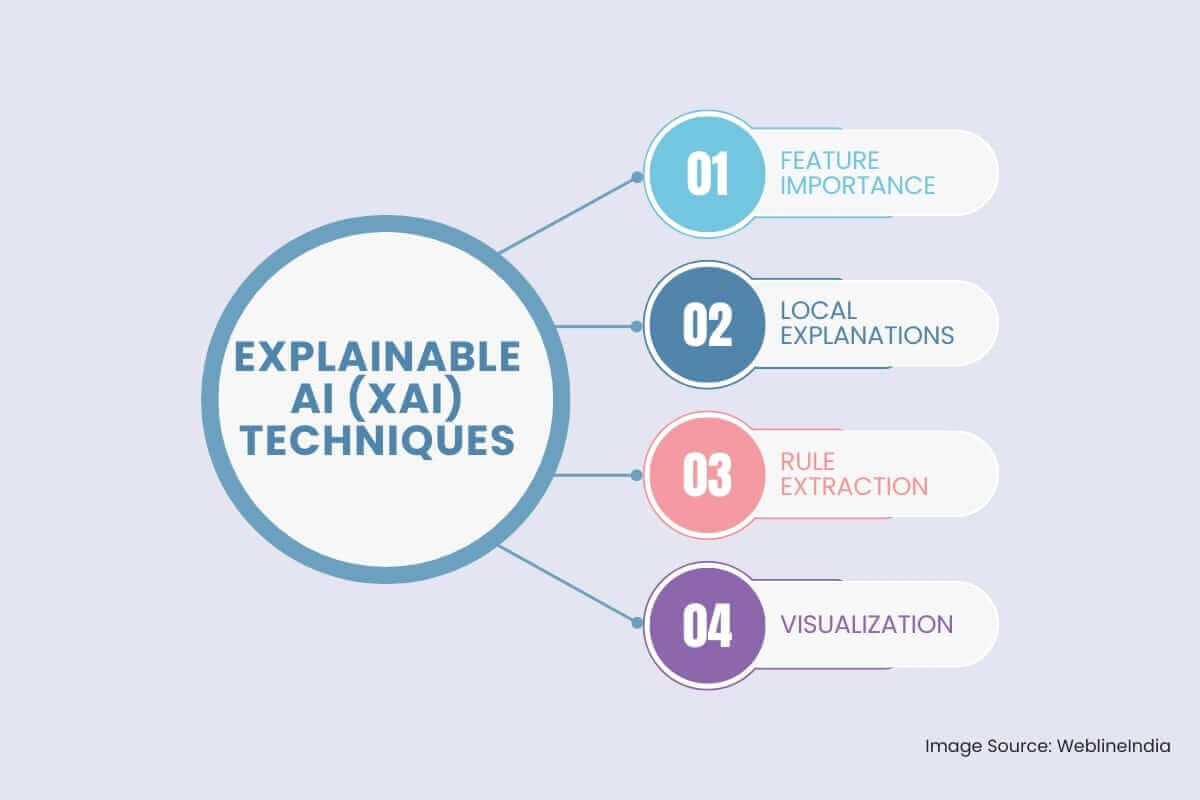

Uitlegbare AI (XAI) -technieken

Om het Black Box -probleem aan te pakken, is het veld van uitlegbare AI (XAI) naar voren gekomen. XAI richt zich op het ontwikkelen van technieken die de besluitvormingsprocessen van AI-modellen transparanter en begrijpelijker maken. Sommige belangrijke XAI -technieken zijn:

- Functie belang: Deze techniek is bedoeld om de invoerfuncties te identificeren die de grootste invloed hebben op de output van het model.

Het belang van permutatie: deze methode beoordeelt het belang van een functie door zijn waarden willekeurig te schuiven en te observeren hoe dit de prestaties van het model beïnvloedt.

SHAP (Shapley Additieve verklaringen): deze op games gebaseerde benadering biedt een meer genuanceerd begrip van het belang van functies door de output van het model toe te schrijven aan individuele functies.

- Lokale verklaringen: Deze methoden bieden verklaringen voor individuele voorspellingen van het model.

Kalk (lokale interpreteerbare model-agnostische verklaringen): deze techniek benadert het gedrag van het model lokaal rond een specifiek gegevenspunt met behulp van een eenvoudiger, meer interpreteerbaar model, zoals een lineair model of een beslissingsboom.

Anchors: deze methode identificeert een reeks voorwaarden (ankers) die, indien aanwezig, een specifieke voorspelling met hoge waarschijnlijkheid garanderen.

- Regelextractie: Deze benadering omvat het hakken van mens-leesbare regels uit het getrainde model.

Beslissingsboominductie: deze techniek omvat het bouwen van een beslissingsboom, die gemakkelijk kan worden geïnterpreteerd door mensen, om de voorspellingen van het model te benaderen.

Regelgebaseerde systemen: deze systemen vertegenwoordigen expliciet de kennis van het model in de vorm van if-then regels.

- Visualisatie: Visualiseren van de interne werking van een AI-model kan waardevolle inzichten bieden in zijn besluitvormingsproces.

Activeringskaarten: deze visualisaties benadrukken de gebieden van een afbeelding waarop het model zich richt bij het maken van een voorspelling.

Aandachtsmechanismen: deze technieken kunnen worden gebruikt om de delen van een tekst of volgorde te visualiseren waar het model op let bij het maken van een voorspelling.

Het overwinnen van uitdagingen bij het ontwikkelen van verklaarbare AI

Hoewel uitlegbare AI een veelbelovende oplossing biedt, komt het implementeren van effectief met zijn eigen uitdagingen met zich mee:

- Afweging tussen nauwkeurigheid en verklaarbaarheid: enkele van de krachtigste AI-tools, zoals diepe neurale netwerken, kunnen een hoge nauwkeurigheid bieden, maar ten koste van moeilijker te verklaren zijn. Het balanceren van deze twee factoren blijft een belangrijke uitdaging.

- Complexiteit van modellen: veel AI -technologieën vertrouwen op geavanceerde algoritmen die inherent moeilijk te verklaren zijn. Onderzoek blijft onderzoeken hoe deze complexe modellen interpreteerbaar te maken zonder hun prestaties op te offeren.

- Schaalbaarheid: omdat AI -tools op grotere schalen worden ingezet, kan het behouden van effectieve uitleg voor elke beslissing die het systeem genomen overweldigend worden.

De rol van AI -technologieën bij het oplossen van het Black Box -probleem

AI -technologieën evolueren voortdurend om meer transparante en interpreteerbare systemen te creëren. Van het ontwikkelen van betere algoritmen tot het verbeteren van datavisualisatietechnieken, deze technologieën zijn de weg vrijgemaakt voor oplossingen voor het Black Box -probleem in AI.

- Hybride modellen: het combineren van zowel uitlegbare als black-box-modellen kan een balans bieden tussen prestaties en transparantie. Het gebruik van eenvoudigere modellen voor besluitvorming, terwijl het afhankelijk is van meer complexe modellen voor voorspellingen kan bijvoorbeeld zowel nauwkeurigheid als interpreteerbaarheid mogelijk maken.

- Gegevensvisualisatie: effectieve gegevensvisualisatie kan AI-modellen transparanter maken door het besluitvormingsproces in een toegankelijk formaat te tonen. Interactieve tools kunnen gebruikers AI -systemen kunnen opvragen voor verdere uitleg.

Conclusie: streven naar transparantie bij AI-besluitvorming

Het Black Box -probleem in AI biedt een belangrijk obstakel voor de bredere acceptatie en ethische implementatie van AI -technologieën. Hoewel krachtig, moeten AI -tools transparanter worden om ervoor te zorgen dat hun beslissingen begrijpelijk, betrouwbaar en eerlijk zijn. Als AI -ontwikkeling Voortgang, het gebied van verklaarbare AI blijft evolueren, onderzoekers onderzoeken innovatieve oplossingen om deze uitdagingen te overwinnen, waardoor het mogelijk is om te genieten van de voordelen van AI -technologieën zonder in gevaar te brengen op verantwoording of ethiek.

Sociale hashtags

#UitlegbareAi #aitransparantie #BlackBoxProbleem #xai #Trustinai #MachinElarning #DeeplePearning #aimodellen #shap #lime

Wil je AI transparanter en betrouwbaarder maken voor uw bedrijf?

Veelgestelde vragen

Referenties: hoor het rechtstreeks van onze wereldwijde klanten

Onze ontwikkelprocessen leveren dynamische oplossingen om zakelijke uitdagingen aan te gaan, kosten te optimaliseren en digitale transformatie te versnellen. Door experts ondersteunde oplossingen versterken klantloyaliteit en online aanwezigheid, terwijl bewezen succesverhalen laten zien hoe innovatieve applicaties echte problemen oplossen. Onze gewaardeerde klanten wereldwijd hebben het al ervaren.

Prijzen en Erkenningen

Hoewel tevreden klanten onze grootste motivatie zijn, heeft erkenning van de industrie aanzienlijke waarde. WeblineIndia is consistent toonaangevend in technologie, met prijzen en onderscheidingen die onze uitmuntendheid bevestigen.

OA500 Wereldwijde outsourcingbedrijven 2025, door Outsource Accelerator

Topsoftware-ontwikkelingsbedrijf, door GoodFirms

Beste fintech-productoplossingsbedrijf – 2022, door GESIA

Bekroond als – Beste app-ontwikkelingsbedrijf in India 2020, door SoftwareSuggest