Push-Benachrichtigungen sind überall-ob es sich um eine Breaking-Nachrichtenwarnung, ein Wetter-Update oder eine Nachricht “Ihre Bestellung hat” -Meldung versendet handelt. Sie steigern das Engagement und bieten den Benutzern Echtzeitwert. Das Entwerfen eines Push -Benachrichtigungssystems, mit dem Milliarden von Nachrichten über Plattformen hinweg verarbeitet werden können, während es leistungsfähig und zuverlässig bleibt, ist jedoch kein Spaziergang im Park.

Moderne Anwendungen müssen häufig zeitempfindliche Informationen auf Benutzer auf mobilen Geräten (iOS/Android), Desktops (MacOS/Windows) und Browsern (Chrome, Firefox, Safari) weitergeben. Jede dieser Plattformen verfügt über eigene Protokoll, Lieferbeschränkungen und Ratengrenzen. Schichten Sie nun Geschäftsregeln wie Benutzerpräferenzen, Segmentierung, Drosselung, Wiederholung und Lokalisierung-Sie starren plötzlich auf ein nicht trivial verteiltes System.

Eine grundlegende Implementierung kann in geringer Größe oder in einem Nachweis des Konzepts funktionieren. Aber was passiert, wenn Sie 50 Millionen Benutzer mit mehreren Geräten haben und Marketing alle paar Minuten Kampagnen auf 10% Ihres Publikums ausführen möchte? Hier fällt die Dinge auseinander, wenn Ihre Architektur von Grund auf nicht dafür gebaut wurde.

Dieser Leitfaden geht durch den architektonischen Blaupause, ein skalierbares, fehlertolerantes und erweiterbares Push-Benachrichtigungssystem zu bauen. Es konzentriert sich auf die plattformübergreifende Lieferung (APNs, FCM, Webpush), Systeme auf Systemebene wie Warteschlangen und Wiederholungen sowie die Einstellung der Leistung unter hoher Belastung.

Ziel ist es, Sie mit den mentalen Modell- und Entwurfsmustern auszustatten, die zum Aufbau eines Systems erforderlich sind, das nicht unter Druck geschnallt ist – und sich mit Ihren Produktanforderungen weiterentwickeln kann.

Systemanforderungen

Funktionale Anforderungen

Im Kern muss das Push-Benachrichtigungssystem Nachrichten an Endbenutzergeräte liefern. Aber “Lieferung” reicht nicht aus. Folgendes sollte das System tatsächlich tun:

- Multi-Plattform-Lieferung: Unterstützen Sie den Apple Push Benachrichtigungsdienst (APNS), Firebase Cloud-Messaging (FCM) und Web Puscol (WPP).

- Geräteregistrierung und Verwaltung: Speichern Sie Geräte -Token, die Benutzern, Plattformen und Anwendungen zugeordnet sind.

- Targeting -Funktionen: Senden Sie Nachrichten an bestimmte Benutzer, Gerätegruppen, Benutzersegmente oder alle Benutzer (Sendung).

- Planung: Lassen Sie die Nachrichten sofort oder zu einer zukünftigen geplanten Zeit gesendet.

- Ratenbegrenzung: Drosselklappennachrichten basierend auf Plattformbeschränkungen oder internen Geschäftsregeln.

- Logik wiederholen: Automatisch wiedervergebene Lieferungen mit exponentiellen Backoff- oder benutzerdefinierten Wiederholungsrichtlinien.

- Benutzereinstellungen: Respektieren Sie den Opt-in/Opt-Out-Status, die ruhigen Stunden oder spezifischen Kanaltypen (z. B. Werbe- und Transaktions-Transaktions-Typen).

- Auditing & Analytics: Erfolge/Misserfolg der Lieferung/Misserfolg, öffnet (wenn möglich) und diagnostische Metadaten für die Fehlerbehebung.

Nicht funktionierende Anforderungen

Dies sind das Rückgrat-Anliegen-Zulassung dieser, und Ihre Plattform wird unter Verwendung der realen Welt zusammenbrechen.

- Skalierbarkeit: Das System muss Spikes von Millionen von Nachrichten pro Minute verarbeiten.

- Verfügbarkeit: Targeting 99,99% Verfügbarkeit, insbesondere für kritische Pfade wie Geräteregistrierung und Lieferpipelines.

- Latenz: Sub-Sekunden-Verarbeitung für Transaktionen (z. B. OTP, Sicherheitswarnungen); Tolerable Delay (5-15s) für Batch-Marketing-Nachrichten.

- Haltbarkeit: Nachrichten dürfen im Falle eines Knotens oder eines Dienstfehlers nicht verloren gehen.

- Sicherheit: End-to-End-Schutz von Benutzerdaten, Authentifizierung für Dienste von dritten Parteien, Verschlüsselung von Nutzlasten beim Transport und in Ruhe.

- Multi-Messen: Fähigkeit, mehrere Anwendungen/Kunden mit isolierten Daten- und Lieferpipelines zu unterstützen.

Einschränkungen und Annahmen

Die Definition von Grenzen ist entscheidend, um architektonische Ambiguität zu verringern.

- Angenommen, die Plattform -Push -Anbieter (APNs, FCM, Webpush) sind extern und fungieren als schwarze Boxen mit veröffentlichten SLAs.

- Nachrichtennutzlasten sind klein (2KB – 4 KB), wobei die meisten Logik auf der Client -Seite behandelt werden.

- Es gibt eine vorhandene Benutzeridentitätsplattform, die Geräte-zu-Benutzer-Zuordnungen und Benutzerpräferenzen enthüllt.

- Das System garantiert nicht die Lieferung – sobald es an APNs/FCM abfiel, ist die Verantwortung ihre.

- Das System wird in einer Cloud-nativen Umgebung ausgeführt (Kubernetes oder verwaltete Container, Autoscaling usw.).

Kerngebrauchsfall und Lieferlandschaft

Bevor Sie in die Architektur eintauchen, ist es wichtig zu klären, wofür dieses System gelöst wird – weil „Push -Benachrichtigungen“ in verschiedenen geschäftlichen Kontexten unterschiedliche Dinge bedeuten. In diesem Abschnitt wird die reale Betriebslandschaft untersucht, die das System nutzt und wie sich die Skala auf die Entwurfswahl auswirkt.

Hauptgeschäftsnutzungsfall

Definieren wir einen typischen, hochwirksamen Anwendungsfall: Eine groß angelegte B2C-E-Commerce-Plattform möchte Echtzeit-Push-Benachrichtigungen über mobile und web-Benachrichtigungen senden, um das Benutzungsbetrieb voranzutreiben, Benutzer von Bestellstatus-Updates zu alarmieren oder verhaltensbasierte Erinnerungen (z. B. verlassene Cart-Nudges). Es gibt auch interne Anwendungsfälle – Ops -Warnungen, Betrugssysteme und Partnerintegrationen. Der Kerntreiber ist jedoch mit hohem Durchsatz, benutzerorientiertes Messaging mit unterschiedlichen Kritikalitätsniveaus.

Benutzer und Benachrichtigungskanäle

Die Endbenutzer des Systems sind nicht nur Kunden, die die Push -Nachrichten erhalten. Es gibt mehrere Schauspieler:

- Vermarkter: Führen Sie große Kampagnen, Zeitplan- und Segment -Benutzerkohorten aus.

- Produktteams: Trigger-Kontextbenachrichtigungen aus App-Verhalten (In-App-Meilensteine, Gamification Loops).

- Backend -Systeme: Automatisch Transaktionsmeldungen wie OTPs, Zahlungsbestätigungen oder Lieferbenachrichtigungen auslösen.

Am empfangenden Ende kann jeder Benutzer mehrere Gerätetypen haben:

- Mobile Apps: iOS über APNs und Android über FCM.

- Webbrowser: Über das Web-Push-Protokoll (VAPID-basiert), normalerweise für Desktop-/Laptop-Benutzer.

- Dienste von Drittanbietern: In einigen Fällen sind Integrationen mit Lieferkanälen von Drittanbietern wie WhatsApp- oder In-App-Messaging-Overlays beteiligt-aber aus dem Spielraum für dieses System.

Überlegungen zu Volumen und Skalierung

Hier ist, was das System in der realen Skala erwarten wird:

- 100 m+ registrierte Geräte über Plattformen hinweg mit 5–10% täglich aktiv.

- Transaktionsereignisse: 3–5m Nachrichten/Tag mit SLAs mit harter Latenz (z. B. OTP innerhalb von 3 Sekunden).

- Kampagnen: Burst sendet in weniger als 5 Minuten an 10 bis 20 Millionen Benutzer, die häufig über Dashboard- oder Backend -Job -Warteschlangen ausgelöst werden.

- Peak -Parallelität: 200k+ Nachrichten/Minute während schwarzer Ereignisse vom Typ Freitag oder während viraler Spikes.

Hier geht es nicht darum, eine Nachricht an einen Benutzer zu senden. Es geht darum, Millionen von maßgeschneiderten Nachrichten über Tausende von Knoten zu senden, mit Zuverlässigkeit, Wiederholungen und minimaler Verzögerung. Das Design muss dieser Art der dynamischen Arbeitsbelastung berücksichtigen, was bedeutet, dass die Kerndienste, verteilte Warteschlangen und die horizontale Skalierbarkeit auf jeder Ebene sind.

High-Level-Systemarchitektur

Die Architektur für ein skalierbares Push -Benachrichtigungssystem dreht sich um drei Prinzipien: Entkopplung, Parallelität, Und plattformspezifische Lieferung. Im Maßstab fallen monolithische Designs auseinander. Diese Architektur umfasst einen Microservices-basierten, ereignisgesteuerten Ansatz, der Milliarden von Nachrichten mit minimalem Engpässen throtten, throtten, wiederholen und prüfen können.

Gehen wir durch die Kernsubsysteme, den Datenfluss und die plattformspezifischen Abstraktionen, die alles zum Laufen bringen.

Komponentenübersicht

Die Architektur ist in die folgenden logischen Komponenten unterteilt:

- Einnahme -API: Empfängt Nachrichtenanfragen – Batch oder Transactional – Eingabetaste, befasst sich mit Nachrichten in die Pipeline.

- Routing -Motor: Schauen Sie sich Geräte aus, spalteten Nachrichten pro plattformübergreifendes Paar auf, um sie in die jeweiligen Warteschlangen zu verwandeln.

- Plattform -Zustellungsarbeiter: Dedizierte Microservices für APNs, FCM und Webpush. Diese handeln Verbindungsmanagement, Wiederholungen, Chargen und Ratenbegrenzung.

- Message Warteschlange (Broker -Ebene): High-Throughput-Broker (z. B. Kafka, Rabbitmq oder Google Pub/Sub) für die Entkopplung von Produzenten aus der Lieferlogik.

- Geräteregistrierungsdienst: Speichert Gerätemetadaten, Benutzerzuordnungen, Token-Gültigkeit, Plattformtyp und Opt-In-Status.

- Preference & Rules Engine: Bewertet Benutzerbenachrichtigungseinstellungen, Unterdrückungsregeln (ruhige Stunden, Frequenzkappen) oder kanalspezifische Überschreibungen.

- Scheduler: Für verzögerte oder zeitwindbasierte Nachrichtenzustellung.

- Überwachung und Rückkopplungsschleife: Erfasst Lieferungen, Fehler und Analysen auf Plattformebene auf Plattformebene; Griff APNS -Feedback, FCM -Deinstallationen usw.

Hochrangiger Architekturdiagramm

+------------------+

| Ingestion API |

+--------+---------+

|

v

+---------------------+

| Routing Engine |

+--------+------------+

|

v

+---------------------+

| Message Broker |

| (Kafka / RabbitMQ) |

+--------+------------+

|

+--------------------------+--------------------------+

| | |

v v v

+-------------+ +--------------+ +----------------+

| APNs Worker | | FCM Worker | | WebPush Worker |

+------+------+ +------+-------+ +--------+-------+

| | |

v v v

+------------------+ +---------------------+ +------------------------+

| Apple Push Notif | | Firebase Cloud Msg | | Web Push Service (VAPID)|

| Service (APNs) | | (FCM) | | |

+------------------+ +---------------------+ +------------------------+

+------------------------+ +--------------------------+

| Device Registry Svc | <------> | User Preferences Engine |

+------------------------+ +--------------------------+

+---------------------------+

| Scheduler / Campaign Svc |

+---------------------------+

+---------------------------+

| Monitoring / Analytics |

| (Logs, Receipts, Metrics) |

+---------------------------+

Wichtige architektonische Muster

- Ereignisgesteuerte Architektur: Der Nachrichtenfluss ist vollständig asynchron. Hersteller (APIs, interne Systeme) werden von der Lieferung unter Verwendung von Pub/Sub- oder Messaging -Warteschlangen entkoppelt.

- Plattformspezifische Abstraktion: Die Arbeiter sind pro Plattform zugeschnitten. Jeder verwaltet seine eigenen Zinsgrenzen, Nutzlastformate, Wiederholungen und API -Auth.

- Backdruckunterstützung: Nachrichtenmakler müssen Überspannungen bearbeiten, ohne Daten zu löschen. Pufferung, Warteschlangen und Autoscaling der Verbraucher sind eingebaut.

- Idempotenz & Deduplizierung: Nachrichten müssen eindeutige IDs tragen, um Probleme mit doppelter Send zu vermeiden, insbesondere bei Wiederholungen.

- Versagensisolation: Ein Plattformausfall (z. B. APNs) sollte keine Nachrichten für FCM/Webpush kaskaden und abbilden. Jeder Arbeiterpool ist isoliert und fehlertolerant.

Diese Architektur kann jede Komponente horizontal unabhängig skalieren – mehr Arbeiter für APNs während der iOS -Kampagnen -Bursts oder mehr Routingknoten während der Einnahmespitzen. Jede Stufe kann überwacht, gedrosselt oder neu gestartet werden, ohne sich auf das vollständige System auswirken.

Benötigen Sie Hilfe bei der Architektierung in Skala?

Planen Sie, Push-Benachrichtigungen über Millionen von Benutzern zu veranlassen, aber nicht sicher, wie die Lieferung oder die Verwaltung von plattformübergreifenden Macken skaliert werden kann?

Wir können Ihnen helfen, ein kattiert getestetes Push-System zu entwerfen, das auf das Wachstum und die Leistungsanforderungen Ihres Produkts zugeschnitten ist.

Datenbankdesign und Token -Management

Push -Benachrichtigungssysteme live oder sterben durch ihre Fähigkeit, Millionen von Geräte -Token, Benutzerpräferenzen und Nachrichtenzuständen effizient zu verwalten. In diesem Abschnitt wird ein Datenbankschema entworfen, das horizontal skaliert, die Lieferkonsistenz beibehält und Echtzeit-Targeting und Filterung unterstützt.

Kerndatenentitäten

Zumindest sind die folgenden Einheiten erforderlich:

- Benutzer: Logische Benutzeridentität (UID), an ein oder viele Geräte gebunden.

- Geräte: Plattformspezifische Geräteaufzeichnungen mit Tokens, App-Version, zuletzt gesehen usw.

- Vorlieben: Benutzerspezifische Opt-in/Opt-out-Flags, Kanaleinstellungen, ruhige Stunden usw.

- Nachrichten: Geschichte der gesendeten Benachrichtigungen, deren Lieferstatus und Metadaten zur Fehlerbehebung/Prüfung.

Entitätsbeziehungsmodell (ERD)

So beziehen sich die Unternehmen auf hohem Niveau:

+--------+ 1 +---------+ M +-----------+ | Users |---------------<| Devices |--------------->| Preferences| +--------+ +---------+ +-----------+ | | | | 1 | | | M | v v +-------------+ +--------------+ | Notifications| | Delivery Logs| +-------------+ +--------------+

Tabellenschemata (vereinfacht)

users (

id UUID PRIMARY KEY,

email TEXT UNIQUE NOT NULL,

created_at TIMESTAMP DEFAULT NOW()

)

-- Index: unique email lookup

-- CREATE UNIQUE INDEX idx_users_email ON users(email);

devices (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

platform ENUM('ios', 'android', 'web') NOT NULL,

token TEXT UNIQUE NOT NULL,

app_version TEXT,

last_active TIMESTAMP,

is_active BOOLEAN DEFAULT true,

created_at TIMESTAMP DEFAULT NOW()

)

-- Indexes:

-- CREATE INDEX idx_devices_user_platform ON devices(user_id, platform);

-- CREATE UNIQUE INDEX idx_devices_token ON devices(token);

preferences (

id UUID PRIMARY KEY,

user_id UUID NOT NULL REFERENCES users(id) ON DELETE CASCADE,

channel ENUM('transactional', 'marketing') NOT NULL,

enabled BOOLEAN DEFAULT true,

quiet_hours JSONB,

updated_at TIMESTAMP DEFAULT NOW()

)

-- Index: preference lookup

-- CREATE UNIQUE INDEX idx_prefs_user_channel ON preferences(user_id, channel);

notifications (

id UUID PRIMARY KEY,

title TEXT,

body TEXT,

payload JSONB,

scheduled_at TIMESTAMP,

priority ENUM('high', 'normal', 'low') DEFAULT 'normal',

created_by TEXT,

created_at TIMESTAMP DEFAULT NOW()

)

delivery_logs (

id UUID PRIMARY KEY,

notification_id UUID NOT NULL REFERENCES notifications(id) ON DELETE CASCADE,

device_id UUID NOT NULL REFERENCES devices(id) ON DELETE CASCADE,

status ENUM('pending', 'delivered', 'failed', 'dropped') DEFAULT 'pending',

attempt_count INT DEFAULT 0,

response_code TEXT,

error_message TEXT,

delivered_at TIMESTAMP

)

-- Indexes:

-- CREATE INDEX idx_logs_device_status ON delivery_logs(device_id, status);

-- CREATE INDEX idx_logs_notif_status ON delivery_logs(notification_id, status);

Beispielreihen (nur veranschaulichend)

users

--------------------------------------------------------------

id | email

--------------------------------------+-------------------------

5b6e...d1 | user@example.com

devices

--------------------------------------------------------------

id | user_id | platform | token | is_active

----------+----------+----------+---------------+------------

f7a9...91 | 5b6e...d1| ios | abc123token...| true

preferences

--------------------------------------------------------------

id | user_id | channel | enabled | quiet_hours

----------+----------+----------------+---------+-------------

c1f3...72 | 5b6e...d1| marketing | false | {"start":"22:00","end":"07:00"}

notifications

--------------------------------------------------------------

id | title | priority | scheduled_at

----------+----------------+----------+--------------

e93f...55 | Order Shipped! | high | 2025-04-22 13:00:00

delivery_logs

--------------------------------------------------------------

id | notification_id | device_id | status | attempt_count

----------+-----------------+-----------+------------+---------------

d95b...11 | e93f...55 | f7a9...91 | delivered | 1

Best Practices des Token-Verwaltungen

- De-Duplikat-Token: Mehrere Geräte senden möglicherweise das gleiche Token (insbesondere auf Android). bei der Registrierung deduplizieren.

- Token -Ablaufhandhabung: Validieren Sie problemlos Token über Feedback -Dienste (z. B. APNS -Feedback, FCM nicht registrierte Fehler) und markieren inaktiv.

- Weiche Löschungen: Verwenden Sie `is_active` -Flags anstelle von harten Löschungen, um verwaiste Lieferprotokolle zu vermeiden.

- Index mit Bedacht: Geräte sollten auf `(user_id, plattform)` und `(token)` für schnelle Lookups und De-De-Enttäuschen indexiert werden.

- Vermeiden Sie die Benutzerverbindungen zur Laufzeit: Halten Sie alle Zieldaten (Token, OPT-Ins) in Fast-Access-Läden wie Redis oder vorgesprochenen Ansichten für Hochgeschwindigkeitsbereitstellungsläufe auf.

Multi-Tenancy- und Isolationsstrategien

Wenn Sie mehrere Apps oder Clients unterstützen:

- Mieterspaltenstrategie: Fügen Sie jeder Tabelle eine Spalte `mandant_id` hinzu und erzwingen Sie die Isolation auf Zeilenebene.

- Logische DB -Isolation: Verwenden Sie separate Schemas oder Datenbanken pro Mieter, wenn die SLA- und Datenempfindlichkeit dies erfordert.

- Schreibpfad-Trennung: Isolieren Sie Transaktionsnachrichten mit hoher Priorität von Massen-/Marketing-Warteschlangen in der DB-Schicht, um verrückte Nachbarnprobleme zu vermeiden.

Partitionierung & Skala

Im Maßstab bestimmte Tabellen (wie wie Lieferung_logs) wird schnell wachsen. Halten:

- Zeitbasierte Partitionierung: Shard -Protokolle monatlich oder wöchentlich, um aufgeblähte Indizes zu vermeiden.

- Archivpolitik: Bewegen Sie ältere Protokolle in Kühlspeicher (z. B. S3 + Athena), um den Zugang zu überprüfen, ohne die Live -Leistung zu beeinflussen.

- Token -Cache: Synchronisieren Sie toziale Geräte-Token in Redis oder DynamoDB für Hochdurchsatz-Versandschleifen.

Redis -Token -Cache -Schema

Redis wird als lesoptimierte In-Memory-Token-Lookup-Schicht verwendet. Es wird vermieden, während des Nachrichtenversandes die primäre DB zu treffen, und unterstützt Konstantzeitsuche bei massiven Benutzer-/Gerätesätzen.

Primäre Anwendungsfälle:

- Schnelle Fan-Out von Geräte-Token pro Benutzer

- Suche nach Benutzersegmenten (z. B. aktive iOS -Geräte)

- Token -Deduplizierung und Verfallskontrolle

- TTL -Durchsetzung für inaktive oder gedrehte Tokens

Empfohlene Schlüsselstruktur

Key: push:user::tokens Type: Redis Set Value: token:: TTL: Optional (based on last_active)

Beispiel:

Key: push:user:5b6ed...d1:tokens

Value: {

"token:ios:abc123token...",

"token:web:def456token...",

"token:android:xyz789token..."

}

Alternativer Schlüssel für die direkte Token -Suche

Key: push:token::

Type: Hash

Fields: {

user_id: ,

app_version: ,

last_seen: ,

is_active: true/false

}

TTL: 30 days from last_seen

Beispiel:

Key: push:token:ios:abc123token...

Value: {

user_id: "5b6ed...d1",

app_version: "6.4.1",

last_seen: "2025-04-21T18:11:45Z",

is_active: true

}

Am besten Praktiken

- Schüttlast von DB: Cache-Aufwärmjobs sollten aktive Token aus der relationalen DB beim Start oder über CDC (Änderung der Datenerfassung) synchronisieren.

- Ungeregelt: Unregister: Wenn ein Gerät nicht registriert ist oder Token durch APNS/FCM für ungültig markiert ist, löschen Sie den Redis -Eintrag.

- Halten Sie TTL schlank: Token, die in 30 bis 60 Tagen nicht verwendet werden, sollten ausfallen, um ein Cache -Aufblähen zu verhindern.

- Fanout auf Set-Level: Verwenden Sie Redis-Sets, um alle Token pro Benutzer zu erhalten, und führen Sie Message-Fan-Out in Arbeitsprozessen effizient aus.

- Unterstützung mit mehreren Mietern: Präfix alle Schlüssel mit Mieter-ID, wenn sie in einer Umgebung mit mehreren Mietern betrieben werden.

Dieser Cache ergänzt die persistente DB-Schicht, indem er während der kritischen Send-Schleife als Suchstufe mit niedriger Latenz dient. Es hilft auch bei der Segment -Lieferflüsse (z. B. nur an Benutzer mit aktiven iOS -Token) ohne teure relationale Verknüpfungen oder vollständige Scans.

Benötigen Sie Hilfe bei der Strukturierung von Gerätedaten für die Skalierung?

Mühe, Millionen von Gerätetypen, Lieferprotokollen und Einstellungen für Mobile und Web zu verwalten?

Wir können Ihnen helfen, eine robuste Datenschicht zu entwerfen – SQL und Redis enthalten -, die Ihr Push -System schnell, konsistent und immer bereit zu liefern.

Detailliertes Komponentendesign

Jeder Teil des Systems hat seine eigene Verantwortung – aber die Art und Weise, wie sie zusammenarbeiten, definiert, ob Ihre Push -Architektur skalieren oder zerbröckelt. In diesem Abschnitt werden wir die Kernkomponenten Ebene für Ebene aufschlüsseln: Datenhandhabung, Servicelogik, Zustellungsarbeiter und optionale UI -Hooks.

1. Datenschicht (Speicher, Zugriff und Caching)

- Relational DB: Speichert Kerneinheiten (Benutzer, Geräte, Vorlieben, Benachrichtigungen, Lieferprotokolle).

- Redis: Dient als Hochgeschwindigkeits-Lookup-Schicht für aktive Token, jüngste Lieferungen und Echtzeit-Unterdrückungsregeln.

- ORM- oder Datenzugriffsschicht: Verwenden Sie eine saubere Abstraktion, um Validierung, Feldausfälle und Schemabeschränkungen durchzusetzen. Vermeiden Sie es, rohe SQL in Lieferschleifen zu schreiben.

- Lesen Sie die Replikationsnutzung: Lesen Sie hochvolumige Leseabfragen (z. B. Fan-Out-Lookups) in Replikate, um Schreibkontention zu verhindern.

2. Anwendungsschicht (Routing, Filterung, Segmentierung)

Die App -Schicht ist das Gehirn des Systems. Es weiß, was zu senden ist, an wen, wann und unter welchen Bedingungen. Hier lebt die Geschäftslogik.

- Einnahme -API: Vervollständigt eingehende Anfragen von internen Diensten (OTP, Marketing -Tools, Transaktionsauslöser).

- Message Routing -Dienst: Entscheidet, welche Benutzer/Geräte welche Nachricht erhalten sollen. Verbinden Sie Message Metadata mit Redis -Token -Sets.

- Preference & Rules Engine: Erzwingt Opt-in/Out, Kanallimits (z. B. max. 2 Marketing-Pings pro Tag) und Zeitfenster (z. B. keine Nachrichten um 2 Uhr morgens).

- Ratencontroller: Drosselmeldung pro Mieter pro Plattform pro Region. Integriert sich in Redis -Zähler oder Schieberfensteralgorithmen.

3. Integrationsschicht (Lieferdienste und Arbeiter)

Jede Plattform (APNS, FCM, WebPush) hat ihre Macken – also nicht hinter einer generischen Schnittstelle abstrahieren. Behandeln Sie sie stattdessen als erstklassige Bürger mit engagierten Lieferdiensten.

- APNS -Arbeiter: Verwendet tokenbasierte Authentifizierung über JWT. Griffe drücken über http/2. Verwaltet TCP -Verbindungspool und Ratengrenzen von Apple.

- FCM -Arbeiter: Auth über Servicekonten. Batches Nachrichten pro Thema oder Benutzergruppe. Tracks pro Einglückfehler (z. B. nicht registriert, Quoten überschritten).

- Webpush -Arbeiter: Implementiert Vapid, verschlüsselt Nutzlasten mithilfe der Kryptographie der elliptischen Kurve und sendet direkt an Endpoint -URIs.

- Wiederholungswarteschlange: Jede fehlgeschlagene Lieferung wird mit exponentiellem Backoff erneut geeignet. DLQs (Dead-Letter-Warteschlangen) erfassen anhaltende Inspektionsfehler.

4. UI-Schicht (optional, admin-Ausrichtung)

Nicht alle Systeme benötigen dies, aber für interne Marketing-OPs oder Produktteams kann ein leichtes Dashboard nützlich sein.

- Kampagnenkomponist: Erstellen und Planen von Benachrichtigungen an Benutzersegmente mit WYSIWYG -Tools.

- Vorschau & Targeting: Live -Test auf Testgeräten oder A/B -Eimer vor einem vollständigen Rollout.

- Aktivitätsprüfung: Echtzeit-Dashboard, das anzeigt, was sich in der Warteschlange befindet, was zugestellt wurde und was fehlgeschlagen ist (mit Begründungscodes).

Designtipps

- Brechen Sie jeden Arbeiter in zustandslose Mikrodienste, die horizontal skalieren können.

- Verwenden Sie nicht den gleichen Service sowohl für die Lieferung als auch für das Feedback (z. B. APNS -Quittungen). Isolieren Sie diese Flüsse aus Belastbarkeit.

- Fügen Sie in jeder Schicht strukturierte Protokollierungs- und Korrelations -IDs für die Rückverfolgbarkeit hinzu.

Skalierbarkeit Überlegungen

Push -Benachrichtigungssysteme müssen nicht nur arbeiten – sie müssen unter unvorhersehbaren Verkehrsschwellen *schnell *und *in Skala *arbeiten. Dieser Abschnitt beschreibt die Muster, Infrastrukturstrategien und Schutzmaßnahmen, die erforderlich sind, um den Durchsatz hoch und die Latenzen niedrig zu halten, selbst wenn Sie Millionen von Nachrichten pro Minute senden.

Horizontale Skalierung über Ebenen

Jede Komponente im System – zugängliche API, Router, Arbeiter, Warteschlangen – sollte horizontal skalierbar sein. Dies ermöglicht eine unabhängige Abstimmung von Engpässen, ohne die gesamte Pipeline zu überproben.

- API -Gateways / Ein- und Ausgang: Front -APIs sollten autoscale auf der Grundlage von CPU/RPS basieren. Verwenden Sie die Rate -Begrenzung, um nachgelagerte Dienste zu schützen.

- Staatlose Arbeiter: Zustellungsarbeiter und Router müssen staatenlos und containeriert sein. Verwenden Sie Kubernetes HPA (Horizontal Pod Autoscaler) oder Fargate Autoscaling -Regeln basierend auf der Warteschlangentiefe, CPU oder Latenz.

- Serienwarfbasierte Skalierung: Verfolgen Sie die Größe der Rückstände und laken Sie mehr Arbeiter, wenn die Tiefe die Schwelle überschreitet (z. B. Kafka -Verzögerung oder Rabbitmq -Warteschlangenlänge).

Sharding und Partitionierung

- Shard von user_id: Partitionsbereitstellung Workloads nach Hashed -Benutzer -ID zur Erhaltung der Lokalität und zur Verhinderung von Streitigkeiten im DB- oder Token -Cache.

- Kafka -Partitionierung: Verwenden Sie Nachrichtenschlüssel basierend auf Benutzer- oder Mieter -ID, um Benachrichtigungen an die richtige Verbrauchergruppe Shard zu leiten.

- Datenbankpartitionierung: Für große Tische wie

Lieferung_logsVerwenden Sie eine zeitbasierte Partitionierung (z. B. monatlich), um die Abfragegeschwindigkeit aufrechtzuerhalten.

Fan-Out-Leistungsoptimierungen

Der echte Engpass in hochwertigen Systemen ist Fan-Out: Zuordnung einer logischen Nachricht auf Tausende oder Millionen von Geräte-Token.

- Redis Set Union: Verwenden Sie Redis, um alle Token für einen Benutzer oder eine Kohorte mit festgelegten Vorgängen sofort zu erhalten.

- Batching -API -Anrufe: Gruppennachrichten nach Plattform und Batch-Send (z. B. unterstützt FCM bis zu 500 Token pro Stapelanforderung).

- Token -Deduplizierung: Stellen Sie sicher, dass keine doppelten Token in die Lieferwarteschlangen gehen. Behalten Sie die Einzigartigkeit über Redis- oder Vorverarbeitungsschritt auf.

Caching -Strategie

- Token: Zwischen Benutzer -ID zwischengespeichert. TTL auf Lieferung oder Anmeldung aktualisiert.

- Vorlieben: Cache-Unterdrückungsregeln (z. B. ruhige Stunden, Frequenzkappen) in Redis- oder Speicher-lokaler Speicher.

- Drosselung: Redis Thecters (Incribby + TTL) oder Token Eimer für Mieterebene und globale Kappen.

Resilienzmuster

- Bulkhead -Isolation: Getrennte Arbeiterpools pro Plattform. Eine FCM -Verlangsamung sollte keine APNs -Sendungen blockieren.

- Warteschlangen: Warteschlangen: Persistent fehlende Nachrichten (z. B. ungültige Token) werden abgeladen und zur Inspektion ohne Ablauf der Lieferflüsse angemeldet.

- Leistungsschalter: Beenden Sie vorübergehend die Wiederholung von nachgeschalteten Anbietern, die hohe Ausfallraten (z. B. APNs 503s) zeigen.

- Backoff strategies: Verwenden Sie exponentielle Backoffs mit Jitter, um Warteschlangen wiederzugeben. Vermeiden Sie Stampedes während des Drosselns des Anbieters.

Durchsatz -Benchmarks (Basisziele)

- API -Aufnahme: 2.000 bis 10.000 RPS pro Knoten, abhängig von der Nutzlastgröße.

- Routing und Fan-Out: 5.000–20.000 Geräte -Token -Lookups/Sekunden mit Redis + Partitionierung.

- Durchsatz des Lieferangebots:

- APNs: ~ 5.000–10.000 Drucke/min pro Verbindung (HTTP/2 Multiplexed)

- FCM: ~ 12.000/min mit Batch -Anfragen

- Webpush: ~ 2.000/min (einzelner Endpunkt sendet)

Benötigen Sie Hilfe, um Ihre Push -Pipeline -kugelsicher zu machen?

Das Gebäude für die Skala ist mehr als nur Autoscaling -Pods. Von Kafka-Tuning bis hin zu Fan-Out-Optimierung und Leistungsschalter können wir Ihnen helfen, eine Push-Infrastruktur zu entwerfen, die nicht blinzelt-selbst am Starttag.

Sicherheitsarchitektur

Drücken Sie die Schnittstelle zur Benachrichtigungssysteme mit sensiblen Benutzerdaten, Cloud -Messaging -Plattformen und internen Diensten. Wenn nicht in jede Ebene von Token -Speicher bis hin zu API -Interaktionen in jede Ebene eingebunden ist, setzen Sie sich für Datenschutz -Lecks, Missbrauchsvektoren und Compliance -Fehler ein. Dieser Abschnitt deckt die Grundsätze und Praktiken der wesentlichen Sicherheitsdesign ab, um Ihr System von End-to-End zu härten.

1. Authentifizierung und Autorisierung

- Interne Zugangskontrolle: Alle internen APIs (Einnahme, Planung, Routing) sollten mit kurzlebigen JWTs oder gegenseitigen TLs geschützt werden-insbesondere, wenn sie über Dienste oder Umgebungen hinweg zugänglich sind.

- API -Gateway -Richtlinien: Verwenden Sie IAM oder RBAC auf Gateway-Ebene, um zu beschränken, welche Dienste oder Benutzer verschiedene Arten von Benachrichtigungen einreichen können (z. B. Transaktionsmarketing).

- Mietertrennung: Wenn Sie Multi-Mandanten-Systeme unterstützen, erzwingen Sie die strenge Mieter-basierte Isolation in jeder Abfrage-, Routen- und Nachrichten-Versandfluss.

2. Management für Plattformanmeldeinformationen

Integrationen von Drittanbietern mit APNs und FCM erfordern Geheimnisse, die mit Sorgfalt behandelt werden müssen.

- Store Keys in einem geheimen Manager: Verwenden Sie Tools wie AWS Secrets Manager, Hashicorp Vault oder GCP Secret Manager, um APNS -Keys und FCM -Anmeldeinformationen zu speichern.

- Drehen Sie regelmäßig Anmeldeinformationen: Bauen Sie die Automatisierung auf, um mindestens vierteljährlich Service -Anmeldeinformationen zu drehen.

- Begrenzen Sie Schlüsselbereiche: Verwenden Sie Servicekonten mit den am wenigsten erforderlichen Berechtigungen – nicht mehr, nicht weniger.

3. Nutzlastsicherheit

- Fügen Sie keine PII in Push -Nutzlasten ein: Nutzlasten sind auf Betriebssystemebene oft sichtbar (insbesondere Android). Geben Sie niemals Namen, E -Mail -Adressen oder sensible Token ein.

- Verschlüsseln Sie in Ruhe und im Transit: Alle Daten in der Datenbank und Redis müssen mit AES-256 oder plattformspezifischer AT-REST-Verschlüsselung verschlüsselt werden.

- Web -Push -Nutzlastverschlüsselung: VAPID-basierte Web-Push erfordert eine elliptische Kurvenverschlüsselung (NIST P-256); Dies muss ordnungsgemäß behandelt werden, um stille Lieferfehler zu vermeiden.

4. Missbrauchsschutz und Ratenbegrenzung

Links deaktiviert kann ein Push -System vorgewaltet werden – entweder für Spam -Benutzer oder zur Überlastung der Lieferinfrastruktur.

- Ratengrenzwerte pro Service: Verwenden Sie Redis-Zähler oder undichtende Bucket-Algorithmen, um Per-API- und Tarifant-Ratenkappen durchzusetzen.

- Quotendurchsetzung: Die täglichen Nachrichtenlimits pro Benutzer oder Segment (insbesondere für das Marketing) sollten in der Routing -Ebene erzwungen werden.

- Audit-Trails auf Auth-Ebene: Alle Anfragen zum Senden von Nachrichten sollten mit dem Dienstnamen, der Benutzeridentität, der IP und den Nachrichtenmetadaten geprüft werden.

5. Geheimnisse und Anmeldeinformationen Hygiene

- Verwenden Sie Isolation auf Umweltebene: Teilen Sie niemals Entwickler, Inszenierung und Proditen für Push -Dienste.

- Klartextprotokolle deaktivieren: Vermeiden Sie die Protokollierung von Token, Anmeldeinformationen, oder schieben Sie Nutzlasten mit sensiblen Metadaten in Protokollen. Maskieren Sie alles, was für das Debuggen nicht benötigt wird.

- Überwachung auf Missbrauch: Alarm, wenn die Verwendung von Außenspitzen erwartete Muster-insbesondere hochvolumige Sendungen von Nicht-pro-professionellen Konten oder plötzlichen FCM-Fehlern sendet.

6. clientseitige Schutzmaßnahmen (minimal, aber erwähnenswert)

- Token-Rotation auf App-Ebene: Stellen Sie sicher, dass Ihr mobiles SDK die Token regelmäßig aktualisiert und sie bei Abmeldung oder Deinstallation nicht registriert.

- SSL Pinning (optional): Wenn die App eine Verbindung zu Ihrem Backend direkt herstellt, um sich für den Push zu registrieren, sollten Sie festlegen, dass Sie MITM -Angriffe verhindern.

Erweiterbarkeit und Wartbarkeit

Ein skalierbares Push-System ist kein einmaliger Build-es muss sich mit sich ändernden Geschäftsanforderungen, Plattform-Updates und Nutzungsmustern entwickeln. Die Architektur muss modular, leicht zu erweitern und sicher zu warten, ohne Regressionen einzuführen. In diesem Abschnitt werden Ihre Push-Infrastruktur für die langfristige Entwicklung und die Entwicklung von Entwicklern strukturiert.

1. Plugin-freundliche Architektur

Eine saubere Trennung zwischen Kernlogik und lieferungsspezifischer Logik ermöglicht eine schnellere Iteration, ohne die Produktionsströme zu destabilisieren.

- Zustellungsarbeiter als Plugins: Kapitelle APNs, FCM und Webpush -Logik in eigenständigen Modulen mit einer gemeinsam genutzten Zustellschnittstelle (z. B. `send (Token, Nutzlast, Konfiguration)`).

- Nachrichtentransformatoren: Implementierung von Transformationshaken pro Plattform (z. B. verwendet APNs “alert”, FCM verwendet “Benachrichtigung” + `data`).

- Haken für benutzerdefinierte Logik: Ermöglichen Sie Vor- und Nachsendungs-Haken in der Routing-Ebene für Mieterspezifische Überschreibungen, z. B. benutzerdefinierte Drosselung oder A/B-Logik.

2. Saubere Code-Praktiken

Push-Codebasen werden in der Regel zum Dumping zu plattformspezifischen Hacks, sofern sie nicht streng beibehalten werden.

- Strenge Schnittstellenverträge: Verwenden Sie klare Schnittstellen für Zustellmodule und Nachrichtendefinitionen (z. B. `messagePayload`,` liefercontext`).

- Zentrale Konfigurationsverwaltung: Alle Ratengrenzen, Wiederholung von Richtlinien und Plattformanmeldeinformationen sollten extern in Konfigurationsdateien oder Secret -Managern definiert werden.

- Servicegrenzen: Vermeiden Sie die Kopplung von Routing -Logik mit Lieferlogik. Behandeln Sie jeweils als unabhängig einsetzbaren Microservice.

3. Feature-Flags und Versionierung

Unterstützen Sie iterative Merkmalentwicklung und Rückwärtskompatibilität durch strenge Versioning.

- Versioned Nachrichtenformate: Definieren Sie Nachrichtenschemata mit Versioning (“V1`,” V2 “usw.) und unterstützen Sie die Upgrades parallel, ohne ältere Formate zu brechen.

- Feature Flags für neue Ströme: Rollen Sie eine neue Lieferlogik hinter Flags pro Mieter oder Umgebung aus, um den Explosionsradius zu minimieren.

- Modell mit weicher Deprezierung: Markieren Sie Legacy -APIs und Nachrichtenstrukturen für die geplante Entfernung; Fügen Sie bei Verwendung die Protokollierung hinzu.

4. Test- und Validierungsschichten

Eine kaputte Nutzlast kann in Lieferausfälle eindringen. Sicherstellen Sie jede neue Veröffentlichung mit starker Validierung.

- Schema -Validierung: Verwenden Sie das JSON -Schema oder eine Protobuf -Validierung, bevor Nachrichten zum Versand eingeleitet werden.

- Vertragstests: Definieren Sie die Erwartungen für Plattformmodule mithilfe von Pakt- oder ähnlichen Tools, um die Integrationsdrift zu verhindern.

- Sandbox -Modus: Stellen Sie einen Trocken- oder Testmodus für interne Dienste zur Verfügung, um Push zu simulieren, ohne Live-Endpunkte zu treffen.

5. Anti-Patterns nach Wartbarkeit zu vermeiden

- Hardcoding plattformspezifisches Verhalten: Immer abstrakte Plattformlogik in Module oder Plugins.

- Mischlogik mit globaler Logik: Mieterlogik: Verwenden Sie Scoped-Dienste oder Bedingungen auf Routenebene-Inline-Mieterschreiber-Überschüsse nicht.

- Mangel an Beobachtbarkeit in neuen Strömen: Neue Routen oder Module müssen vom ersten Tag an strukturierte Protokolle, Metriken und Fehlerbehandlungen enthalten.

Leistungsoptimierung

Wenn Sie Millionen von Benachrichtigungen vorantreiben, geht es nicht nur um Systemdesign, sondern auch darum, wie effizient jede Komponente unter Druck ausgeführt wird. Die Leistungsstimmung kann die Latenz verringern, den Durchsatz verbessern und nachgeschaltete Ausfälle verhindern. Dieser Abschnitt konzentriert sich darauf, wie Sie Ihre Push -Pipeline an den Daten, Verarbeitung und Lieferschichten optimieren können.

1. Datenbankabfragesteuerung

- Gezielte Indizes: Stellen Sie in ihren jeweiligen Tabellen die Indizes für `token`,` user_id` und `notification_id` sicher. Composite-Indizes helfen bei Fan-Out-Lesevorgängen (z. B. `eriebel_id, status`).

- Abfragen nach Segment -ID, keine Rohbenutzerfilter: Vermeiden Sie komplexe Join-Abfragen während der Send-Zeit. Vorkompute von Segmenten und Cache -Benutzer -IDs oder Token in Redis.

- Verbindungspool -Management: Verwenden Sie das Verbindungsbad (z. B. PGBouncer), um Spiky-Anfrage-Engpässe während hoher Volumenläufe zu vermeiden.

2. Token-Fan-Out-Effizienz

- Batch liest aus Redis: Verwenden Sie beim Abrufen von Token pro Benutzer oder per Segment immer “Smembers” + `mget` in pipelierten Stapeln.

- Schüttgutschleifen: Prozess in Chargen (z. B. 500–1.000 Token pro Iteration), um das Überziehen von Netzwerknetzwerken zu vermeiden.

- Payload -Vorlage Caching: Cache -gerenderte Nutzlasten (Titel/Körper/Metadaten) beim Ausstrahlung von ähnlichen Gerätegruppen.

3. Async -Verarbeitung und Arbeiterabstimmung

- Prefetch: Nachrichten: Verwenden Sie Message Prefetch -Zählungen (z. B. Kafka `fetch.min.Bytes`, Rabbitmq` prefetch_count`), um die Leerlaufzeit in Lieferangeboten zu verkürzen.

- Liefergrenze: FCM und Webpush ermöglichen ein gewisses Maß an Charge-verwenden Sie dies, wenn Sie nicht personalisierte Kampagnen senden.

- Arbeiterpooling pro Region: Führen Sie isolierte Arbeiterpools (oder Pods) pro geografischer Region aus, um die Latenz zu minimieren und die Kosten für die Cloud-Ausstiegskosten zu senken.

4. Ratenbegrenzung und Durchflussregelung

- Schiebefensterzähler: Verwenden Sie Redis Lua-Skripte, um Ratenkappen auf Plattformebene zu implementieren (z. B. max. 100K/s pro Plattform oder Mieter).

- Warteschlangenrohr: Dynamisch verlangsamen Sie die Meldungsquoten des Broker, wenn die Fehlerquoten spitzen (z. B. APNS 429S- oder FCM -Quotenfehler).

- Backoff -Kontrolle: Verwenden Sie bei den Wiederholungen, dass die exponentielle Backoffs von Jittered verwendet werden, um zu verhindern, dass donnernde Herden fehlgeschlagene Lieferungen haben.

5. Frontend -Rendering -Leistung (nur Web -Push)

- Nutzlastminimierung: Webpush -Nachrichten sollten kompakt sein – zusätzliche Metadaten streifen, auf ~ 2 KB oder weniger für das schnellste Render halten.

- On-Click-Routing: Verwenden Sie Abfrageparameter oder Deep-Links in Webpush `click_action`, um schnellere In-App- oder Browsererlebnisse zu fahren.

- Faule Render -Anreicherung: Zeigen Sie nach Möglichkeit minimale Benachrichtigungsinhalte an und laden Sie vollständige Details, nachdem der Benutzer geklickt hat.

6. Optimierung Überwachung und Rückkopplungsschleife

- Latenzperzentile verfolgen: Überwachen Sie nicht nur die durchschnittliche Lieferzeit. Track P90, P99, um Langschwanzlieferung zu fangen.

- Feedback -Filterung: NUR KRITISCHE FEEDBACK (TOKEN OFFIRE, Gerät nicht erreichbar) anstelle von allem aufnehmen, um die Analytiklast zu reduzieren.

- Metrikenaggregation: Verwenden Sie Tools wie Prometheus mit kardinalitätsbewussten Etiketten, um eine metrische Explosion unter hohem Volumen zu vermeiden.

Teststrategie

Ein System, das auf Millionen von Geräten drückt, kann sich nicht auf manuelle QA oder isolierte Tests verlassen. Die Lieferung ist asynchron, von Drittanbietern abhängig und in Echtzeit-was bedeutet, dass das Testen geschichtet, automatisiert und fehlerfrei ist. In diesem Abschnitt werden die Tests in allen Phasen angesprochen: lokale Entwicklung, CI -Pipelines und Produktionshärten.

1. Einheitstests

Unit -Tests stellen sicher, dass sich die interne Logik bei Routing, Token -Lösung und Nutzlastgenerierung korrekt verhält.

- Testen Sie die Routing -Logik: Validieren Sie die Nutzer -Targeting -Filter, die Durchsetzung der Präferenz und die Plattformaufteilung.

- Mock -Token Sets: Simulieren Sie Redis/DB-Antworten mit gefälschten Token-Zuordnungen, um die Fan-Out-Logik zu testen.

- Schema -Validierung: Stellen Sie sicher, dass die Nutzlasten den Plattformschemas entsprechen-Warn-/Nachrichtenstruktur, plattformspezifische Felder usw.

2. Integrationstests

- In-Memory-Nachrichtenwarteschlangen: Führen Sie Kafka/Rabbitmq lokal aus (oder verwenden Sie Testbehälter), um den vollständigen Erzeuger-zu-Verbraucher-Fluss zu simulieren.

- Gefälschte Lieferadapter: Mock -APNs, FCM und Webpush mit lokalen Endpunkten, die Erfolgs-/Ausfallfälle simulieren, einschließlich Drosselung oder nicht registrierter Geräte.

- End-to-End-Lieferfluss: Gehen Sie zu, dass eine Nachricht, die der Einnahme -API übermittelt wurde, über die Warteschlange, die Regeln und die Arbeiterdienste und Arbeiterdienste erfolgreich den verspotteten Lieferadapter erreicht.

3. Vertragstests

Vertragstests bestätigen, dass die Plattform -Liefermodule aufgrund externer API- oder Nachrichtenformatänderungen nicht brechen.

- Verwenden Sie Pakt oder ähnliche Werkzeuge: Definieren Sie die Vertragserwartungen für jedes Liefermodul (APNS, FCM, Webpush).

- Versionsschemata: Halten Sie die Nachrichtenformate versioniert und überprüfen Sie die Rückwärtskompatibilität bei Änderungen.

4. Last- und Spannungstests

Push-Systeme müssen unter realen Bänden gehalten. Lasttests hilft bei der Validierung der Warteschlangenleistung, der Redis -Hits und der DB -Streit.

- Kampagnen simulieren: Injizieren Sie 10 m+ Mock -Nachrichten in die Warteschlange, um die Skalierung der Arbeiter, die Fehlerraten und die Nachrichtenlatenz zu beobachten.

- Spike- und Soak -Tests: Überprüfen Sie, wie das System kurze Bursts (100k/min) im Vergleich zu Langzeitvolumen (10 k/s für Stunden) umgeht.

- Isolieren Sie langsame Dienstleistungen: Überwachen Sie, welche Komponenten (z. B. Routing, DB schreibt, Token -Cache) langsamer werden.

5. CI Pipeline Deckung

- Testen Sie jeden Push -Pfad: Fügen Sie die Lieferlogik, den Rückback -Wiederholungen und die Ausfallbehandlung im Rahmen der automatisierten CI -Läufe ein.

- Verwenden Sie synthetische Token: Generieren Sie Dummy -APNs/FCM -Token für Testnutzlasten (verwenden Sie niemals echte in CI).

- Lintschemata: Validieren Sie alle Nutzlasten automatisch gegen Plattformspezifikation vor dem Zusammenführen mit JSON-Schema oder Protobuf-Schecks.

6. Chaos & Fehlerinjektion (Fortgeschrittene)

Führen Sie für Teams, die in massivem Maßstab arbeiten, kontrolliertes Chaos ein, um Edge -Fälle vor den Benutzern zu fangen.

- Lieferung von Lieferungen abgeben: Simulieren Sie Netzwerkverzögerungen oder Verluste zwischen Worker und Push Provider.

- Schlechte Nutzlasten einbringen: Verorge Felder oder verstoßen gegen Schemaverträge, um das Problem zu bestätigen und zu isolieren.

- Einnahme von Gas -Feedback: Zögern Sie die Lieferbelege, um sicherzustellen, dass das System aufgrund fehlender Statusaktualisierungen nicht blockiert oder stürzt.

DevOps und CI/CD

Push-Benachrichtigungssysteme umfassen mehrere Dienste, Warteschlangen, Datenbanken und Integrationen von Drittanbietern. Diese Komplexität erfordert eine automatisierte, zuverlässige DevOps -Pipeline, die mit Vertrauen erstellen, testen, bereitstellen und rollt. Dieser Abschnitt deckt die Werkzeuge und Praktiken ab, die erforderlich sind, um Ihre Lieferpipeline schnell, sicher und beobachtbar zu halten.

1. CI/CD -Pipeline -Design

- CI -Praktika: Lint → Unit -Tests → Vertragstests → Integrationstests → Schema -Validierung → Docker Build

- CD -Stufen: Kanarische Bereitstellung → Gesundheitsprüfungen → Metriken Gate → Vollständige Rollout

- Vorabwehrschema Diff: Auto-Check-Datenbankmigrationen für Kompatibilität und mögliche Ausfallzeitprobleme (z. B. Hinzufügen von Spalten ohne Null ohne Standard).

2. Bereitstellungsstrategien

- Blue-Green-Bereitstellung: Verwenden Sie für staatliche Dienste wie Scheduler oder Einnahme-APIs Blue-Green, um den Verkehr ohne Ausfallzeiten zu wechseln.

- Kanarische Bereitstellung: Für Lieferarbeiter und Router werden für eine kleine POD -Untergruppe (z. B. 5%) eingesetzt und auf Lieferfehler oder Plattform -API -Fehler beobachten.

- Progressive Rollouts: Rollen Sie Funktionen mit Konfigurationsflags (nicht Codezweige) aus, damit Änderungen zur Laufzeit umgeschaltet werden können.

3. Infrastruktur als Code (IAC)

- Verwenden Sie Terraform oder Pulumi: Verwalten Sie Infra in AWS/GCP für Warteschlangen, DBs, Redis -Cluster und VPCs.

- Dynamische Umgebungen: Sprühen Sie isolierte Testumgebungen in Merkmalszweigen, um Push-Flüsse von End-to-End zu testen, ohne die Inszenierung zu verschmutzen.

- Geheimnisse Automatisierung: Store Push Service -Anmeldeinformationen in geheimen Managern und injizieren Sie über versiegelte Geheimnisse oder Seitenwagen in Schoten.

4. Gitops & Konfigurationsmanagement

- Versionskonfigurationen: Halten Sie die Ratengrenzen, Richtlinien und Mieterschreiber in Git – nicht in Dienstleistungen.

- ConfigMap-gesteuerte Verhalten: Inject plattformspezifische Einstellungen in Arbeiter (z. B. APNS-Poolgröße, Webpush TTL) über Kubernetes configMaps.

- Rollback über Git Revert: Wenn eine Konfiguration oder Flag -Produktion die Produktion bricht, ermöglicht Gitops einen schnellen Rollback mit der Überwachbarkeit.

5. Release-Validierung & nach dem Deploy-Schecks

- Haken nach dem Deploy: Lösen Sie die Gesundheitsprüfungen oder Rauchtests automatisch nach dem Rollout.

- Sehen Sie sich Liefermetriken an: Überwachen Sie die Lieferraten, Fehlercodes und die Warteschlangengröße in 15 bis 30 Minuten nach dem Einsatz, bevor Sie vollständig skalieren.

- Fail-Fast-Verhalten: Wenn Lieferfehler Spike (z. B. ungültige Token 403s von FCM), automatische HALT-Bereitstellung und Benachrichtigung von Bereitstellungen.

Benötigen Sie Hilfe bei der Versandschiffung mit Vertrauen?

Ein robustes Push -System zu bauen ist eine Sache – es ist eine andere, es ohne Angst in Produktion zu treiben. Wenn Sie Hilfe bei der Einrichtung einer CI/CD-Pipeline, sicheren Bereitstellungen und Rollback-Safe-Releases für Ihren Push-Stack benötigen, haben wir es zuvor gemacht.

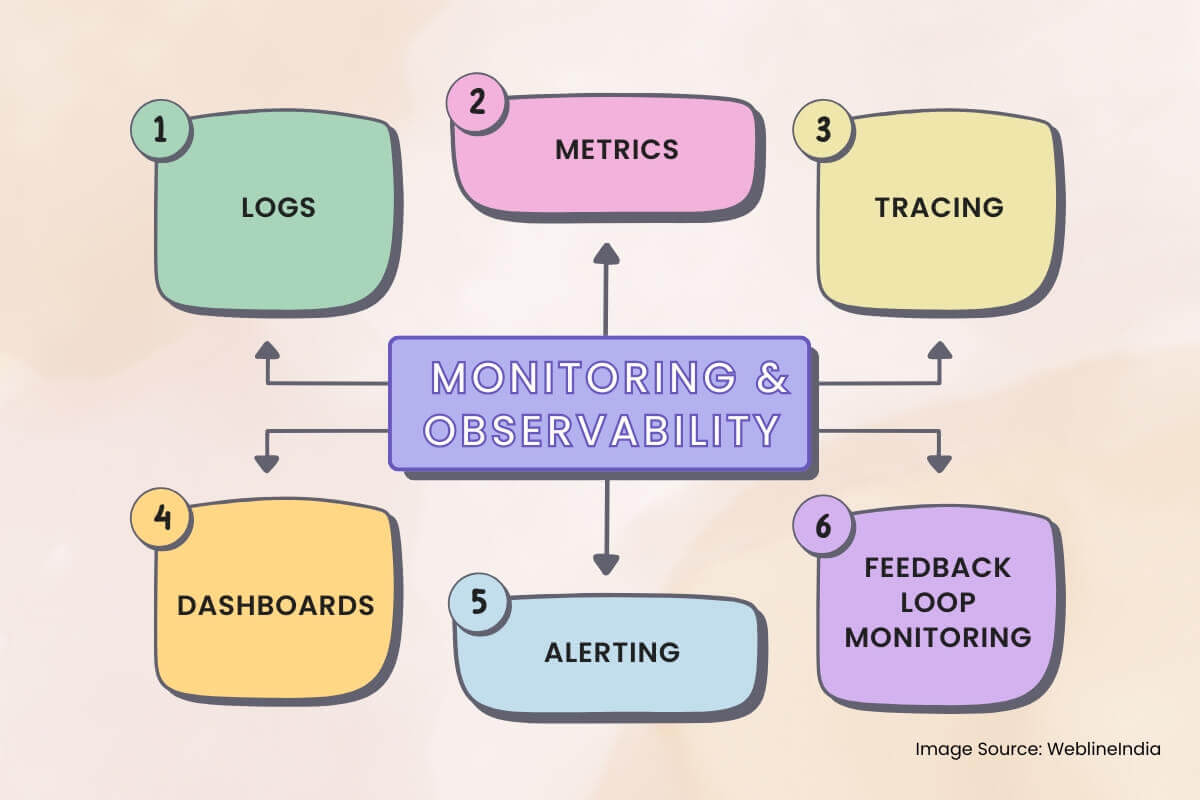

Überwachung und Beobachtbarkeit

Push-Benachrichtigungssysteme sind asynchron, verteilt und verlassen sich auf Black-Box-Drittanbieterdienste wie APNs und FCM. Ohne ordnungsgemäße Beobachtbarkeit treten die Fehler unbemerkt auf, stille Abbindungen treten auf, und das Debuggen wird zu Raten. In diesem Abschnitt wird beschrieben, was zu überwachen ist, wie der Nachrichtenfluss nachverfolgt und wie Sie aussagekräftige Warnungen erstellen können.

1. Protokolle

- Strukturierte Protokollierung: Verwenden Sie JSON -Protokolle mit Feldern wie `message_id`,` device_id`, `plattform`,` status` und `error_code` für jede Lieferphase.

- Korrelations -IDs: Tag-Protokolle aus Einnahme → Routing → Zustellungsarbeiter mit einer gemeinsam genutzten Anforderungs-ID für End-to-End-Rückverfolgbarkeit.

- Sensible Felder reduzieren: Mask-Token, Benutzer-IDs oder Nutzlastinhalte in Protokollen-insbesondere auf freigegebenen oder Drittanbieter-Plattformen.

2. Metriken

Metriken sagen Sie, was auf Makroebene passiert. Aggregieren Sie sie über Dienste hinweg, um plattformweite Probleme frühzeitig zu erkennen.

- Lieferdurchsatz: Nachrichten pro Plattform pro Minute gesendet. Brechen Sie durch “Mieter”, “Priority” und “message_type” (Transaktion/Marketing) ab.

- Lieferungserfolg/Fehlerrate: Track `Delivered`,` Droped`, `failed` und` retyrying’ -Eimer – mit Tags für die Grundursache (`unregistriert`,` rate_limited`, `Invalid_token`).

- Warteschlangenlatenz: Zeit vom Enqueue bis zum Arbeitnehmerabholung und Arbeiter bis hin zur Plattformanerkennung.

3. Verfolgung

Spuren sind kritisch, wenn Nachrichten lautlos verschwinden oder verzögert werden. Integrieren Sie die verteilte Verfolgung in jeden internen Dienst.

- Spurenspannen: Einnahme → Redis/Token -Lookup → Präferenzprüfung → Warteschlange Enqueue → Arbeitermeldung → Plattformzustellung.

- Link -Protokolle mit Spuren: Geben Sie Trace -IDs in Protokolle und Dashboard -Links ein (z. B. von Kibana bis Jaeger/Tempo).

- Stichprobenrate -Kontrolle: Immer OTPs und fehlgeschlagene Nachrichten verfolgen; Verwenden Sie probabilistische Stichproben für Kampagnen, um den Gemeinkosten zu reduzieren.

4. Dashboards

Echtzeit-Dashboards helfen den Betreibern und Bereitschaftstechnikern, die Systemgesundheit auf einen Blick zu verstehen.

- Plattform -Lieferstatus: Echtzeitzahlen von gesendeten, fehlgeschlagenen, wiederholten Nachrichten pro Plattform (APNS/FCM/Webpush).

- Queue -Tiefe: Live -Sichtbarkeit in Routing- und Lieferwarteschlangen – Steigende Warteschlangentiefe zeigt eine Sättigung oder eine nachgeschaltete Verlangsamung an.

- Rückkopplungssignalanalyse: Visualisieren Sie Token Invalidierungen, Ratenlimits Treffer und Feedback -Quittungen von Push -Plattformen.

5. Alarmierung

- Ausfallspike -Warnungen: Wenn fehlgeschlagene Nachrichten einen Schwellenwert (Absolutzahl oder Fehlerrate %) innerhalb eines Schiebungsfensters überschreiten.

- Lieferlatenzwarnungen: Wenn die P95 -Latenz SLA überschreitet (z. B. OTP> 3s, Kampagne> 30s).

- Warteschlangenwachstum für Decken: Alarm, wenn DLQs anfangen, Nachrichten zu sammeln – signalisiert einen anhaltenden Versagensweg.

6. Überwachung der Rückkopplungsschleife

Plattformen wie APNs und FCM senden asynchron Feedback. Diese Quittungen benötigen eine eigene Pipeline.

- Feedback -Einnahmearbeiter: Konsumieren und speichern Sie nicht registrierte Token-Ereignisse, Lieferfehler und Ratschläge.

- Metrikenextraktion: Aggregieren Sie Feedback-Signale in Dashboards und Fehlerklassenverteilungen.

- Token Cleanup -Automatisierung: Trigger Hintergrundjobs, um veraltete Token basierend auf Plattform -Feedback zu deaktivieren oder zu entfernen.

Kompromisse und Designentscheidungen

Jede architektonische Entscheidung ist mit Kompromisse verbunden. Das Entwerfen eines skalierbaren Push -Benachrichtigungssystems bedeutet ständig die Latenz im Vergleich zum Durchsatz, die Einfachheit und die Flexibilität und die Zuverlässigkeit im Vergleich zu den Kosten. Dieser Abschnitt beschreibt einige der wichtigsten Entscheidungen, die im gesamten System getroffen wurden, und die in Betracht gezogenen Alternativen.

1. plattformspezifische Arbeitnehmer im Vergleich zu Unified Delivery Interface

- Entscheidung: Separate APNs, FCM und Webpush in isolierte Lieferdienste.

- Abtausch: Mehr Code- und Bereitstellungskomplexität, aber viel bessere Fehlerisolation, Skalierbarkeit und Debugierbarkeit pro Plattform.

- Alternative: Eine generische einheitliche Schnittstelle könnte die Code -Duplikation verringern, müsste jedoch eine umfangreiche bedingte Logik erfordern und die Beobachtbarkeit verringern.

2. REDIS-Token-Cache gegen DB-Nur-DB-Lieferung

- Entscheidung: Verwenden Sie Redis für aktive Token-Lookup und Fan-Out während des Nachrichtenroutings.

- Abtausch: Erfordert Hintergrundsynchronisation und Invalidierungslogik, verbessert jedoch drastisch den Durchsatz der Lieferung und reduziert die DB -Last.

- Alternative: Direct DB Reads während des Fan-Out würde die Architektur vereinfachen, aber nicht auf Bände auf Kampagnenebene skalieren.

3. Kafka für Message Queuing vs. einfachere Warteschlangen

- Entscheidung: Verwenden Sie Kafka oder ein gleichwertiges verteiltes Protokoll für Routing- und Zustellwarteschlangen.

- Abtausch: Steilere Lernkurve und Infra -Managementbelastung, ermöglicht jedoch eine hohe Haltbarkeit, Wiederholungen und Verbraucherskalierbarkeit.

- Alternative: Rabbitmq/Quadratmeter sind einfacher zu bedienen, bieten jedoch weniger Flexibilität für groß angelegte Lüfter- oder Liefergarantien.

4. Dead-Letter-Warteschlangen vs. Inline-Wiederholungsschleifen

- Entscheidung: Verwenden Sie dedizierte DLQs für dauerhafte Ausfälle und beschränken Sie die In-Place-Wiederholung auf 2–3 Versuche.

- Abtausch: Etwas höherer operativer Overhead, verhindert die Warteschlangenblockierung und ermöglicht die Verarbeitung der Async -Wiederherstellungen.

- Alternative: Inline -Wiederholung mit Backoff ist einfacher zu implementieren, besteht jedoch durch, um nachgeschaltete Systeme zu überladen oder Nachrichten zu verzögern.

5. zeitbasierte DB-Partitionierung im Vergleich zu flachem Tischwachstum

- Entscheidung: Partitionsablieferung loget sich bis Monat lang an, um die Indexgröße und die Retentionsrichtlinien zu kontrollieren.

- Abtausch: Kompliziertere Abfragerouting und potenzielle Fragmentierung des Datenzugriffs.

- Alternative: Eine monolithische Tabelle wäre zunächst einfacher zu verwalten, würde jedoch die Leistung beeinträchtigen und die Aufräumarbeiten komplizieren.

6. Kompromisse bei der Feature-Geschwindigkeit vs. Liefergarantien

- Entscheidung: Separate Transaktionen von Marketingflüssen in jeder Ebene – Einnahme, Warteschlangen, Lieferdienste.

- Abtausch: Mehr Routing-Komplexität und zusätzliche Infrastruktur, verhindert, dass nicht kritischer Verkehr kritische Pfade (z. B. OTPs) abbaute.

- Alternative: Ein einheitlicher Flow vereinfacht das Routing, besteht jedoch durch die Auswirkungen des Kunden bei schweren Kampagnenlasten oder bei der Drossung von Plattform.

7. Bekannte technische Schuldenbereiche

- Abgestandene Token -Reinigung: Benötigt eine Optimierung oder Automatisierung über die Aufnahme von Rückkopplungsschleifen.

- Segmentvormaterialisierung: Derzeit läuft Just-in-Time während der Kampagne-Senden. sollte auf Hintergrundjobs verlegt werden.

- Ratenbegrenzer Skalierung: Shared Redis-Instanzen für die Ratenkontrolle könnten im Rahmen von Kampagnen im globalen Maßstab zu einem Engpass werden.

Was diese Architektur richtig macht

Bei der Gestaltung eines skalierbaren Push -Benachrichtigungssystems geht es nicht nur darum, Nachrichten zu senden, sondern dass die richtigen Nachrichten, zuverlässig und im Maßstab die richtigen Geräte, an die richtigen Geräte bereitgestellt werden. Diese Architektur ist speziell gebaut, um diese Herausforderung direkt zu begegnen und Durchsatz, Kontrolle und Wartbarkeit in einem hochverteilten System auszugleichen.

Wichtige Erkenntnisse

- Entkoppelte Architektur: Einnahme, Routing und Lieferung sind für Resilienz und Skalierbarkeit sauber getrennt.

- Plattformisolation: Jeder Push -Service (APNS, FCM, Webpush) wird von einem speziellen Arbeiter behandelt, der auf seine Macken eingestellt ist.

- Token Caching und Fan-Out: Redis Powers Fast Token Resolution und ermöglicht die Bereitstellung von Nachrichten mit hoher Durchgabe, ohne Ihre primäre DB zu hämmern.

- Datendauer: Nachrichtenwarteschlangen sorgen für eine zuverlässige Lieferung auch dann, wenn Plattform -APIs ausfallen, und DLQs erfassen Kantenfälle für eine spätere Inspektion.

- Beobachtbarkeit überall: Nachverfolgung, Metriken und strukturierte Protokolle machen Debugging-Zustellpipelines und Flows auf Benutzerebene im Maßstab praktisch.

- Merkmalssichere Erweiterbarkeit: Modulare Komponenten, Hook-basierte Logik und Schema-Versionierung ermöglichen es dem System, sich weiterzuentwickeln, ohne die älteren Pfade zu brechen.

Möglichkeiten zur zukünftigen Verbesserung

- Feinkörniges Droseln: Per-Benutzer- oder pro-Gerätsrate-Obergrenze könnten die Überveredelung weiter reduzieren und UX verbessern.

- Segmentmaterialisierungspipeline: Wenn die Segmentierung von vorab geplanten Hintergrundjobs die Kampagneneinführung noch schneller gestartet hat.

- Regionale Lieferoptimierung: Geo-lokale Zustellungsarbeiter könnten die Kosten für die Latenz- und Cloud-Ausstiegskosten senken, indem sie die Plattformanrufe näher am Benutzer der Benutzer halten.

Dieses System funktioniert nicht nur – es hält unter Druck, skaliert mit dem Wachstum und bleibt auf dem Laufenden, wenn sich die Anwendungsfälle weiterentwickeln. Das ist es, was Wurf-Benachrichtigungsskripte von einer Lieferplattform in Echtzeit, Produktionsstörungen, unterscheidet.

Benötigen Sie Hilfe, um Ihr Push -Benachrichtigungssystem auf diese Ebene zu bringen?

Das Entwerfen und Skalieren einer Multi-Plattform-Push-Benachrichtigungsarchitektur ist kein Wochenendprojekt. Wenn Sie vom ersten Tag am ersten Tag etwas Zuverlässiges erstellen oder das feststellen möchten, was bereits Risse zeigt, können wir das System, das Ihre Benutzer erwarten, helfen.

Referenzen: Hören Sie es direkt von unseren globalen Kunden

Unsere Entwicklungsprozesse liefern dynamische Lösungen, um geschäftliche Herausforderungen zu meistern, Kosten zu optimieren und die digitale Transformation voranzutreiben. Expertenunterstützte Lösungen stärken die Kundenbindung und die Online-Präsenz, während belegte Erfolgsgeschichten reale Problemlösungen durch innovative Anwendungen hervorheben. Unsere geschätzten Kunden weltweit haben es bereits erlebt.

Auszeichnungen und Anerkennungen

Zufriedene Kunden sind unsere größte Motivation, doch auch Branchenanerkennung hat einen hohen Stellenwert. WeblineIndia ist seit Jahren führend in der Technologie, und Auszeichnungen sowie Ehrungen bestätigen kontinuierlich unsere Exzellenz.

OA500 Globale Outsourcing-Unternehmen 2025, von Outsource Accelerator

Top Softwareentwicklung-Unternehmen, von GoodFirms

Bestes FinTech-Produktlösungsunternehmen – 2022, von GESIA

Ausgezeichnet als – Bestes App-Entwicklungsunternehmen in Indien 2020, von SoftwareSuggest