Wenn der Markt von der Digitalisierung angetrieben wird, ist die transformative Kraft von Große Sprachmodelle (LLMs) unbestreitbar. Von der Automatisierung des Kundenservice bis zur Generierung komplexer Codes versprechen LLMs beispiellose Effizienz und Innovation. Doch für viele große Unternehmen, insbesondere solche, die in stark regulierten Sektoren wie dem Finanzwesen, dem Gesundheitswesen und der Regierung tätig sind, wird das Streben nach Innovationen im Bereich der künstlichen Intelligenz (KI) durch ein erhebliches, nicht verhandelbares Hindernis behindert: Datenschutz und Sicherheit.

Die Standardarchitektur für die Bereitstellung anspruchsvoller LLMs umfasst häufig die Auslagerung an große öffentliche Cloud-Anbieter. Obwohl dieses Modell praktisch ist, bedeutet es von Natur aus, dass sensible Unternehmensdaten, die zum Trainieren, Feinabstimmen und Interagieren mit diesen Modellen verwendet werden, die sicheren Grenzen des internen Netzwerks des Unternehmens verlassen müssen. Diese Exposition ist nicht nur ein Risiko; Es handelt sich um einen direkten Verstoß gegen behördliche Vorschriften (wie DSGVO, HIPAA und verschiedene nationale Datenlokalisierungsgesetze) und interne Compliance-Richtlinien.

Hier entsteht das Konzept von On-Premise-LLMs, nicht nur als Alternative, sondern als wesentliche Architektur für Unternehmen, bei denen der Datenschutz an erster Stelle steht und dies oft auch tun Stellen Sie ein engagiertes Team ein für eine sichere KI-Implementierung. Der direkte Einsatz von LLMs auf unternehmenseigener, interner Hardware ist die endgültige Lösung, um absolute Datensouveränität zu erreichen und sicherzustellen, dass proprietäre Informationen niemals die physische und digitale Kontrolle des Unternehmens verlassen.

Sind Sie bereit, Unternehmensdaten beim Einsatz von KI privat zu halten? Sprechen Sie noch heute mit unseren LLM-Experten.

Der große Konflikt: Innovation vs. Konformität

Der Business Case für KI ist klar: Wettbewerbsvorteil, Kostensenkung und überlegene Entscheidungsfindung. Allerdings wird die Unternehmenslandschaft zunehmend durch eine strikte Daten-Governance bestimmt.

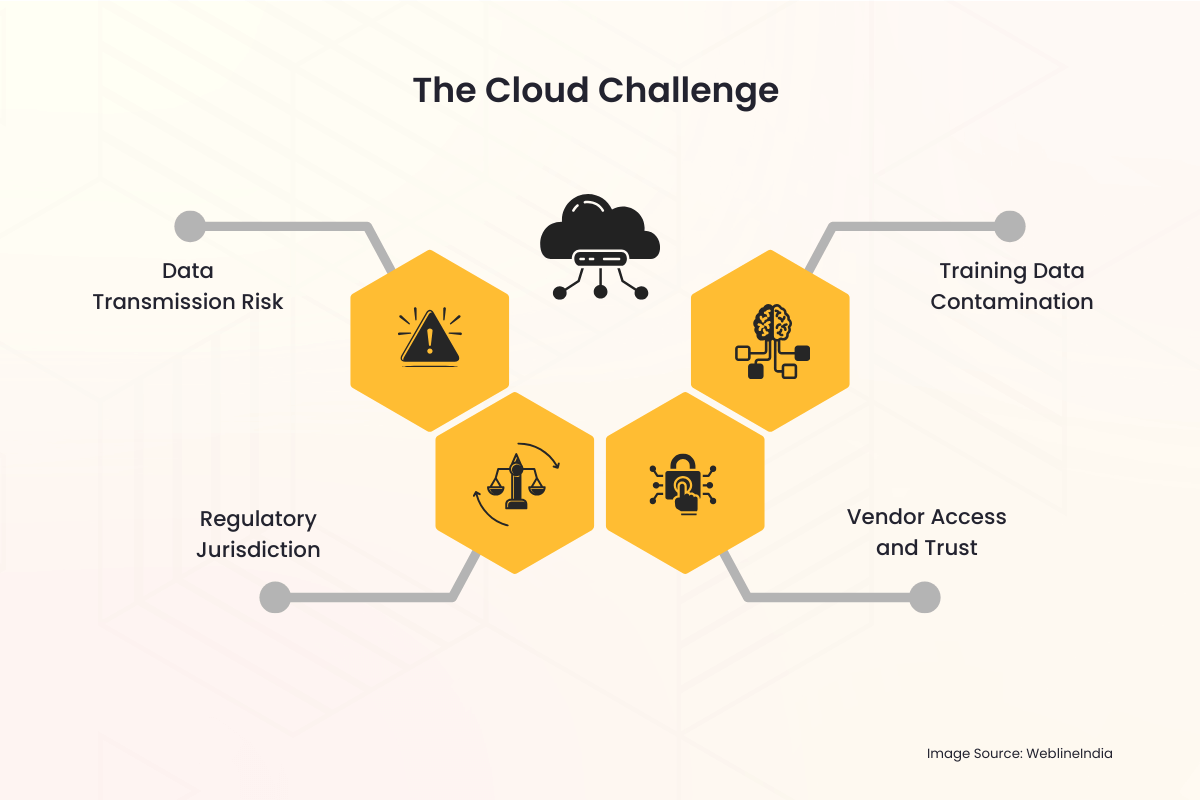

Die Cloud-Herausforderung

Wenn ein Unternehmen einen in der Cloud gehosteten LLM-Dienst nutzt, tauchen sofort mehrere Datenschutz-Fallstricke auf:

- Risiko der Datenübertragung: Jede Anfrage, jede Eingabe und die daraus resultierende Ausgabe müssen das öffentliche Internet durchlaufen und sich vorübergehend auf einem Server eines Drittanbieters befinden. Dieser gesamte Prozess ist ein potenzieller Vektor für das Abfangen oder den unbefugten Zugriff.

- Gerichtsstand: Daten, die in einem anderen Land oder einer anderen Gerichtsbarkeit als dem Ursprungsland des Unternehmens gespeichert werden, können komplexe, oft widersprüchliche internationale Gesetze zur Folge haben. Die Datenlokalisierung – die Anforderung, dass Daten innerhalb bestimmter Grenzen gespeichert und verarbeitet werden müssen – wird mit einem multinationalen Cloud-Anbieter praktisch unmöglich.

- Anbieterzugang und Vertrauen: Unternehmen sind gezwungen, den Sicherheitsprotokollen, Mitarbeiterzugriffskontrollen und Aufbewahrungsrichtlinien des Cloud-Anbieters zu vertrauen. Dies führt einen Dritten in die Arbeitsabläufe mit den sensibelsten Daten ein.

- Kontamination der Trainingsdaten: Wenn proprietäre Daten eines Unternehmens zur Feinabstimmung eines in der Cloud gehosteten Modells verwendet werden, besteht immer das Risiko, dass Modellgewichte unbeabsichtigt oder sogar böswillig weitergegeben werden oder die Reaktionen von Modellen anderer Mandanten beeinflussen, was zu Datenlecks führt.

Diese Bedenken sind nicht theoretisch. Aufsehen erregende Vorfälle von Datenschutzverstößen und die strengen Strafen, die von globalen Regulierungsbehörden verhängt werden, haben den Datenschutz von einem IT-Problem zu einer zentralen Priorität in den Vorstandsetagen gemacht. Für Organisationen, die mit personenbezogenen Daten (PII), geschützten Gesundheitsinformationen (PHI) oder geheimem geistigem Eigentum (IP) umgehen, ist das Risikoprofil von Public-Cloud-LLMs oft einfach zu hoch, um es zu akzeptieren.

Die On-Premise-Lösung: Kontrolle und Souveränität zurückgewinnen

Das On-Premise-LLM-Bereitstellungsmodell geht diese tiefgreifenden Datenschutzbedenken direkt an und löst sie, indem es die gesamte KI-Infrastruktur (die Hardware, die Software, die Modellgewichte und die Trainingsdaten) unter die direkte und ausschließliche physische und digitale Kontrolle des Unternehmens stellt.

1. Absolute Datensouveränität

Datensouveränität bedeutet, dass Daten nur den Gesetzen und Governance-Regeln des Landes oder der Organisation unterliegen, in dem sie erfasst und gespeichert werden.

- Geografische Kontrolle: Bei einer Einrichtung vor Ort befindet sich die Hardware physisch im Rechenzentrum des Unternehmens, häufig in einem bestimmten Land oder sogar in einem bestimmten sicheren Raum. Dadurch werden die Anforderungen an die Datenresidenz und Datenlokalisierung grundsätzlich erfüllt und die Einhaltung von Vorschriften wie der EU-DSGVO oder verschiedenen nationalen Sicherheitsgesetzen unkompliziert.

- Keine externe Übertragung: Die gesamte Datenverarbeitung, das Modelltraining und die Inferenz (Abfragen des Modells) erfolgen innerhalb der Unternehmens-Firewall. Sensible Eingabeaufforderungen und proprietäre interne Dokumente, die vom LLM verwendet werden, verlassen niemals die sichere Netzwerkumgebung.

2. Verbesserte Sicherheit und Compliance

Eine Bereitstellung vor Ort ermöglicht es dem Sicherheitsteam, das bestehende, robuste Sicherheits-Framework der Organisation direkt auf das KI-System anzuwenden.

- Bestehende Sicherheitsinfrastruktur: Die LLM-Lösung kann nahtlos in etablierte Unternehmenssicherheitstools integriert werden, darunter Intrusion Detection Systems (IDS), hochentwickelte Firewalls, Identity and Access Management (IAM)-Lösungen und Data Loss Prevention (DLP)-Systeme. Dies ist häufig umfassender und maßgeschneiderter als die Sicherheitsebenen, die ein allgemeiner Cloud-Dienst bietet.

- Maßgeschneiderte Zugangskontrolle: Der Zugriff auf das Modell selbst kann über unternehmensinternes Active Directory oder andere unternehmensweite IAM-Lösungen streng kontrolliert werden. Nur autorisierte Mitarbeiter, Abteilungen oder Anwendungen können mit dem Modell interagieren und Zugriffsprotokolle werden intern zu Prüfzwecken aufbewahrt.

- Vereinfachte Prüfung: Die Einhaltung gesetzlicher Vorschriften erfordert häufig detaillierte Prüfprotokolle. Durch den Besitz des gesamten Stacks kann das Unternehmen detaillierte Protokolle über jede Modellnutzung, Schulungsaufgabe und Administratoraktion führen, was die Compliance-Prüfung für interne und externe Prüfer erheblich erleichtert.

3. Schutz des geistigen Eigentums

Für Unternehmen liegt der wahre Wert eines LLM nicht nur im grundlegenden Modell (wie Llama, Mistral oder anderen), sondern auch im proprietären Wissen, das zur Feinabstimmung des Modells verwendet wird. Diese Feinabstimmungsdaten sind das geistige Eigentum der Organisation.

- Isolierte Trainingsumgebung: Wenn die Feinabstimmung vor Ort durchgeführt wird, werden die proprietären Datensätze (z. B. Kundendaten, interne Berichte, Patentanmeldungen oder Produktspezifikationen) niemals an Dritte hochgeladen. Die daraus resultierenden fein abgestimmten Modellgewichte, die das Wissen des Unternehmens effektiv verschlüsseln, werden auch intern gespeichert und verhindern so, dass externe Parteien unbefugten Zugriff auf das Kern-IP erhalten.

Benötigen Sie ein konformes On-Premise-LLM, das auf Ihre Branche zugeschnitten ist? Lassen Sie es uns sicher aufbauen.

Die praktischen Aspekte der On-Premise-LLM-Architektur

Obwohl die Vorteile für den Datenschutz überzeugend sind, erfordert die Bereitstellung eines LLM vor Ort eine sorgfältige Planung und Investitionen in die zugrunde liegende Technologie.

Die Hardware-Herausforderung: Der Bedarf an GPUs

LLMs sind rechenintensiv. Der Schlüsselfaktor für eine effiziente On-Premise-Bereitstellung ist spezielle Hardware, vor allem GPUs (Graphics Processing Units).

- Inferenzleistung: Um Benutzerabfragen (Inferenz) in Echtzeit bedienen zu können, benötigt das LLM Hochgeschwindigkeitsspeicher und parallele Rechenleistung, die von GPUs bereitgestellt werden, häufig in dedizierten Server-Racks.

- Schulung und Feinabstimmung: Das Training eines Modells von Grund auf ist ein gewaltiges Unterfangen, aber eine Feinabstimmung (Anpassung eines vorhandenen Modells) ist auf weniger, aber leistungsstarken GPUs möglich. Bei der Investition in diese Hardware handelt es sich um einen Kapitalaufwand (CapEx), der die laufenden Betriebsausgaben (OpEx) der Cloud-Servicegebühren ersetzt und eine langfristige Kostenvorhersehbarkeit bietet.

Der Software-Stack

Die vollständige On-Premise-Lösung umfasst mehr als nur Hardware. es erfordert eine robuste Software- und Orchestrierungsschicht:

- Modellauswahl: Der erste Schritt besteht darin, ein quelloffenes, kommerziell nutzbares Basis-LLM (wie Llama 3, Mistral usw.) auszuwählen, das legal heruntergeladen und auf einer privaten Infrastruktur bereitgestellt werden kann.

- Containerisierung (z. B. Docker/Kubernetes): Um die komplexe Bereitstellung zu verwalten, werden das LLM und seine Abhängigkeiten häufig in Container gepackt. Orchestrierungstools wie Kubernetes verwalten den Cluster von GPU-Servern und sorgen so für Skalierbarkeit und hohe Verfügbarkeit, ähnlich wie eine private Cloud-Umgebung – die oft von Unternehmen implementiert wird Stellen Sie Cloud- und DevOps-Ingenieure ein um eine solch komplexe KI-Infrastruktur zu verwalten.

- Interne API-Schicht: Innerhalb der Firewall ist eine Anwendungsprogrammierschnittstelle (API) integriert, die es internen Anwendungen (Chatbots, Codierungsassistenten, Datenanalysten) ermöglicht, Eingabeaufforderungen an das LLM zu senden, ohne jemals das öffentliche Internet zu berühren.

Überwindung der Datenlatenz und Governance

Vor-Ort-Lösungen beseitigen Datenlatenz und verbessern die Governance für interne Datenquellen.

- Interner Datenzugriff in Echtzeit: LLMs müssen oft auf die aktuellsten internen Daten zugreifen – ein Prozess namens Retrieval-Augmented Generation (RAG). Da das LLM vor Ort ist, verfügt es über einen Zugriff mit geringer Latenz und hoher Bandbreite auf interne Datenbanken, Data Lakes und Dokumenten-Repositories, was zu genaueren, kontextbezogenen und zeitnahen Ergebnissen führt, ohne dass eine Datenübertragung über das Internet erforderlich ist.

- Einheitliche Governance: Das Data-Governance-Team kann einen einzigen Regelsatz auf die Daten, den RAG-Index und das LLM selbst anwenden und so eine einheitliche und einfachere Compliance-Umgebung schaffen.

Strategische Vorteile für datenschutzbewusste Branchen

Der Wechsel zu einer On-Premise-Architektur ist eine strategische Entscheidung, die ein starkes Engagement für die Einhaltung gesetzlicher Vorschriften und das Vertrauen der Kunden signalisiert.

| Industrie | Primäres Datenschutzbedenken | Vorteile einer On-Premise-Lösung |

| Gesundheitswesen (HIPAA) | Schutz von PHI und Patientenakten. | Stellt sicher, dass PHI in einer sicheren, dedizierten Umgebung bleibt; vereinfacht die für die Compliance erforderlichen Audit-Protokolle. |

| Finanzdienstleistungen (DSGVO, PCI-DSS) | Kunden-PII, Transaktionsdaten, algorithmische IP. | Garantiert Datenresidenz und -lokalisierung; schützt proprietäre Handelsalgorithmen und Kundenbewertungsmodelle vor externer Gefährdung. |

| Regierung / Verteidigung | Verschlusssache, hochsensible oder staatsgeheime Informationen. | Ermöglicht den Einsatz in Air-Gap-Umgebungen (Netzwerke, die physisch vom Internet isoliert sind) und gewährleistet so absolute Sicherheit. |

| Fertigung / Forschung und Entwicklung | Geistiges Eigentum (IP), proprietäre Designs und Geschäftsgeheimnisse. | Verhindert das Durchsickern einzigartiger Herstellungsprozesse oder Produktdesigndetails, die während der RAG oder Feinabstimmung verwendet werden. |

Überbrücken Sie die Lücke mit professionellen IT-Services

Die Entscheidung, auf eine On-Premise-LLM-Architektur umzusteigen, ist zwar strategisch sinnvoll für den Datenschutz, bringt jedoch eine erhebliche betriebliche Komplexität mit sich. Es erfordert spezielle Fähigkeiten in der Hardwarebeschaffung (insbesondere Hochleistungs-GPUs), dem Aufbau einer robusten, containerisierten Umgebung (wie Kubernetes), der Feinabstimmung von Modellen für sensible Daten und der Integration des LLM in bestehende Unternehmenssysteme. Hier ist ein vertrauenswürdiger IT-Dienstleistungspartner von unschätzbarem Wert.

WeblineIndia ist eine renommierte IT-Agentur in den USA, die sich darauf spezialisiert hat, das umfassende Fachwissen bereitzustellen, das für eine reibungslose Bewältigung dieses Übergangs erforderlich ist. Sie bieten professionelle End-to-End-Dienstleistungen an, von der Entwicklung des optimalen On-Premise-Hardware-Stacks, der auf Ihre Inferenz- und Schulungsanforderungen zugeschnitten ist, bis hin zur Verwaltung der sicheren Bereitstellung von Open-Source-LLMs innerhalb Ihrer Firewall.

Cloud-Experten im Entwicklungszentrum von WeblineIndia in Indien verfügen über umfassende Erfahrung in sicherer Cloud-Infrastruktur und KI-Implementierung. Unternehmen können ihre private LLM-Umgebung schnell bereitstellen, die strikte Einhaltung interner Compliance-Richtlinien sicherstellen und die Wertschöpfung beschleunigen, ohne teure, spezialisierte interne KI-Engineering-Teams einstellen und schulen zu müssen, indem sie erfahrene Remote-Entwickler einsetzen. Diese Partnerschaft verwandelt ein anspruchsvolles Infrastrukturprojekt in eine überschaubare, strategisch umgesetzte Initiative, die sich voll und ganz der Wahrung Ihrer absoluten Datensouveränität widmet.

Mit WeblineIndia ist die Zukunft privat und sicher

Die Aufregung um LLMs sollte nicht die grundsätzliche Verantwortung der Unternehmen für den Schutz der ihnen anvertrauten sensiblen Daten überschatten. Für jede große Organisation, in der Compliance, Datenschutz und Datensouveränität nicht verhandelbar sind (was heute die erfolgreichsten Unternehmen sind), ist das Public-Cloud-LLM-Modell ein grundlegendes Missverhältnis.

Der Übergang zur LLM-Bereitstellung vor Ort stellt einen klaren Weg nach vorn dar. Es sind die notwendigen Investitionen in Hardware und Fachwissen, die die Sicherheitslücke schließen, die strengsten globalen regulatorischen Anforderungen erfüllen und es dem Unternehmen letztendlich ermöglichen, das volle, transformative Potenzial der künstlichen Intelligenz auszuschöpfen, ohne jemals sein wertvollstes Gut zu gefährden: seine Daten.

Kontaktieren Sie WeblineIndia IT-Beratungsdienste, um den inhärenten Risiken der Cloud zu entkommen und die Kontrolle über ihren KI-Stack zurückzugewinnen, um mutig Innovationen voranzutreiben. Sie können sicherstellen, dass das Vertrauen der Kunden, die Einhaltung von Vorschriften und das geistige Eigentum in ihrem eigenen Hoheitsgebiet absolut geschützt sind.

Soziale Hashtags

#OnPremiseLLM #Datensouveränität #UnternehmensKI #KICompliance #DatenschutzZuerst #SichereKI #LLMSicherheit #Unternehmenstechnologie

Möchten Sie die volle Kontrolle über Ihren KI-Stack ohne Datenrisiko? Beginnen Sie mit WeblineIndia.

Häufig gestellte Fragen

Referenzen: Hören Sie es direkt von unseren globalen Kunden

Unsere Entwicklungsprozesse liefern dynamische Lösungen, um geschäftliche Herausforderungen zu meistern, Kosten zu optimieren und die digitale Transformation voranzutreiben. Expertenunterstützte Lösungen stärken die Kundenbindung und die Online-Präsenz, während belegte Erfolgsgeschichten reale Problemlösungen durch innovative Anwendungen hervorheben. Unsere geschätzten Kunden weltweit haben es bereits erlebt.

Auszeichnungen und Anerkennungen

Zufriedene Kunden sind unsere größte Motivation, doch auch Branchenanerkennung hat einen hohen Stellenwert. WeblineIndia ist seit Jahren führend in der Technologie, und Auszeichnungen sowie Ehrungen bestätigen kontinuierlich unsere Exzellenz.

OA500 Globale Outsourcing-Unternehmen 2025, von Outsource Accelerator

Top Softwareentwicklung-Unternehmen, von GoodFirms

Bestes FinTech-Produktlösungsunternehmen – 2022, von GESIA

Ausgezeichnet als – Bestes App-Entwicklungsunternehmen in Indien 2020, von SoftwareSuggest