Las aplicaciones de seguimiento de fitness han evolucionado mucho más allá de simples contadores de pasos o registros de actividades basados en GPS. Los usuarios de hoy esperan interactividad social rica, gamificación competitiva, sincronización de datos en tiempo real e integración perfecta con un creciente ecosistema de wearables y plataformas de salud. Strava estableció un punto de referencia en este espacio al fusionar el seguimiento de las actividades atléticas con el compromiso social: tablas de clasificación, desafíos, comentarios, clubes e incluso carreras virtuales, todo envuelto en un UX resbaladizo que prioriza tanto el rendimiento como la comunidad.

El diseño de un sistema como este va mucho más allá de las operaciones básicas de CRUD en los entrenamientos de los usuarios. Exige una arquitectura robusta que pueda manejar:

- Actualizaciones de ubicación geográfica de alta frecuencia de millones de usuarios concurrentes

- Generación de alimentos en tiempo real y transmisión de actividades a redes de seguidores

- Consultas de gráficos sociales escalables y de baja latencia

- Almacenamiento y recuperación de medios (por ejemplo, mapas de ruta, fotos, insignias)

- Las tuberías de datos basadas en eventos para segmentos informáticos, tablas de clasificación y desafíos

- Controles de seguridad y privacidad en preferencias complejas de intercambio de datos

El desafío es arquitectando un backend que admite una experiencia rápida, atractiva y socialmente rica, mientras permanece lo suficientemente flexible como para integrarse con dispositivos de acondicionamiento físico de terceros, apoyar la moderación de la comunidad y evolucionar nuevas características sin romper las viejas.

Esta inmersión profunda técnica desglosa la arquitectura de dicho sistema. Describe los requisitos centrales, diseños de escalabilidad y capacidad de respuesta en tiempo real, modelos de datos para contenido generado por el usuario y patrones de infraestructura para admitir una plataforma de aptitud social que puede crecer a millones de usuarios sin degradar el rendimiento o la confiabilidad.

Requisitos del sistema

1. Requisitos funcionales

Las funcionalidades centrales de la aplicación de fitness deben respaldar el seguimiento de la actividad y el compromiso social a escala. Los requisitos funcionales clave incluyen:

- Gestión de usuarios: Registrarse, autenticación, edición de perfil y recuperación de cuentas.

- Grabación de actividad: Los entrenamientos basados en GPS log (por ejemplo, ejecuciones, viajes), entrada manual de soporte y metadatos de captura como distancia, ritmo, elevación, frecuencia cardíaca y equipo utilizado.

- Sincronización de datos en tiempo real: Ubicación de transmisión y datos del sensor de dispositivos móviles o portátiles con baja latencia.

- Gráfico social: Siga/dejar de seguir mecanismos, sugerencias de amigos y visibilidad de la actividad controlada por la privacidad (por ejemplo, privado, solo seguidores, público).

- Feed de actividad: Línea de tiempo dinámico que muestra entrenamientos de usuarios seguidos, incluidos me gusta, comentarios y re-chozas.

- Desafíos y tablas de clasificación: Cree concursos de tiempo en el tiempo (por ejemplo, “Ride 100km en 7 días”), tablas de clasificación de segmento de seguimiento y clasificaciones de calcular de manera asincrónica.

- Soporte de medios: Sube y vea fotos, enruve los mapas de calor y los logros personales (por ejemplo, insignias, hitos).

- Notificaciones: Notificaciones de impulso en tiempo real y en la aplicación por me gusta, comentarios, nuevos seguidores y actualizaciones de desafío.

- Integración de terceros: Sincronizar con Apple Health, Google Fit, Garmin y otros ecosistemas de fitness.

2. Requisitos no funcionales

Para apoyar la interacción en tiempo real y las bases de usuarios en crecimiento, el sistema debe cumplir con los estrictos requisitos no funcionales:

- Escalabilidad: Servicios y tiendas de datos escalables horizontalmente para manejar millones de usuarios activos y terabytes de datos geo-temporales.

- Baja latencia: Tiempo de respuesta sub-segundo para interacciones sociales y representación de mapas en tiempo real.

- Disponibilidad: 99.9%+ tiempo de actividad con tolerancia a fallas en regiones y zonas.

- Seguridad y privacidad: Autenticación basada en OAUTH2, control de acceso granular, almacenamiento cifrado y configuraciones de intercambio controladas por el usuario.

- Extensibilidad: Límites de servicio modular para apoyar características futuras como carreras virtuales, chats basados en clubes o entrenamiento en vivo.

- Consistencia de datos: La consistencia eventual es aceptable en feeds y tablas de clasificación, pero se requiere una consistencia sólida para transacciones como configuraciones de cuentas o compras premium.

- Soporte fuera de línea: Permitir a los usuarios registrar y colocar actividades cuando fuera de línea, con sincronización automática al reconexión.

3. Restricciones y supuestos

- Las aplicaciones móviles (iOS y Android) serán los principales clientes; La interfaz web es secundaria.

- La ubicación y los datos de salud deben procesarse bajo las regulaciones regionales de cumplimiento (por ejemplo, GDPR, HIPAA, donde corresponda).

- La mayoría de los usuarios sincronizarán 1–2 actividades por día, pero los usuarios e integraciones propensos pueden aumentar las tasas de ingestión durante eventos o períodos de desafío.

- Implementación nativa de la nube; La arquitectura asume el uso de servicios en la nube administrados para cómputo, almacenamiento y transmisión.

Caso de uso / escenario

1. Contexto comercial

La aplicación de fitness se dirige a un amplio grupo demográfico, desde caminantes casuales hasta ciclistas competitivos, pero enfatiza la participación de la comunidad sobre el seguimiento individual. Piense en ello como un híbrido entre un entrenador personal y una red social. El objetivo es impulsar el uso recurrente a través de la competencia, la responsabilidad social y el progreso gamificado, aumentando en última instancia la conversión de retención y suscripción.

La monetización en la aplicación puede incluir:

- Suscripciones premium para análisis avanzados, segmentos en vivo e ideas de capacitación más profundas

- Desafíos de marca o competiciones patrocinadas

- Promoción de equipo en la aplicación (por ejemplo, mercado de afiliados para zapatos, bicicletas, wearables)

Por lo tanto, la aplicación debe permitir una base robusta para las métricas de rendimiento en tiempo real al tiempo que ofrece experiencias atractivas y socialmente dinámicas a las que los usuarios regresan a diario, incluso si no están entrenando ese día.

2. Personas y patrones de uso

- Atletas solo: Los usuarios que rastrean sus entrenamientos, comparan el rendimiento pasado y ocasionalmente se unen a desafíos o segmentos globales.

- Entusiastas sociales: Usuarios altamente comprometidos que publican con frecuencia, comentan las actividades de los amigos y prosperan en la interacción comunitaria.

- Gerentes de club: Usuarios avanzados que coordinan eventos grupales, administran tablas de clasificación privadas y espacios sociales moderados dentro de los clubes.

- Nerds de datos: Suscriptores premium interesados en zonas de frecuencia cardíaca, curvas de potencia, métricas de recuperación y exportación de datos.

3. Escala esperada

El sistema debe estar diseñado para admitir:

- 10m+ usuarios registrados

- 2–3m MAUS (usuarios activos mensuales), con ~ 500k DAUS (usuarios activos diarios)

- Más de 10 m+ subidas por mes por mes, con picos durante los fines de semana y eventos de desafío importantes

- 500k+ usuarios concurrentes durante los períodos pico

- Miles de millones de puntos de datos por mes a través de sensores de GPS, elevación, frecuencia cardíaca y movimiento

- Millones de consultas diarias de alimentación, interacciones sociales y notificaciones en tiempo real

Para satisfacer estas demandas, la arquitectura debe optimizar las cargas de trabajo sociales pesadas de lectura, el tráfico de ingesta de ráfaga de las cargas de actividad y el procesamiento asíncrono de alto rendimiento para la coincidencia de segmentos y las actualizaciones de la tabla de clasificación.

¿Necesita ayuda para diseñar su propia aptitud física o aplicación social?

Construir una plataforma de acondicionamiento físico social que escala a millones de usuarios requiere más que código limpio: toma la arquitectura correcta desde el primer día.

¿Desea una orientación experta sobre el diseño para el rendimiento, la sincronización en tiempo real y la participación del usuario a escala?

Arquitectura de alto nivel

La arquitectura debe apoyar eficientemente la ingestión de actividad en tiempo real, la distribución de alimentos sociales, el análisis geoespacial y la interacción del usuario, todo a escala. Esto exige un enfoque modular orientado a servicios con límites bien definidos entre sistemas centrales como el seguimiento de actividades, la gestión de usuarios, el procesamiento de gráficos sociales y la entrega de notificaciones.

1. Descripción general del componente

El sistema está estructurado alrededor de los siguientes componentes principales:

- API Gateway: Punto de entrada central para toda la comunicación del cliente. Maneja la autenticación, la limitación de tarifas y enruta el tráfico a los servicios internos.

- Servicio de autenticación: Administra flujos de OAUTH2, emisión de tokens, gestión de sesiones e integración con proveedores de identidad de terceros (por ejemplo, Apple, Google).

- Servicio de perfil de usuario: Almacena información personal, preferencias, equipo y configuraciones de privacidad.

- Servicio de actividad: Maneja la ingestión de entrenamiento basada en GPS, el análisis de la ruta, la validación de actividad y la extracción de metadatos (por ejemplo, ritmo, ganancia de elevación).

- Servicio de alimentación: Genera y almacena la actividad de la actividad, procesa actualizaciones de gráficos sociales y maneja el abanico para nuevas publicaciones de actividad.

- Servicio de gráfico social: Gestiona las relaciones de seguidor y calcula la visibilidad para actividades y desafíos.

- Motor de desafío y tabla de clasificación: Calcula las clasificaciones, maneja la lógica del desafío y actualiza los trofeos y segmentos virtuales.

- Servicio de medios: Maneja las cargas de imágenes (fotos, mapas de ruta), almacenamiento en caché de CDN y control de acceso.

- Servicio de notificación: Publica notificaciones en tiempo real y por lotes a través de WebSockets, FCM/APNS o bandejas de entrada en la aplicación.

- Tubería Analytics: Procesa corrientes de actividad para ideas, detección de tendencias y recomendaciones de atletas.

- Portal de administrador y moderación: Herramientas para administrar informes de abuso, creación de desafíos y paneles de análisis.

2. Diagrama de arquitectura de alto nivel

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Resumen del flujo de datos

Cuando un usuario comienza un entrenamiento:

- La aplicación móvil transmite datos GPS y sensor a través de un WebSocket o una carga de API por parte de Servicio de actividades.

- El servicio analiza los datos, almacena el entrenamiento y emite un evento al Generador de alimentación.

- El Servicio de gráficos sociales Determina quién puede ver la actividad.

- El elemento de alimentación se almacena y se empuja a usuarios relevantes a través del Servicio de notificación.

- Si corresponde, la actividad es evaluada por el Motor de tabla de clasificación para la elegibilidad de desafío y actualizaciones de clasificación.

- Fotos y visualizaciones de ruta se envían a la Servicio de medios y almacenado en caché a través de un CDN.

Este diseño modular admite tanto la escala horizontal como la evolución del servicio aislado. También permite el abanico en tiempo real para feeds y notificaciones utilizando la comunicación basada en eventos (por ejemplo, Kafka o Nats).

Diseño de base de datos

1. Modelos de datos principales y descripción general de ERD

El sistema utiliza un enfoque de persistencia políglota: bases de datos relacionales para integridad transaccional, series de tiempo/NoSQL para datos de actividad y tiendas gráficas o en memoria para consultas sociales de alto rendimiento.

Entidades principales:

- Usuario: Información de perfil, configuración de autenticación, preferencias, nivel de suscripción

- Actividad: Datos de entrenamiento que incluyen puntos GPS, métricas, equipo, medios de comunicación

- Seguir: Relaciones de seguidores y reglas de visibilidad

- FeedItem: Eventos renderizables vinculados a los usuarios (por ejemplo, actividad publicada, comentario, insignia)

- Desafío: Metadatos y estado para competiciones grupales

- RaeperboardEntry: Posición de desafío o segmento y métricas

Diagrama de relación de entidad (conceptual):

[Usuario]

├── id (PK)

├── nombre, correo electrónico, URL del avatar

└── json de configuración

[Actividad]

├── id (PK)

├── id del usuario (FK → Usuario)

├── tipo, hora de inicio, duración

├── distancia, altitud, promedio de horas

├── referencia de datos geográficos (FK → GeoStore)

└── visibilidad (pública / seguidores / privada)

[GeoStore] (índice de almacenamiento externo o referencia de S3)

├── id (PK)

├── id de la actividad (FK → Actividad)

└── gps_data (matriz o puntero de archivo)

[Seguir]

├── id_seguidor (FK → Usuario)

├── id_seguidor (FK → Usuario)

└── creado_en

[FeedItem]

├── id (PK)

├── id_actor (FK → Usuario)

├── verbo ("publicado", "comentado", "me gusta")

├── id_objeto (p. ej., id_actividad, id_comentario)

└── id_usuario_objetivo (FK → Usuario)

[Desafío]

├── id (PK)

├── nombre, descripción, Tipo

├── fecha_de_inicio, fecha_de_fin

└── visibilidad, regla_json

[Entrada_de_la_tabla_de_clasificación]

├── id (PK)

├── id_del_desafío (FK → Desafío)

├── id_del_usuario (FK → Usuario)

├── valor_de_métrica (distancia, duración)

└── rango

2. Opciones de tecnología de bases de datos

Cada dominio de datos está optimizado para su propio patrón de acceso:

- PostgreSQL: Fuente de datos canónicos para perfiles de usuario, actividades, metadatos de alimentación y desafíos. Excelente para la integridad transaccional y la aplicación de la clave extranjera.

- TimescaledB / InfluxDB: Para la ingestión de puntos GPS, la telemetría de actividad y el análisis de la serie temporal (por ejemplo, ritmo con el tiempo, zonas de recursos humanos).

- S3 + CD: Se utiliza para almacenar pistas GPS en bruto, imágenes de ruta y medios cargados (con acceso seguro de URL previamente firmado).

- Redis / Memcached: Para una recuperación rápida de tablas de clasificación, actividades recientes y datos de alimentación precomputados.

- Neo4j o dgraph (opcional): Para el transcurso de gráfico social complejo, la membresía del club y las sugerencias de seguidores mutuos a escala.

3. Estrategia multi-tenancia y partición

- Fragmento: Las actividades y los elementos de alimentación están fragmentados por ID de usuario o ID de región para habilitar la escala horizontal en las particiones.

- Partición basada en el tiempo: La telemetría GPS y las tablas de clasificación se dividen en particiones mensuales/semanales para el envejecimiento y el rendimiento.

- Multi-tenancia suave: Los clubes u organizaciones (por ejemplo, grupos de ejecución, equipos de ciclismo) operan dentro del espacio de nombres global, pero pueden obtener consultas de alcance (a través de inquilt_id) cuando sea necesario.

4. Replicación y alta disponibilidad

- PostgreSQL: Implementado con réplicas de espera calientes y envío de Wal para conmutación por error.

- Redis: Configurado con Sentinel para alta disponibilidad y elección maestra automatizada.

- Medios y Geostore: El almacenamiento de objetos se replica en todas las regiones y se entrega a través de un CDN global para acceso de baja latencia.

Este diseño de la base de datos garantiza la evolución de esquemas flexibles, la ingestión de actividad rápida y el apoyo escalable para las cargas de trabajo social y el análisis, todo al tiempo que preserva la integridad referencial donde más importa.

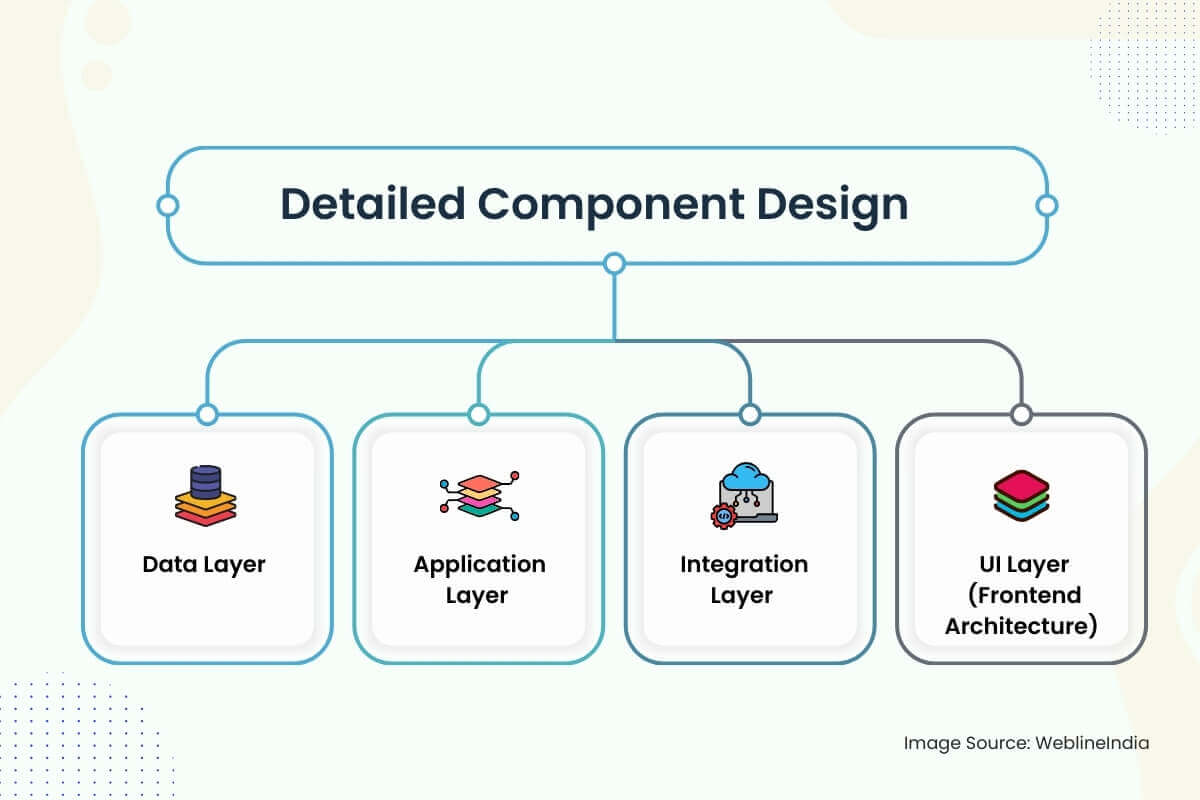

Diseño de componentes detallados

1. Capa de datos

- Estrategia de esquema: Los esquemas están diseñados en torno a los límites claros del dominio: usuarios, actividades, feeds, gráficos sociales y desafíos. Las columnas como `visibilidad`,` status` y `actividades_type` utilizan tipos enumerados para la eficiencia de indexación. Se prefieren los UUID sobre los enteros autoincremados para evitar problemas clave en las tiendas distribuidas.

- Acceso a datos: El acceso a los datos básicos pasa por repositorios de capa de servicio delgada que hacen cumplir las políticas de control de acceso (por ejemplo, verificaciones de visibilidad en las actividades). Las operaciones de lectura se optimizan a través de vistas materializadas y instantáneas de alimentación pre-unidas. Caminos de escritura como la ingestión de actividades Use colas de escritura y tuberías de inserción a granel para suavizar los picos de ingestión.

- Validación: La validación de la entrada ocurre en múltiples niveles: la aplicación de esquemas de borde a través de OpenAPI o GraphQL, validación profunda en capas de servicio (por ejemplo, puntos GPS válidos, marcas de tiempo no superpuestas) y verificaciones de sanidad asincrónica en los datos de telemetría a través de trabajos de fondo.

2. Capa de aplicación

Diseño de servicio: Cada dominio principal (usuario, actividad, alimentación, notificación, gráfico social) se implementa como un microservicio aislado. Los servicios exponen los puntos finales GRPC y REST-REST para API públicas, GRPC para la comunicación entre servicios. Principios de arquitectura limpia La lógica de dominio separada del código de transporte e infraestructura.

Marcos:

- Vaya o oxidre para servicios críticos de rendimiento (actividad, feed, tabla de clasificación)

- Node.js o python para código de pegamento, integraciones y flujos de trabajo async

- GraphQL Server (Apolo o Hasura) para agregación front-end y consultas declarativas

Autenticación: Los tokens JWT se emiten a través de flujos OAuth2. Las llamadas de servicio a servicio utilizan tokens internos firmados con ámbitos basados en roles.

Limitación de tarifas y cuotas: Implementado a través de cubos de token respaldados por Redis en la puerta de enlace y granularidad a nivel de usuario (especialmente para cargas de actividad).

3. Capa de integración

Colas de mensaje: Kafka o NATS se usa para flujos de trabajo de asíncrono: procesamiento de actividades, ventilador de alimentación, coincidencia de segmentos y publicación de notificaciones. Los manejadores ideampotentes con fuertes garantías de entrega se utilizan para evitar postes duplicados o entradas de placa de clasificación.

Sync de terceros: Integraciones de OAuth con Garmin, Fitbit, Apple Health, etc., se ejecutan a través de un combo de polvo de fondo + Webhook. Los nuevos datos se colocan y procesan a través de la tubería de ingestión de actividades.

Tipos de eventos:

Actividad.→ Servicio de ventilador para alimentar, notificar a los seguidoresdesafío. Joined→ Verifique la elegibilidad, el inserto de la tabla de clasificación de activaciónusuario.→ Actualizar gráfico, actualización de actualización, notificación de bienvenida de Enqueue

4. Capa de UI (arquitectura frontend)

Pila de aplicaciones: Reaccione nativo para aplicaciones móviles multiplataforma, con TypeScript y Redux Toolkit para la administración de estado. La aplicación web utiliza Next.js para SSR/ISR con estilo de utilidad Tailwind y consultas GraphQL para backend.

Preocupaciones de seguridad:

- Los secretos del cliente nunca están integrados: OAuth PKCE Flow es obligatorio

- Todas las llamadas de API requieren tokens firmados, y los puntos finales de orientación pública se filtran por velocidad, origen y rol

- Los datos de Geo están en arena por configuración de visibilidad: las actividades privadas se excluyen de los mapas de calor, los alimentos y los cálculos de segmento

Características en tiempo real: WebSockets o SSE se utilizan para impulsar notificaciones, estado de desafío y actualizaciones de alimentación. Filback a largas encuestas en redes restringidas. El frontend mantiene un caché local de SQLite para el registro de actividades fuera de línea.

Arquitectando algo similar?

El diseño de plataformas en tiempo real, geográficas e socialmente interactivas requiere precisión entre el flujo de datos, el manejo de eventos y la arquitectura móvil.

Si está construyendo algo ambicioso, como una plataforma de fitness social, integración portátil o alimentación en tiempo real, nos encantaría ayudarlo a hacerlo bien desde el principio.

Consideraciones de escalabilidad

1. Escala de capa de aplicación

- Servicios sin estado: Todos los servicios centrales (actividad, feed, desafío, etc.) son apátridas y horizontalmente escalables. Cada instancia es desechable y liderada por un equilibrador de carga. Los principios compartidos de nada aseguran que las instancias no dependan del estado local.

- Escala automática: Autoscaling de POD horizontal basado en K8S (HPA) se utiliza para servicios basados en métricas de profundidad de CPU, memoria y cola. Para los servicios sensibles a la latencia (como la alimentación o la notificación), las métricas personalizadas (por ejemplo, el retraso de eventos) pueden desencadenar escamas más rápidas.

- API Gateway Throtttling: Los límites de tasa basados en el cliente y la IP evitan las inundaciones de API. La tolerancia de ráfaga se admite utilizando ventana deslizante respaldada por Redis o algoritmos de cubo con fugas.

2. Escala de capa de datos

Leer Optimización: Los datos de acceso frecuente (por ejemplo, actividades recientes, instantáneas de la tabla de clasificación) se almacenan en caché agresivamente en Redis con TTLS y LRU Eviction. PostgreSQL Read Replicas se escalan en función del tráfico para descargar análisis y consultas de interfaz de usuario.

Estrategias de fragmentación:

- Datos de actividad: Prohibido por ID de usuario en particiones o grupos lógicos (por ejemplo, Activity_01, Activity_02, …)

- Artículos de alimentación: Dividido por ID de actor e ID de destinatario con índices compuestos para búsqueda rápida

- Geostore: Utiliza el prefijo de clave S3 por región y marca de tiempo para la lista de objetos optimizado y el nivel rentable

3. Feed and Social Graph Fan-Out

La generación de alimentos es un gran desafío de escalabilidad en las plataformas sociales. El sistema utiliza un enfoque de ventilador híbrido:

- Fan-Out-On-Write (primario): Cuando un usuario publica una actividad, el servicio de alimentación lo empuja en filas de alimentación precomputadas para seguidores.

- Fan-Out-On-Read (Fallback): Para los usuarios de alto rendimiento (celebridades, personas influyentes), los feeds se construyen en el momento de la consulta con paginación de registros de eventos respaldados por Kafka o tablas de índice de alimentación.

Almacenamiento de alimentación: Implementado a través de tablas optimizadas de escritura o tiendas de la familia de columnas (por ejemplo, SCYLLADB o Cassandra-Like Stores) con TTL para eventos efímeros y JSON previamente renderizado para hidratación rápida.

4. Desafío y procesamiento de la tabla de clasificación

- Computo por lotes: Las tablas de clasificación se calculan en lotes utilizando un motor de procesamiento de flujo (por ejemplo, Apache Flink, Spark Streaming). Las coincidencias de segmentos y las validaciones de desafío se ejecutan asincrónicamente desde la ingestión de actividades utilizando temas de kafka duraderos.

- Agregación de ventanas: Las estadísticas de desafío son ventanas (diarias, semanales) para evitar escaneos de antecedentes completos y reducir la presión de almacenamiento. Las vistas de material agregado están indexadas por desafío y segmento.

5. Ingestión de datos de Geo y Sensor

- Ingests de alta frecuencia: Los puntos GPS se escriben en lotes a las tiendas de series temporales (o archivos S3 con indexación) y se ponen en cuenta para evitar el desbordamiento de la memoria. El lote reduce la amplificación de escritura en el DB y acelera el manejo de la contrapresión.

- Compresión: Las coordenadas GPS están codificadas por delta y se regalan antes del almacenamiento. La rehidratación ocurre en el renderizado o el tiempo de exportación del mapa, no durante la pantalla de alimentación en tiempo real.

6. Ratios de tráfico de terceros

Los picos de sincronización de Garmin o Apple se absorben utilizando colas de ingestión desacopladas y tuberías ETL controladas por la velocidad. Cada integración tiene un disyuntor y una política de reintento para prevenir el abuso aguas arriba o las tormentas de ventilador.

Arquitectura de seguridad

1. Autenticación y autorización

- Autenticación: Todas las interacciones del cliente usan OAuth 2.0 con PKCE para flujos móviles. Los JWT son emitidos y firmados por el Servicio de Auth, que contiene ID de usuario, alcance y vencimiento. Los tokens de actualización se giran y se cifran en reposo.

- Inicio de sesión federado: Se admiten firmes de Google, Apple y Facebook, pero siempre se vinculan a una identidad de usuario nativo. Los tokens de inicio de sesión sociales son validados del lado del servidor, no confiables directamente.

- Autorización: Cada servicio valida el token JWT y hace cumplir las reglas de nivel de alcance (por ejemplo, `Leer: Feed`,` Post: Activity`). RBAC (control de acceso basado en roles) se utiliza para herramientas internas (por ejemplo, administración, roles moderadores).

2. Protección de datos

- En paz:

- Las tiendas PostgreSQL, Redis y Object están encriptadas utilizando el cifrado AES-256 con claves administradas por el cliente (CMKS).

- Los campos confidenciales (por ejemplo, correo electrónico, métricas de salud) se cifran en la capa de aplicación antes de que DB escriba.

- En tránsito: Todo el tráfico entre servicios y cliente a servidor está protegido por TLS 1.2+. Mutual TLS se utiliza para la comunicación de GRPC entre servicios de backend de confianza.

- Enmascaramiento a nivel de campo: Los campos sensibles están enmascarados o redactados en registros y paneles. La herramienta de observabilidad aplica el etiquetado de campo y el escaneo de PII automatizado antes de la ingestión.

- Privacidad Geo: Las actividades marcadas como privadas o “solo seguidores” están completamente excluidas de los feeds, las tablas de clasificación e índices de búsqueda. Los datos de mapas de calor se anonimizan y se muestrean solo de actividades públicas, con geográfico cerca de las zonas locales.

3. IAM Diseño y gestión de secretos

- Misterios: Todas las claves de API, las credenciales de DB y los tokens webhook se almacenan en una bóveda centralizada (por ejemplo, Hashicorp Vault o AWS Secrets Manager) e inyectan a través del entorno en tiempo de ejecución. Las políticas de rotación están automatizadas para credenciales de corta duración.

- SOY: Cada microservicio tiene una identidad y un conjunto de roles únicos. Las políticas de IAM se alcanzan con los permisos mínimos requeridos (por ejemplo, acceso de solo lectura al almacenamiento de objetos, acceso de solo escritura a temas de Kafka). Los agentes de CI/CD asumen roles temporales utilizando OIDC Trust.

4. Codificación segura y protección de API

- Validación de entrada: Toda la entrada externa se valora al esquema utilizando OpenAPI o esquema JSON. Frontend y el backend imponen la longitud, el formato y las verificaciones de los límites.

- Limitación de la tasa: Los límites de velocidad por usuario y por-IP se aplican a través de los complementos Redis o API Gateway. Los modelos de detección de abuso (por ejemplo, tormenta de inicio de sesión o comportamiento de spam) se alimentan de políticas dinámicas de estrangulamiento.

- Protección de reproducción: Todas las solicitudes firmadas incluyen nonces o marcas de tiempo. Las cargas de actividad y los webhooks utilizan firmas HMAC para validar el origen y evitar la manipulación.

- Seguridad del código: El análisis estático (SAST) y el escaneo de dependencia se integran en las tuberías de CI. La detección de secretos (por ejemplo, Gitleaks) bloquea la exposición accidental. Todos los flujos críticos pasan por solicitudes de extracción revisadas por pares y auditadas.

Extensibilidad y mantenibilidad

1. Límites de servicio modular

Cada dominio principal (usuarios, actividades, alimentación, notificaciones, desafíos) está encapsulado en su propio servicio, con su propio esquema, API y tiempo de ejecución desplegable. Estos servicios se comunican asincrónicamente a través de colas de mensajes o sincrónicamente a través de GRPC/REST, dependiendo de la sensibilidad de latencia.

Este aislamiento permite la escala independiente, los ciclos de liberación y la incorporación de nuevos ingenieros sin riesgo de daño colateral a características no relacionadas. Por ejemplo, enviar un nuevo formato de clasificación o disparador de notificación no toca la actividad de ingerir la lógica o los perfiles de usuario.

2. Patrones orientados al complemento

- Oyentes de eventos:Las nuevas funciones (por ejemplo, logros, alertas de coaching en vivo o insignias basadas en dispositivos) se incorporan al suscribirse a eventos clave como actividad.creada o desafío.completado. Esto permite innovar sin reescribir la lógica previa.

- Banderas de características: Todas las características orientadas al usuario están controladas por indicadores dinámicos (por ejemplo, sistemas de palanca de palanca de lanzamientoDarkly o internos), lo que permite despliegues de canarios, pruebas A/B o lanzamientos por etapas basadas en región, nivel de usuario o plataforma.

- Lógica de desafío personalizado: El motor de desafío es extensible a través de motores de reglas o secuencias de comandos incrustados (por ejemplo, Lua o Cel). Esto permite a los gerentes de marketing o clubes crear nuevos tipos de desafíos (por ejemplo, “escalar 2k metros en 3 días”) sin codificar lógica en el backend.

3. Código limpio y patrones

- Diseño impulsado por el dominio (DDD): Los servicios usan DDD para organizar la lógica por contexto limitado (agregación de actividad, puntuación del segmento, gestión de seguidores) en lugar de por capa técnica. Esto reduce la lógica transversal y la expansión de código.

- Pruebas y pelusas: CI aplica la pelusa estricta, los umbrales de cobertura de código y las pruebas de contrato para todas las API. La velocidad del desarrollador se mantiene alta porque las configuraciones de desarrollo locales utilizan contenedores con bases de datos sembradas y colas simuladas para la iteración rápida.

- Monorepo vs Polyrepo: El backend es típicamente Polyrepo (uno por servicio), mientras que la aplicación móvil puede vivir en un monoreso con paquetes modulares. Las definiciones de esquema de ProTobufs o GraphQL compartidos están controladas por versión en un repositorio de contrato separado.

4. Versión de servicio y compatibilidad con atraso

- Versión de API: Todas las API públicas están versionadas (por ejemplo, `/v1/actividades`). Los puntos finales en desuso se mantienen durante un período de puesta de sol definido, con observabilidad para monitorear el uso.

- Evolución del esquema: Los esquemas PostgreSQL usan migraciones aditivas (agregando columnas, no retirándolas) y nunca cambie el nombre de enumeraciones o restricciones sin doble lectura/escritura para alternar en su lugar. Para las tiendas NoSQL, cada objeto está etiquetado con una versión de esquema para la deserialización compatible con hacia atrás.

- Compatibilidad del protocolo: Los contratos de GRPC y ProtoBuf están diseñados para evitar romper los cambios: los campos nunca se eliminan y las ID de campo no se reutilizan. Para GraphQL, los campos desactivados permanecen disponibles con encabezados de advertencia y pelusas en la interfaz.

¿Pensando a largo plazo para su plataforma?

¿Necesita ayuda para diseñar una arquitectura modular y a prueba de futuro que no se derrumbará bajo el infierno de versiones o los cuellos de botella de crecimiento?

Ya sea que esté escalando una aplicación social o extendiendo una plataforma de fitness, estamos aquí para ayudar a Architect a largo plazo.

Optimización del rendimiento

1. Ajuste de la consulta de la base de datos

- Indexación de consultas: Cada columna de alta cardinalidad utilizada en filtros o uniones, como `user_id`,` Activity_id`, `Create_at` o` Challenge_id`, está respaldada por los índices BTree o Gin. Los índices compuestos se crean para consultas frecuentes como `Follower_id + Create_at Desc` en Feeds o` User_id + Challenge_id` en las búsquedas de la tabla de clasificación.

- Vistas materializadas: Los rollups diarios (por ejemplo, “Total Distance Run esta semana”) se almacenan como vistas materializadas y se actualizan a través de trabajos de asíncrono. Esto evita los escaneos de agregación repetitivos y acelera las métricas móviles del tablero.

- Consulta en caché: Las tablas de clasificación, los perfiles públicos y las páginas de desafío estático usan Redis como una capa de almacenamiento en caché con TTL inteligentes e invalidación explícita en eventos relevantes.

2. Procesamiento asincrónico

- Cargas de trabajo diferidas: Las tareas pesadas, como la coincidencia de segmentos, la generación de mapa de calor, la evaluación de la insignia y el avance de la alimentación del seguidor, se diferencian a los trabajadores de fondo que consumen temas de Kafka/Nats. Esto mantiene la ruta de sumisión de actividad receptiva (~ 100–200 ms p99).

- Caminos de ingestión a granel: Las cargas de Garmin o Apple Health se incluyen y procesan en paralelo, con deduplicación y aislamiento de errores para evitar bloquear las sincronizaciones completas del dispositivo debido a archivos corruptos únicos.

3. Controles de limitación y abuso de tarifas

- Control de tarifas: Cada punto final de la API tiene límites de velocidad de nivel de usuario y de nivel IP impulsado en la puerta de enlace. Las operaciones de alto costo (por ejemplo, actividades de publicación con los medios) se limitan a través de aceleraciones adaptativas vinculadas a solicitar latencia y retraso en la cola.

- Detección de abuso: Los modelos aprendidos a máquina obtienen acciones como Sigue Spam, Inundaciones de comentarios o Geo-Posting abusivo. Estos están vinculados a los filtros en tiempo real que disminuyen la velocidad o los clientes maliciosos de Sandbox automáticamente.

4. Capas de almacenamiento en caché

- Almacenamiento en caché: Los mapas de ruta, los avatares de perfil, las páginas de desafío y las baldosas de mapa de calor se sirven a través de nodos de borde CDN (CloudFlare, rápidamente). Las teclas de caché están etiquetadas con la versión hash para permitir una invalidación global rápida.

- Caché del lado del cliente: La aplicación móvil utiliza SQLite local para el modo fuera de línea, con hidratación de las blobs JSON actualizadas por Delta recibidas en Startup o Post-Login. Esto permite la representación de alimentación instantánea y el comienzo más suave.

5. Rendimiento frontend

- Carga incremental: Los pergaminos de alimentación, las vistas de perfil y las listas de desafíos implementan la paginación infinita de desplazamiento o ventana utilizando tokens basados en cursor. Esto minimiza el tamaño de la carga útil y la presión de memoria en los clientes móviles.

- Optimización de imágenes: Todas las imágenes cargadas son redimensionadas, comprimidas y convertidas en formato (por ejemplo, WebP) por el servicio de medios antes de la entrega de CDN. Las variantes de activos específicos del dispositivo se seleccionan utilizando encabezados de negociación de contenido.

- JS BUNDLING & TREE STARK: Los clientes web usan agrupadores modernos (por ejemplo, Vite o Webpack 5) con división de importación dinámica y agitación de árboles. La carga perezosa se emplea para componentes de UI no críticos como gráficos, mapas o análisis.

Estrategia de prueba

1. Tipos de pruebas

- Prueba unitaria: Cada capa de servicio tiene pruebas unitarias extensas que cubren la lógica del dominio, la validación de entrada y las funciones de utilidad. Estos son rápidos y aislados, no se permiten dependencias externas. Las bibliotecas de burla (por ejemplo, Gomock, Pytest-Mock, Jest) se usan para aislar los efectos secundarios.

- Prueba de integración: Las interacciones clave del servicio, como el envío de actividades que desencadenan la generación de alimentos o las verificaciones de elegibilidad de desafío, están cubiertas con entornos de prueba basados en Docker. Estas pruebas giran dependencias reales (PostgreSQL, Redis, Kafka) y validan el comportamiento en condiciones realistas.

- Prueba de contrato: Para las API de GRPC y REST, las pruebas de contrato (por ejemplo, el uso de PACT o BUF para ProTobuf) validan que los servicios de productores y consumidores se adhieren a los esquemas acordados, especialmente en los baches de versión de servicio o durante las implementaciones paralelas.

- Prueba de extremo a extremo (E2E): Los flujos críticos del usuario (registro, inicio de sesión, seguimiento de actividades, comentarios) se prueban utilizando cipreses o desintoxicación (para React Native). Estas pruebas se ejecutan en emuladores y dispositivos reales en CI contra entornos de estadificación.

2. Estrategia de cobertura de prueba de CI

- Aplicación de la cobertura del código: Se aplican umbrales mínimos para PRS utilizando herramientas como CodeCov o Sonarqube. El bloque de puertas de cobertura se fusiona si el nuevo código carece de casos de prueba adecuados, especialmente para las funciones de transformación de datos o lógica de servicio.

- Tuberías de CI paralelizadas: Las pruebas se agrupan por servicio y se ejecutan en paralelo a través de acciones de GitHub, Circleci o Buildkite. La matriz de prueba incluye permutaciones de entorno (por ejemplo, diferentes versiones de DB, versiones API).

- Accesorios de prueba y siembra: Los datos de la prueba compartida se aprovisionan a través de instantáneas contenedores o accesorios declarativos de YAML/JSON. Todos los servicios soportan el modo de prueba de prueba para entornos de pruebas locales y de CI.

3. Pruebas de carga y resiliencia

- Prueba de carga: Las secuencias de comandos de langosta, artillería o K6 simulan patrones de tráfico máximo (gran ventilador, cargas de actividad masiva, actualización de la tabla de ritmo de desafío, para probar la respuesta del sistema bajo estrés. Las pruebas de carga se ejecutan semanalmente y durante los principales lanzamientos.

- Ingeniería del caos: Herramientas como Gremlin o Litmuschaos inyectan fallas en el servicio, DB o capa de red (por ejemplo, picos de latencia, particiones de Kafka, fallaos de DB). El objetivo es validar las políticas de reintento, la lógica de retroceso y la cobertura de alerta.

- Afirmaciones de resiliencia: Los interruptores de circuitos, los mamparos y las retroceso de tiempo de espera se prueban explícitamente. Las implementaciones canarias incluyen pruebas de inyección de fallas antes de que avance el despliegue completo.

DevOps y CI/CD

1. Descripción general de la tubería de CI/CD

Todo el sistema se basa en flujos de trabajo basados en GIT (GitHub, GitLab o Bitbucket) con tuberías automatizadas activadas en solicitudes de extracción, fusiones y lanzamientos basados en etiquetas. CI/CD se trata como un producto de primera clase con rendimiento, aislamiento y visibilidad como principios centrales.

Etapas de tubería:

- Construir: Las imágenes de contenedores se construyen por servicio utilizando DockerFiles de varias etapas. Las imágenes base comunes se almacenan en caché y se reutilizan. Para las aplicaciones frontend, los pasos de compilación incluyen agitación de árboles, transpilación y análisis de paquetes.

- Prueba: Las pruebas de unidad, integración y contrato se ejecutan en trabajos aislados con carga de artefactos (por ejemplo, informes de cobertura, registros de pruebas). Los trabajos fallidos se anotan en línea en PRS para el triaje rápido.

- Escaneo de seguridad: Los escaneos de vulnerabilidad SAST (por ejemplo, Sonarqube, Snyk) y de dependencia se aplican antes de que se promuevan los artefactos. Secretos herramientas de escaneo bloquean la exposición accidental.

- Firma de imagen: Las imágenes de contenedores se firman y almacenan en un registro seguro (por ejemplo, AWS ECR, Registro de artefactos GCP) con etiquetas inmutables y metadatos de procedencia.

- Despliegue de estadificación: Las construcciones etiquetadas se implementan automáticamente en un clúster de puesta en escena. Las pruebas canarias, las pruebas de humo y las verificaciones de salud sintéticas se ejecutan en este entorno con TTL cortos.

- Promoción de la producción: Las implementaciones en PRODS se activan manualmente (con puertas de aprobación) o automáticamente después de pasar las condiciones de control de calidad. Las herramientas de GITOPS (por ejemplo, ArgoCd, Flux) aplican manifiestas de un repositorio estatal versionado.

2. Infraestructura como código (IAC)

- Terraform: Toda la infraestructura (VPC, grupos K8s, instancias de DB, roles IAM, colas) se gestiona a través de módulos Terraform. Los cambios se revisan y previsecen utilizando

plan de terraformaciónen prs. La detección de deriva funciona todas las noches para detectar cambios manuales. - Personalizar y cascos: Los manifiestos de K8S se plantan a través de timón y se manejan en entornos utilizando superposiciones de kustomice. Esto facilita la anulación de réplicas, configuraciones y secretos por entorno.

- Gestión de secretos: Los secretos y los mapas de configuración se inyectan a través de secretos sellados (por ejemplo, SOPS Mozilla, secretos sellados de Bitnami) o sincronizados de bóveda utilizando inyectores sidecar. Todos los secretos se rotan y auditan regularmente.

3. Estrategia de implementación

- Implementaciones de color verde azulado: Para los servicios de ruta crítica como la autores o la actividad, se utilizan estrategias de color verde azulado. El tráfico se cambia gradualmente utilizando reglas de ingreso, con una reversión automatizada si las verificaciones de salud fallan.

- Lanzamientos canarios: Los servicios no críticos (por ejemplo, notificaciones, tablas de clasificación) usan despliegue canarios, desplegando al 5%, luego al 25%, luego al 100%con el tiempo. Las métricas (latencia, tasa de error, CPU) se comparan con las líneas de base antes de continuar.

- Banderas de características: Todas las nuevas rutas de código están protegidas por alternar de características. Esto permite la exposición progresiva, los lanzamientos oscuros y los interruptores de matar instantáneos durante los incidentes.

4. Artefacto e higiene ambiental

- Ciclo de vida de imagen: Las construcciones antiguas se podan automáticamente en función de las políticas de retención de edad o SHA. Las imágenes no utilizadas nunca se mantienen más allá de los 30 días a menos que se etiqueten como LTS o versiones de reversión.

- Entornos de vista previa: Los entornos de estadificación efímera se crean por PR utilizando espacios de nombres dinámicos en Kubernetes. Estos entornos imitan las topologías de producción y se destruyen después de la fusión o el cierre de relaciones públicas.

- Mecanismo de reversión: Cada implementación es atómica y de piñada. Las reversiones se pueden activar a través de Git Revert, Historial de timón o clic UI Argocd, en cuestión de segundos.

¿Necesita ayuda para enviar más rápido sin romper las cosas?

¿Desea construir una tubería de ingeniería de alta velocidad con balas a prueba de balas, flujos de trabajo GITOPS y CI/CD de grado de producción?

Ya sea que esté ampliando un backend de microservicios o iniciando una nueva función móvil, vamos a arquitectar un sistema DevOps que funcione bajo presión.

Monitoreo y observabilidad

1. Registro

- Registro estructurado: Cada servicio inicia sesión en formato JSON utilizando campos estructurados como `request_id`,` user_id`, `actividades_id` y` duration_ms`. Los registros se transmiten a través de Bit Fluent o Filebeat en una tubería central (por ejemplo, Elasticsearch, Loki) para consultas y análisis indexados.

- IDS de correlación: Cada solicitud genera una ID de correlación única que se propaga a través de los límites del servicio a través de encabezados y contexto de registro. Esto permite la trazabilidad completa de extremo a extremo de la aplicación móvil a las colas de back-end a DB.

- Higiene de registro: Las reglas de enmascaramiento de PII se aplican en el nivel de tubería de registro. Los secretos, los tokens de acceso, las coordenadas GPS y la telemetría en bruto se excluyen o se redactan automáticamente antes de que los registros presionen el almacenamiento.

2. Métricas

- Métricas del sistema: La CPU, la memoria, el disco y el uso de la red se exportan desde cada nodo y POD a través de los exportadores Prometheus. Los umbrales de alerta se establecen para saturación, presión de recursos y rotación inusual de POD.

- Métricas comerciales:

- Actividades por minuto, eventos de alimentación por segundo

- El desafío se une, escribe la tabla de clasificación, partidos de segmento

- Latencia por punto final, tasas de error de percentil 99

- Instrumentación personalizada: Los servicios utilizan las bibliotecas de clientes Prometheus para exportar contadores, histogramas y medidores para la lógica personalizada, como “evaluaciones de insignias procesadas” o “puntos GPS por carga”.

3. Rastreo distribuido

- Sistema de rastreo: OPENTELEMETRY se utiliza para instrumentos de servicios con tramos para llamadas HTTP/GRPC, consultas DB y manejo de colas de async. Las rastros se exportan a backends como Jaeger, Honeycomb o Tempo.

- Muestreo de rastreo: El muestreo basado en la cabeza (con tasas ajustables) garantiza que las transacciones de alto valor, como la ingestión de actividades o el avance de la alimentación, siempre se capturen, mientras que los trabajos de fondo de baja prioridad se muestrean de manera probabilística.

- Vinculación de rastreo: Todos los rastros se vuelven a los ID de usuario y los metadatos de solicitud, lo que permite la depuración de envíos de actividades individuales, errores de tabla de clasificación o generación de alimentación lenta de seguidores con cadenas de causalidad exactas.

4. Alertas y paneles

- Gestión de alerta: Prometheus AlertManager u Opsgenie maneja la deduplicación, las ventanas de silencio, las rotaciones de guardia y las políticas de escalada. Las alertas incluyen ganchos Slack/Teams, SMS y Pagerduty cuando se cruzan los umbrales críticos.

- Paneles: Los paneles de Grafana se prefieren por servicio con capacidades de desglose para latencia, tasas de error, rendimiento de DB, retrasos en cola y fallas de API externas. Las partes interesadas comerciales también obtienen vistas de KPI (por ejemplo, usuarios activos, tasas de finalización de desafío).

- SLOS y presupuestos de error: Los puntos finales clave (por ejemplo, sumisión de actividad, carga de alimentación, unión de desafío) están vinculados a SLOS formales con umbrales de latencia/error. Las tasas de quemaduras se calculan para informar el ritmo de activación y despliegue de la bandera de características.

5. Verificaciones de salud y sondas de preparación

- Livial y preparación: Todos los servicios exponen los puntos finales `/HealthZ` para la vida básica (por ejemplo, estado del grupo de subprocesos, memoria) y preparación (por ejemplo, conectividad DB, retraso de cola). Kubernetes usa estos para la orquestación de autoscalización y implementación.

- Cheques profundos: Las tareas de fondo periódicas realizan transacciones sintéticas (por ejemplo, actividad de prueba inserta + lectura de alimentación) para validar la salud de la lógica de negocios, no solo el tiempo de actividad del sistema.

Compensaciones y decisiones de diseño

1. Abanico de escritura vs. Abanico de lectura

- Decisión: Se eligió un modelo híbrido. Para los usuarios promedio, el sistema utiliza Fan-Out-On-Write para prepoblar las alimentos. Para los usuarios de alto rendimiento (por ejemplo, personas influyentes), cambia a Fan-Out-On-Lead.

- Por qué: Las entradas de alimentación precomputas minimizan la latencia y descarga la ruta de lectura, pero es costoso cuando un usuario tiene miles de seguidores. El diseño híbrido se optimiza para el caso del 95% al tiempo que protege la infraestructura de las tormentas de ventilador.

- Compensación: Más complejidad operativa. El sistema debe enrutar dinámicamente las escrituras/lecturas a través de diferentes rutas de código basadas en el nivel de usuario o el recuento de seguidores. También aumenta la superficie de la prueba.

2. Persistencia políglota

- Decisión: PostgreSQL, Redis, Kafka y S3 fueron elegidos como la pila central. El uso opcional de Neo4J para el recorrido de gráfico social se diferenció.

- Por qué: Estas herramientas se alinean bien con los patrones de acceso: PostgreSQL para integridad, redis para acceso de baja latencia, kafka para escala basada en eventos y S3 para el almacenamiento de blob. Evitar un gráfico especializado DB Simplified OPS y incorporación.

- Compensación: Algunas consultas de gráficos (por ejemplo, “seguidores mutuos en un club”) son menos eficientes sin un motor gráfico dedicado. El almacenamiento en caché basado en Redis mitiga esto, pero agrega complejidad de coherencia de caché.

3. Sync de GPS en tiempo real frente a la carga posterior al entrenamiento

- Decisión: La carga posterior al entrenamiento es el valor predeterminado; La sincronización en tiempo real es opcional y opta (por ejemplo, para seguimiento en vivo o carreras virtuales).

- Por qué: La transmisión GPS en tiempo real crea una carga de backend constante, introduce desafíos de consistencia para actividades parciales y aumenta el drenaje de energía en los dispositivos móviles. Para la mayoría de los usuarios, la carga por lotes es suficiente.

- Compensación: Capacidad reducida para alimentar características como vítores en vivo, coincidencia de marcapasos o actualizaciones de tabla de clasificación en progreso. Las versiones futuras pueden ampliar el soporte en tiempo real detrás de las banderas de funciones.

4. Microservicios vs. Monolito

- Decisión: Los microservicios se eligieron temprano, con límites de dominio claros: actividad, alimento, usuario, desafío, medios, etc.

- Por qué: Permite la escala independiente, el desarrollo paralelo y la propiedad específica del dominio. La ingestión de alimentación y actividad tiene perfiles de rendimiento muy diferentes: separarlos permite la optimización dirigida.

- Compensación: Requiere herramientas robustas: descubrimiento de servicios, seguimiento, aislamiento de CI/CD y madurez de ingeniería de plataforma. Para los equipos pequeños, esto agrega complejidad por adelantado, pero la agilidad a largo plazo supera el dolor a corto plazo.

5. Flujos de trabajo síncronos vs.

- Decisión: Todas las rutas no críticas (ventilador de alimentación, actualizaciones de la tabla de clasificación, notificaciones) son asíncronas a través de Kafka/Nats. Solo las consultas de autores y usuarios usan flujos de solicitud/respuesta.

- Por qué: Los sistemas de asíncrono escala mejor y decouple flujos de trabajo. También permiten lotes de lotes, reintentos y priorización de la cola, esencial para patrones de ingesta de variables como sincronizaciones de terceros o picos de desafío.

- Compensación: Eventual consistencia y complejidad de depuración. Requiere DLQS (colas de letras muertas), repeticiones de eventos y lógica de deduplicación cuidadosa. El monitoreo y la observabilidad son clave para la seguridad aquí.

Deuda arquitectónica y mitigaciones

- Algunas rutas de alimentación más antiguas aún suponen escrituras sincrónicas, que se refactoran en servicios de fane-out con sede en Kafka.

- El motor de desafío inicial tenía reglas codificadas, reemplazadas por un motor de reglas para su flexibilidad.

- Lógica de permiso dispersada en todos los servicios: se centraliza en un servicio de política de acceso para hacer cumplir la consistencia.

Takeaways y áreas clave para mejorar

1. Lo que esta arquitectura hace bien

- Escalabilidad por diseño: Los servicios sin estado, el procesamiento basado en eventos y las bases de datos fragmentadas mantienen el sistema receptivo incluso a millones de usuarios y altas tasas de ingestión.

- Límites modulares: La separación clara entre actividad, social, medios y lógica de análisis permite una optimización enfocada y un desarrollo seguro y paralelo.

- Async primero: Desacoplar la generación de alimentos, la puntuación del desafío y las notificaciones de la ruta de ingesta de núcleo ofrecen un rendimiento y aislamiento de fallas donde importa.

- Seguridad y privacidad: Los controles de acceso de grano fino, el almacenamiento cifrado y las prácticas de observabilidad estrictas se alinean con la responsabilidad de datos de nivel GDPR.

- Velocidad del desarrollador: Las tuberías de CI/CD, los indicadores y las pruebas de contrato admiten la iteración rápida y segura, sin comprometer la estabilidad de producción.

2. Oportunidades de mejora

- Consultas de gráficos dinámicos: Reevaluando el uso de Redis versus DBS gráficos especialmente diseñados (por ejemplo, DGRAPH, Nebula) para la detección de seguidores mutuos o características avanzadas del club.

- Control de acceso unificado: Centralización de todas las verificaciones de permisos en un servicio de políticas (OPA o personalizado) para evitar la duplicación y la deriva en los servicios.

- Características en vivo: Expandir capacidades en tiempo real (por ejemplo, segmentos en vivo, marcapasos, ejecuciones grupales) con protocolos de transmisión confiables y despliegue controlado.

- Sincronización móvil fuera de línea: Mejora de UX fuera de línea para usuarios en áreas rurales o durante actividades largas al aire libre con mejores estrategias de resolución de conflictos.

- Análisis avanzado: Construyendo tuberías dedicadas de atletas (por ejemplo, estimación máxima de VO2, carga de entrenamiento) utilizando lagos de datos preingregados y modelos ML.

Esta plataforma de diseño equilibra el rendimiento, la flexibilidad y la experiencia del usuario en un contexto social de fitness exigente. Está listo para la producción, probado en batalla y construido para el crecimiento, pero con espacio para evolucionar hacia un ecosistema de acondicionamiento físico más inteligente, en tiempo real y personalizado.

¿Construir algo tan ambicioso?

Diseñar plataformas escalables, seguras y socialmente atractivas no se trata solo de elegir la pila adecuada, sino que se trata de tomar las decisiones correctas en el momento adecuado.

Ya sea que esté lanzando una aplicación de fitness, mejorando la participación del usuario o modernizando su backend, estamos listos para ayudarlo a arquitectarla con confianza.

La gente también pregunta (preguntas frecuentes)

¿Cómo desarrollar una aplicación de rastreador de fitness?

Comience por definir las características centrales: seguimiento de actividad GPS, ingestión de datos de salud (frecuencia cardíaca, pasos), perfiles de usuario y registro fuera de línea. A partir de ahí, diseñe una experiencia móvil primero utilizando React Native o Swift/Kotlin, implementa la autenticación segura de los usuarios (OAUTH2) y conecte a un backend que pueda ingerir, procesar y analizar los datos del sensor en tiempo real. La infraestructura nativa de la nube, las tiendas de datos escalables y el procesamiento basado en eventos serán clave para mantener apretados el rendimiento y la capacidad de respuesta.

¿Cuánto cuesta construir una aplicación de fitness?

Depende del alcance, pero una aplicación de fitness de grado de producción con seguimiento GPS, autenticación de usuario, sincronización en tiempo real, almacenamiento en la nube y características sociales generalmente costará entre $ 50k a $ 500k+ para construir y lanzar. Eso incluye UI/UX, desarrollo móvil, arquitectura de backend, DevOps y QA. Escala de costos basado en la complejidad: el seguimiento en vivo, los gráficos sociales, las integraciones y el análisis aumentan el esfuerzo de ingeniería.

¿Cómo hacer una aplicación Strava?

Para construir una aplicación similar a Strava, necesitará un cliente móvil para la grabación de actividades basada en GPS, un backend para almacenar y analizar los entrenamientos de los usuarios, y una capa de gráfico social para alimentos, seguidores e interacciones. Los componentes centrales incluyen una tubería de ubicación en tiempo real, un servicio de alimentación escalable y un motor basado en eventos para desafíos y tablas de clasificación. La arquitectura para la escalabilidad, la baja latencia y los límites de servicio modular es esencial.

¿Cuánto cuesta crear una aplicación como Strava?

Una plataforma de estilo strava con todas las funciones puede exceder fácilmente $ 500k a $ 1M+ en el costo de desarrollo, dependiendo de su conjunto de características, estructura de equipo y tiempo de comercialización. Los costos incluyen desarrollo móvil y de back-end, infraestructura en la nube, optimización del rendimiento y soporte para cosas como cargas de medios, configuraciones de privacidad e integraciones de dispositivos de terceros.

¿Qué base de datos usa Strava?

Strava no ha detallado públicamente su pila completa, pero en base a patrones comunes a sistemas de escala similar, es probable que usen una combinación de bases de datos relacionales (por ejemplo, PostgreSQL), almacenes de datos distribuidos para telemetría (por ejemplo, Cassandra o DBS de series de tiempo) y sistemas similares a la caza de caché. Su arquitectura está basada en eventos y basada en microservicios, con infraestructura en la nube que maneja millones de actividades por día.

¿Por qué Strava es tan popular?

Strava clavó la mezcla de seguimiento de fitness y compromiso social. No se trata solo de grabar carreras, se trata de compartirlas, competir en segmentos, ganar insignias e interactuar con una comunidad. La alimentación social, las características de la gamificación y el ecosistema desafío hacen que la plataforma sea pegajosa y formadora de hábitos, lo que impulsa la retención y la viralidad.

¿Es rentable una aplicación de fitness?

Sí, si se ejecuta bien. Las aplicaciones de fitness basadas en suscripción (como Strava Premium, MyFitnessPal, etc.) han demostrado ser altamente rentables. Los ingresos pueden provenir de análisis premium, herramientas de coaching, desafíos de marca o mercados de engranajes. Pero la rentabilidad requiere una fuerte estrategia de retención, eficiencia de infraestructura y crecimiento de los usuarios más allá de MVP.

¿Cómo monetizo mi aplicación de fitness?

Las estrategias de monetización comunes incluyen: suscripciones freemium (por ejemplo, desbloquear análisis o coaching más profundos), compras en la aplicación (por ejemplo, planes de capacitación), asociaciones de marca (por ejemplo, desafíos patrocinados) y mercados afiliados (por ejemplo, zapatos, wearable). Los anuncios son posibles, pero a menudo degradan la experiencia del usuario. Concéntrese en la confianza del usuario y el valor a largo plazo al diseñar rutas de monetización.

Testimonios: Escúchalo directamente de nuestros clientes globales

Nuestros procesos de desarrollo ofrecen soluciones dinámicas para afrontar retos empresariales, optimizar costos e impulsar la transformación digital. Soluciones respaldadas por expertos mejoran la retención de clientes y la presencia en línea, y casos de éxito comprobados muestran la resolución de problemas reales mediante aplicaciones innovadoras. Nuestros estimados clientes en todo el mundo ya lo han experimentado.

Premios y Reconocimientos

Aunque los clientes satisfechos son nuestra mayor motivación, el reconocimiento de la industria tiene un valor significativo. WeblineIndia ha liderado constantemente en tecnología, con premios y galardones que reafirman nuestra excelencia.

OA500 Empresas globales de externalización 2025, por Outsource Accelerator

Mejor empresa de desarrollo de software, por GoodFirms

Mejor empresa de soluciones de producto fintech – 2022, por GESIA

Premiada como – Mejor empresa de desarrollo de apps en India 2020, por SoftwareSuggest