När marknaden drivs av digitalisering är den transformativa kraften hos Stora språkmodeller (LLM) obestridlig. Från att automatisera kundtjänst till att generera komplex kod, LLMs lovar oöverträffad effektivitet och innovation. Ändå, för många stora företag, särskilt de som är verksamma inom starkt reglerade sektorer som finans, sjukvård och myndigheter, hämmas strävan efter artificiell intelligens (AI) av en betydande, icke förhandlingsbar vägspärr: datasekretess och säkerhet. Standardarkitekturen för att distribuera sofistikerade LLM:er involverar ofta outsourcing till stora offentliga molnleverantörer.

Även om den är bekväm, betyder den här modellen i sig att känslig företagsdata, som används för att träna, finjustera och interagera med dessa modeller, måste lämna de säkra gränserna för företagets interna nätverk. Denna exponering är inte bara en risk; det är ett direkt brott mot regulatoriska mandat (som GDPR, HIPAA och olika nationella lagar om datalokalisering) och interna efterlevnadspolicyer.

Det är här konceptet med on-premise LLMs dyker upp, inte bara som ett alternativ, utan som den väsentliga arkitekturen för företag som är fast beslutna att vara sekretess-först och ofta väljer att anställa ett dedikerat team för säker AI-implementering. Att distribuera LLM:er direkt på företagsägd, intern hårdvara är den definitiva lösningen för att uppnå absolut datasuveränitet, vilket säkerställer att proprietär information aldrig lämnar den fysiska och digitala kontrollen av organisationen.

Är du redo att hålla företagsdata privat när du använder AI? Prata med våra LLM-experter idag.

Den stora konflikten: innovation vs. efterlevnad

Affärsfallet för AI är tydligt: konkurrensfördelar, kostnadsminskning och överlägset beslutsfattande. Företagslandskapet definieras dock alltmer av strikt datastyrning.

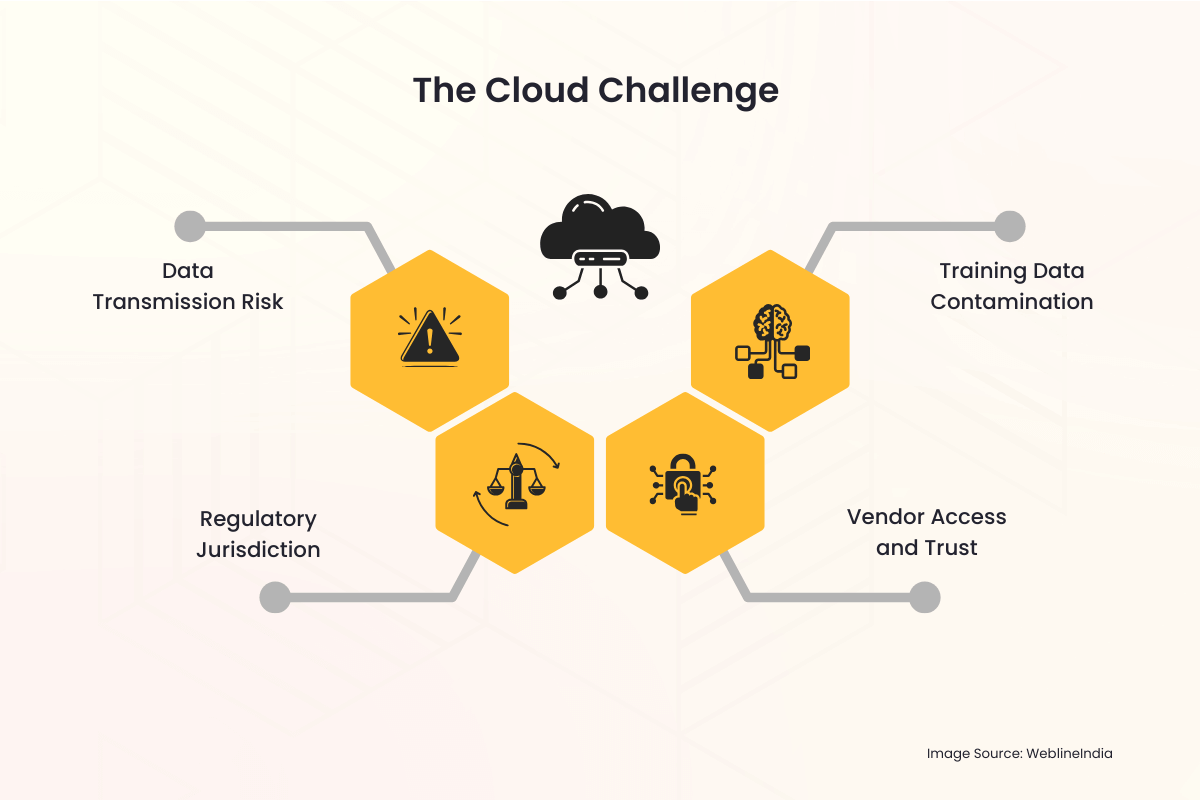

Molnutmaningen

När ett företag använder en molnbaserad LLM-tjänst uppstår flera sekretessfällor omedelbart:

- Dataöverföringsrisk: Varje fråga, varje ingång och den resulterande utdata måste passera det offentliga internet och tillfälligt finnas på en tredjepartsserver. Hela denna process är en potentiell vektor för avlyssning eller obehörig åtkomst.

- Regulatorisk jurisdiktion: Data som lagras i ett annat land eller jurisdiktion än företagets ursprung kan utlösa komplexa, ofta motstridiga, internationella lagar. Att uppnå datalokalisering – kravet på att data ska lagras och bearbetas inom specifika gränser – blir praktiskt taget omöjligt med en multinationell molnleverantör.

- Leverantörsåtkomst och förtroende: Företag tvingas lita på molnleverantörens säkerhetsprotokoll, åtkomstkontroller för anställda och lagringspolicyer. Detta introducerar en tredje part i de mest känsliga dataarbetsflödena.

- Kontaminering av träningsdata: Om ett företags egna data används för att finjustera en modell som är värd i molnet, finns det alltid en risk att modellvikter oavsiktligt, eller till och med uppsåtligt, kan delas eller påverka svaren från modeller som används av andra hyresgäster, vilket leder till dataläckage.

Dessa farhågor är inte teoretiska. Uppmärksammade incidenter av dataintrång och de stränga påföljder som upprätthålls av globala tillsynsorgan har höjt datasekretessen från IT-huvudvärk till en central styrelseprioritet. För organisationer som hanterar personligt identifierbar information (PII), skyddad hälsoinformation (PHI) eller sekretessbelagd immateriell egendom (IP), är riskprofilen för LLM i offentliga moln ofta helt enkelt för hög för att accepteras.

Den lokala lösningen: Återta kontroll och suveränitet

Den lokala LLM-implementeringsmodellen tar direkt upp och löser dessa djupa integritetsproblem genom att placera hela AI-infrastrukturen (hårdvaran, mjukvaran, modellvikterna och utbildningsdata) under direkt och exklusiv fysisk och digital kontroll av företaget.

1. Absolut datasuveränitet

Datasuveränitet innebär att data endast omfattas av lagarna och styrningsreglerna i det land eller den organisation där den samlas in och lagras.

- Geografisk kontroll: Med en lokal installation är hårdvaran fysiskt placerad i företagets datacenter, ofta i ett specifikt land eller till och med ett specifikt säkert rum. Detta tillfredsställer i sig kraven på datauppehåll och datalokalisering, vilket gör det enkelt att följa bestämmelser som EU:s GDPR eller olika nationella säkerhetslagar.

- Noll extern överföring: All databehandling, modellutbildning och slutledning (fråga om modellen) sker inom företagets brandvägg. Känsliga uppmaningar och proprietära interna dokument som används av LLM lämnar aldrig den säkra nätverksmiljön.

2. Förbättrad säkerhet och efterlevnad

En lokal distribution gör att säkerhetsteamet kan tillämpa organisationens befintliga, robusta säkerhetsramverk direkt på AI-systemet.

- Befintlig säkerhetsinfrastruktur: LLM-lösningen kan sömlöst integreras med etablerade företagssäkerhetsverktyg, inklusive Intrusion Detection Systems (IDS), sofistikerade brandväggar, lösningar för identitets- och åtkomsthantering (IAM) och system för förebyggande av dataförlust (DLP). Detta är ofta mer omfattande och skräddarsytt än säkerhetsskikten som erbjuds av en generisk molntjänst.

- Anpassad åtkomstkontroll: Tillgången till själva modellen kan kontrolleras strikt via företagets interna Active Directory eller andra företags IAM-lösningar. Endast auktoriserade anställda, avdelningar eller applikationer kan interagera med modellen, och åtkomstloggar bevaras internt för revisionsändamål.

- Förenklad revision: Regelefterlevnad kräver ofta detaljerade revisionsspår. Genom att äga hela stacken kan företaget föra detaljerade loggar över varje modellanvändning, utbildningsuppgift och administratörsåtgärd, vilket gör kontroller av efterlevnad mycket enklare för interna och externa revisorer.

3. Immaterialrättsskydd

För företag ligger det verkliga värdet av en LLM inte bara i grundmodellen (som Llama, Mistral eller andra) utan i den proprietära kunskap som används för att finjustera den. Denna finjusteringsdata är organisationens IP.

- Isolerad träningsmiljö: När finjustering utförs på plats laddas de proprietära datamängderna (såsom kundregister, interna rapporter, patentansökningar eller produktspecifikationer) aldrig upp till en tredje part. De resulterande finjusterade modellvikterna, som effektivt kodar företagets kunskaper, behålls även internt, vilket förhindrar att någon extern part får obehörig åtkomst till kärn-IP.

Behöver du en kompatibel, lokal LLM skräddarsydd för din bransch? Låt oss bygga det säkert.

Praktiskiteterna för on-premise LLM-arkitektur

Även om integritetsfördelarna är övertygande, kräver implementeringen av en lokal LLM noggrann planering och investeringar i den underliggande tekniken.

Hårdvaruutmaningen: Behovet av GPU:er

LLM är beräkningskrävande. Nyckeln för effektiv distribution på plats är specialiserad hårdvara, främst GPU:er (Graphics Processing Units).

- Slutledningskraft: För att betjäna användarfrågor i realtid (inferens) kräver LLM höghastighetsminne och parallell processorkraft som tillhandahålls av GPU:er, ofta i dedikerade serverrack.

- Träning och finjustering: Att träna en modell från grunden är ett enormt åtagande, men finjustering (anpassa en befintlig modell) är möjlig på färre, kraftfulla GPU:er. Investeringen i denna hårdvara är en kapitalutgift (CapEx) som ersätter de pågående driftsutgifterna (OpEx) för molntjänstavgifter, vilket erbjuder långsiktig kostnadsförutsägbarhet.

Programvarustapeln

Den fullständiga lösningen på plats omfattar mer än bara hårdvara; det kräver en robust programvara och orkestreringslager:

- Modellval: Att välja en öppen källkod, kommersiellt gångbar grundläggande LLM (som Llama 3, Mistral, etc.) som lagligt kan laddas ner och distribueras på privat infrastruktur är det första steget.

- Containerisering (t.ex. Docker/Kubernetes): För att hantera den komplexa distributionen paketeras ofta LLM och dess beroenden i behållare. Orkestreringsverktyg som Kubernetes hanterar klustret av GPU-servrar, vilket säkerställer skalbarhet och hög tillgänglighet, ungefär som en privat molnmiljö – ofta implementerad av företag som Anställ moln- och DevOps-ingenjörer att hantera en så komplex AI-infrastruktur.

- Internt API-lager: Ett applikationsprogrammeringsgränssnitt (API) är byggt i brandväggen, vilket gör att interna applikationer (chatbotar, kodningsassistenter, dataanalytiker) kan skicka meddelanden till LLM utan att någonsin röra det offentliga internet.

Att övervinna datafördröjningen och styrning

Lokala lösningar eliminerar datalatens och förbättrar styrningen av interna datakällor.

- Intern dataåtkomst i realtid: LLM:er behöver ofta komma åt den senaste interna informationen – en process som kallas Retrieval-Augmented Generation (RAG). Genom att vara på plats har LLM tillgång till interna databaser, datasjöar och dokumentförråd med låg latens och hög bandbredd, vilket leder till mer exakta, kontextuella och snabbare resultat utan behov av dataöverföring över internet.

- Enhetlig styrning: Datastyrningsteamet kan tillämpa en enda uppsättning regler på data, RAG-index och själva LLM, vilket skapar en enhetlig och enklare efterlevnadsmiljö.

Strategiska fördelar för integritetsmedvetna industrier

Övergången till en lokal arkitektur är ett strategiskt beslut som signalerar ett starkt engagemang för regelefterlevnad och kundförtroende.

| Industri | Primärt sekretessproblem | Lokal lösningsfördel |

| Sjukvård (HIPAA) | Skydd av PHI och patientjournaler. | Säkerställer att PHI förblir i en säker, dedikerad miljö; förenklar revisionsloggar som krävs för efterlevnad. |

| Finansiella tjänster (GDPR, PCI-DSS) | Kund-PII, transaktionsdata, algoritmisk IP. | Garanterar datauppehåll och lokalisering; skyddar proprietära handelsalgoritmer och kundpoängmodeller från extern exponering. |

| Regering/försvar | Sekretessbelagd, mycket känslig eller statshemlig information. | Möjliggör distribution i miljöer med luftgap (nätverk fysiskt isolerade från internet), vilket säkerställer absolut säkerhet. |

| Tillverkning / FoU | Immateriella rättigheter (IP), patentskyddad design och affärshemligheter. | Förhindrar läckage av unika tillverkningsprocesser eller produktdesigndetaljer som används under RAG eller finjustering. |

Överbrygga klyftan med professionella IT-tjänster

Beslutet att övergå till en lokal LLM-arkitektur, samtidigt som det är strategiskt bra för integritet, introducerar betydande operationell komplexitet. Det kräver specialkunskaper inom hårdvaruanskaffning (särskilt högpresterande GPU:er), inrättande av en robust, containeriserad miljö (som Kubernetes), finjustering av modeller på känslig data och integrering av LLM med befintliga företagssystem. Det är här som en pålitlig IT-tjänstepartner blir ovärderlig.

WeblineIndia är en känd IT-byrå i USA som specialiserar sig på att tillhandahålla den omfattande expertis som behövs för att navigera sömlöst i denna övergång. De erbjuder end-to-end professionella tjänster, från att designa den optimala hårdvarustacken på plats skräddarsydd för dina slutsatser och utbildningsbehov, till att hantera den säkra distributionen av open source LLMs inom din brandvägg.

Molnexperter vid WeblineIndia’s utvecklingsnav i Indien har djup erfarenhet av säker molninfrastruktur och implementering av AI. Företag kan snabbt distribuera sin privata LLM-miljö, säkerställa strikt efterlevnad av interna efterlevnadspolicyer och snabbare tid till värde utan att behöva anställa och utbilda dyra, specialiserade interna AI-ingenjörsteam, genom att utnyttja erfarna fjärrutvecklare. Detta partnerskap förvandlar ett utmanande infrastrukturprojekt till ett hanterbart, strategiskt genomfört initiativ, helt dedikerat till att upprätthålla din absoluta datasuveränitet.

Framtiden är privat och säker med WeblineIndia

Entusiasmen kring LLM:er bör inte överskugga det grundläggande ansvar som företag har för att skydda de känsliga uppgifter som anförtrotts dem. För alla stora organisationer där efterlevnad, integritet och datasuveränitet inte är förhandlingsbara (vilket vill säga de flesta framgångsrika företag idag) är LLM-modellen för det offentliga molnet en fundamental oöverensstämmelse.

Övergången till LLM-distribution på plats representerar en tydlig väg framåt. Det är den nödvändiga investeringen i hårdvara och expertis som stänger säkerhetsklyftan, uppfyller de strängaste globala regulatoriska kraven och i slutändan gör det möjligt för företaget att utnyttja den fulla, transformativa potentialen hos artificiell intelligens utan att någonsin kompromissa med dess mest värdefulla tillgång: dess data.

Kontakta WeblineIndia IT-konsulttjänster för att undkomma molnets inneboende risker och återta kontrollen över sin AI-stack för att djärvt förnya sig. Du kan försäkra kundernas förtroende, efterlevnadsstatus och immateriella rättigheter är absolut säkrade inom deras egen suveräna domän.

Sociala Hashtags

#OnPremiseLLM #DataSuveränitet #FöretagsAI #AIEfterlevnad #IntegritetFörst #SäkerAI #LLMSäkerhet #Företagsteknik

Vill du ha full kontroll över din AI-stack utan datarisk? Börja med WeblineIndia.

Vanliga frågor

Kundreferenser: Hör det direkt från våra globala kunder

Våra utvecklingsprocesser levererar dynamiska lösningar för att hantera affärsutmaningar, optimera kostnader och driva digital transformation. Lösningar med expertstöd förbättrar kundlojaliteten och den digitala närvaron, och beprövade framgångsberättelser lyfter fram verklig problemlösning genom innovativa applikationer. Våra uppskattade kunder världen över har redan upplevt det.

Priser och Erkännanden

Även om nöjda kunder är vår största motivation, har branscherkännande betydande värde. WeblineIndia har konsekvent varit ledande inom teknologi, med priser och utmärkelser som bekräftar vår excellens.

OA500 Globala outsourcingföretag 2025, av Outsource Accelerator

Ledande mjukvaruutvecklingsföretag, av GoodFirms

Bästa fintech-produktlösningsföretag – 2022, av GESIA

Utsedd till – Bästa apputvecklingsföretag i Indien 2020, av SoftwareSuggest