Cuando el mercado está impulsado por la digitalización, el poder transformador de los modelos de lenguajes grandes (LLM) es innegable. Desde la automatización del servicio al cliente hasta la generación de código complejo, los LLM prometen una eficiencia e innovación sin precedentes. Sin embargo, para muchas grandes empresas, especialmente aquellas que operan en sectores altamente regulados como las finanzas, la salud y el gobierno, la búsqueda de innovación en Inteligencia Artificial (IA) se ve obstaculizada por un obstáculo importante y no negociable: la privacidad y la seguridad de los datos.

La arquitectura predeterminada para implementar LLM sofisticados a menudo implica la subcontratación a los principales proveedores de nube pública. Si bien es conveniente, este modelo significa inherentemente que los datos corporativos confidenciales, utilizados para entrenar, ajustar e interactuar con estos modelos, deben salir de los límites seguros de la red interna de la empresa. Esta exposición no es sólo un riesgo; es una violación directa de los mandatos regulatorios (como GDPR, HIPAA y varias leyes nacionales de localización de datos) y políticas de cumplimiento interno.

Aquí es donde surge el concepto de LLM locales, no simplemente como una alternativa, sino como la arquitectura esencial para las empresas que deciden priorizar la privacidad y que a menudo eligen hacerlo contratar equipo dedicado para una implementación segura de la IA. La implementación de LLM directamente en hardware interno de propiedad corporativa es la solución definitiva para lograr la soberanía absoluta de los datos, garantizando que la información patentada nunca abandone el control físico y digital de la organización.

¿Está preparado para mantener la privacidad de los datos empresariales mientras utiliza la IA? Hable con nuestros expertos en LLM hoy.

El gran conflicto: innovación versus cumplimiento

El argumento comercial a favor de la IA es claro: ventaja competitiva, reducción de costos y toma de decisiones superior. Sin embargo, el panorama corporativo está cada vez más definido por una estricta gobernanza de datos.

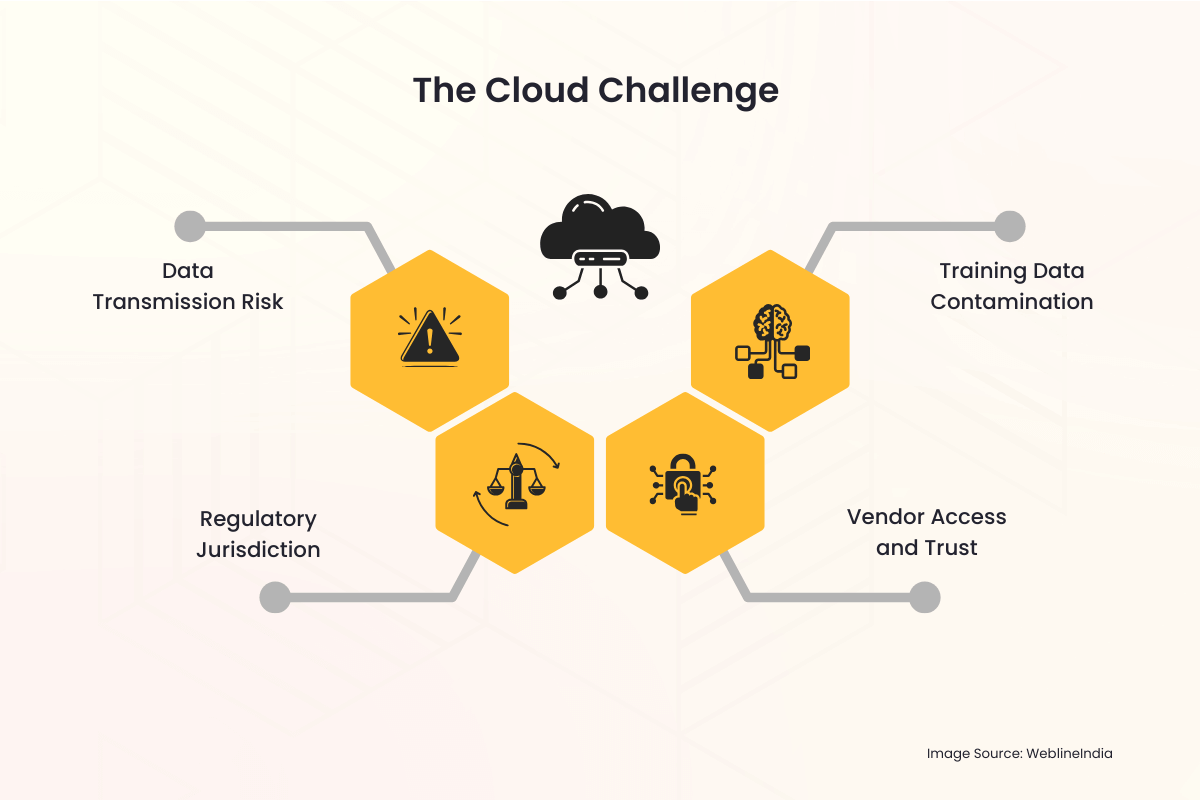

El desafío de la nube

Cuando una empresa utiliza un servicio LLM alojado en la nube, inmediatamente surgen varios problemas de privacidad:

- Riesgo de transmisión de datos: Cada consulta, cada entrada y el resultado resultante deben atravesar la Internet pública y residir temporalmente en un servidor de terceros. Todo este proceso es un vector potencial de interceptación o acceso no autorizado.

- Jurisdicción regulatoria: Los datos almacenados en un país o jurisdicción diferente al de origen de la empresa pueden desencadenar leyes internacionales complejas y a menudo contradictorias. Lograr la localización de datos (el requisito de que los datos se almacenen y procesen dentro de fronteras específicas) se vuelve prácticamente imposible con un proveedor de nube multinacional.

- Acceso y confianza del proveedor: Las empresas se ven obligadas a confiar en los protocolos de seguridad, los controles de acceso de los empleados y las políticas de retención del proveedor de la nube. Esto introduce a un tercero en los flujos de trabajo de datos más confidenciales.

- Contaminación de datos de entrenamiento: Si los datos patentados de una empresa se utilizan para ajustar un modelo alojado en la nube, siempre existe el riesgo de que los pesos de los modelos se compartan inadvertidamente, o incluso maliciosamente, o influyan en las respuestas de los modelos utilizados por otros inquilinos, lo que provocará una fuga de datos.

Estas preocupaciones no son teóricas. Los incidentes de alto perfil de violaciones de datos y las severas sanciones impuestas por los organismos reguladores globales han elevado la privacidad de los datos de un dolor de cabeza de TI a una prioridad central en las salas de juntas. Para las organizaciones que manejan información de identificación personal (PII), información de salud protegida (PHI) o propiedad intelectual (IP) clasificada, el perfil de riesgo de los LLM en la nube pública a menudo es simplemente demasiado alto para aceptarlo.

La solución local: recuperar el control y la soberanía

El modelo de implementación local de LLM aborda y resuelve directamente estas profundas preocupaciones de privacidad al colocar toda la infraestructura de IA (el hardware, el software, los pesos del modelo y los datos de entrenamiento) bajo el control físico y digital directo y exclusivo de la empresa.

1. Soberanía absoluta de datos

Soberanía de datos significa que los datos están sujetos únicamente a las leyes y reglas de gobernanza del país u organización donde se recopilan y almacenan.

- Control Geográfico: Con una configuración local, el hardware está ubicado físicamente dentro del centro de datos de la empresa, a menudo dentro de un país específico o incluso en una sala segura específica. Esto satisface intrínsecamente los requisitos de residencia y localización de datos, lo que facilita el cumplimiento de regulaciones como el GDPR de la UE o varias leyes de seguridad nacional.

- Transmisión externa cero: Todo el procesamiento de datos, el entrenamiento del modelo y la inferencia (consulta del modelo) ocurren dentro del firewall corporativo. Las indicaciones confidenciales y los documentos internos propietarios utilizados por el LLM nunca abandonan el entorno de red seguro.

2. Seguridad y cumplimiento mejorados

Una implementación local permite al equipo de seguridad aplicar el sólido marco de seguridad existente de la organización directamente al sistema de IA.

- Infraestructura de seguridad existente: La solución LLM se puede integrar perfectamente con herramientas de seguridad corporativa establecidas, incluidos sistemas de detección de intrusiones (IDS), firewalls sofisticados, soluciones de gestión de identidad y acceso (IAM) y sistemas de prevención de pérdida de datos (DLP). Esto suele ser más completo y personalizado que las capas de seguridad que ofrece un servicio de nube genérico.

- Control de acceso personalizado: El acceso al modelo en sí se puede controlar estrictamente a través de Active Directory corporativo interno u otras soluciones empresariales de IAM. Solo los empleados, departamentos o aplicaciones autorizados pueden interactuar con el modelo, y los registros de acceso se conservan internamente con fines de auditoría.

- Auditoría simplificada: El cumplimiento normativo a menudo requiere pistas de auditoría detalladas. Ser propietario de toda la pila permite a la empresa mantener registros detallados de cada uso del modelo, tarea de capacitación y acción administrativa, lo que facilita mucho las comprobaciones de cumplimiento para los auditores internos y externos.

3. Protección de la propiedad intelectual

Para las empresas, el verdadero valor de un LLM radica no sólo en el modelo fundamental (como Llama, Mistral u otros) sino en el conocimiento propio utilizado para perfeccionarlo. Estos datos de ajuste son la propiedad intelectual de la organización.

- Entorno de entrenamiento aislado: Cuando el ajuste se realiza localmente, los conjuntos de datos propietarios (como registros de clientes, informes internos, solicitudes de patentes o especificaciones de productos) nunca se cargan a un tercero. Los pesos del modelo ajustados resultantes, que codifican eficazmente el conocimiento de la empresa, también se conservan internamente, evitando que cualquier parte externa obtenga acceso no autorizado a la IP central.

¿Necesita un LLM local que cumpla con las normas y se adapte a su industria? Construyámoslo de forma segura.

Los aspectos prácticos de la arquitectura LLM local

Si bien los beneficios de privacidad son convincentes, implementar un LLM local requiere una planificación e inversión cuidadosas en la tecnología subyacente.

El desafío del hardware: la necesidad de GPU

Los LLM son computacionalmente exigentes. El factor clave para una implementación local eficiente es el hardware especializado, principalmente GPU (Unidades de procesamiento de gráficos).

- Poder de inferencia: Para atender consultas de usuarios en tiempo real (inferencia), el LLM requiere memoria de alta velocidad y potencia de procesamiento paralelo proporcionada por GPU, a menudo en bastidores de servidores dedicados.

- Capacitación y puesta a punto: Entrenar un modelo desde cero es una tarea enorme, pero el ajuste fino (adaptación de un modelo existente) se puede lograr con menos GPU potentes. La inversión en este hardware es un gasto de capital (CapEx) que reemplaza el gasto operativo continuo (OpEx) de las tarifas del servicio en la nube, ofreciendo previsibilidad de costos a largo plazo.

La pila de software

La solución local completa implica algo más que hardware; requiere un software robusto y una capa de orquestación:

- Selección de modelo: El primer paso es elegir un LLM fundamental de código abierto y comercialmente viable (como Llama 3, Mistral, etc.) que pueda descargarse e implementarse legalmente en una infraestructura privada.

- Contenedorización (por ejemplo, Docker/Kubernetes): Para gestionar la implementación compleja, el LLM y sus dependencias suelen empaquetarse en contenedores. Las herramientas de orquestación como Kubernetes administran el clúster de servidores GPU, garantizando escalabilidad y alta disponibilidad, muy parecido a un entorno de nube privada, a menudo implementado por empresas que Contrate ingenieros en la nube y DevOps para gestionar una infraestructura de IA tan compleja.

- Capa API interna: Se construye una interfaz de programación de aplicaciones (API) dentro del firewall, lo que permite que las aplicaciones internas (chatbots, asistentes de codificación, analistas de datos) envíen indicaciones al LLM sin siquiera tocar la Internet pública.

Superar la latencia y la gobernanza de los datos

Las soluciones locales eliminan la latencia de los datos y mejoran la gobernanza de las fuentes de datos internas.

- Acceso a datos internos en tiempo real: Los LLM a menudo necesitan acceder a los datos internos más actualizados, un proceso llamado generación aumentada de recuperación (RAG). Al ser local, el LLM tiene acceso de baja latencia y gran ancho de banda a bases de datos internas, lagos de datos y repositorios de documentos, lo que genera resultados más precisos, contextuales y oportunos sin la necesidad de transferir datos a través de Internet.

- Gobernanza unificada: El equipo de gobierno de datos puede aplicar un único conjunto de reglas a los datos, el índice RAG y el propio LLM, creando un entorno de cumplimiento unificado y más simple.

Ventajas estratégicas para industrias conscientes de la privacidad

El cambio a una arquitectura local es una decisión estratégica que indica un fuerte compromiso con el cumplimiento normativo y la confianza del cliente.

| Industria | Preocupación principal por la privacidad | Beneficio de la solución local |

| Atención médica (HIPAA) | Protección de PHI y registros de pacientes. | Garantiza que la PHI permanezca dentro de un entorno seguro y dedicado; simplifica los registros de auditoría necesarios para el cumplimiento. |

| Servicios financieros (GDPR, PCI-DSS) | PII del cliente, datos de transacciones, IP algorítmica. | Garantiza la residencia y localización de los datos; protege los algoritmos comerciales patentados y los modelos de puntuación de clientes de la exposición externa. |

| Gobierno / Defensa | Información clasificada, altamente sensible o secreto de estado. | Permite el despliegue en entornos aislados (redes físicamente aisladas de Internet), garantizando una seguridad absoluta. |

| Fabricación / I+D | Propiedad intelectual (PI), diseños propietarios y secretos comerciales. | Evita la fuga de procesos de fabricación únicos o detalles de diseño de productos utilizados durante RAG o ajuste fino. |

Cerrando la brecha con servicios de TI profesionales

La decisión de realizar la transición a una arquitectura LLM local, si bien es estratégicamente sólida para la privacidad, introduce una complejidad operativa significativa. Exige habilidades especializadas en la adquisición de hardware (específicamente GPU de alto rendimiento), la configuración de un entorno robusto en contenedores (como Kubernetes), el ajuste de modelos sobre datos confidenciales y la integración del LLM con los sistemas empresariales existentes. Aquí es donde un socio de servicios de TI de confianza resulta invaluable.

WeblineIndia es una reconocida agencia de TI en los EE. UU. que se especializa en brindar la experiencia integral necesaria para navegar esta transición sin problemas. Ofrecen servicios profesionales de extremo a extremo, desde el diseño de la pila de hardware local óptima adaptada a sus necesidades de inferencia y capacitación, hasta la gestión de la implementación segura de LLM de código abierto dentro de su firewall.

Los expertos en la nube del centro de desarrollo de WeblineIndia en India poseen una amplia experiencia en infraestructura de nube segura e implementación de IA. Las empresas pueden implementar rápidamente su entorno LLM privado, garantizando un estricto cumplimiento de las políticas de cumplimiento interno y acelerando el tiempo de obtención de valor sin la necesidad de contratar y capacitar equipos internos de ingeniería de IA especializados y costosos, aprovechando los desarrolladores remotos experimentados. Esta asociación transforma un proyecto de infraestructura desafiante en una iniciativa manejable y ejecutada estratégicamente, totalmente dedicada a mantener la soberanía absoluta de sus datos.

El futuro es privado y seguro con WeblineIndia

El entusiasmo en torno a los LLM no debería eclipsar la responsabilidad fundamental que tienen las empresas de proteger los datos confidenciales que se les confían. Para cualquier organización grande donde el cumplimiento, la privacidad y la soberanía de los datos no son negociables (es decir, las empresas más exitosas de la actualidad), el modelo LLM de nube pública es un desajuste fundamental.

El cambio a la implementación de LLM en las instalaciones representa un camino claro a seguir. Es la inversión necesaria en hardware y experiencia lo que cierra la brecha de seguridad, satisface los requisitos regulatorios globales más estrictos y, en última instancia, permite a la empresa aprovechar todo el potencial transformador de la Inteligencia Artificial sin comprometer nunca su activo más valioso: sus datos.

Contacto WeblineIndia Servicios de consultoría de TI para escapar de los riesgos inherentes de la nube y recuperar el control sobre su pila de IA para innovar con audacia. Puede garantizar que la confianza del cliente, el cumplimiento y la propiedad intelectual estén absolutamente protegidos dentro de su propio dominio soberano.

Hashtags sociales

#LLMEnLocal #SoberaníaDeDatos #IAEmpresarial #CumplimientoDeIA #PrivacidadPrimero #IAsegura #SeguridadDeLLM #TecnologíaEmpresarial

¿Quiere un control total sobre su pila de IA sin riesgo de datos? Comience con WeblineIndia.

Preguntas frecuentes

Testimonios: Escúchalo directamente de nuestros clientes globales

Nuestros procesos de desarrollo ofrecen soluciones dinámicas para afrontar retos empresariales, optimizar costos e impulsar la transformación digital. Soluciones respaldadas por expertos mejoran la retención de clientes y la presencia en línea, y casos de éxito comprobados muestran la resolución de problemas reales mediante aplicaciones innovadoras. Nuestros estimados clientes en todo el mundo ya lo han experimentado.

Premios y Reconocimientos

Aunque los clientes satisfechos son nuestra mayor motivación, el reconocimiento de la industria tiene un valor significativo. WeblineIndia ha liderado constantemente en tecnología, con premios y galardones que reafirman nuestra excelencia.

OA500 Empresas globales de externalización 2025, por Outsource Accelerator

Mejor empresa de desarrollo de software, por GoodFirms

Mejor empresa de soluciones de producto fintech – 2022, por GESIA

Premiada como – Mejor empresa de desarrollo de apps en India 2020, por SoftwareSuggest